Почему так сложно узнать основные факты о государственных алгоритмах?

13 января 2024 г.Привет, ребята, меня зовут Тодд Фезерс, я корпоративный репортер в The Markup.

В прошлом месяце репортеры Lighthouse Reports и Wired опубликовали "Внутри машины подозрений", потрясающее разоблачение алгоритм обнаружения мошенничества, используемый городом Роттердамом (Нидерланды) для отказа десяткам тысяч людей в социальных пособиях.

Расследование показало, что алгоритм, созданный для Роттердама консалтинговой компанией Accenture, дискриминирует по этническому и половому признаку. И что самое впечатляющее, он в мельчайших подробностях продемонстрировал как и почему алгоритм вел себя именно так.

(Поздравляем команду Lighthouse/Wired, включая Дхрува Мехротру, который, возможно, помнят читатели, помог нам расследовать алгоритмы прогнозирования преступлений в 2021 году.)

Города по всему миру и многие штаты США используют аналогичные алгоритмы, созданные частными компаниями, чтобы сигнализировать гражданам о мошенничестве с пособиями. Не из-за отсутствия попыток мы очень мало знаем о том, как они работают.

Lighthouse и Wired смогли продемонстрировать, насколько одна входная переменная, например, наличие родителя, повлияла на оценку риска заявителя из Роттердама. Но во многих местах мы даже не знаем, каковы входные переменные для этих систем принятия решений с высокими ставками.

Как алгоритм обнаружения мошенничества производит свои расчеты и почему он был разработан для такой работы — это не просто вопросы, интересующие журналистов. Людям автоматически отказывают в льготах нуждаются в этой базовой информации, чтобы обжаловать решения, когда их право на надлежащую правовую процедуру было нарушено.

«Большую часть времени [органами социального обеспечения] происходит общее сокращение расходов, и алгоритмическое определение используется, чтобы скрыть реальную причину сокращения пособий и предложить, казалось бы, нейтральное сокращение, но для того, чтобы оспорить это, нужно уметь точно определить причину.

Без этой информации вы не сможете решить проблему», — сказала Ханна Блох-Вехба, профессор юридической школы Техаса A&M, которая изучает, как Алгоритмическая непрозрачность угрожает справедливому правительству.

«Это то, что мы обязаны как граждане государства: когда оно отнимает что-то, на что мы имеем право, по крайней мере, они должны сказать нам, почему».

Люди, которым отказывали в еде и аренде или подвергались расследованию из-за алгоритма Роттердама, теперь могут начать понимать, почему система потерпела неудачу только потому, что Lighthouse сделала что-то эпически, мифически сложное: она получила то, что она описала как «святую троицу алгоритмической ответственности: данные обучения». , файл модели и код».

«Потребовалось почти два года, чтобы приобрести материалы, необходимые для проведения этого эксперимента», — написали репортеры в своей методологии.

«Мы отправили запросы FOIA (запросы о свободе информации) правительствам по всей Европе с запросом документации, оценок, кода и данных обучения для моделей машинного обучения, аналогичных той, которая используется в Роттердаме».

Роттердам был единственным городом, предоставившим файл модели и другую техническую документацию, и это произошло после года переговоров. В конце концов журналистам все же повезло получить данные обучения: городские власти по незнанию включили их в исходный код гистограмм, которые они отправляли репортерам.

Потребовалось шесть лет, с момента внедрения алгоритма в 2017 году до публикации книги «Внутри машины подозрений», чтобы общественность получила полное представление о том, как он работает и что пошло не так. Роттердам прекратил использование алгоритма в 2021 году.

К сожалению, мы никогда не приблизимся к получению «святой троицы» для большинства алгоритмов принятия государственных решений. И чем больше городов и штатов обращаются к правительству с помощью частных алгоритмов, тем менее эффективными становятся инструменты прозрачности, используемые журналистами, активистами и людьми, пострадавшим от алгоритмов.

Прошло 10 лет с тех пор, как штат Мичиган запустил Мичиганскую интегрированную систему автоматизации данных (MiDAS) — алгоритм обнаружения мошенничества с 93 процента ошибок, что автоматически отказывается десяткам тысяч квалифицированных кандидатов в получении пособий по безработице, что приводит к банкротства и отчуждение домов.

Юристы, борющиеся на передовой против решений MiDAS, до сих пор не имеют полного понимания того, как работает система, которая остается в работе после некоторые реформы — был разработан и действует.

Та информация, которой они располагают, в основном была получена через судебные иски штата и федерального правительства, поданные жителями Мичигана, чьи налоговые декларации были заблокированы после того, как MiDAS автоматически отметила их за искажение фактов и инициировала взыскание налогов с их счетов.

"Я до сих пор не знаю, видели ли мы на самом деле формальный алгоритм", - сказал Тони Пэрис, адвокат некоммерческой организации Sugar Law Center for Economic and Social Justice, который представлял интересы претендентов на пособие по безработице, оказавшихся на ошибках MiDAS.

Блох-Вехба сказал что, когда алгоритмы используются для лишения граждан свободы или собственности, правительства должны быть обязаны раскрывать входные переменные и способы их взвешивания. Несколько штатов рассматривают законопроекты для этого агентствам потребуется документировать используемые ими автоматизированные системы принятия решений и выполнять алгоритмическую оценку воздействия.

Но по всей стране предыдущие усилия законодателей по обеспечению большей прозрачности государственных автоматизированных систем принятия решений в основном имели вылетел из строя. В 2021 году более 30 законодателей штата Мичиган выступили соавтором законопроект, который обязывает штат нанимать независимого эксперта для проверки исходного кода и алгоритмов MiDAS. Законопроект не прошел через комитет.

Между тем, FAST Enterprises, одна из компаний, ответственных за MiDAS, сообщает в рекламные материалы о том, что программное обеспечение для пособий по безработице используют еще шесть штатов: Массачусетс, Монтана, Орегон, Невада, Теннесси и Вашингтон, где есть были свои проблемы с компанией.

Неясно, включают ли системы всех этих штатов алгоритмическое обнаружение мошенничества.

И FAST — не единственный поставщик этих систем.

В течение нескольких лет некоммерческий Информационный центр электронной конфиденциальности (EPIC) отслеживает распространение технологий от Pondera Solutions, которая продает свои Алгоритм «Мошенник» для городов и штатов. Thomson Reuters приобрела Pondera в 2020 году.

Как и репортеры из Lighthouse, эти освещая MiDAS в Мичигане, и многие из нас здесь, в The Markup, сотрудники EPIC в основном использовали запросы публичных записей, чтобы попытаться приоткрыть завесу над государственными алгоритмами.

В каждом штате США и во многих национальных правительствах (включая правительство США) действует закон о свободе информации или открытых записях, который позволяет общественности запрашивать документацию о государственной деятельности.

Это потрясающая система и основа многих журналистских расследований. Но когда дело доходит до получения информации об алгоритмах, для создания которых правительства наняли частные компании, законы о свободе информации терпят неудачу. Успех Lighthouse — заметное исключение, и на него потребовалось много времени.

Бен Уинтерс и Том МакБрайен из EPIC заявили, что многие правительственные учреждения, к которым они обращались с запросами на информацию о Пондере, просто так и не ответили (что незаконно). Некоторые агентства, которые ответили, предоставили EPIC копии своих контрактов с Pondera, в которых были перечислены конкретные результаты, такие как проверочные тесты системы обнаружения мошенничества.

Но когда EPIC впоследствии запросила результаты этих тестов, агентства «заблокировали или получили сопротивление, заявив, что это служебная или конфиденциальная» информация, сказал МакБрайен.

По моему собственному опыту, мне регулярно отказывают агентства, заявляющие об освобождении от коммерческой тайны.

Несмотря на обширную работу с публичными записями, EPIC и, как следствие, все мы до сих пор не знаем всех входных переменных, которые города и штаты вводят в систему Fraudcaster Pondera.

Мы не знаем, как именно Fraudcaster рассчитывает риск и какие решения приняли люди о том, как следует использовать эти прогнозы.

Уинтерс и МакБрайен даже не запросили у агентств код Пондеры или данные обучения — столпы этой святой троицы алгоритмической справедливости — и я в большинстве случаев тоже этого не делаю. По крайней мере, в США правительственные учреждения и апелляционные органы по публичным записям утверждают, что самая подробная, но важная информация о частных алгоритмах скрыта от публичного просмотра, даже если эти алгоритмы были созданы с единственной целью выполнения основной государственной функции.< /п>

Честно говоря, эта колонка представляет собой субтвит на 1500 слов о нескольких правительственных учреждениях и компаниях, занимающихся выявлением мошенничества с льготами, которые – по крайней мере на данный момент – останутся безымянными.

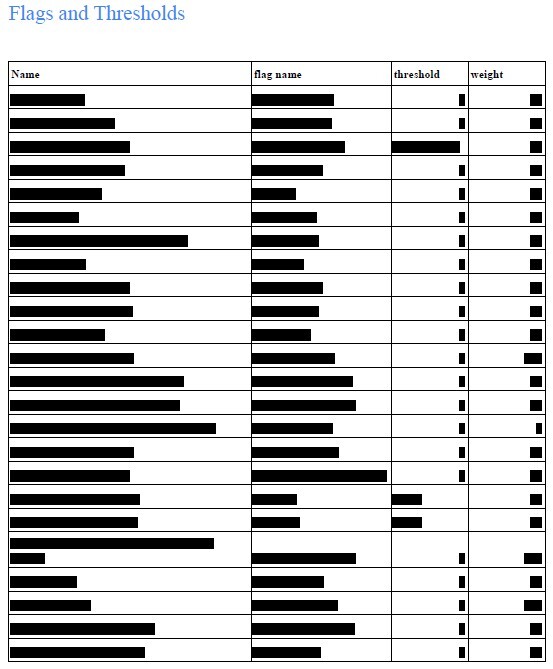

Достаточно сказать, что я пытался узнать больше о конкретном алгоритме, используемом для обнаружения мошенничества в нескольких программах государственных льгот, но не продвинулся так далеко, как хотелось бы. Иногда попадается святая троица, иногда вот такие страницы:

Но последствия этой темы выходят далеко за рамки моих собственных задач как репортера. Этот особый вид государственно-частного партнерства, а также непрозрачность и препятствия, которые оно создает, ставят под угрозу процессуальные права десятков тысяч людей.

Не будет журналистского разоблачения каждого существующего алгоритма обнаружения мошенничества. А даже если бы и были, информация не доходит до тех, кто в ней нуждается, достаточно быстро.

Как сказала мне Блох-Веба: «Главный вопрос в конечном итоге не в том, «Откуда мы узнаем, что происходит». А в том, «Как мы узнаем об этом, пока не стало слишком поздно?»»

Спасибо за прочтение,

Тодд Физерс

Корпоративный репортер

Разметка

Автор: Тодд Фезерс

Также опубликовано здесь

Фото Майкла Дзеджича на Unsplash

Оригинал