Исследование Национального центра кибербезопасности: генеративный искусственный интеллект может увеличить глобальную угрозу программ-вымогателей

25 января 2024 г.Национальный центр кибербезопасности Великобритании опубликовал новое исследование, в котором показано, что генеративный искусственный интеллект может увеличить риски от киберугроз, таких как программы-вымогатели.

В целом в отчете говорится, что генеративный ИИ обеспечит «повышение возможностей» существующих угроз, а не станет источником совершенно новых угроз. Злоумышленникам придется быть достаточно опытными, чтобы получить доступ к «качественным обучающим данным, значительному опыту (как в области ИИ, так и в киберпространстве) и ресурсам», прежде чем они смогут воспользоваться преимуществами генеративного ИИ, что, по мнению NCSC, вряд ли произойдет до 2025 года. В будущем злоумышленники «смогут быстрее и эффективнее анализировать украденные данные и использовать их для обучения моделей ИИ».

Как генеративный ИИ может «усилить» атаки

«Мы должны гарантировать, что мы не только используем технологию искусственного интеллекта для ее огромного потенциала, но и управляем ее рисками, включая ее последствия для киберугроз», — написала генеральный директор NCSC Линди Кэмерон в пресс-релизе. «Появление ИИ в кибератаках является эволюционным, а не революционным, а это означает, что оно усиливает существующие угрозы, такие как программы-вымогатели, но не меняет ландшафт рисков в ближайшем будущем».

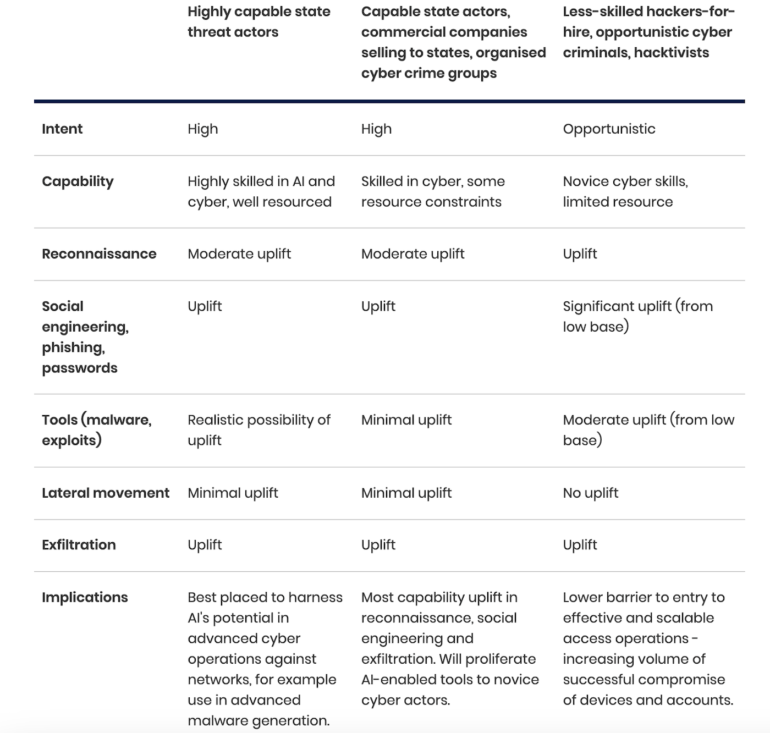

В отчете угрозы отсортированы (рис. A) по потенциалу «подъёма» от генеративного ИИ и по типам субъектов угроз: спонсируемые государством, хорошо организованные и менее квалифицированные или оппортунистические злоумышленники.

Рисунок А

В докладе говорится, что угроза генеративного ИИ, распространяющаяся на 2025 год, исходит от «эволюции и совершенствования существующих тактик, методов и процедур», а не от совершенно новых.

Службы искусственного интеллекта снижают входной барьер для злоумышленников-вымогателей

Ожидается, что программы-вымогатели по-прежнему будут доминирующей формой киберпреступности, говорится в отчете. Подобно тому, как злоумышленники предлагают программу-вымогатель как услугу, они теперь также предлагают генеративный искусственный интеллект как услугу, говорится в отчете.

СМОТРИТЕ: Недавний вредоносный ботнет перехватывает облачные учетные данные от AWS, Microsoft Azure и других компаний (TechRepublic)

«Услуги искусственного интеллекта снижают барьеры для входа, увеличивая количество киберпреступников, и расширяют их возможности за счет улучшения масштаба, скорости и эффективности существующих методов атак», — заявил Джеймс Бэббидж, генеральный директор по угрозам Национального агентства по борьбе с преступностью. в пресс-релизе NCSC об исследовании.

Злоумышленники, занимающиеся программами-вымогателями, уже используют генеративный искусственный интеллект для разведки, фишинга и кодирования. NCSC ожидает, что эта тенденция сохранится «до 2025 года и далее».

Социальная инженерия может быть облегчена искусственным интеллектом

Исследование показало, что в ближайшие два года социальная инженерия увидит значительный рост благодаря генеративному искусственному интеллекту. Например, генеративный ИИ сможет удалять орфографические и грамматические ошибки, которые часто отмечают спам-сообщения. В конце концов, генеративный ИИ может создавать новый контент для нападающих и защитников.

Злоумышленники, занимающиеся фишингом и вредоносным ПО, могут использовать ИИ, но, скорее всего, он есть только у опытных

Аналогичным образом, злоумышленники могут использовать генеративный искусственный интеллект для получения доступа к учетным записям или информации о паролях в ходе фишинговой атаки. Однако в докладе говорится, что для использования генеративного искусственного интеллекта для вредоносных программ потребуются продвинутые злоумышленники. Чтобы создать вредоносное ПО, способное обходить современные фильтры безопасности, генеративный ИИ должен быть обучен на больших объемах высококачественных данных об эксплойтах. Единственные группы, которые сегодня могут иметь доступ к этим данным, — это субъекты национальных государств, но в докладе говорится, что существует «реальная вероятность» существования таких хранилищ.

Уязвимости могут возникать быстрее из-за ИИ

Сетевые менеджеры, стремящиеся исправить уязвимости до того, как они будут использованы, могут столкнуться с усложнением своей работы, поскольку генеративный искусственный интеллект ускоряет время между обнаружением уязвимостей и их эксплуатацией.

Как защитники могут использовать генеративный искусственный интеллект

NCSC отметил, что некоторые преимущества генеративного искусственного интеллекта, которые кибератакующие могут получить, могут принести пользу и правозащитникам. Генеративный искусственный интеллект может помочь найти закономерности и ускорить время, необходимое для обнаружения или сортировки атак, а также выявления вредоносных электронных писем или фишинговых кампаний.

Чтобы улучшить глобальную защиту от злоумышленников с использованием генеративного ИИ, Великобритания организовала создание Декларации Блетчли в ноябре 2023 года в качестве руководства по устранению перспективных рисков ИИ.

NCSC и некоторые британские частные отраслевые организации внедрили искусственный интеллект для улучшения обнаружения угроз и обеспечения безопасности в соответствии со Стратегией кибербезопасности стоимостью 2,6 миллиарда фунтов стерлингов (3,3 миллиарда долларов США), объявленной в 2022 году.

Оригинал