ИИ — это не проблема — вам следует беспокоиться о разработчиках ИИ

28 января 2023 г.То, что ChatGPT и другие чат-боты изменили наше понимание и взаимодействие с инструментами искусственного интеллекта (ИИ), уже не новость. Многие люди впервые узнали об искусственном интеллекте, когда в ноябре прошлого года Интернет взбесился после выпуска ChatGPT.

Не сбрасывая со счетов волнение, связанное с чат-ботом OpenAI, мы ежедневно сталкиваемся с инструментами и операциями ИИ. Возьмем, к примеру, тот факт, что поисковая система и карта Google используют искусственный интеллект для обработки запросов и получения ответов за считанные секунды.

ИИ — хороший, плохой и неизбежный

Возможности того, что можно сделать с помощью ChatGPT и других инструментов искусственного интеллекта, вызвали небывалый восторг. Есть случаи, когда эти инструменты создают контент и технические документы, предназначенные исключительно для профессионалов.

ChatGPT использовался для написания кода, разработки вредоносных программ, генерации идей, перевода языков и многого другого. В 2022 году использование Midjourney выросло более чем на 1000 %.

Возможности этих инструментов также внушают страх перед концом света. Есть опасения по поводу массового безработицы, плагиат с использованием искусственного интеллекта и мошенническое образование, судебный процесс по авторским правам, дезинформация, фальшивые рефераты исследований и демократизация киберпреступности.

В иске, поданном 13 января 2023 г., компании Stability AI, Midjourney и DeviantArt обвиняются в нарушении «права миллионов художников».

ИИ — это будущее. Мы должны научиться принимать хорошее и принимать меры, чтобы свести к минимуму влияние плохого. Однако нет никаких сомнений в том, что искусственный интеллект продолжит разрушать современное общество.

Недавний опрос, проведенный Statista показали, что поколение Z (29%), поколение X (28%) и миллениалы (27%) используют генеративные инструменты ИИ.

Ожидается, что выручка мирового рынка ИИ вырастет со 136 миллиардов долларов в 2022 году до более чем 1,5 триллиона долларов США к 2030 году. По данным IBM, 35% компаний использовали ИИ в своем бизнесе, 42% изучали ИИ, а 66% в настоящее время выполняете или планируете применять ИИ для достижения целей устойчивого развития.

К преимуществам ИИ относятся автоматизация работы (30%), экономия средств (54%), производительность ИТ (53%) и повышение качества обслуживания клиентов (48%).

Создание ИИ

Учитывая множество чудес ChatGPT и других инструментов, легко предположить, что инструменты ИИ представляют собой сплав колдовства и науки. К счастью, это не так.

ИИ – это созданные в лаборатории математические модели на основе данных, предназначенные для выполнения задач, требующих человеческого интеллекта, таких как распознавание закономерностей, изучение опыта, решение проблем и принятие эффективных решений.

Развитие ИИ обусловлено достижениями в таких областях, как информатика, нейробиология и психология. Он основан на идее, что человеческий интеллект может быть смоделирован и смоделирован машиной.

Некоторые из ключевых технологий и методов, используемых в ИИ, включают машинное обучение, обработку естественного языка и робототехнику.

Влияние человеческого предубеждения на развитие ИИ

Понятие "мусор на входе, мусор на выходе" очень верно для ИИ. Поскольку мы продолжаем развиваться и все больше и больше полагаться на системы искусственного интеллекта, мы также должны осознавать возможность предвзятости в этих системах.

Хотя легко указать пальцем на сам ИИ как на проблему, правда в том, что реальная проблема заключается в предвзятости тех, кто разрабатывает и обучает эти системы. Системы ИИ ведут себя именно так, как хотят их разработчики.

69 % исследователей ИИ считают, что ИИ и его разработка представляют угрозу безопасности и должны уделять больше внимания безопасности.

Человеческая предвзятость в ИИ может проявляться по-разному: от данных, используемых для обучения ИИ, до процессов принятия решений самой системой.

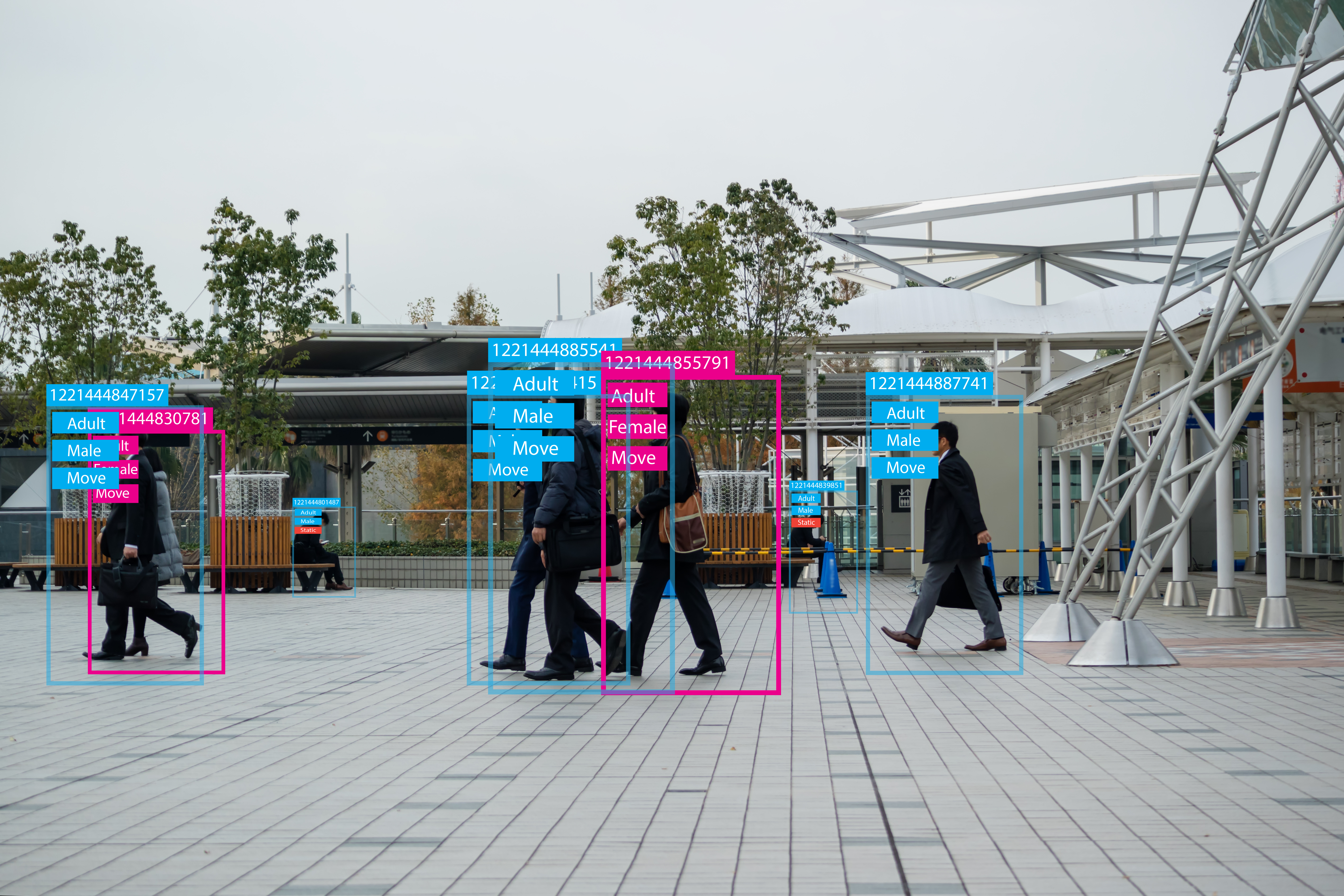

Например, если система ИИ обучается на наборе данных, который непропорционально состоит из одной конкретной группы людей, она может быть не в состоянии точно понимать и принимать решения для других групп.

Точно так же, если система ИИ предназначена для принятия решений на основе определенных предположений или стереотипов, она может увековечить вредные предубеждения в обществе.

Одна из самых больших проблем с ИИ заключается в том, что данные, на которых он обучается, могут отражать предубеждения людей, которые собирают и обрабатывают эти данные.

Например, если набор данных, используемый для обучения системы распознавания лиц, в основном состоит из изображений светлокожих людей, система, скорее всего, будет плохо работать при попытке распознать лица людей с более темным оттенком кожи.

Это форма предвзятости, которая может иметь реальные последствия, как, например, в случае с цветные люди ложно арестованы из-за ошибочного совпадения распознавания лиц.

Но не только данные могут быть предвзятыми, люди, создающие и обучающие эти системы, также могут внести предвзятость из-за своих собственных бессознательных предубеждений.

Например, исследование обнаружило что языковые модели, такие как GPT-3, которые были обучены на наборе данных, в основном расистских и сексистских, имеют тенденцию создавать гендерно-стереотипные и расистские тексты. Это может увековечить вредные стереотипы и ограничить потенциал систем ИИ.

Социально ответственные инструменты искусственного интеллекта

Поскольку 74 % организаций не предприняли шагов для обеспечения надежности и ответственности своего ИИ, необходимость срочного создания социально ответственных инструментов ИИ является коллективной ответственностью. Он начинается с выявления потенциальной предвзятости и активной работы по ее устранению.

Это означает диверсификацию команды людей, работающих над ИИ, и обеспечение широкого спектра мнений и опыта.

Важно убедиться, что данные, используемые для обучения ИИ, разнообразны и репрезентативны для населения, которое он будет обслуживать. Это включает в себя тщательный отбор и проверку данных, чтобы гарантировать, что они не увековечивают существующие предубеждения или стереотипы.

Кроме того, важно учитывать потенциальное влияние данных на разные группы людей и получать информацию с разных точек зрения, чтобы обеспечить полноту и достоверность данных.

Дизайн систем ИИ должен быть прозрачным и объяснимым. Это означает, что процессы принятия решений в системах ИИ должны быть четкими и понятными для людей, чтобы можно было выявить и устранить любые потенциальные предубеждения или проблемы.

Крайне важно регулярно оценивать и контролировать производительность систем ИИ, чтобы убедиться, что они функционируют должным образом и не допускают вредных предубеждений. Сюда входит регулярный анализ данных, используемых для обучения систем ИИ, а также решений и действий моделей ИИ.

Правительство должно принимать законы и постановления, которые обеспечивают социально ответственную разработку и использование ИИ, не препятствуя росту и развитию.

Максимальное использование ИИ на благо общества

Искусственный интеллект может полностью изменить нашу жизнь, работу и общение. Но по мере того, как мы продолжаем разрабатывать и полагаться на системы ИИ, крайне важно, чтобы мы также учитывали возможность предвзятости. Мы должны признать, что настоящую озабоченность вызывает не сам ИИ, а предвзятость тех, кто его разрабатывает и обучает.

Зная об этой проблеме и принимая меры по ее устранению, мы можем гарантировать, что будущее ИИ принесет пользу всем.

Целью должно стать развитие ИИ на благо общества. Такая цель потребует коллективной ответственности со стороны правительств, разработчиков и пользователей. Правительства должны обеспечить соблюдение нормативных требований, обеспечивающих разработку систем ИИ социально ответственным образом.

Разработчики должны предотвращать предвзятость, внедряя разнообразие, прозрачность и подотчетность. Они должны регулярно оценивать и контролировать работу систем ИИ, чтобы предотвратить непреднамеренную предвзятость и злоупотребления.

Общественность также должна понимать, что она несет ответственность за то, как она использует ИИ. Всем следует препятствовать социально безответственному использованию ИИ.

н

Оригинал