Введение в MedPaLM: «двоюродный брат» ChatGPT, ориентированный на здравоохранение

20 марта 2023 г.27 декабря 2022 года — всего через пару дней после Рождества и менее чем через месяц после грандиозного открытия ChatGPT миру — команда исследователей Google и DeepMind опубликовала свои выводы о новой большой языковой модели, которую они назвали MedPaLM, и ее «обнадеживающие результаты» в медицинских и клинических условиях.

И пока земной шар все еще охвачен безумием ChatGPT, его практически анонимный «кузен» MedPaLM потенциально может возвестить недалекую революцию в том, как мы оказываем медицинскую помощь.

Так что же такое MedPaLM?

Чтобы понять, что такое MedPaLM, давайте сначала разберем, что означает каждая буква в его сокращенном названии (что-то вроде акростиха, если хотите):

Медицина: медицина

Па: Пути

Pa означает Pathways, новую архитектуру искусственного интеллекта, запущенную < a href="https://hackernoon.com/company/google">Google в октябре 2021 года, предназначенный для одновременного выполнения множества задач и изучения новых задач на сверхскорости. Отказавшись от традиционного метода обучения моделей машинного обучения для хорошего выполнения одной задачи, Pathways открыла новую эру моделей ИИ, способных выполнять несколько задач одновременно, а также использовать и комбинировать свои существующие навыки для более быстрого и эффективного изучения новых задач. эффективно.

"Мы хотим, чтобы [эта] модель обладала различными возможностями, которые можно было бы использовать по мере необходимости и объединять для выполнения новых, более сложных задач — немного ближе к тому, как мозг млекопитающих обобщает задачи". – Джефф Дин, старший научный сотрудник Google и старший вице-президент Google Research.

Архитектура искусственного интеллекта Google Pathways

LM: языковая модель

LM — это сокращение от Language Model (в данном случае Модель большого языка) — вычислительная модель, предназначенная для понимания и генерации человеческого языка. Или, проще говоря, статистическая модель, предсказывающая вероятность появления следующего слова в заданной последовательности слов.

Для такого предложения, как «Кошка сидела на ____», языковая модель может предсказать, что наиболее вероятным последующим словом будет «коврик», «коврик» или «стул», основываясь на вероятностях появления этих слов в предложении. контекст предложения.

Большие языковые модели можно обучать на большом количестве текстовых корпусов, используя алгоритмы машинного обучения для изучения шаблонов и структуры языка.

После обучения эти модели можно использовать для ряда задач обработки естественного языка, включая генерацию текста, перевод, анализ настроений и многое другое.

Как разрабатывался MedPaLM?

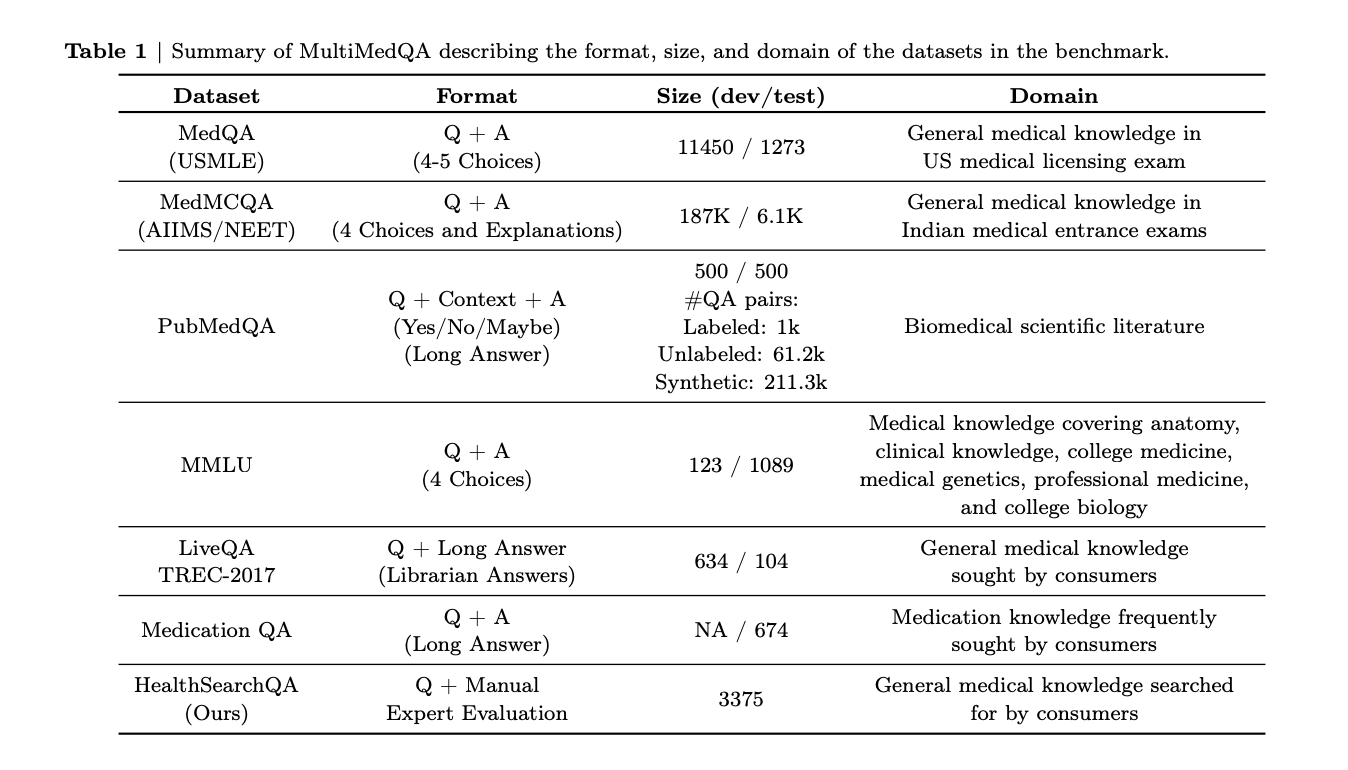

MedPaLM – это продукт обширного повторяющегося эксперимента, проведенного группой исследователей Google и DeepMind для оценки эффективности и точность больших языковых моделей для медицинских и клинических приложений.

Что это значит?

Представьте, что вы пытаетесь идеально настроить скрипку. Чтобы взять идеальную ноту, вам нужно постоянно увеличивать и уменьшать натяжение струны и очень осторожно поворачивать ручки, чтобы достичь желаемого результата. Во многом это именно то, что сделали создатели MedPaLM для достижения своей цели. Поэтому вместо того, чтобы думать о ней как о совершенно новой языковой модели, думайте о ней как о модели Google PaLM, преднамеренно и тщательно откалиброванной для максимальной точности в медицинских условиях.

Хорошо, а как это было "настроено"?

Чтобы настроить или, точнее, обучить MedPaLM, его исследователи использовали подсказки. Подсказки для больших языковых моделей — это фрагменты текста, используемые для руководства или направления генерации нового текста моделью. Они предназначены для того, чтобы помочь модели создавать выходные данные, которые имеют отношение к конкретной задаче или теме, и могут принимать различные формы, такие как утверждения, заполняющие пробелы, вопросы или фразы, устанавливающие контекст.

Так, например:

«Завершите следующее предложение: Столица Франции — ____».

"Как лучше всего приготовить бутерброд с сыром на гриле?"

"Напишите абзац, описывающий причины Гражданской войны в США."

"В этом отрывке из романа представлен персонаж: "Она была высокой и худой, с проницательными голубыми глазами и серьезным выражением лица". Как зовут героиню и что она делает в этой сцене?"

Почему мне нужна языковая модель, предназначенная для здравоохранения, чтобы подсказать, как лучше всего приготовить бутерброд с жареным сыром?

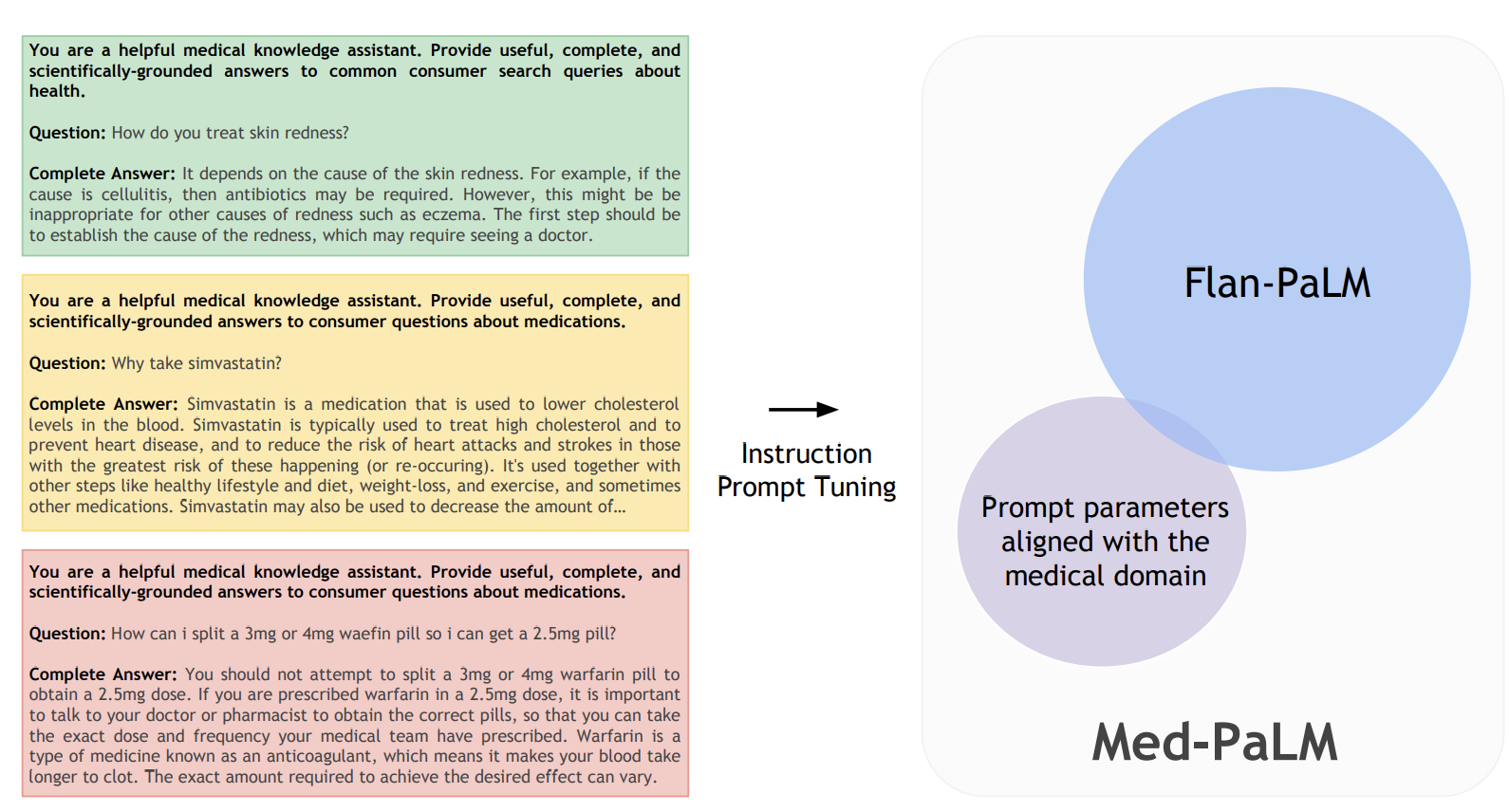

Вы не знаете. Именно поэтому разработчики MedPaLM использовали технику под названием Instruction Prompt Tuning (IPT). Настройка подсказок с инструкциями – это метод точной настройки большой языковой модели для конкретной задачи путем предоставления примеров желаемых пар ввода и вывода в виде подсказок.

Таким образом, вместо того, чтобы создавать LLM с общими ответами на общие темы, команда MedPaLM использовала рекомендации и примеры от группы квалифицированных клиницистов для каждого потребительского набора данных с ответами на медицинские вопросы, чтобы быстро настроить Flan-PaLM (предыдущая итерация MedPaLM) и сформировать гипермедицинское обслуживание. сфокусированный LLM: MedPaLM.

Как работает MedPaLM?

Ну, это действительно зависит от того, что вы хотите сделать.

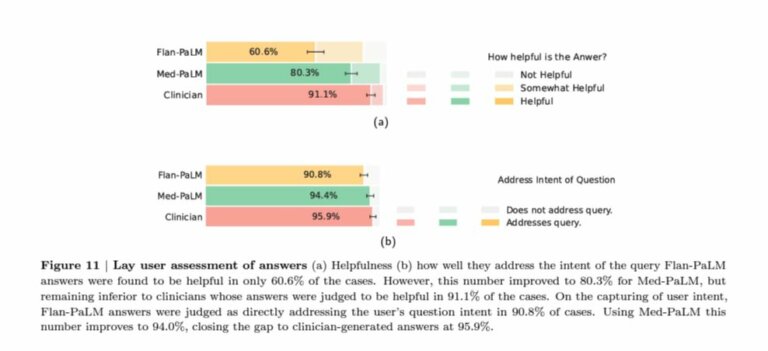

С точки зрения предоставления ответов на медицинские вопросы потребителей, 94,4% ответов MedPaLM были оценены как непосредственно относящиеся к намерениям пользователя, что всего на 1,5% меньше, чем у человека-клинициста. 80,3 % его ответов оказались полезными, что на 11 % меньше, чем у человека-клинициста, но на 30 % лучше, чем у его предшественника Flan-PaLM.

Впечатляет? Еще бы.

Но в других проверенных областях MedPaLM оставляет желать лучшего.

В 16,9% ответов MedPaLM получил неверную информацию, в отличие от 3,6% ответов врачей-людей. Неправильные рассуждения были замечены в 10,1% ответов MedPaLM и всего в 2,1% ответов клиницистов. Неправильное понимание произошло в 18,7% случаев для MedPaLM и в 2,2% для клиницистов.

Что это значит для здравоохранения?

Попытки точно предсказать, как MedPaLM и другие LLM будут использоваться в клинических и медицинских целях, на данном этапе немного глупы. Какими бы впечатляющими ни были недавние достижения в этой области, одна-единственная ошибка может иметь катастрофические последствия, когда речь идет о жизни или смерти медицинской помощи. Один неверный ответ на вопрос пациента (например, какой препарат следует принять для лечения определенного состояния) может привести к госпитализации и даже смерти.

Эта проблема еще больше усугубляется тем фактом, что большие языковые модели по сути являются огромными черными ящиками, и им не хватает объяснимости или возможности точно определить, почему они дали определенные входные данные.

Устранение ошибки начинается со знания того, как найти проблему, и, какими бы впечатляющими ни были возможности MedPaLM, это лишь одна (из многих) вещей, которые он не может сделать.

Итак, для чего можно использовать LLM в здравоохранении?

- Обобщение и анализ исследовательских работ: приблизительно 7287 статей (в среднем 5,16 минут чтения) ежемесячно публикуются в медицинских журналах. Теоретически, чтобы не отставать от литературы, врач должен посвящать этой задаче 627,5 часов в месяц, или около 29 часов в будний день, или 3,6 эквивалента усилий врача на полный рабочий день. И хотя это нереалистично в любом сценарии, LLM невероятно эффективно резюмируют, анализируют и представляют ключевые моменты из подробного текста, значительно сокращая время, необходимое для того, чтобы быть в курсе последних исследований.

2. Улучшение клинической документации. Большие языковые модели можно использовать для повышения качества клинической документации путем выявления отсутствующей или неполной информации в медицинских записях.

3. Кодирование и выставление счетов. Создавая соответствующие коды для процедур и лечения, LLM могут помочь сократить количество ошибок и обеспечить адекватное вознаграждение врачей за свою работу.

4. Управление здоровьем населения. Используя LLM, врачи могут выявлять тенденции и закономерности в состоянии здоровья пациентов и разрабатывать целевые вмешательства для улучшения показателей здоровья населения.

5. Клинические исследования. Анализируя большие объемы данных и выявляя закономерности и тенденции, которые трудно отследить с помощью традиционных статистических методов, LLM можно использовать для облегчения клинических исследований с повышенной скоростью и масштабом. р>

6. Анализ удовлетворенности пациентов: LLM могут быть использованы для просеивания и анализа отзывов и настроений пациентов с помощью тысяч опросов и взаимодействий в социальных сетях, чтобы определить критические области для улучшения удовлетворенности пациентов, доступа и опыта.< /p>

Как насчет планирования встреч?

Хорошие LLM настолько хороши, насколько хороши данные, на которых они обучались.

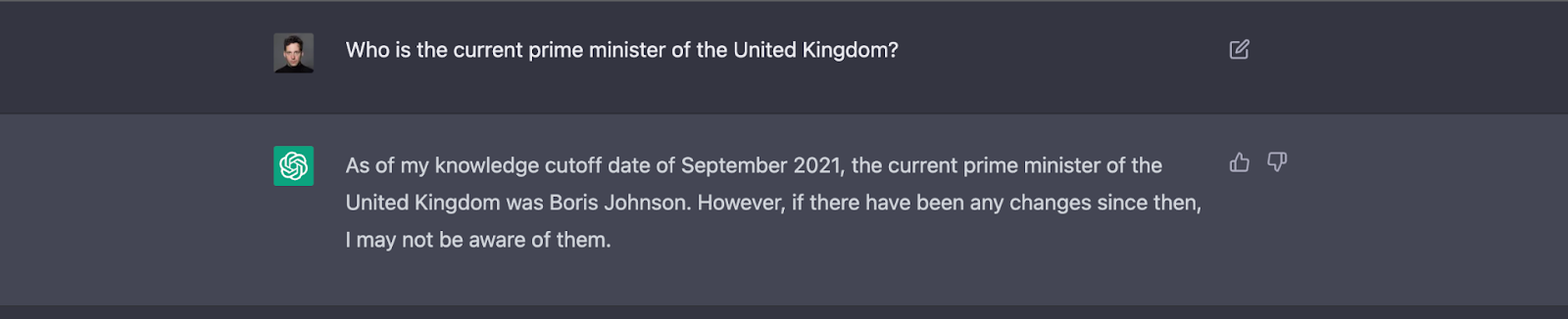

Например, ChatGPT — несмотря на его объективно впечатляющие возможности извлечения знаний — был обучен только параметрам, относящимся к 2021 году. Любое событие, имевшее место в любое время после крайнего срока, установленного в сентябре 2021 года, полностью выходит за его рамки.

Таким образом, несмотря на то, что Борис Джонсон ушел с поста премьер-министра Соединенного Королевства в сентябре 2022 года и с тех пор его сменили два премьер-министра (Лиз Трасс и нынешний Риши Сунак), ChatGPT (по общему признанию) совершенно ничего не знает.

Но что, если я обучу LLM в списке всех врачей моей системы здравоохранения? Разве это не сработает?

Это было бы. Но только до того момента, пока не произойдет даже самое незначительное изменение. Так, например, если хотя бы один из ваших врачей перейдет в другую клинику, добавит еще одну специализацию в свои предложения по уходу, обновит свое рабочее время или даже уволится, ваш LLM, планирующий прием, предоставит вашим пациентам неверную и вводящую в заблуждение информацию.< /p>

<цитата>

Если даже один фрагмент данных перестает быть актуальным, вся модель становится поврежденной и, следовательно, устаревшей.

То же самое можно сказать о любом случае использования, требующем точной работы данных в реальном времени. Так, например, поиск по сайту, пополнение запасов по рецепту и актуальные часто задаваемые вопросы.

О, значит, LLM действительно могут помочь мне только с административными задачами?

Сами по себе, да, на что нечего чихать, и они сэкономят практикующим врачам бесчисленные часы, которые в противном случае тратятся на бюрократическую офисную работу. Но для любых случаев использования, требующих актуальных данных в режиме реального времени, LLM могут служить только частью гораздо более адаптивной и гибкой диалоговой платформы, а не всем блюдом.

В этом подробном анализе генеральный директор Hyro Исраэль Круш излагает ингредиенты, необходимые для объединения LLM с платформами диалогового ИИ на уровне предприятия для создания действительно гибкого взаимодействия с пациентами, которое поддерживается постоянно обновляемыми организационными знания (собственные данные) и динамическая бизнес-логика (постоянно меняющиеся внутренние и внешние процессы).

Большой герой 6

На вопрос в недавнем интервью Becker's Hospital Review что он думает о ChatGPT и других LLM, Энди Чу, старший вице-президент по продуктам и технологиям в Providence Digital Innovation Group, сказал, что индустрия все еще «далеко от дней Big Hero 6», диснеевского фильма 2014 года, изображающего футуристического робота-медика. добавил, что он предполагает, что эта технология будет использоваться для ответов на административные вопросы, связанные с пациентами, «дерево решений» или общие вопросы медицинского образования.

https://youtu.be/jbKSvOfqxF0?embedable=true

Мысли Чу перекликаются с более широким мнением, разделяемым большинством лидеров цифрового здравоохранения, о том, что LLM, такие как MedPaLM, следует встречать с равными частями волнения и осторожности. Хотя нет никаких сомнений в том, что эти экстраординарные «машины» могут автоматизировать и ускорить широкий спектр преимущественно административных приложений, когда речь идет о медицинском и клиническом использовании, по-прежнему существуют явные тревожные флажки. Кроме того, отсутствие у LLM способности к адаптации данных делает их неэффективными для достижения любых целей, которые требуют текущих и развивающихся внутренних организационных знаний.

Чу выразил это лучше всего, сказав: «Важно помнить, что здравоохранение — это очень личное, а генеративные технологии искусственного интеллекта так же хороши, как и данные, к которым осуществляется доступ. Источники данных в здравоохранении должным образом безопасны и защищены, поэтому мы должны преувеличивают обещание, особенно когда речь идет о таких областях, как выявление симптомов, сортировка и рекомендации по клиническому лечению».

Также опубликовано здесь

Оригинал