Основной доклад NVIDIA GTC: архитектура Blackwell ускорит работу продуктов искусственного интеллекта в конце 2024 года

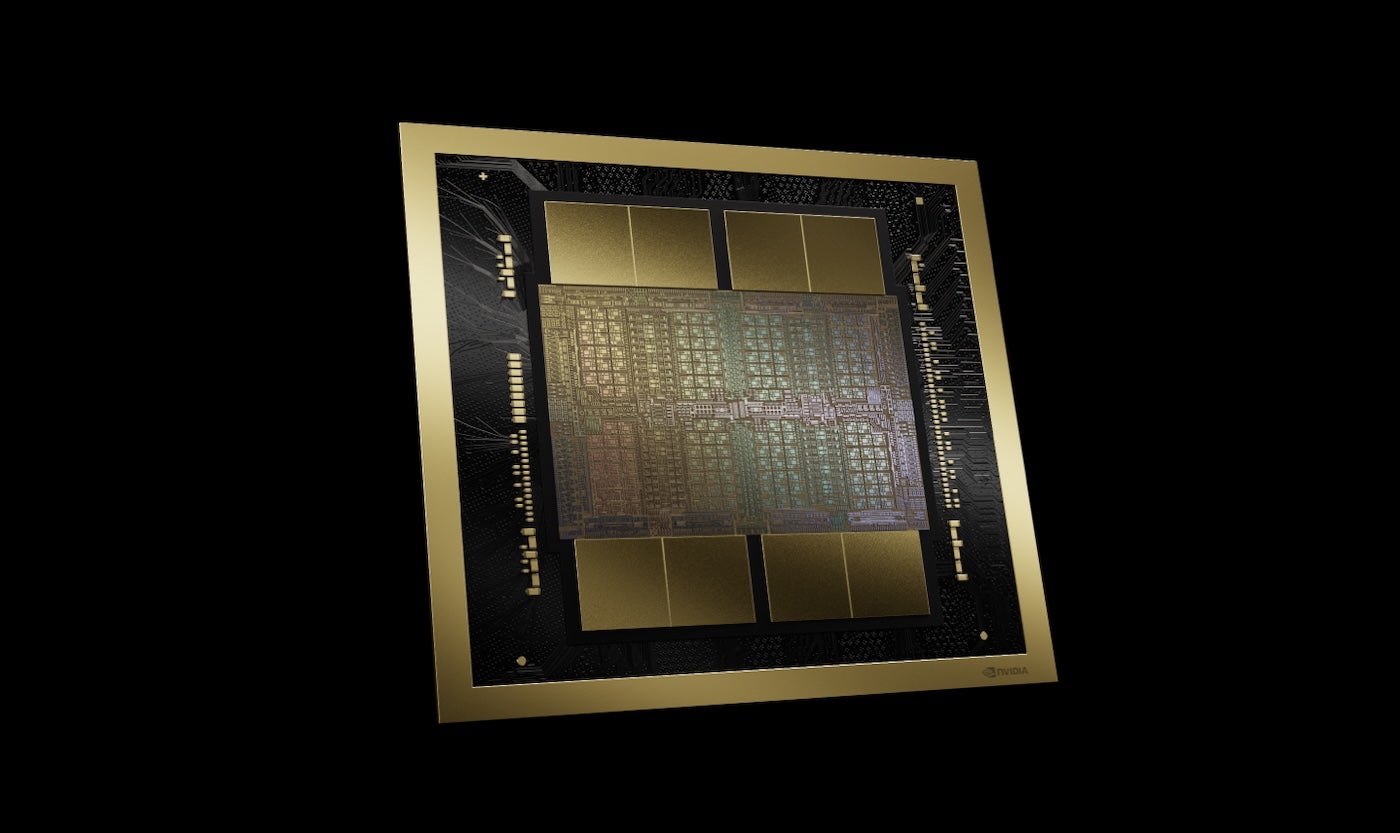

20 марта 2024 г.Новейшей платформой графических процессоров NVIDIA является Blackwell (рис. A), которую такие компании, как AWS, Microsoft и Google, планируют использовать для генеративного искусственного интеллекта и других современных вычислительных задач, заявил генеральный директор NVIDIA Дженсен Хуанг во время основного доклада на конференции NVIDIA GTC 18 марта в Сан-Франциско. Хосе, Калифорния.

Рисунок А

Продукты на базе Blackwell поступят на рынок от партнеров NVIDIA по всему миру в конце 2024 года. Хуанг объявил о длинной линейке дополнительных технологий и услуг от NVIDIA и ее партнеров, говоря о генеративном искусственном интеллекте как о лишь одном из аспектов ускоренных вычислений.

«Когда вы начинаете ускоряться, ваша инфраструктура — это графические процессоры CUDA», — сказал Хуанг, имея в виду CUDA, платформу параллельных вычислений и модель программирования NVIDIA. «И когда это произойдет, это будет та же инфраструктура, что и для генеративного ИИ».

Blackwell обеспечивает обучение и вывод больших языковых моделей

Платформа графического процессора Blackwell содержит два кристалла, соединенных межчиповым соединением со скоростью 10 терабайт в секунду, что означает, что каждая сторона может работать так, как если бы «два кристалла думали, что это один чип», — сказал Хуанг. Он имеет 208 миллиардов транзисторов и производится с использованием 208-миллиардного процесса NVIDIA 4NP TSMC. Он может похвастаться пропускной способностью памяти 8 ТБ/с и производительностью искусственного интеллекта 20 пентафлопс.

Для предприятий это означает, что Blackwell может выполнять обучение и логические выводы для моделей искусственного интеллекта с масштабированием до 10 триллионов параметров, сообщила NVIDIA.

Blackwell усовершенствован следующими технологиями:

- Второе поколение TensorRT-LLM и NeMo Megatron от NVIDIA.

Фреймворки для удвоения размеров вычислений и моделей по сравнению с движком-трансформером первого поколения.

Конфиденциальные вычисления с собственными протоколами шифрования интерфейса для обеспечения конфиденциальности и безопасности.

Специальный механизм распаковки для ускорения запросов к базе данных в области анализа и обработки данных.

Что касается безопасности, Хуанг сказал, что механизм надежности «выполняет самотестирование, внутрисистемное тестирование каждого бита памяти на чипе Blackwell и всей памяти, подключенной к нему. Это как если бы мы поставляли чип Blackwell с собственным тестером».

Продукты на базе Blackwell будут доступны у партнерских поставщиков облачных услуг, компаний-партнеров NVIDIA Cloud Partner и некоторых независимых облаках.

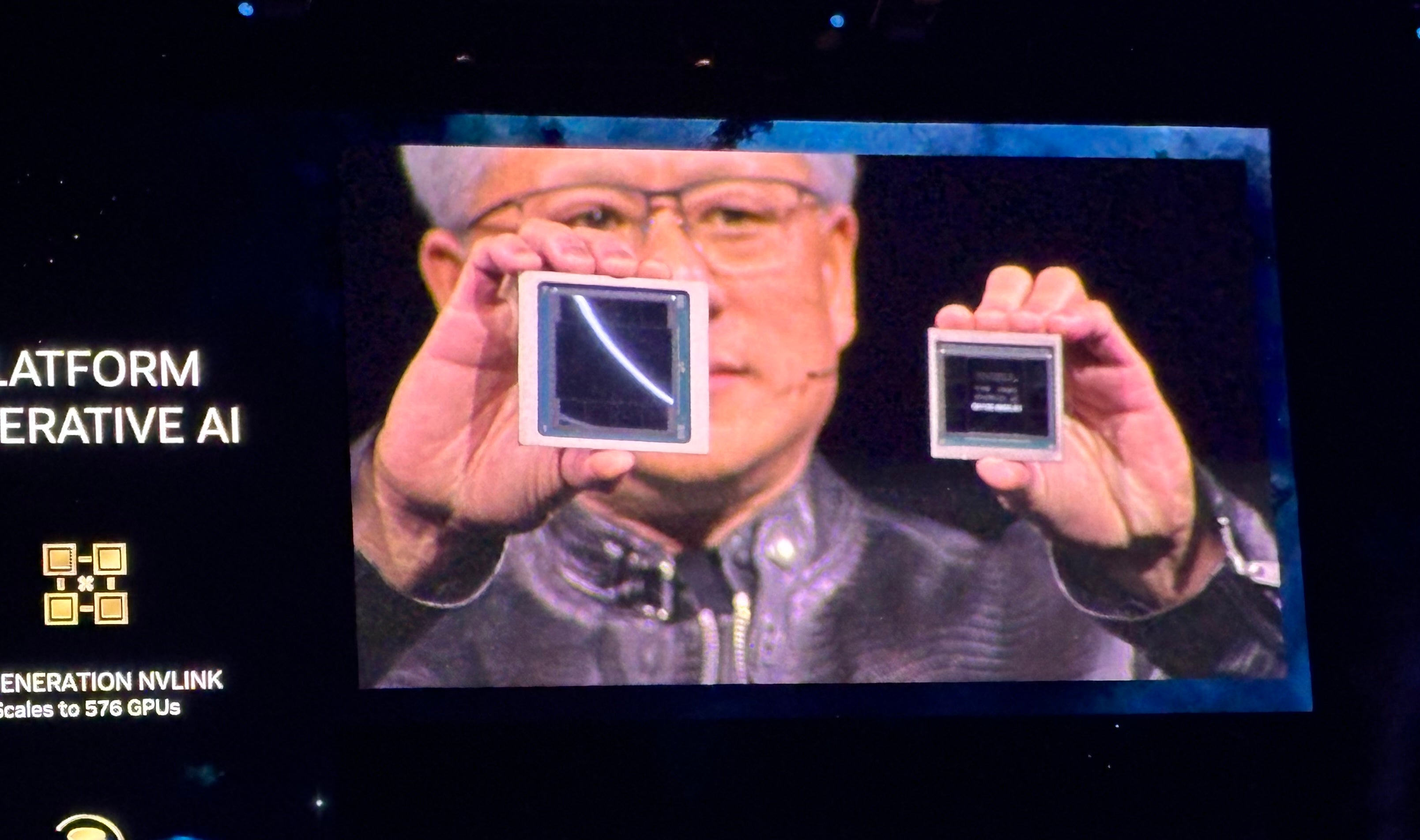

Линейка графических процессоров Blackwell следует за линейкой графических процессоров Grace Hopper, которая дебютировала в 2022 году (рис. B). NVIDIA заявляет, что Blackwell будет использовать генеративный искусственный интеллект в реальном времени на LLM с триллионом параметров при в 25 раз меньших затратах и меньшем энергопотреблении, чем линейка Hopper.

Рисунок Б

Суперчип NVIDIA GB200 Grace Blackwell соединяет несколько графических процессоров Blackwell

Наряду с графическими процессорами Blackwell компания анонсировала суперчип NVIDIA GB200 Grace Blackwell, который соединяет два графических процессора NVIDIA B200 с тензорными ядрами и процессор NVIDIA Grace, обеспечивая новую комбинированную платформу для вывода LLM. Суперчип NVIDIA GB200 Grace Blackwell можно связать с недавно анонсированными платформами NVIDIA Quantum-X800 InfiniBand и Spectrum-X800 Ethernet для обеспечения скорости до 800 ГБ/с.

GB200 будет доступен в облаке NVIDIA DGX, а также через экземпляры AWS, Google Cloud и Oracle Cloud Infrastructure позднее в этом году.

Новый дизайн сервера ориентирован на модели искусственного интеллекта с триллионом параметров

GB200 является одним из компонентов недавно анонсированного GB200 NVL72, стоечного сервера, который объединяет 36 процессоров Grace и 72 графических процессора Blackwell для производительности ИИ 1,8 экзафлопс. NVIDIA рассматривает возможные варианты использования огромных LLM с триллионом параметров, включая постоянную память разговоров, сложные научные приложения и мультимодальные модели.

GB200 NVL72 сочетает в себе разъемы NVLink пятого поколения (5000 кабелей NVLink) и суперчип GB200 Grace Blackwell, обеспечивающие огромную вычислительную мощность, которую Хуанг называет «экзофлопсной системой искусственного интеллекта в одной стойке».

«Это больше, чем средняя пропускная способность Интернета… мы могли бы отправить всё всем и каждому», — сказал Хуанг.

«Наша цель — постоянно снижать затраты и энергопотребление — они напрямую коррелируют друг с другом — вычислений», — сказал Хуанг.

Для охлаждения GB200 NVL72 требуется два литра воды в секунду.

Следующее поколение NVLink обеспечивает ускоренную архитектуру центров обработки данных.

Пятое поколение NVLink обеспечивает двунаправленную пропускную способность 1,8 ТБ/с на каждый графический процессор между 576 графическими процессорами. Эта версия NVLink предназначена для использования с самыми мощными и сложными LLM, доступными сегодня.

«В будущем центры обработки данных будут рассматриваться как фабрики искусственного интеллекта», — сказал Хуанг.

Представляем микросервисы NVIDIA Inference

Еще одним элементом возможной «фабрики искусственного интеллекта» является микросервис NVIDIA Inference, или NIM, который Хуанг назвал «новым способом получения и упаковки программного обеспечения».

NIM NVIDIA — это микросервисы, содержащие API, специализированный код, оптимизированные механизмы вывода и корпоративную среду выполнения, необходимые для запуска генеративного ИИ. Эти облачные микросервисы можно оптимизировать в соответствии с количеством графических процессоров, используемых клиентом, и запускать их в облаке или в собственном центре обработки данных. NIM позволяют разработчикам использовать API, NVIDIA CUDA и Kubernetes в одном пакете.

СМОТРИТЕ: Python остаётся самым популярным языком программирования согласно индексу TIOBE. (Техреспублик)

NIM используют ИИ для создания ИИ, упрощая некоторые сложные работы, такие как логические выводы и обучение, необходимые для создания чат-ботов. С помощью специализированных библиотек CUDA NIM можно настроить для конкретных отраслей, таких как здравоохранение.

По словам Хуана, вместо написания кода для программирования ИИ разработчики могут «собрать команду ИИ», которая будет работать над процессом внутри NIM.

«Мы хотим создавать чат-ботов – вторых пилотов с искусственным интеллектом – которые будут работать вместе с нашими дизайнерами», – сказал Хуанг.

NIM доступны с 18 марта. Разработчики могут бесплатно экспериментировать с NIM и запускать их по подписке NVIDIA AI Enterprise 5.0. NIM доступны в Amazon SageMaker, Google Kubernetes Engine и Microsoft Azure AI и могут взаимодействовать с платформами искусственного интеллекта Deepset, LangChain и LlamaIndex.

Новые инструменты для NVIDIA AI Enterprise выпущены в версии 5.0

NVIDIA выпустила версию 5.0 AI Enterprise, свою платформу развертывания искусственного интеллекта, призванную помочь организациям развертывать продукты генеративного искусственного интеллекта для своих клиентов. В версии 5.0 NVIDIA AI Enterprise добавлено следующее:

- НИМ.

Микросервисы CUDA-X для широкого спектра вариантов использования искусственного интеллекта с графическим ускорением.

AI Workbench — набор инструментов для разработчиков.

Поддержка платформы Red Hat OpenStack.

Расширенная поддержка новых графических процессоров NVIDIA, сетевого оборудования и программного обеспечения для виртуализации.

Оператор большой языковой модели NVIDIA с расширенным поиском теперь находится в раннем доступе для AI Enterprise 5.0.

AI Enterprise 5.0 доступен через Cisco, Dell Technologies, HP, HPE, Lenovo, Supermicro и других поставщиков.

Другие важные анонсы NVIDIA на GTC 2024

Хуан анонсировал широкий спектр новых продуктов и услуг в области ускоренных вычислений и генеративного искусственного интеллекта во время основного выступления NVIDIA GTC 2024.

NVIDIA анонсировала cuPQC, библиотеку, используемую для ускорения постквантовой криптографии. Разработчики, работающие над постквантовой криптографией, могут обратиться в NVIDIA за обновлениями о доступности.

Серия сетевых коммутаторов NVIDIA X800 ускоряет инфраструктуру искусственного интеллекта. В частности, серия X800 включает Ethernet-коммутаторы NVIDIA Quantum-X800 InfiniBand или NVIDIA Spectrum-X800, коммутатор NVIDIA Quantum Q3400 и NVIDIA ConnectXR-8 SuperNIC. Коммутаторы X800 будут доступны в 2025 году.

Основные партнерства, подробно описанные в программном докладе NVIDIA, включают:

- Полнофункциональная платформа искусственного интеллекта NVIDIA будет доступна в Oracle Enterprise AI начиная с 18 марта.

AWS предоставит доступ к инстансам Amazon EC2 на базе графического процессора NVIDIA Grace Blackwell и облаку NVIDIA DGX с защитой Blackwell.

NVIDIA ускорит Google Cloud с помощью вычислительной платформы NVIDIA Grace Blackwell AI и облачного сервиса NVIDIA DGX, которые появятся в Google Cloud. Google еще не подтвердил дату доступности, хотя, скорее всего, это будет конец 2024 года. Кроме того, платформа DGX Cloud на базе NVIDIA H100 обычно доступна в Google Cloud с 18 марта.

Oracle будет использовать NVIDIA Grace Blackwell в своем суперкластере OCI, вычислениях OCI и облаке NVIDIA DGX в облачной инфраструктуре Oracle. Некоторые комбинированные суверенные ИИ-сервисы Oracle-NVIDIA доступны с 18 марта.

Microsoft будет использовать суперчип NVIDIA Grace Blackwell для ускорения Azure. Поступление ожидается позднее в 2024 году.

Dell будет использовать инфраструктуру искусственного интеллекта и пакет программного обеспечения NVIDIA для создания Dell AI Factory, комплексного корпоративного решения искусственного интеллекта, доступного с 18 марта по традиционным каналам и Dell APEX. Когда-нибудь в будущем Dell будет использовать суперчип NVIDIA Grace Blackwell в качестве основы для стоечной архитектуры высокой плотности с жидкостным охлаждением. Суперчип будет совместим с серверами Dell PowerEdge.

SAP добавит возможности генерации дополненной информации NVIDIA в свой второй пилот Joule. Кроме того, SAP будет использовать NVIDIA NIM и другие совместные сервисы.

«Вся индустрия готовится к Блэквеллу», — сказал Хуанг.

Конкуренты ИИ-чипов NVIDIA

NVIDIA конкурирует в первую очередь с AMD и Intel в сфере корпоративного искусственного интеллекта. Qualcomm, SambaNova, Groq и множество поставщиков облачных услуг работают в одной и той же сфере в отношении генеративного вывода и обучения ИИ.

У AWS есть собственные платформы для вывода и обучения: Inferentia и Trainium. Помимо партнерства с NVIDIA по широкому спектру продуктов, Microsoft имеет собственный чип для обучения искусственного интеллекта и вывода: Maia 100 AI Accelerator в Azure.

Отказ от ответственности: NVIDIA оплатила мне авиабилеты, проживание и питание на мероприятии NVIDIA GTC, которое проходило с 18 по 21 марта в Сан-Хосе, Калифорния.

Оригинал