Перспективы и потенциал LLM в криптографии

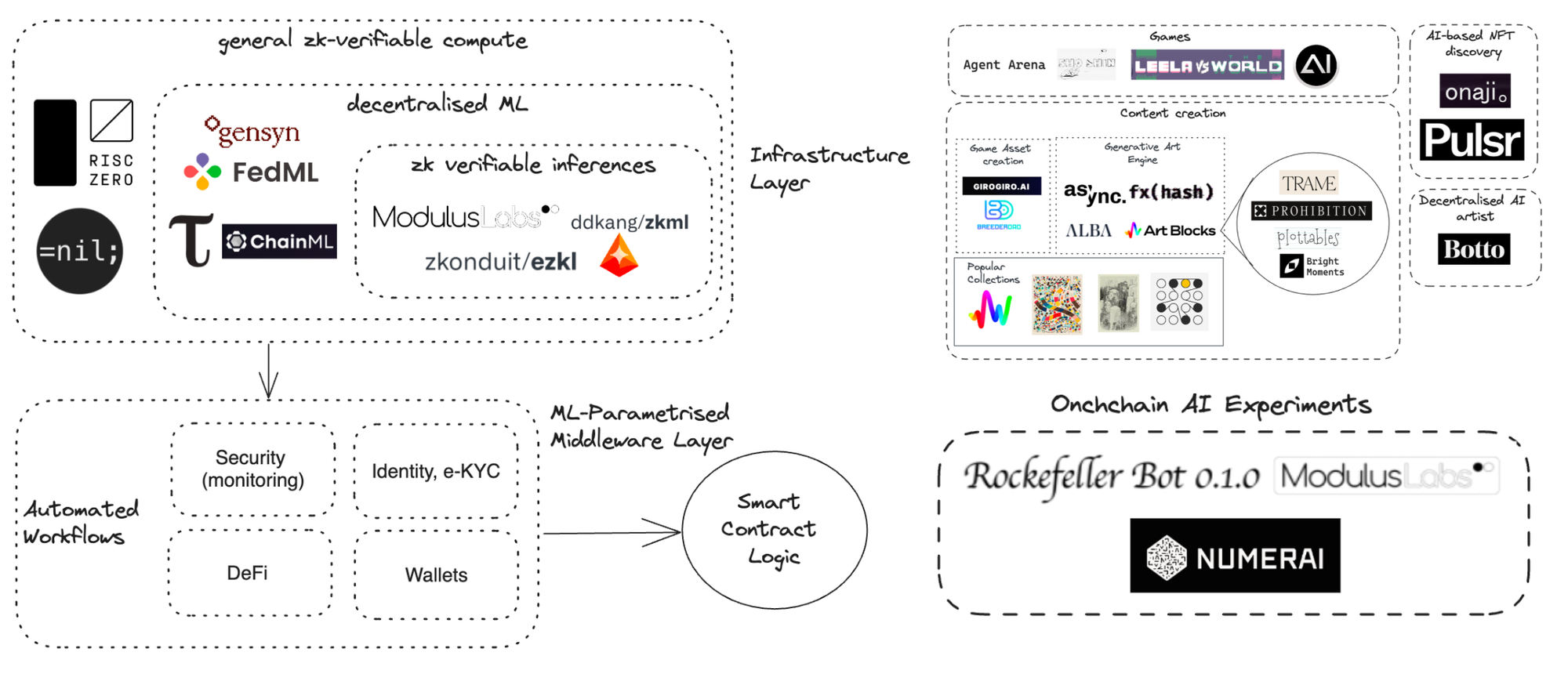

12 сентября 2023 г.Из-за бума LLM в последнее время мы видим все больше и больше проектов AI + Blockchain. Помимо комбинации LLM и блокчейна, мы также видим возвращение ИИ в блокчейн. ZKML — одна из популярных комбинаций.

Искусственный интеллект и блокчейн — это две разные технологии с совершенно разными характеристиками. ИИ требует большой вычислительной мощности, которую предлагают централизованные центры обработки данных. Блокчейны обеспечивают децентрализованные вычисления и конфиденциальность, но не подходят для больших вычислений и большого хранилища. Мы все еще ищем правильный способ объединения искусственного интеллекта и блокчейна. Вот обзор проектов AI + Blockchain.

В этом исследовании мы в основном сосредоточимся на применении LLM в криптопространстве. LLM – действительно мощная технология, поскольку она способна понимать естественный язык. Разработчики используют LLM в двух направлениях:

* Предоставляйте точные и актуальные ответы на большой объем контекстных данных. * Выполняйте конкретные задачи, используя разные агенты/инструменты

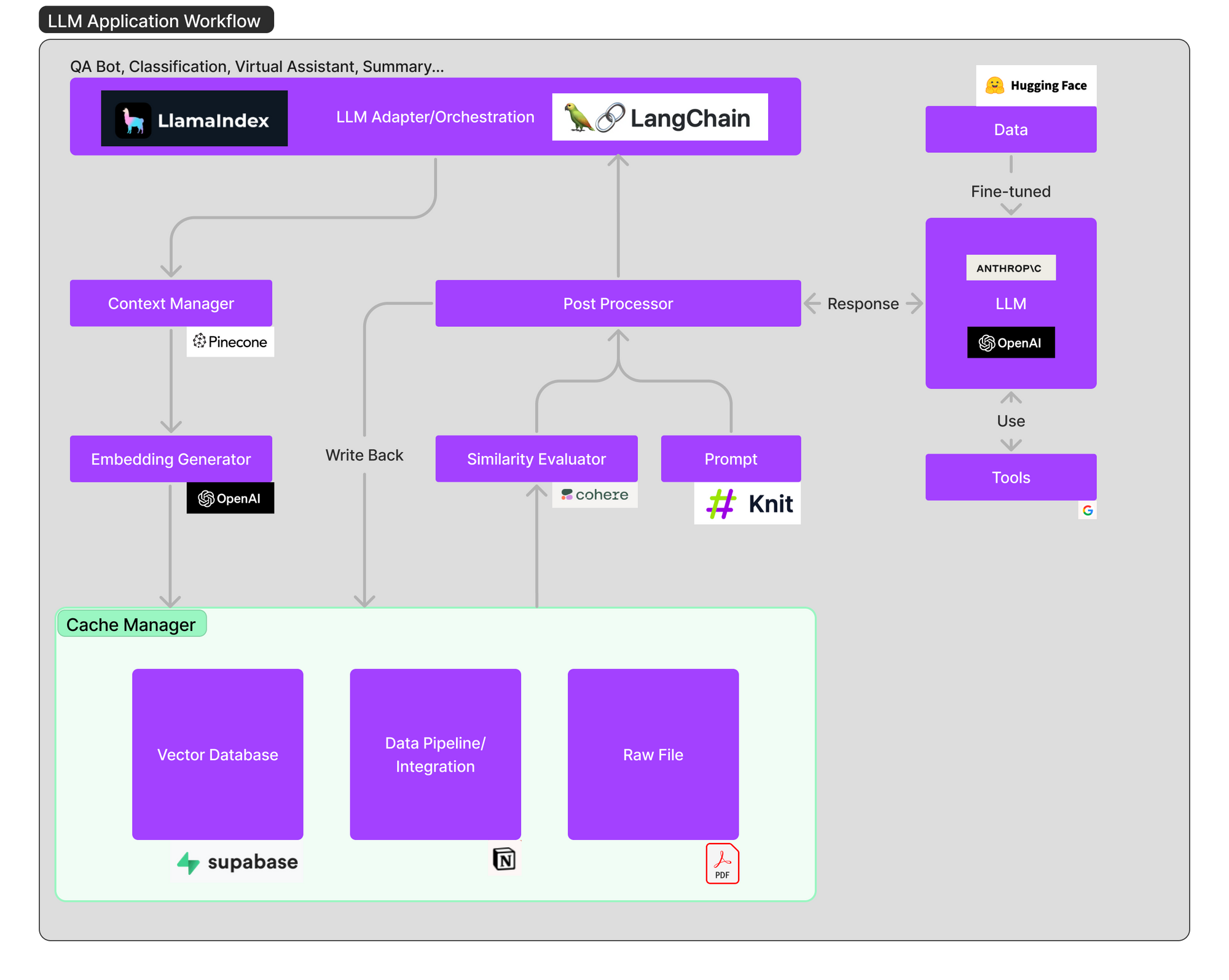

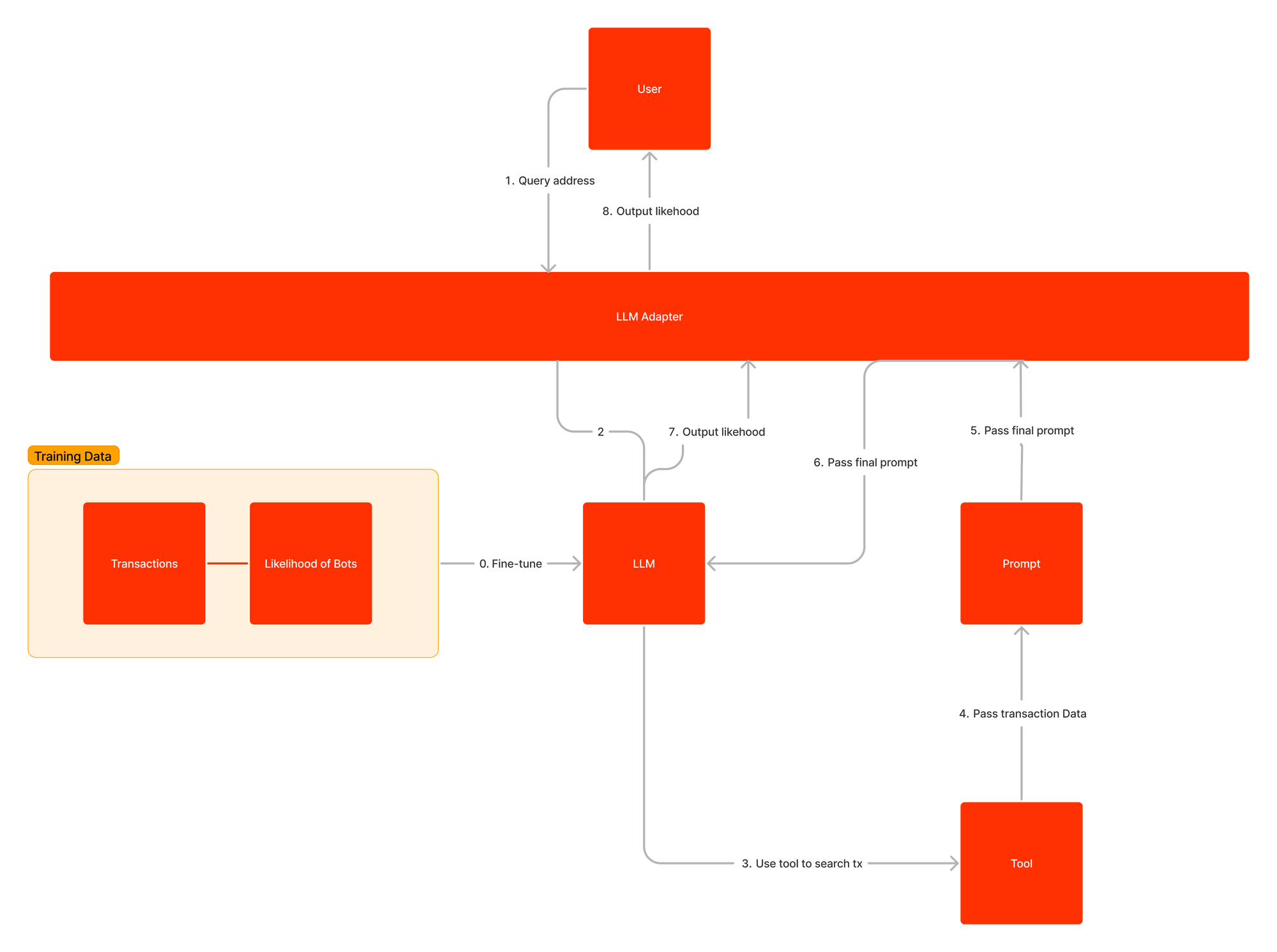

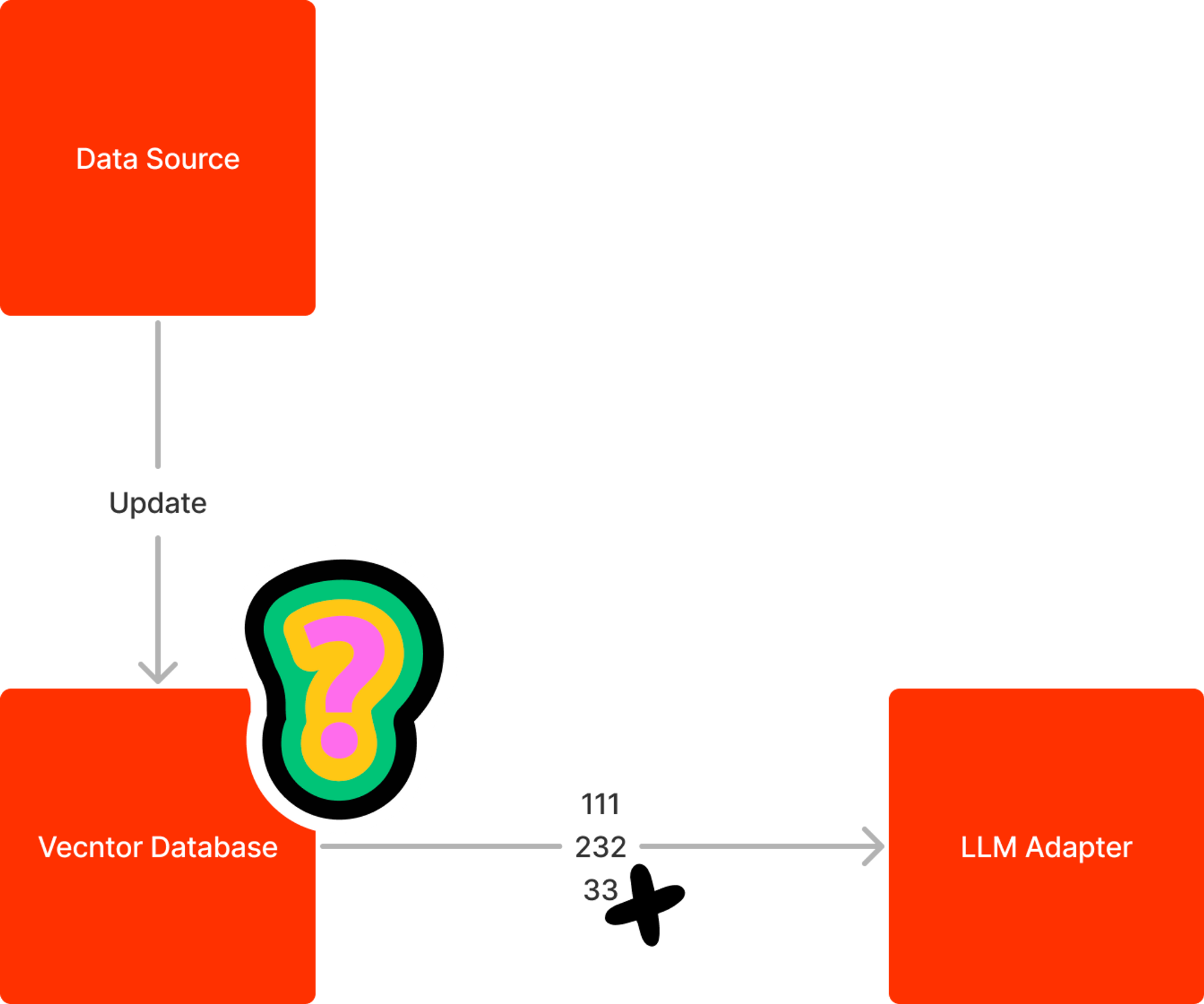

Вот диаграмма рабочего процесса разработки приложения LLM, отвечающего на вопросы пользователей. Сначала связанные источники данных генерируются во вложения и сохраняются в базе данных векторов. Адаптеры LLM используют пользовательские запросы и поиск по сходству для поиска связанных контекстов в базе данных векторов. Соответствующие контексты помещаются в приглашение и отправляются в LLM. LLM выполнит запросы и использует необходимые инструменты для генерации ответа. Иногда LLM настраивается на конкретные наборы данных, чтобы повысить точность и сократить расходы.

Рабочий процесс подачи заявки на LLM можно условно разделить на три основных этапа:

* Подготовка и внедрение данных. Этот этап предполагает сохранение конфиденциальной информации (например, заметок по проекту) для будущего доступа. Обычно файлы фрагментируются, обрабатываются с помощью модели внедрения, а затем сохраняются в базе данных определенного типа, известной как векторная база данных. * Формулирование и извлечение подсказок: когда пользователь отправляет поисковый запрос (в данном случае поиск информации о проекте), программное обеспечение создает последовательность подсказок для ввода в языковую модель. Последнее приглашение обычно включает в себя шаблон приглашения, жестко закодированный разработчиком программного обеспечения, примеры действительных результатов, называемые примерами с несколькими фрагментами, любые необходимые данные, полученные от внешних API, и набор соответствующих файлов, извлеченных из базы данных векторов. * Выполнение и вывод подсказок: после завершения подсказок они передаются в уже существующую языковую модель (LLM) для вывода, которая может включать в себя как API-интерфейсы собственной модели, так и модели с открытым исходным кодом или индивидуально настроенные модели. Некоторые разработчики могут также включить на этом этапе операционные системы, такие как ведение журнала, кэширование и проверка.

Мы предлагаем 8 потенциальных направлений, в которых LLM может помочь сфере блокчейна:

* Интегрируйте встроенные функции Al/LLM в блокчейн. * Используйте LLM для анализа записей транзакций. * Используйте LLM для выявления потенциальных ботов. * Используйте LLM для написания кодов * Используйте LLM для чтения кода. * Используйте LLM, чтобы помочь сообществу. * Используйте LLM для отслеживания рынка * Используйте LLM для анализа проектов

Интегрируйте встроенные функции AI/LLM в блокчейн

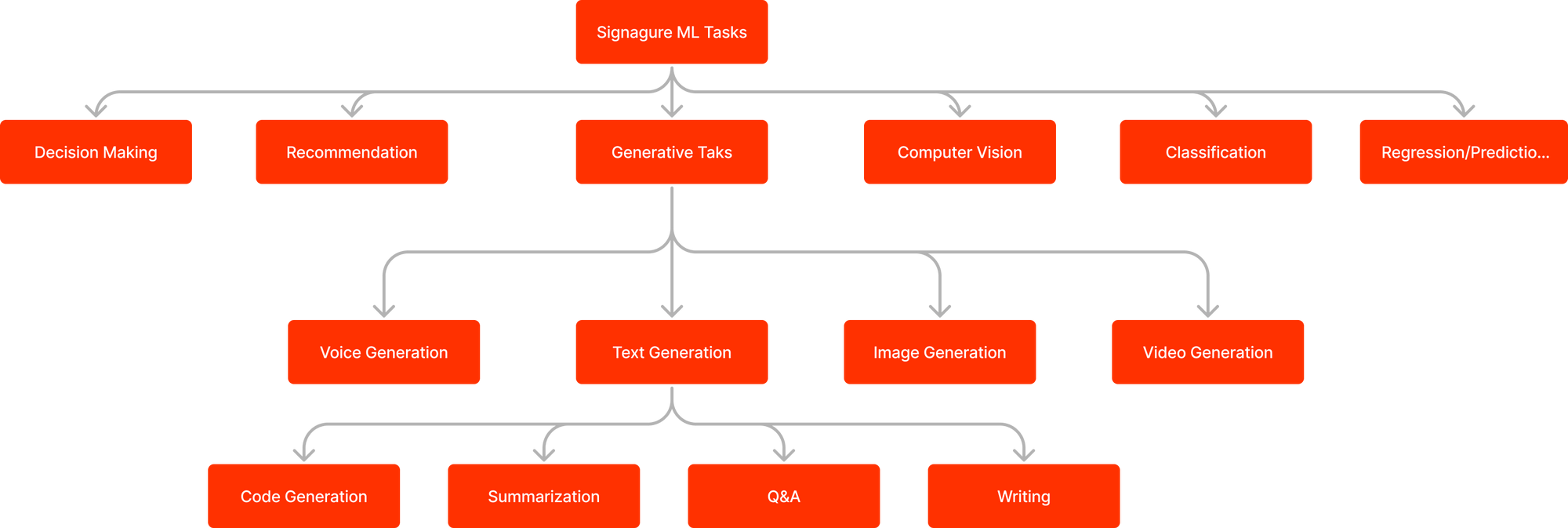

Блокчейн будет иметь встроенные функции и модели искусственного интеллекта. Разработчики смогут получить доступ к функциям искусственного интеллекта для выполнения характерных задач машинного обучения, таких как классификация, регрессия, завершение текста и AIGC в цепочке. Разработчики могут вызывать эти функции ИИ через смарт-контракты.

Благодаря этим встроенным функциям разработчики могут наделить свои смарт-контракты интеллектуальностью и автономностью. Классификации, регрессия и AIGC — типичные задачи ИИ. Давайте посмотрим, как их можно использовать в сфере блокчейна, и рассмотрим несколько примеров проектов.

Классификации

Классификация может использоваться, чтобы определить, является ли адрес ботом или реальным человеком. Это может изменить текущую ситуацию с продажей NFT. Классификация также может повысить безопасность экосистемы DeFi. Смарт-контракты DeFi могут фильтровать вредоносные транзакции и предотвращать потерю средств.

Регресс

Регрессионную деятельность можно использовать в прогнозировании. Его можно использовать в управлении фондами и активами.

Numer.ai уже использовал искусственный интеллект, чтобы помочь им управлять своими средствами. Numer предоставляет высококачественные данные фондового рынка. Ученые, работающие с данными, работают над этими данными и применяют машинное обучение для прогнозирования фондового рынка.

AIGC

Многие проекты NFT пытаются создать вселенную IP. Однако их ограниченное содержание не может поддерживать вселенную. Если мы сможем использовать AIGC в цепочке, модель AIGC сможет выводить бесчисленное количество контента по относительно низкой цене. Этот сгенерированный контент имеет схожий фирменный стиль. В модели возможен вывод текста, иллюстраций, музыки, вокала или даже музыки. Это значительно расширяет вселенную IP. Участники сообщества могут совместно настроить модель в соответствии со своими ожиданиями. Процесс тонкой настройки также дает сообществу ощущение вовлеченности.

Ботто уже использовал модель AIGC для создания художественного контента. Сообщество голосует за понравившиеся изображения, чтобы коллективно доработать модель AIGC.

Если мы рассматриваем блокчейн как базу данных, мы также обнаруживаем, что Databend интегрирует встроенные функции искусственного интеллекта в свою базу данных. Они предоставляют такие функции, как:

- ai_embedding_vector: создает вложения для текстовых документов.

- ai_text_completion: генерирует текстовые дополнения на основе заданного запроса.

- cosine_distance: вычисляет косинусное расстояние между двумя вложениями.

- ai_to_sql: преобразует инструкции естественного языка в запросы SQL.

Разработчики могут применять эту функцию к своим запросам SQL. Например, поддерживается следующий запрос:

USE <your-database>;

SELECT * FROM ai_to_sql('<natural-language-instruction>');

Предоставление возможностей ИИ для блокчейна

Мы видим несколько проектов, предоставляющих функции искусственного интеллекта для блокчейна.

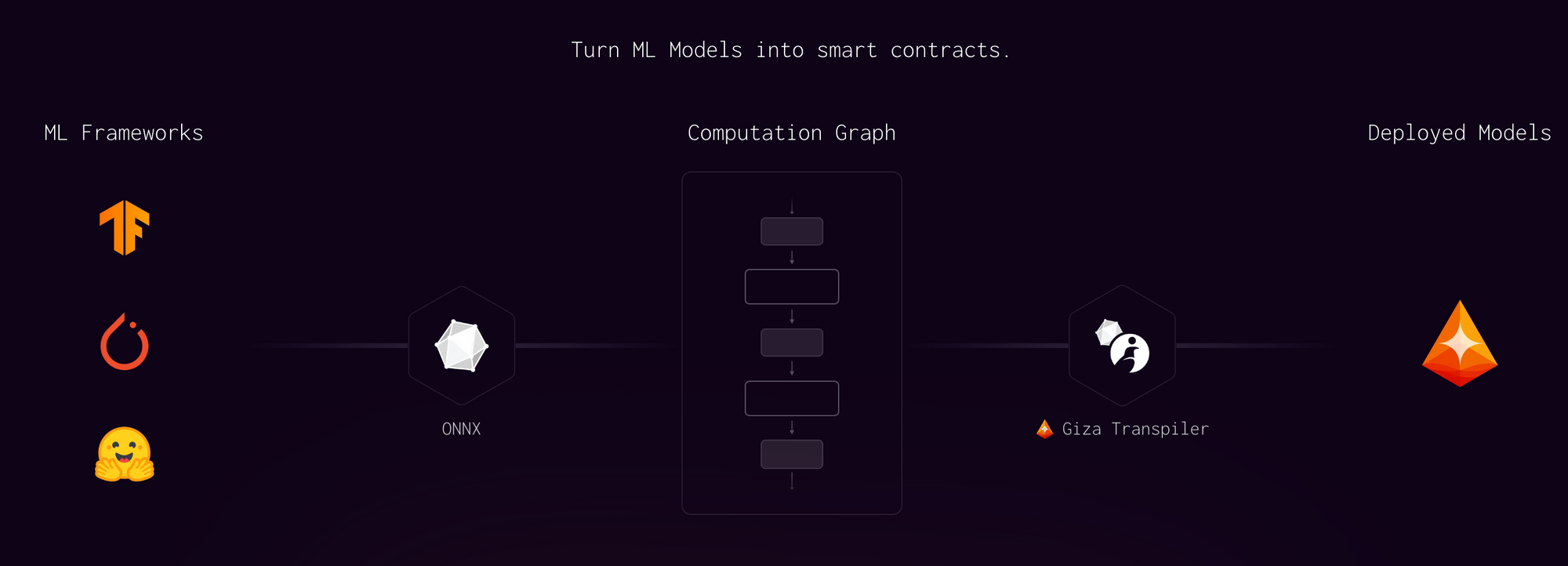

Гиза работает на стороне ZKML. Он генерирует доказательства вывода вне цепочки и выполняет проверку внутри цепочки. Теперь он поддерживает EVM-совместимые цепочки и StarkNet. Гиза недавно объявила о своем партнерстве с Yearn.finance. Yearn будет использовать функции искусственного интеллекта Giza для улучшения оценки рисков.

Modulus Labs работает в схожих направлениях. Они приложили больше усилий к совершенствованию систем проверки для создания высокопроизводительных схем для искусственного интеллекта. Они выпустили демо-версии, такие как шахматный ИИ и ИИ прогнозирования цен на ETH. Их новая демо-версия zkMon — это первая в мире проверенная коллекция NFT генеративно-состязательной сети с нулевым разглашением данных.

Используйте LLM для анализа записей транзакций

Анализ записей транзакций обычно выполняется с помощью определенных приложений, таких как Debank. Людям сложно анализировать записи транзакций вручную. Анализ вручную включает сбор данных, очистку данных и анализ данных. Пользователи должны иметь возможность кодировать. Благодаря LLM у нас появился новый подход. LLM имеет возможность анализировать и визуализировать данные. Таким образом, с помощью LLM мы можем анализировать данные в цепочке с помощью настроек. Мы можем анализировать коэффициент выигрыша, коэффициент производительности или все, что мы хотели бы знать.

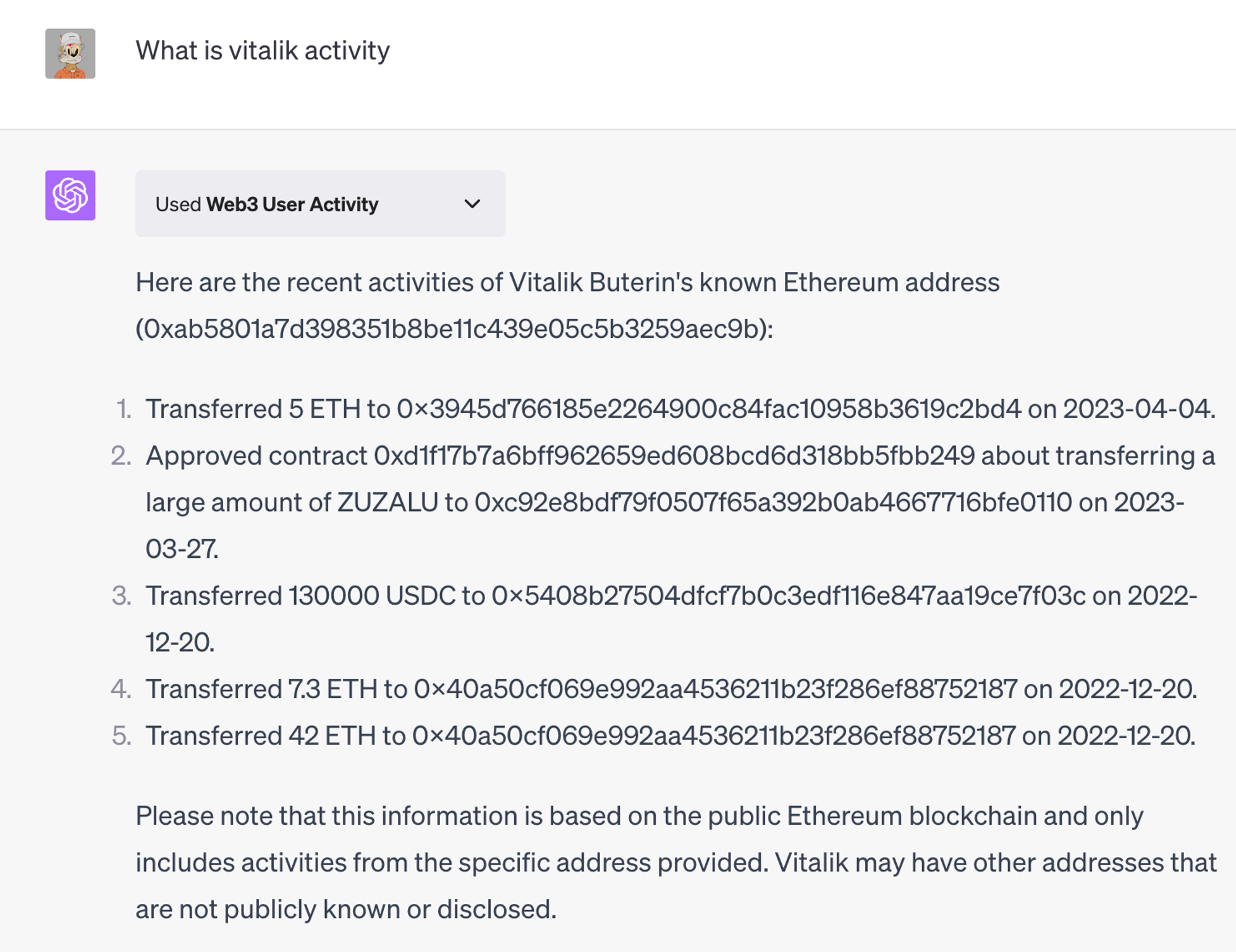

Для развития этого направления RSS3 разработала плагин Web3 User Activity для ChatGPT. Пользователи могут ввести адрес кошелька, ENS или Lens, чтобы просмотреть активность в сети. Плагин будет выводить транзакции в удобочитаемой форме. Однако он не может выполнять сложные запросы, например, сколько держателей Azuki и какие смарт-контракты самые популярные. Пользователи также должны быть осведомлены о точности адреса и метки предоставленного плагина.

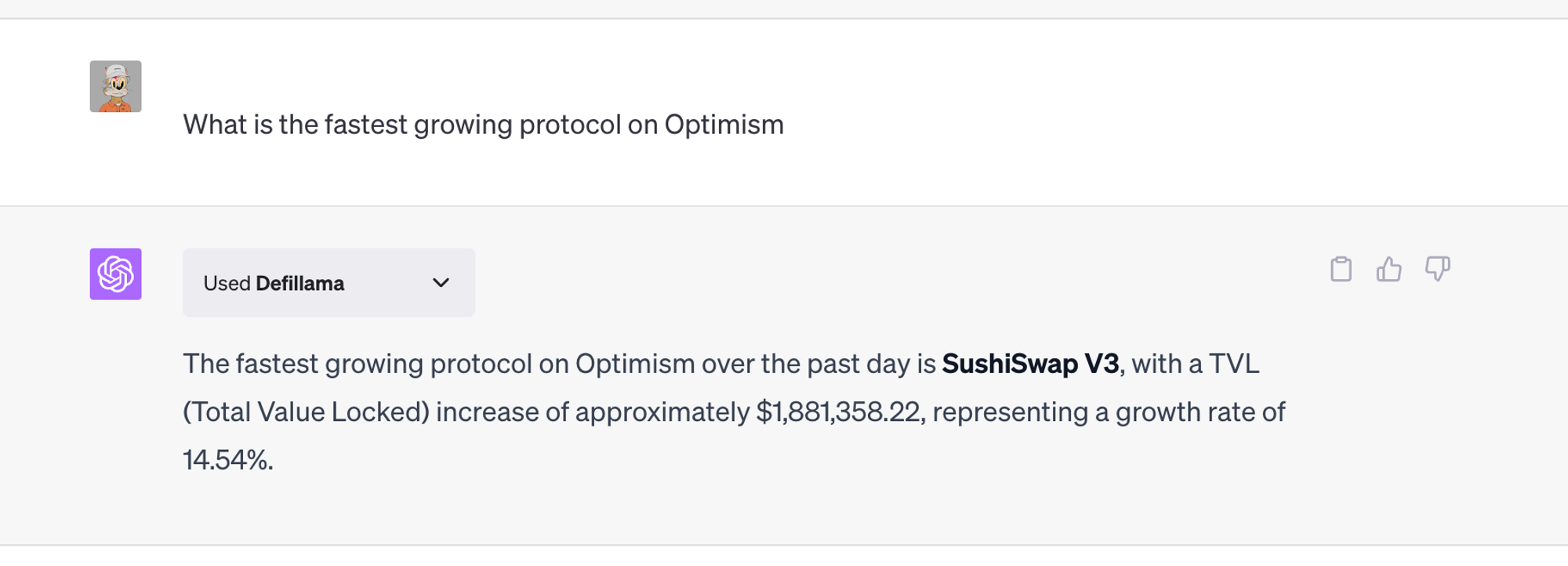

DeFiLlama также выпустила плагин ChatGPT. Пользователи могут использовать естественный язык, чтобы запросить любые данные, доступные на DeFiLlama. Он также может выполнять простые фильтры и сортировки.

Dune также интегрирует GPT в свои продукты. Dune планировала реализовать следующие функции:

- Пояснения к запросу: используйте LLM для объяснения запроса.

- Переводы запросов: используйте LLM для перевода других языков SQL в DuneSQL.

- Запросы на естественном языке: пользователи могут использовать естественный язык для написания запроса.

- Поиск: используйте LLM для улучшения результатов поиска.

- База знаний мастера: чат-бот для пользователей, обменивающихся документами.

Помимо анализа данных в цепочке, Dune также интегрировала LLM в другие функции, о которых мы поговорим позже.

Как и «Дюна», «Пространство и время» также работает над переводом естественного языка в SQL на базе OpenAI.

Данные блокчейна — это высокоструктурированные данные. Использование естественного языка для прямого запроса к базе данных может не дать точных результатов. Лучшим подходом было бы преобразовать естественный язык в SQL и затем выполнить соответствующие запросы SQL.

Используйте LLM для повышения безопасности

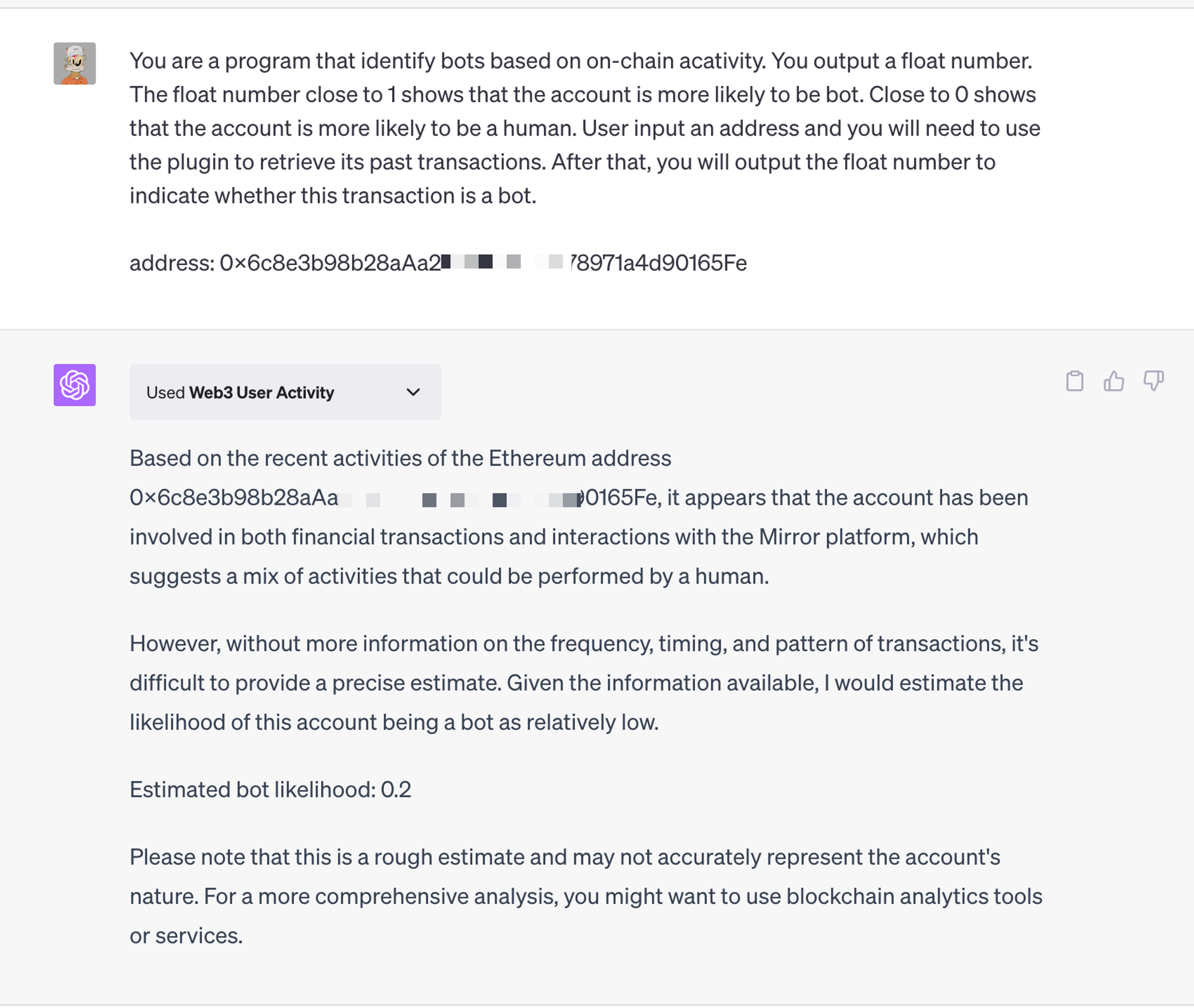

Поскольку LLM обладает логическими и логическими способностями, его можно использовать для фильтрации некоторых вредоносных транзакций. Он действует как межсетевой экран для смарт-контрактов. Вот конкретный пример блокировки действий ботов.

После ввода адреса LLM может получить все данные о транзакциях через сторонний плагин. Затем LLM анализирует эти записи транзакций и выдает вероятность того, что адрес принадлежит боту. Эту функцию можно подключить к децентрализованным приложениям, которые не поддерживают ботов, например к продажам NFT.

Вот простой пример через ChatGPT. ChatGPT получает записи транзакций учетной записи через плагин активности пользователей Web3, разработанный RSS3. Затем ChatGPT анализирует эти записи транзакций и выводит вероятность того, что учетная запись является ботом.

Если мы введем больше записей о транзакциях и настроим LLM на наборах данных, связанных с ботами, мы сможем получить более точные результаты. Вот пример рабочего процесса для таких приложений. Мы также можем добавить кеширование и уровень базы данных, чтобы повысить скорость ответа и снизить затраты.

Используйте LLM для написания кода

LLM широко используется в разработке, чтобы помочь разработчикам писать код быстрее и лучше. По инструкциям разработчиков LLM может генерировать для них код. В настоящее время разработчикам еще предстоит дать подробную инструкцию по LLM. LLM сложно автоматически сгенерировать весь проект для разработчиков.

Некоторые популярные модели LLM для кодов: StarCoder, StarCoder+, Code T5, LTM, DIDACT, WizardCoder, FalCoder-7B, MPT30B.

Все они могут быть использованы для написания смарт-контрактов, но они не могут быть специально обучены на данных смарт-контрактов. Им еще есть куда расти.

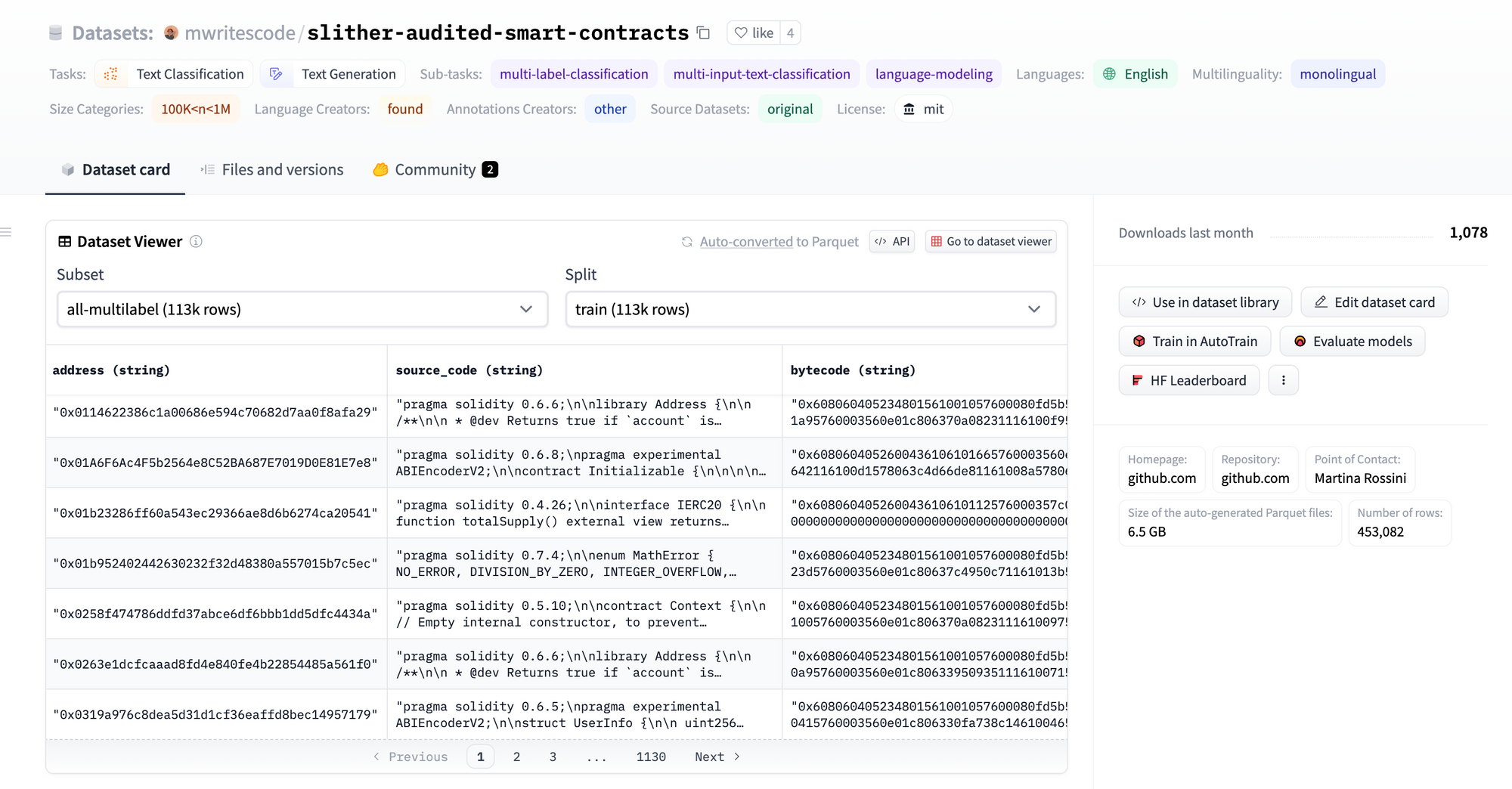

В настоящее время на HuggingFace доступен только один набор данных, связанный со смарт-контрактами. Это смарт-контракты, прошедшие скользящий аудит. Он содержит 113 тысяч смарт-контрактов. Его можно использовать для классификации текста, генерации текста и обнаружения уязвимостей.

По сравнению со вторыми пилотами автоматическая генерация кода была бы более перспективной. Автоматическая генерация кода подходит для смарт-контрактов, поскольку смарт-контракты относительно короткие и простые. Существует несколько способов, которыми LLM может помочь разработчику автоматически писать коды в пространстве блокчейна.

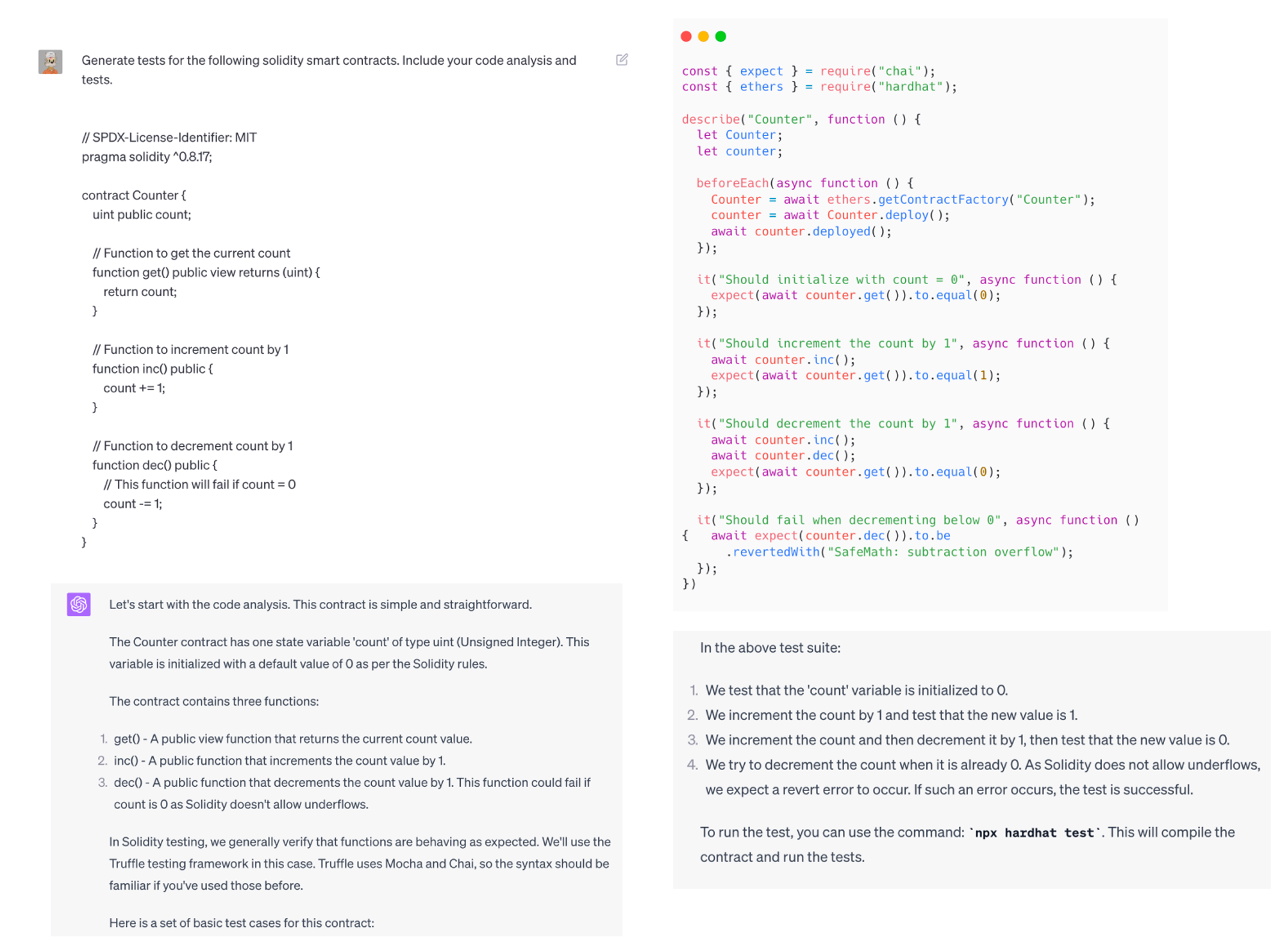

Тесты

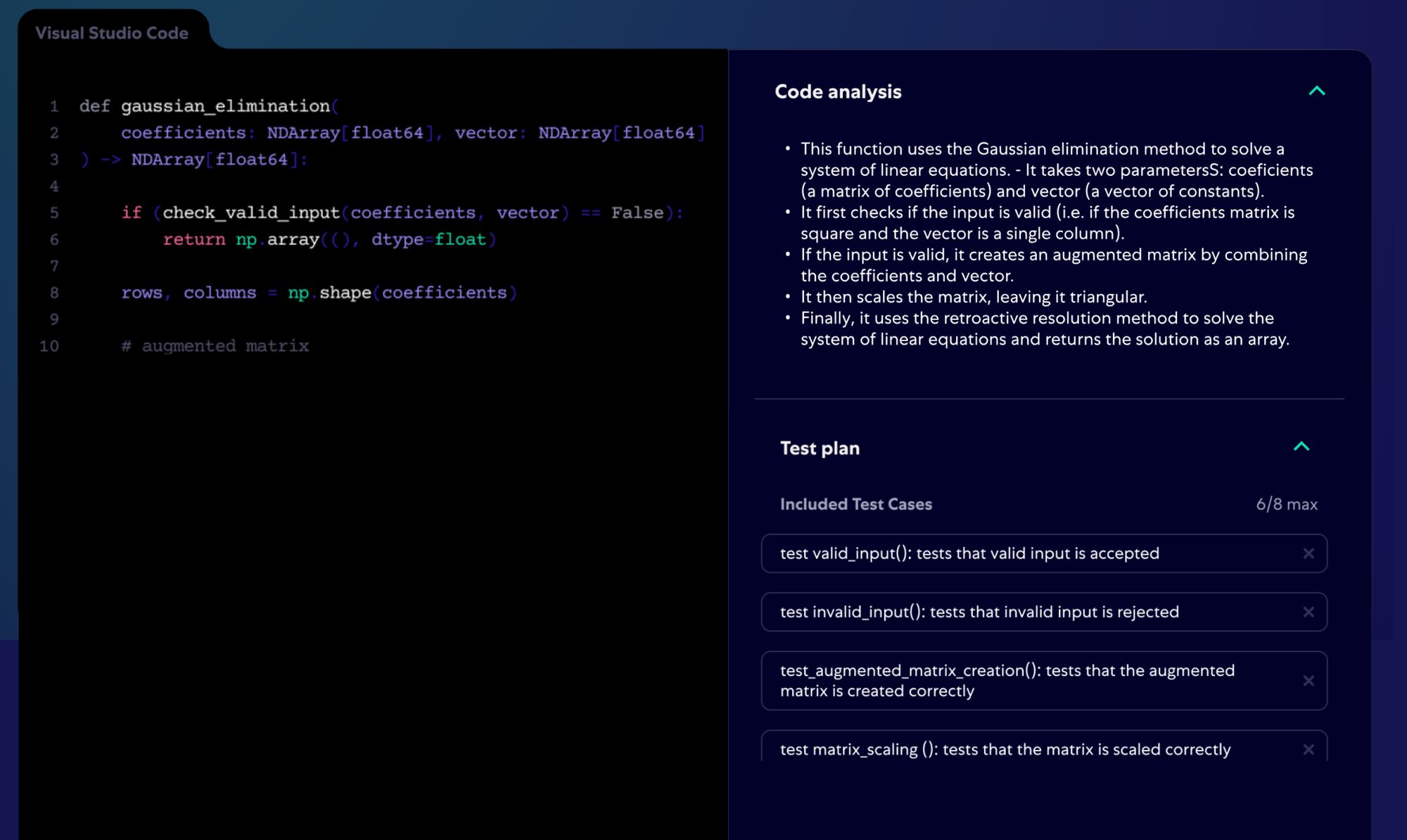

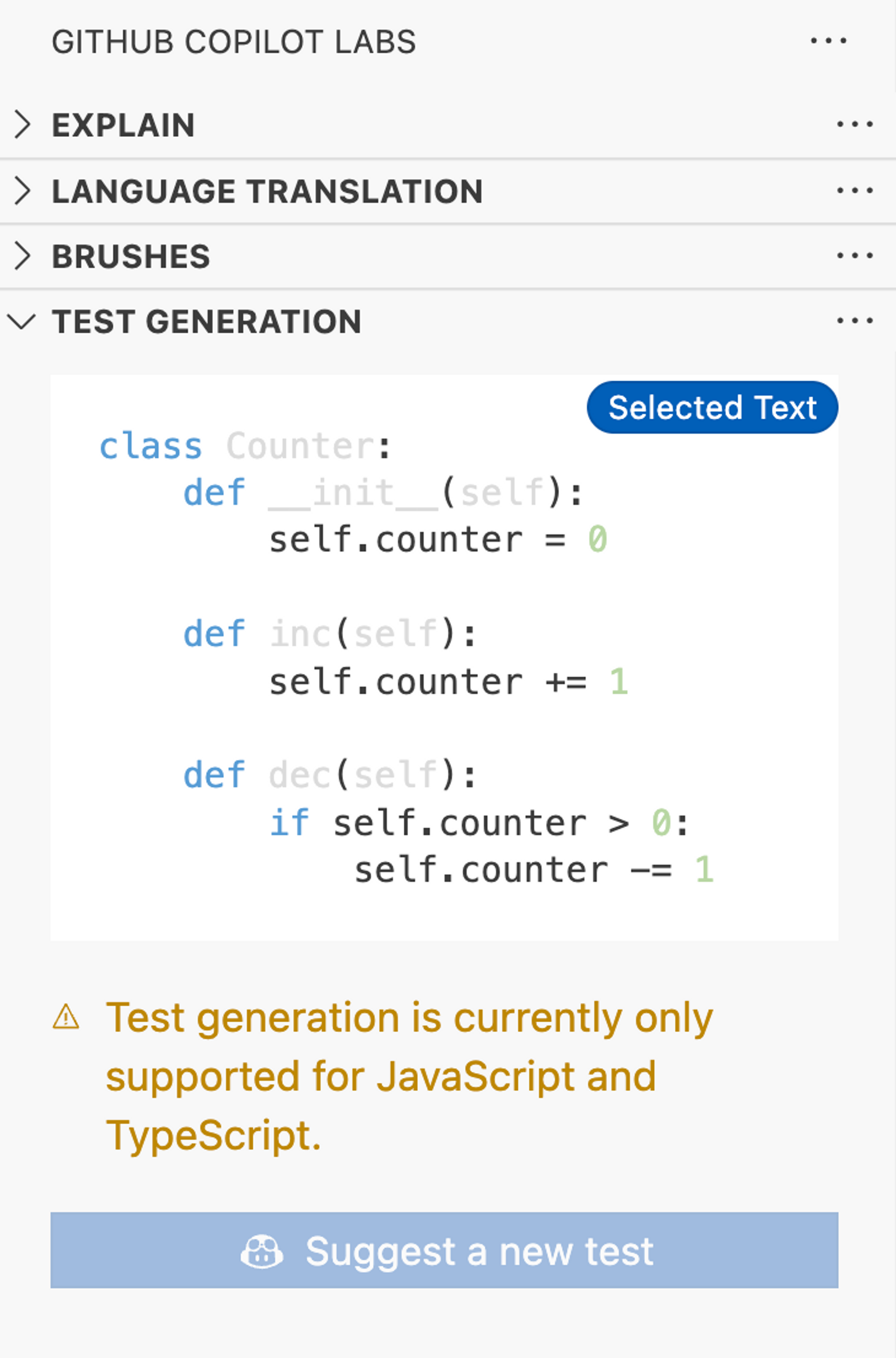

Во-первых, LLM может генерировать тесты для хорошо написанных смарт-контрактов. Уже существуют такие проекты, как Codium, которые могут автоматически генерировать тесты для написанных проектов. Codium в настоящее время поддерживает JS и TS. Codium сначала изучает кодовую базу и анализирует каждую функцию, строку документации и комментарий. Codium напишет анализ кода в виде комментариев к файлам и выведет план тестирования. Пользователи могут выбирать тесты, которые им нравятся, и Coidum сгенерирует выбранные тесты.

Другое программное обеспечение второго пилота также поддерживает создание тестов для выбранных функций.

Мы можем выполнить аналогичные шаги, чтобы воспроизвести аналогичные функции в GPT-4.

Сначала мы просим провести анализ кода, потому что хотим, чтобы LLM уделял этой задаче больше времени. LLM не знает, какие задачи сложны. Он распределяет одинаковое количество вычислительной мощности на каждый токен. Это может привести к неточным результатам при выполнении сложных задач. На основании этих характеристик мы запрашиваем анализ кода. Таким образом, LLM потратит больше токенов/времени на обдумывание этих задач и выдаст более качественные результаты. Этот метод еще называют цепочкой мыслей.

Чтобы заставить его работать с более длинными смарт-контрактами, нам нужен LLM с более широким контекстом или какой-то инженерный проект для сохранения памяти.

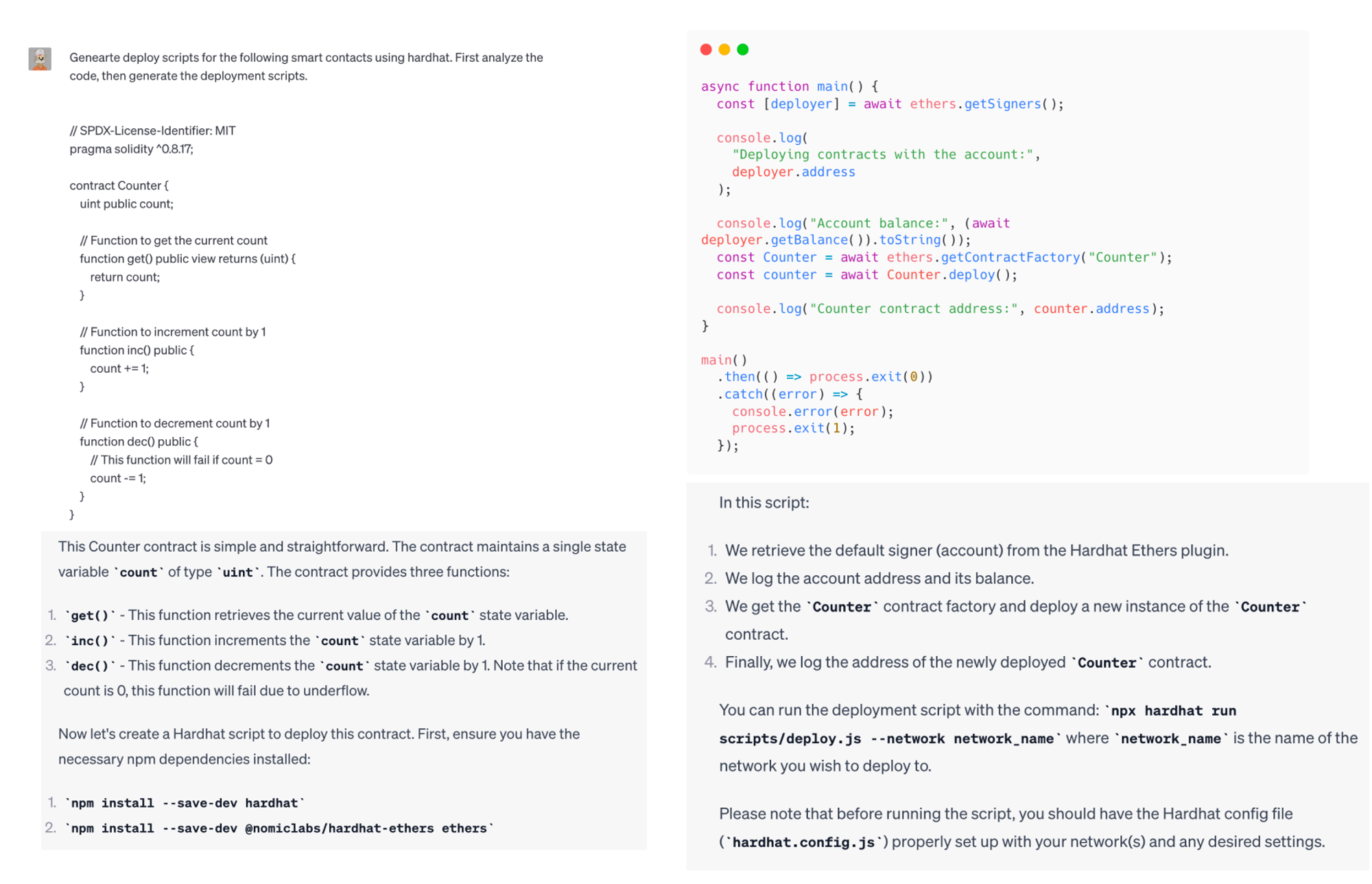

Создание вспомогательных сценариев

Во-вторых, мы можем использовать LLM для автоматического создания некоторых вспомогательных сценариев, например развертывания.

Сценарии развертывания могут уменьшить количество потенциальных ошибок в процессе развертывания вручную. Идея очень похожа на автоматическое создание тестов.

Автоматическое разветвление

На бычьем рынке существует множество форк-проектов. Эти команды разветвленных проектов немного меняют исходную кодовую базу. Это был бы отличный вариант использования LLM. LLM может помочь разработчикам автоматически изменять код в соответствии с потребностями команд. Обычно необходимо изменить только определенные части кода. Для LLM это будет относительно легко сделать.

Автоматическое создание кода

Что, если мы сделаем еще один шаг вперед? Может ли LLM автоматически генерировать смарт-контракты для разработчиков в соответствии с их потребностями? Смарт-контракты относительно короткие и простые по сравнению с другим сложным программным обеспечением, написанным на JS, Rust и Python. Смарт-контракты не имеют большого количества внешних библиотек. LLM относительно легко понять, как писать смарт-контракты.

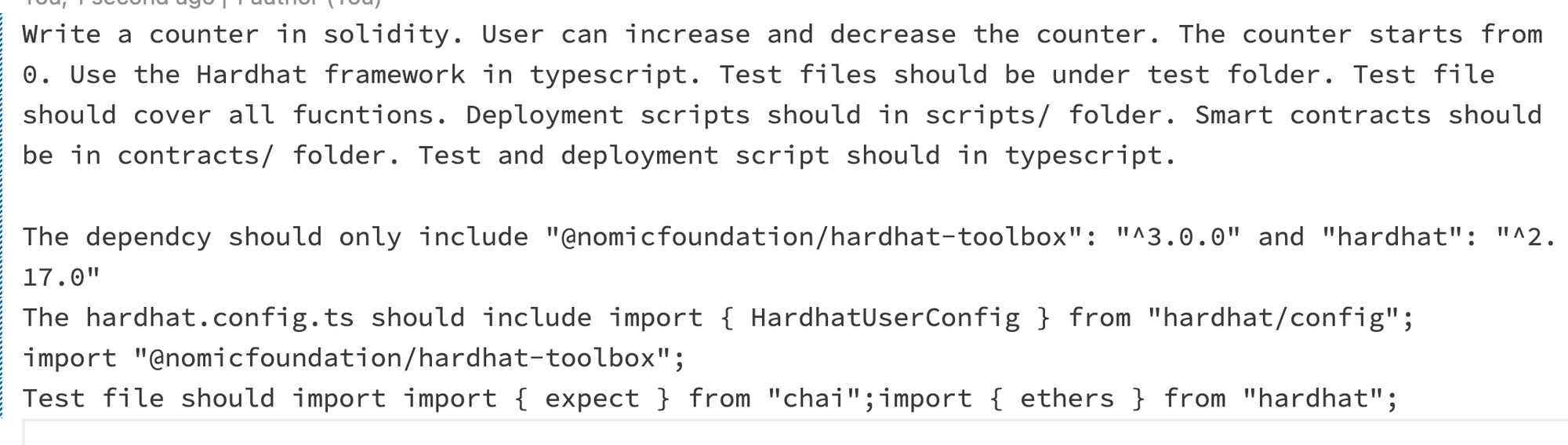

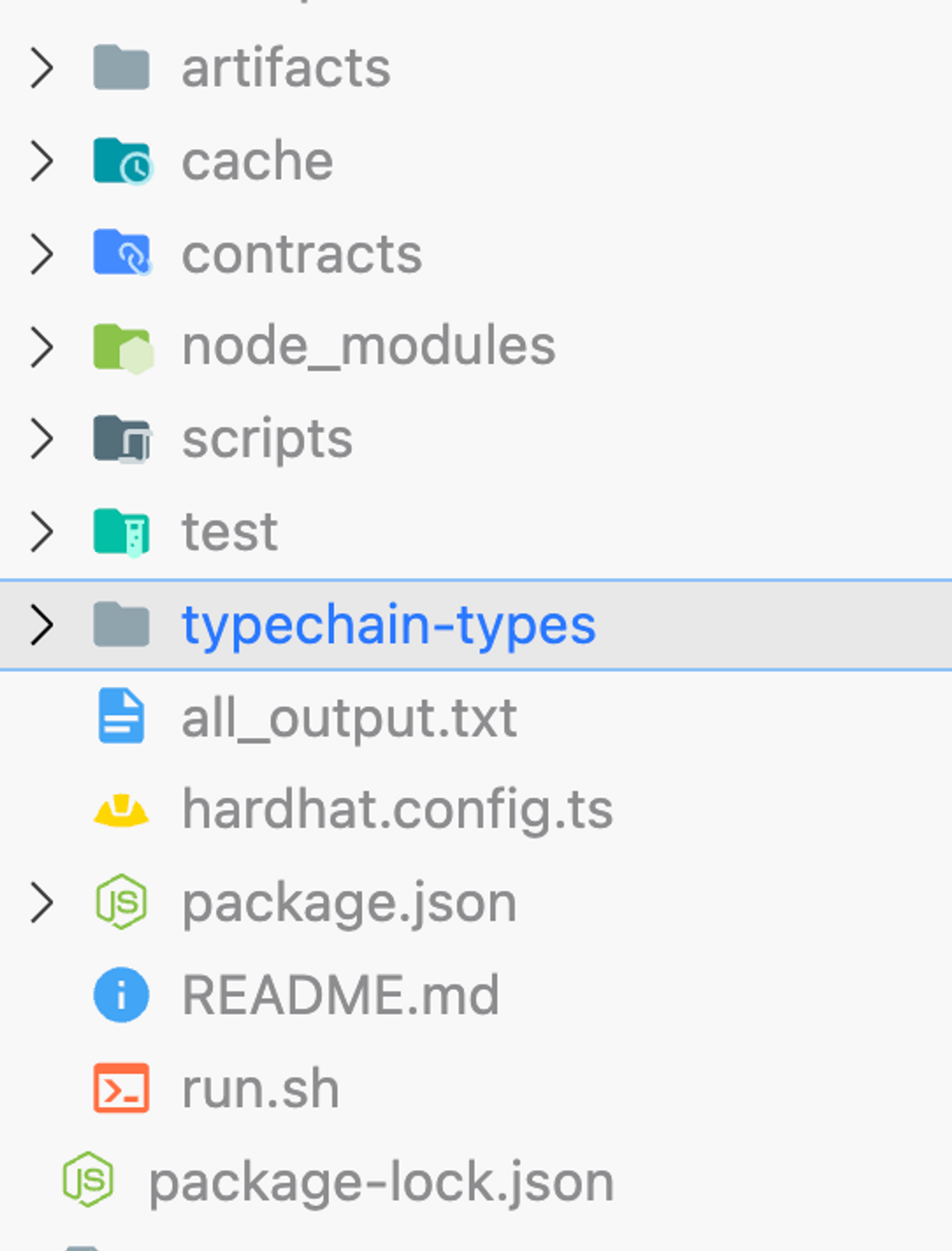

Мы уже наблюдаем некоторый прогресс в автоматической генерации кода. GPT-engineer — один из пионеров. Пользователь должен выполнить свои требования и устранить любую путаницу со стороны LLM. Затем он начал кодировать. Код также включает сценарий, который может запустить весь проект. GPT-инженер может автоматически запустить проект для разработчиков.

Пользователь вводит свои требования. GPT-инженер проанализирует требования и запросит разъяснения. После сбора всей необходимой информации GPT-инженер сначала выводит дизайн программы. Сюда входят основные классы, функции и методы, необходимые для этой задачи. Затем GPT-инженер сгенерирует код для каждого файла.

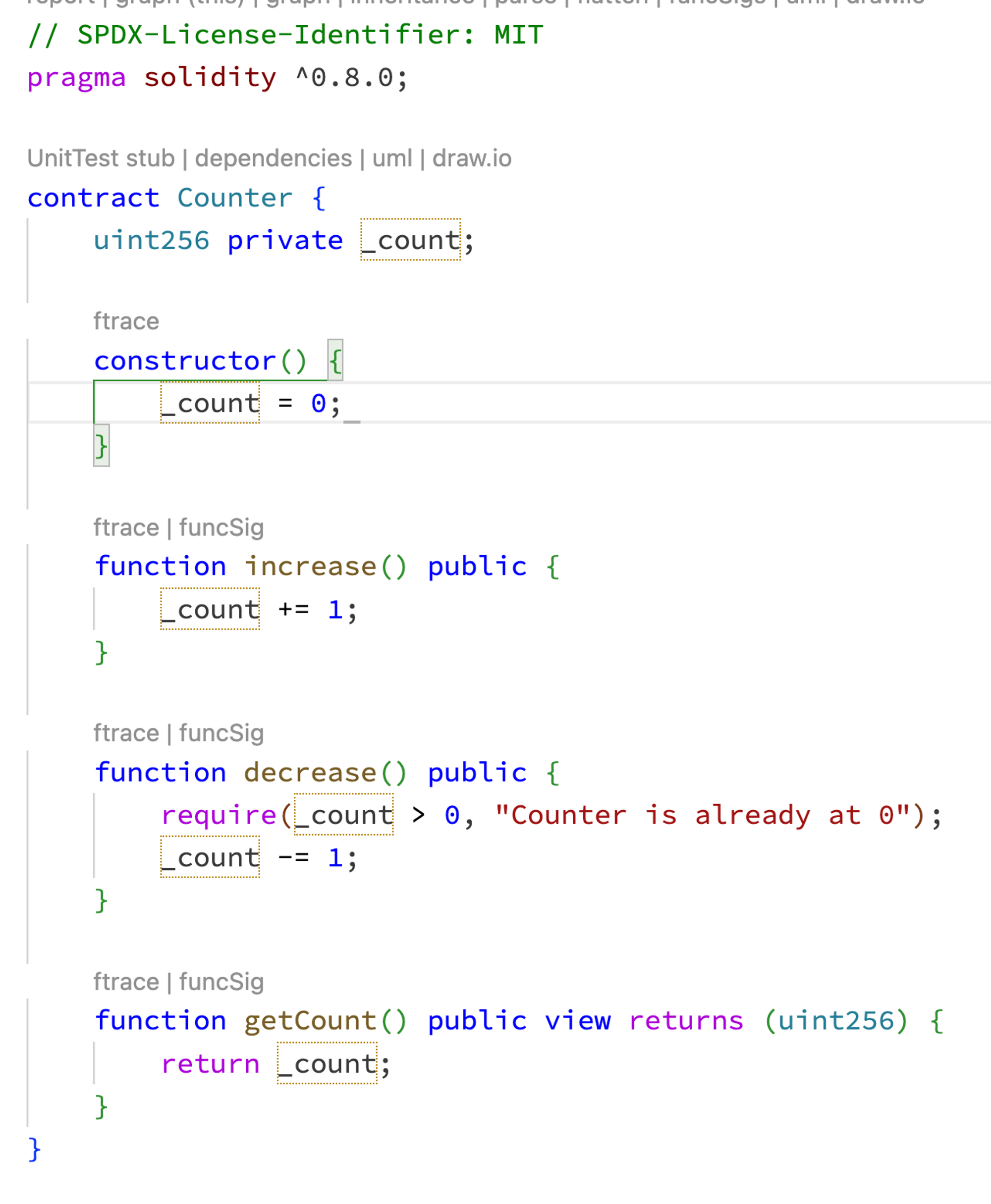

С помощью таких подсказок мы можем создать встречный смарт-контракт.

Смарт-контракт может пройти компиляцию и работает как положено.

Поскольку GPT-engineer изначально разработан для Python, при создании кода, связанного с защитными шлемами, возникают некоторые проблемы. GPT-инженер не знает последней версии Hardhat и иногда генерирует устаревшие тесты и сценарии развертывания.

Что делать, если в нашем коде есть ошибки? Мы можем передать базу кода и журнал ошибок консоли в LLM. LLM может продолжать изменять код до тех пор, пока он не будет успешно работать. Мы видели такие проекты, как flo, работающие в этом направлении. В настоящее время Flo поддерживает только JS.

Если мы хотим повысить точность генерации смарт-контрактов. Мы можем улучшить GPT-инженер, добавив несколько новых подсказок. Мы можем использовать разработку через тестирование и попросить LLM убедиться, что программа прошла определенные тесты, где мы можем лучше ограничить создаваемые программы.

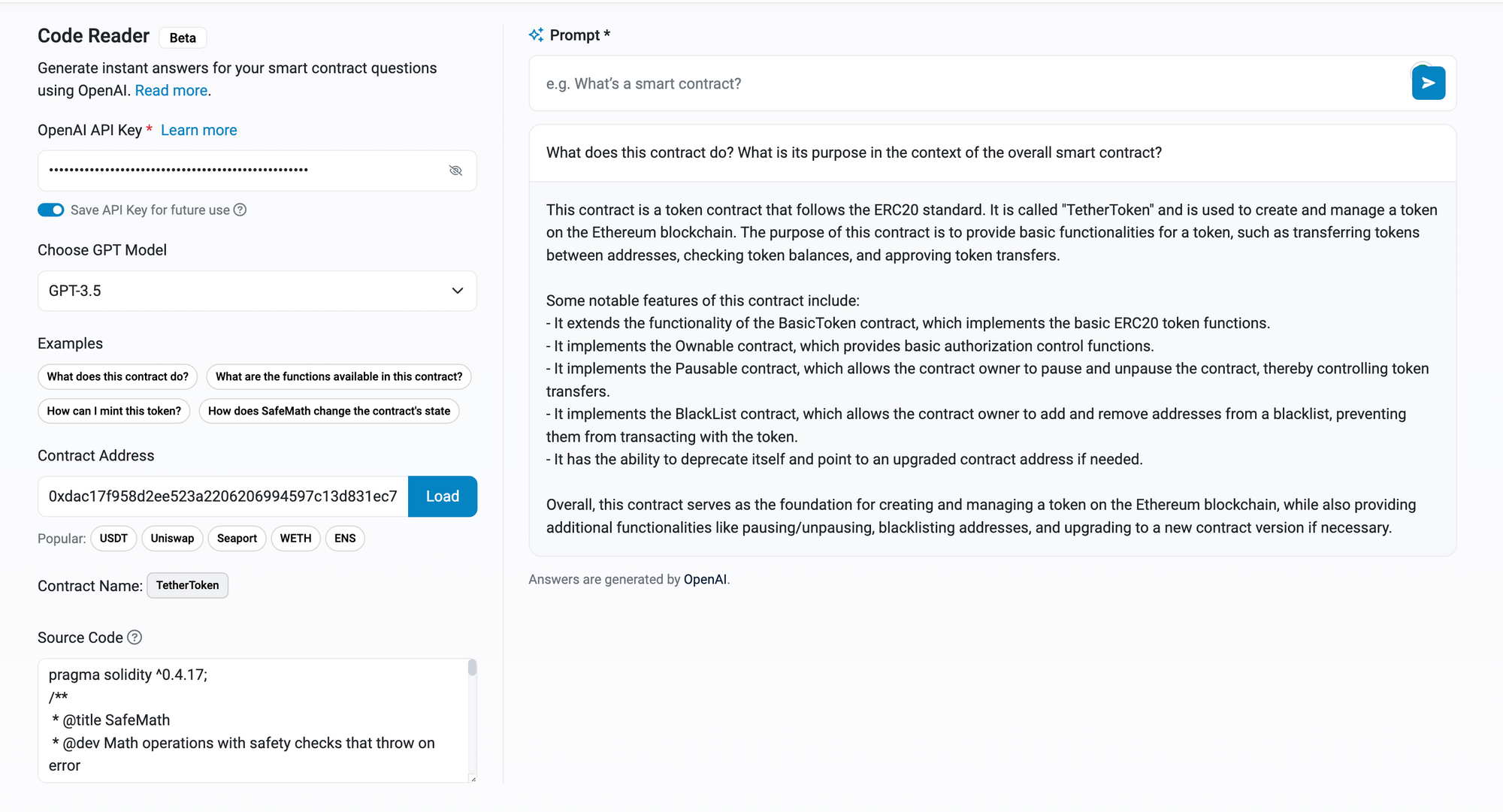

Используйте LLM для чтения кода

Поскольку LLM хорошо понимает код, мы можем использовать LLM для написания документации для разработчиков. LLM также может отслеживать изменение кода для обновления документов. Мы обсуждали этот подход в конце нашего последнего исследования Изучение опыта разработчиков на ZKRU: Углубленный анализ.

Чтение документов — это устаревшее поведение. Общение с кодом — это новый подход. Пользователи могут задавать любые вопросы о коде, а LLM ответит на вопросы пользователей. LLM может интерпретировать код для разработчиков, чтобы помочь им быстро понять смарт-контракты в цепочке. LLM также может помочь людям, не имеющим опыта программирования, разобраться в смарт-контрактах.

Мы уже видим эту тенденцию в мире Web2. Многие инструменты второго пилота имеют такую интерпретацию кода функции.

Etherescan также представляет свою новую функцию, позволяющую пользователям общаться с кодом, используя возможности LLM.

Принимая во внимание способность понимать код, как насчет аудита? В экспериментах, проведенных в статье, нужен ли вам все еще ручной интеллектуальный аудит контракта, LLM достигает 40 % успеха при выявлении уязвимостей, что превосходит случайный базовый показатель. Однако они также имеют высокий уровень ложноположительных результатов. Автор полагает, что ключевым моментом является правильная подсказка.

Помимо подсказок, ограничениями будут также следующие причины:

- Существующий LLM не обучен специально для этой цели. Данные обучения могут не включать кодовую базу смарт-контракта и соответствующие отчеты аудита.

- Обычно самые серьезные уязвимости — это логические проблемы, состоящие из различных функций. LLM в настоящее время ограничены количеством токенов. LLM не могут решать задачи с очень длинными контекстами и улучшать логические способности.

Эти проблемы не так уж сложно решить. Крупные аудиторские фирмы имеют тысячи аудиторских отчетов, которые можно использовать для точной настройки LLM. Выходит LLM с большими лимитами токенов. У Клода лимит токенов составляет 100 тысяч. Недавно выпущенный LTM-1 имеет сумасшедшие ограничения на токены в 5 миллионов. Объединив усилия по решению этих двух проблем, мы, вероятно, увидим, что LLM сможет лучше выявлять ошибки. LLM может помочь аудиторам и ускорить процесс аудита. Это может происходить шаг за шагом. Возможное направление развития:

- Помогает аудиторам систематизировать языки и форматировать отчеты. Это обеспечивает согласованность языков в рамках одной и той же аудиторской фирмы. Обычно разные группы могут иметь разные предпочтительные слова.

- Помогайте аудиторам выявлять и проверять потенциальные ошибки.

- Автоматически создавать проекты отчетов по аудиту.

- Используйте интеграцию ChatGPT, чтобы отвечать на вопросы участников сообщества.

- Получайте ценную информацию о сообществе на основе его сообщений, например, анализ часто задаваемых вопросов.

- Узнайте, какие сообщения важны, например неотвеченные вопросы

- Интеграция встроенных функций AI/LLM в блокчейн

- Использование LLM для анализа записей транзакций

- Использование LLM для повышения безопасности

- Использование LLM для написания кода

- Использование LLM для чтения кода

- Привлечение LLM к помощи сообществу

- Внедрение LLM для отслеживания рынка

- Применение LLM для анализа проектов

Используйте LLM, чтобы помочь сообществу

Управление является важной частью сообщества. Члены сообщества имеют право голосовать за понравившиеся предложения. Эти предложения определят будущее продуктов.

Что касается важных предложений, вокруг этих предложений ведется много справочной информации и дискуссий в сообществе. Всем членам сообщества сложно понять этот контекст перед голосованием. LLM может помочь членам сообщества быстро понять влияние их выбора и помочь им проголосовать.

Еще одно потенциальное применение — боты вопросов и ответов. Мы уже видим ботов вопросов и ответов на основе проектных документов. Мы можем сделать еще один шаг вперед и создать более крупную базу данных знаний. Мы можем подключать различные медиа и источники, такие как презентации, подкасты, Github, чаты Discord и Twitter Space. Боты вопросов и ответов будут доступны не только в строке поиска документов, но также могут появляться в Discord для немедленной поддержки членов сообщества или в Твиттере, чтобы распространять видение проектов и отвечать на любые вопросы.

AwesomeQA сейчас работает в этом направлении. Он реализует три функции:

В настоящее время проблема для ботов вопросов и ответов заключается в том, как точно взять соответствующий контекст из базы данных векторов и передать его в LLM. Например, если пользователи запрашивают несколько характеристик для нескольких элементов с помощью фильтров, боты не смогут получить соответствующие контексты из базы данных векторов.

Обновление базы данных векторов является еще одной проблемой. Текущие решения заключаются в перестроении базы данных векторов или обновлении базы данных векторов по пространству имен. Добавление пространства имен к внедрениям аналогично прикреплению тегов к данным. Это может помочь разработчикам позже легко находить и обновлять соответствующие внедрения.

Используйте LLM для отслеживания рынка

Каждый день происходит множество событий. Рынки сильно меняются. KOL публикует в Твиттере новые идеи и новые мысли. Информационные бюллетени и электронные письма о продуктах попадают в ваш почтовый ящик. LLM может выбрать для вас самые важные идеи и новости. Он также может суммировать контент, чтобы сократить время чтения и помочь вам догнать рынок.

minmax.ai работает над новостями. Они предоставляют сводку последних новостей по определенной теме, а также мнения по этой теме.

Скучные репортажи удаляют из новостей сенсацию, акцентируют внимание на существенных деталях и помогают читателям принимать правильные решения.

Консультирование роботов — одна из самых популярных областей. LLM может стимулировать использование роботов-консультантов. LLM может предоставлять торговые предложения и помогать пользователям управлять своими портфелями, учитывая информацию об акциях в качестве контекста.

Такие проекты, как Numer.ai, используют ИИ для прогнозирования рынка и управления фондом. Есть также портфели, которыми управляет LLM. Пользователи могут следить за этими портфолио на Robinhood.

Composer объединяет торговые алгоритмы с искусственным интеллектом. ИИ строит конкретные торговые стратегии на основе мнений пользователей. Затем ИИ автоматически протестирует эти торговые стратегии. Если пользователи удовлетворены стратегией, композитор может автоматически реализовать стратегию для пользователей.

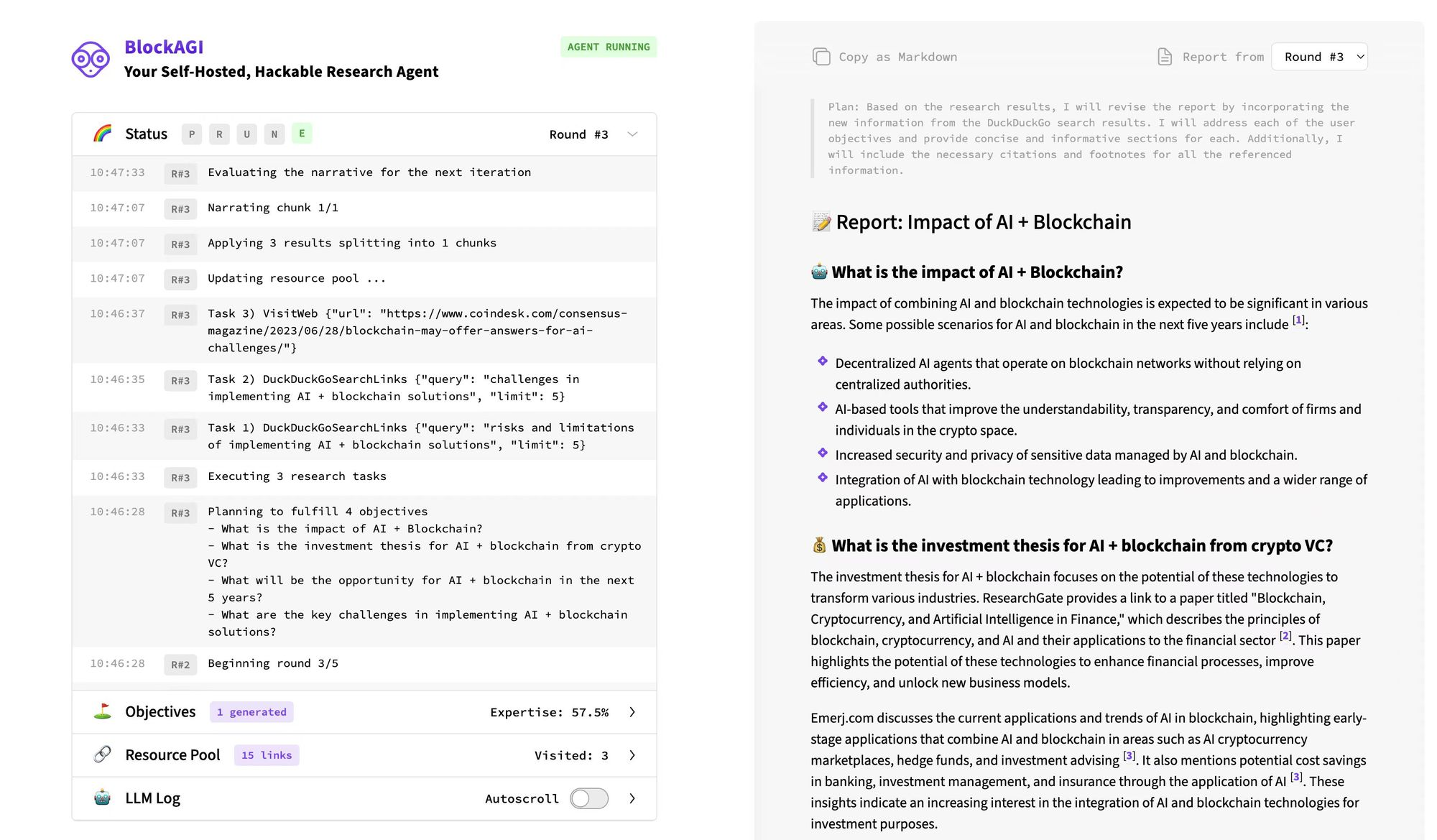

Используйте LLM для анализа проектов

Анализ проектов предполагает чтение большого количества материалов и написание длинных исследовательских статей. LLM умеет читать и писать короткие абзацы. Если мы сможем расширить его возможности на более длинные абзацы, означает ли это, что LLM каким-то образом сможет проводить некоторые исследования проекта? Вероятно, да. Мы можем предоставить LLM технический документ, документ или презентацию мероприятия для анализа проекта и основателя. Ограниченные токеном, мы можем сначала написать план документа. Затем обновите каждый раздел на основе полученных источников.

Такие проекты, как BabyAGI, уже работают в этом направлении. Вот пример вывода BlockAGI, который является вариантом BabyAGI.

LLM также может анализировать личности основателей на основе Твиттера и публичных выступлений. В качестве примера анализатор твитов берет последние твиты и использует LLM для анализа персонала.

Заключение

Это 8 конкретных направлений, в которых LLM может помочь блокчейн-сообществу в ближайшем будущем.

LLM может принести пользу всем участникам криптопространства, включая владельцев проектов, аналитиков и инженеров. Учредители могут использовать LLM для автоматизации таких задач, как документация и вопросы и ответы. Инженеры могут использовать LLM для более быстрого и безопасного написания кода. Аналитикам будет проще исследовать проекты.

В долгосрочной перспективе мы также находим потенциальные возможности применения LLM в GameFi. LLM может генерировать более интересные задачи и играть разные роли в играх. Мир в игре станет более реальным и интересным. NPC будет динамически реагировать на действия игроков. Задачи будут иметь больше концовок в зависимости от того, как их решают пользователи.

LLM можно интегрировать в существующие проекты, но он также открывает возможности для новичков. Например, уже есть ведущие игроки в секторах онлайн-аналитики данных. Dune может интегрировать LLM для улучшения пользовательского опыта. Однако LLM также создает возможности для новичков. Эти новички могут поставить LLM на центральное место в дизайне своего продукта. Эти интеллектуальные продукты, ориентированные на искусственный интеллект, могут создать новую конкуренцию в секторах онлайн-аналитики данных.

Миры Web2 и Web3 действительно имеют некоторые общие сценарии использования в приложениях LLM, но они могут реализовывать продукты по-разному. Потому что данные, которые мы использовали в мире Web3, отличаются от данных в мире Web2. База знаний для LLM также может отличаться в Web2 и Web3. Данные Web3 связаны с блокчейном, ценой токенов, твитами, проектами и исследованиями. Таким образом, для предоставления услуг конечным пользователям требуется, чтобы Web2 и Web3 имели разные LLM.

В связи с бумом LLM мы видим растущую популярность AIxBlockchain. Однако использование большого количества AIxBlockhain за короткий период времени нецелесообразно. Блокчейны и ZK не могут обеспечить большую вычислительную мощность для обучения и вывода некоторых сложных моделей. Маленькие модели недостаточно мощны для решения сложных задач. Более практичный подход — применение LLM в пространстве блокчейна. LLM в последнее время добился большего прогресса, чем другие темы искусственного интеллекта. Разумнее практиковать LLM и блокчейн.

Сообщество LLM работает над улучшением лимитов токенов и повышением точности ответов. Что остается сообществу блокчейнов, так это источники данных и конвейеры данных. Очищенные данные можно использовать для точной настройки LLM для повышения точности в контексте блокчейна. Конвейер данных может интегрировать больше приложений, связанных с блокчейном, в LLM и разработать больше криптоспецифичных агентов.

Особая благодарность IOSG

Оригинал