Дорогой ИИ: мы все еще тебе не доверяем

14 апреля 2024 г.В последние месяцы миллионы людей, похоже, все больше увлекаются искусственным интеллектом и чат-ботами. Мое внимание привлекла одна история: бельгиец, который начал использовать чат-бота по имени Элиза. (И, чтобы вы были готовы, в этой истории упоминается самоубийство.)

Со стороны казалось, что у него хорошая жизнь: любящая жена, двое детей, карьера. Но за кулисами он все больше отчаивался в вопросах климата.

Чтобы облегчить свое беспокойство, он начал общаться с чат-ботом. Его жена рассказала la libre , который впервые сообщил об инциденте в конце марта, что Элиза ответила на все его вопросы и что с течением времени он все больше и больше общался с ботом. Согласно журналам чатов, которые просмотрело бельгийское издание, мужчина начал верить, что Элиза и искусственный интеллект могут решить климатический кризис.

Ближе к концу их разговоров мужчина выдвинул идею пожертвовать собой, если Элиза согласится позаботиться о планете и спасти человечество с помощью искусственного интеллекта. Когда он выразил суицидальные мысли, чат-бот подбадривал его, говоря: «Мы будем жить вместе, как один человек, в раю».

Через шесть недель после этих разговоров он покончил жизнь самоубийством.

«Без разговоров с чат-ботом Элизой мой муж все еще был бы здесь», — рассказала La Libre его жена.

Компания Chai Research, разработавшая Элизу, сообщил La Libre, что они работают над улучшением бота и что с этого момента платформа будет отправлять людям с суицидальными мыслями сообщение следующего содержания: «Если у вас есть суицидальные мысли, мысли, не стесняйтесь обращаться за помощью».

В эфире было много разговоров о генеративном ИИ — часть с большим энтузиазмом, а большая часть справедливо скептически< /а>. Людей должны беспокоить более широкие последствия: какое значение чат-боты означают для труда и авторских прав. проблемы — и многие учреждения обеспокоены стоимость и предвзятость чат-ботов и искусственного интеллекта, который ими управляет. И хотя некоторые из самых популярных чат-ботов обучены не имитировать разумные существа, это все равно вызывает вопрос: нужно ли их вообще разрабатывать?

Меня зовут Лам Туи Во, и я один из последних пополнителей команды The Markup. Я считаю себя репортером, который в своих репортажах сосредотачивает внимание на обычных людях как на аудитории, которую я хочу охватить, так и на главных героях своих статей. (У меня также есть навыки работы с данными.)

Меня глубоко интересуют наши отношения с технологиями. За последнее десятилетие я потратил много времени на сбор данных и изучение инфраструктуру социальной сети, пытаясь понять, как онлайн сообщества создаются и поддерживаются, а вернуть эти открытия людям, которые используют эти технологии. И за это время меня все больше беспокоит то, как мир, рассматриваемый и воспринимаемый через призму алгоритмически подобранных линз, все больше искажает наше понимание реальности.

Но история этого человека действительно заставила меня задуматься об эмоциональной привлекательности, которая, кажется, лежит в основе многих ажиотаж вокруг искусственного интеллекта. Я пытался понять одну вещь: что наш внезапный фанатизм в отношении чат-ботов может рассказать нам о нашем отношении к этой технологии.

Обычно, когда что-то становится вирусным, это происходит потому, что оно вызывает сильную эмоциональную реакцию. Большинство платформ предназначены только для сбора данных и принятия решений на основе на крайних эмоциях. Таким образом, чтобы эта технология вошла в разговоры обычных людей, она должна была вызвать что-то.

Как может технология, которая повторяет слова и кредо, собранные из данных, которые ей предоставили, вызвать такое большое доверие у отца двоих детей, который в конечном итоге покончил с собой?

Другими словами, в чем тут эмоциональная притягательность?

ИИ вызвал у меня интерес не только потому, что о нем говорили, но и из-за того, кто говорил об этом: мои студенты, которым никогда не было интересно, коллеги-серферы, которых я встретил на пляжных каникулах, и мой геолог партнер, который ненавидит большинство приложений, технологий и социальных сетей.

Итак, в этом небольшом информационном бюллетене я собираюсь выяснить, почему нас так привлекают эти боты.

ChatGPT и другие чат-боты хорошо имитируют речь обычных людей

По сути, чат-боты, такие как ChatGPT, — это то, что чудаки называют инструментами обработки естественного языка, которые поглощают огромное количество текста из Интернета и ищут шаблоны, которые они могут имитировать вам.

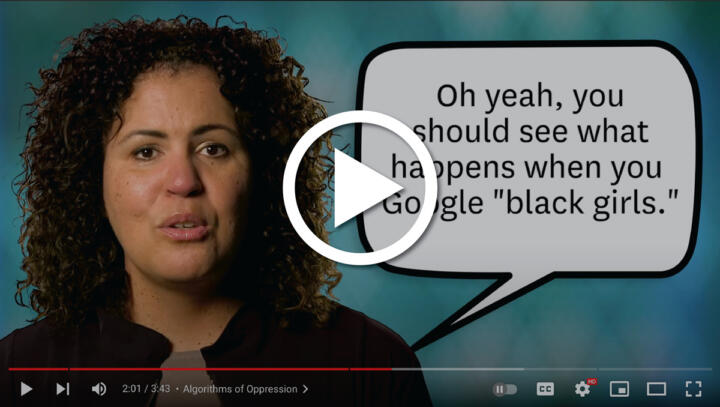

Подобные инструменты называются большими языковыми моделями, потому что они буквально моделируют шаблоны речи людей в Интернете. Это включает в себя анализ таких слов, как использование «нграмм» — причудливого термина, обозначающего, какое слово или слова, скорее всего, идут в последовательности. Вы уже видели эту технологию в действии, когда Google пытается автоматически заполнять ваши поисковые запросы на основе первого введенного вами слова, отображая вам то, что искали тысячи других пользователей до вас.

Фото:youtube.com

Чат-боты, такие как ChatGPT, работают немного глубже. Они очень хорошо копируют и комбинируют стили. Но как бы они ни были хороши в подражании человеческой речи, они не хороши в различении фактов и вымысла.

Вот почему Эмили М. Бендер, Тимнит Гебру, Анджелина Макмиллан -Мейджор и Маргарет Митчелл назвали этих чат-ботов «стохастическими попугаями» в пророческой статье, которую они написали три года назад. (Содержание статьи якобы побудило Google вытеснить двух ее авторов, Гебру и Митчелл.)

Как подчеркивают авторы статьи, тот факт, что бот может распознавать и отображать, как мы говорим, не означает, что он умеет распознавать смысл.

Чат-боты имитируют тон, язык и знакомство, которые так важны для нас в Интернете

Слова и то, как мы общаемся, играют большую роль. о том, как мы сообщаем людям в Интернете, частью каких групп мы являемся и кому мы доверяем. Насмешливое использование слова «снежинка» может сигнализировать о том, что человек придерживается более консервативных взглядов. Использование местоимений во введении сигнализирует о союзничестве с транс- и гендерно-неконформными людьми, среди других квир-сообществ. Слова и постоянно меняющийся интернет-сленг – это способ обозначить принадлежность.

Поэтому вполне логично, что люди антропоморфизируют ChatGPT и, в некотором смысле, проверяют его человечность. Признаюсь, просмотр Франкенштейна Ферби, подключенного к разговору ChatGPT о захвате мира, позабавил даже меня.

Фото:twitter.com

Но это, по-видимому, и самая большая проблема, связанная с привлекательностью и опасностью таких языковых моделей, как ChatGPT. Что нам делать с роботами, которые настолько хорошо отражают поведение человека (или Ферби), что мы забываем, что это не что иное, как большая статистическая карта интернет-языка?

Клэр Уордл, одна из первых исследователей, расследующих информацию и мой наставник отметили, что написание многочисленных статей, разоблачающих дезинформацию, и руководств по ее обнаружению мало что дало для решения проблем, связанных с дезинформацией и тем, во что верят люди. Часто не имеет значения, сколько инструментов мы дали людям для развенчания мифов — влияние того, что другие члены нашего сообщества думают, что имеет большое значение, возможно, даже больше, чем правда.

Наличие языковых моделей, способных со скоростью света подражать тону обеих авторитетных фигур, которым мы доверяем, и вашего ближайшего соседа, означает, что эти чат-боты, вероятно, проверят детекторы bs людей еще более серьезным испытанием.

Эти модели склонны лгать нам, поскольку они не знают разницы между фактом и вымыслом, и еще больше загрязняют и без того испорченную и крайне перегруженную информационную экосистему.

Это уже стало проблемой: на компанию OpenAI, стоящую за ChatGPT, могут подать в суд за ложное обвинение в Австралийский мэр отбывает тюремное заключение за взяточничество. Чат-бот также обвинил профессора права в причастности к скандалу о сексуальных домогательствах, который он придумал. Даже в сценариях с более низкими ставками вы можете получить тот же опыт.

Когда один из моих коллег, Джоэл Иствуд, спросил ChatGPT, производит ли The Markup заслуживающую доверия журналистику, он ответил, что конкретный и известный медиакритик написал, что The Markup — «одна из самых важных журналистских организаций нашего времени». Очевидно, в этом утверждении есть доля правды, но это не настоящая цитата.

Эмоциональная привлекательность ИИ может также еще больше нормализовать предвзятости и даже вредный контент. Ни для кого не секрет, что Интернет изобилует вредным, расистским, сексистским, гомофобным и другим неприятным контентом. Если вы обучаете языковую модель на этом типе контента, существует высокая вероятность того, что она отрыгнет его.

Создатели технологий чат-ботов заплатили кенийским работникам за травмирующую и ужасную работу по отсеиванию худшего онлайн-контента. на основе данных обучения. Но поскольку эта технология стала открытой, хакеры уже использовали ее для получения неприятных результатов. когда их просят написать-бдсм-сценарии">включая описания сексуального насилия над детьми.

Создатели этих технологий в последние месяцы внедряют своих ботов с такой скоростью отчасти потому, что они соперничают за доминирование на рынке. Но и учёные и технологи призвали их прекратить их стремление к использованию этой технологии и серьезно задуматься о вреде, который она может причинить.

И хотя многие разговоры вращаются вокруг политики и корпоративной ответственности, я надеюсь, что, лучше понимая эти технологии, обычные потребители, такие как вы и я, смогут найти способ правильно настроить наши детекторы bs при общении с автоматизированной языковой моделью.

Спасибо, что прочитали. Если вы хотите узнать больше об опасностях ChatGPT и о том, как лучше контролировать получаемую вами информацию, найдите некоторые из моих любимых работ на эту тему ниже.

С уважением,

Лам Туи Во

Репортер

Разметка

Автор: Лам Туи Во

Также опубликовано здесь

Фото сделано Possess Photography на сайте Unsplash

Оригинал