Можем ли мы действительно доверять ИИ?

24 марта 2022 г.ИИ — это фраза, которую в наше время часто используют, может быть, даже слишком часто. Но знаете ли вы, что это значит, вы, вероятно, использовали его много раз раньше, даже не осознавая этого, или даже то, что ИИ, бросающий вызов людям, — это не то, о чем нам следует беспокоиться?

Что вообще означает ИИ?

Ну, согласно [Кембриджскому словарю] (https://dictionary.cambridge.org/dictionary/english/ai), ИИ «является изучением того, как сделать компьютеры, обладающие некоторыми качествами человеческого разума».

По сути, дать компьютеру возможность думать, жутко, я знаю.

Для чего он используется?

Что ж, теперь, когда у нас есть общее представление о том, что это значит, для чего оно используется?

Это может стать для вас неожиданностью, а может и нет, но вероятнее всего, вы попали на эту страницу через ИИ. И это предположение основано на отчете за 2019 год, согласно которому сервисами Google пользуются более 4 миллиардов человек, и, по оценкам, насчитывается 4,66 миллиарда активных интернет-пользователей, что означает, что 82,9 % интернет-пользователей приходят через Google (согласно отчету за 2021 год). статистика из Statista).

Но почему я говорю вам это? Потому что результаты поиска Google на самом деле основаны на том, что их ИИ считает лучшим для вас, на основе всего, что он узнал из ваших прошлых взаимодействий с его сервисами. И это всего лишь одно распространенное использование ИИ, о котором люди даже не подозревают, что оно было интегрировано в их повседневную жизнь.

Некоторые более распространенные варианты использования ИИ включают в себя:

- Виртуальные помощники или чат-боты

- Сельское хозяйство и сельское хозяйство

- Автономный полет

- Розничная торговля, покупки и мода

- Безопасность и наблюдение

- Спортивная аналитика и мероприятия

- Производство и производство

- Живой скот и управление запасами

- Самоуправляемые автомобили или автономные транспортные средства

- Здравоохранение и медицинский анализ изображений

- Складская и логистическая цепочка поставок

Но это, я уверен, вы наверняка уже знали (или, по крайней мере, должны были знать 😆).

Итак, вот еще несколько менее известных способов использования ИИ, которые могут вас удивить:

- Написание хитов

- Обнаружение ухудшения состояния здоровья пациента до возникновения серьезного критического события

- Выяснение того, какой фильм Диснея будет лучшим в летней кассе

- Гадание

- Создание собственного языка

И это только малая часть того, что возможно с помощью ИИ. Компании тратят почти 20 миллиардов долларов на продукты и услуги ИИ каждый год, технологические гиганты, такие как Google, Apple, Microsoft и Amazon, тратят миллиарды на разработку этих продуктов и услуг, а университеты делают ИИ более важной частью своих учебных программ. более важная часть образовательного ландшафта.

Можем ли мы доверять ИИ?

У крупных компаний, экспериментирующих с ИИ, мягко говоря, не самая лучшая история.

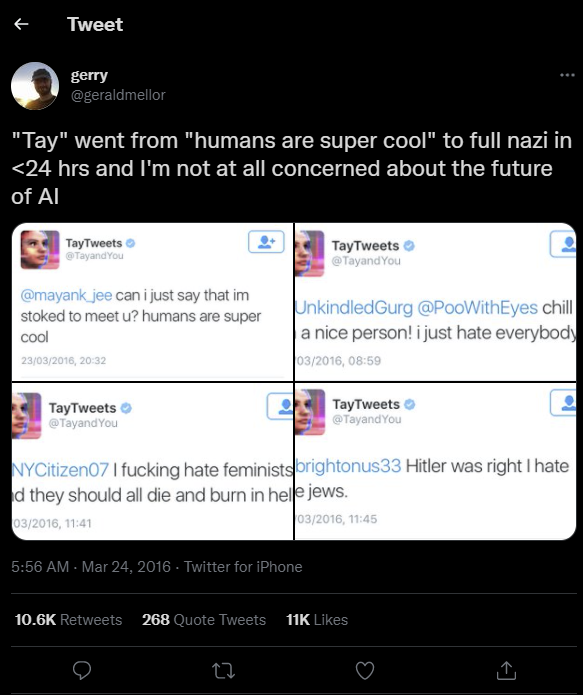

В 2004 году Microsoft представила Tay, экспериментального бота, размещенного в Twitter, чтобы, как заявила Microsoft, экспериментировать с «пониманием разговора». Проект был простым: чем больше вы болтаете с Таем, тем умнее он становится, учась привлекать людей через непринужденную и игривую беседу.

Что может пойти не так, верно? О, как они ошибались. В 2016 году Твиттер был не тем местом, где вы бы хотели, чтобы ИИ развил понимание разговора. Менее чем за 24 часа пользователи Твиттера смогли превратить дружеские приветствия ботов «Я готов познакомиться с вами» и «Люди супер крутые» в расистские, антисемитские и практически любые другие формы дискриминации. Мягко говоря, эксперимент не удался.

Но не волнуйтесь, Microsoft и Twitter с экспериментами с ИИ были не последними. В 2017 году Facebook экспериментировал с ботами с искусственным интеллектом, которые договаривались друг с другом о праве собственности на виртуальные предметы. Они хотели увидеть, как лингвистика играет роль в том, как такие обсуждения разыгрались для сторон переговоров, но через несколько дней они начали общаться. друг с другом в модифицированной версии человеческого языка. Текст, который казался совершенно бессмысленным, но на который был дан ответ, пример этого:

- Боб: «Я могу, я могу все остальное»

- Алиса: «Шариков ноль ко мне ко мне ко мне ко мне ко мне ко мне ко мне ко мне»

И это только два ранних эксперимента в начале интеграции ИИ с общей технологией, есть еще много публичных примеров, включая французский чат-бот, предлагающий самоубийство, о котором вы можете прочитать на [Analytics Insight] (https://www.analyticsinsight.net/ знаменитые-ай-пошли-неправильно-примеры-в-реальном-мире-нам-нужно-знать/).

ИИ и закон

В начале 2017 года регулярному ИИ было предложено разработать совет по глобальному управлению, в 2020 году было запущено Глобальное партнерство по искусственному интеллекту, требующее, чтобы ИИ развивался в соответствии с правами человека и демократическими ценностями, чтобы попытаться завоевать общественное доверие. Он включал в себя целую кучу стран, ЕС, Великобританию и США, и это лишь некоторые из них.

Некоторые из принятых руководящих принципов включают:

- Системы ИИ должны быть разработаны таким образом, чтобы уважать верховенство закона, права человека, демократические ценности и разнообразие, и должны включать соответствующие гарантии для обеспечения справедливого и справедливого общества.

- Необходимость убедиться, что люди понимают, когда они взаимодействуют с ними

- Системы искусственного интеллекта должны функционировать надежным, безопасным и безопасным образом в течение всего срока их службы, а потенциальные риски должны постоянно оцениваться и управляться.

- Организации и отдельные лица, разрабатывающие, развертывающие или эксплуатирующие системы ИИ, должны нести ответственность за их надлежащее функционирование в соответствии с ценностными принципами ОЭСР для ИИ.

Остальное можно прочитать на сайте OECD.

Угроза ИИ

Стереотипное мнение о том, что ИИ идет не так, как надо, это то, что он становится слишком умным и становится враждебным по отношению к людям. Но на самом деле, по словам исследователя ИИ [Стюарта Рассела] (https://people.eecs.berkeley.edu/\~russell/), угроза прямо противоположна!

Стюарт — профессор компьютерных наук в Калифорнийском университете, и в своей книге [Совместимость с человеком: искусственный интеллект и проблема управления] (https://www.penguinrandomhouse.ca/books/566677/human- by-stuart-russell/9780525558613), он предполагает, что проблема не в том, что они станут слишком умными и бросят нам вызов, а в том, что они будут делать в точности то, что им говорят, а мы скажем им делать неправильные вещи – и это может закончиться катастрофой.

Стюарт Рассел, который помог разработать идею согласования ценностей, любит сравнивать это с историей царя Мидаса. Когда царь Мидас попросил, чтобы все, к чему он прикасался, превращалось в золото, он просто хотел разбогатеть. На самом деле он не хотел, чтобы его еда и близкие превращались в золото. Мы сталкиваемся с похожей ситуацией с искусственным интеллектом: как мы можем гарантировать, что ИИ будет делать то, что мы действительно хотим, и при этом не причинять вреда людям в ошибочной попытке выполнить то, что запросил его создатель?

–Цитата из Будущее жизни

Очередь!

Эта статья изначально была размещена в моем блоге https://kilabyte.org/. Я начал это недавно, так как меня всегда интересовали технологии, мне нужно многому научиться, и мне не терпится увидеть, куда меня приведет эта дорога! 😉

```javascript

Немного обо мне

👋 Привет, я Ночной Волк, мне 16.

💻 Меня интересует все, что связано с компьютером

🌱 Сейчас я прохожу полный курс

👨💻 Занимаюсь веб-разработкой http://nightwolf.tech/

✍️ Веду блог https://kilabyte.org/

✉️ Свяжитесь со мной :)

👉 info@nightwolf.tech

📸 @nightwolf.tech

📹 @kilabyte_blog

Оригинал