Где происходит контекстный перевод в больших языковых моделях: эффективность вывода

2 сентября 2024 г.Авторы:

(1) Сюзанна Сиа, Университет Джонса Хопкинса;

(2) Дэвид Мюллер;

(3) Кевин Да.

Таблица ссылок

- Аннотация и 1. Фон

- 2. Данные и настройки

- 3. Где происходит контекстный машинный перевод?

- 4. Характеристика избыточности в слоях

- 5. Эффективность вывода

- 6. Дальнейший анализ

- 7. Заключение, благодарности и ссылки

- А. Приложение

5. Эффективность вывода

Ускорение вывода трансформатора представляет большой интерес для сообщества (Fournier et al., 2023). Мы подчеркиваем потенциал ускорения времени вывода как прямое следствие определения того, где в модели происходит распознавание задачи, и избыточности обработки собственного внимания. Наши результаты показывают, что мы можем достичь значительного ускорения вывода, полностью удалив обработку маркеров контекста после определенной точки в модели, с небольшим или нулевым влиянием на производительность ниже по потоку.

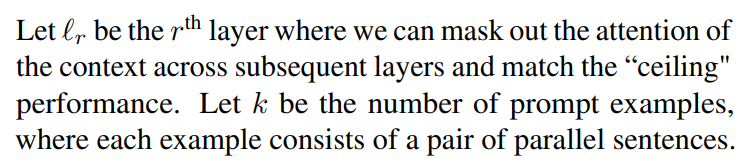

Тогда для модели с nℓ слоями объем обработки с точки зрения скорости и сэкономленной памяти составит приблизительно (nℓ − r)/nℓ × (k/k + 1).

Используя пример LLAMA7B (32 слоя), мы видим на рисунке 2, что модель очень близка к своему предельному значению после обработки примеров на уровне 14 (ℓ = 14). Если нам больше не нужно обрабатывать примеры после ℓ = 14,под быстрым размером5экономия составляет около 45%.

Для моделей с настроенными инструкциями, которые обычно развертываются в производстве, даже если предположить, что примеры не предоставляются, экономия может быть нетривиальной, поскольку модели обычно предоставляются очень длинные инструкции в попытке контролировать ее поведение (оперативное проектирование).

Эта статьядоступно на arxivпо лицензии CC BY 4.0 DEED.

Оригинал