The Trifecta: Университетская симфония Unipelt's Symphony of Bitfit, Adapter и Prefix

13 августа 2025 г.Таблица ссылок

Аннотация и 1. Введение

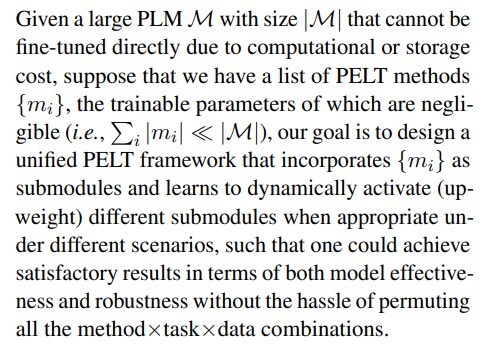

Предварительные

Объединение методов шкура

Эксперименты

4.1 Настройка эксперимента

4.2 Анализ отдельных методов шкура

4.3 Анализ Unipelt

4.4 Эффективность методов шкура

Связанная работа

Заключение, подтверждение и ссылки

2 предварительные

2.1 Методы PELT без дополнительных параметров

PLMS можно использовать в качестве экстракторов функций, где только верхние слои или головка прогнозирования тонко настраиваются без дополнительных параметров (Lee et al., 2019). Однако такие подходы с тонкой настройкой, как правило, приводят к вырожденной производительности модели, которая намного хуже, чем тонкая настройка всех параметров (Lee et al., 2019; Pfeiffer et al., 2021). Недавний метод BitFit (Ben Zaken et al., 2021) только настраивает условия смещения PLM и показано, что достигает производительности, сравнимой с тонкой настройкой по определенным задачам, когда учебные данные ограничены. Поэтому мы выбираем BitFit в качестве представителя этой категории для анализа.

2.2 Методы шкура с дополнительными параметрами

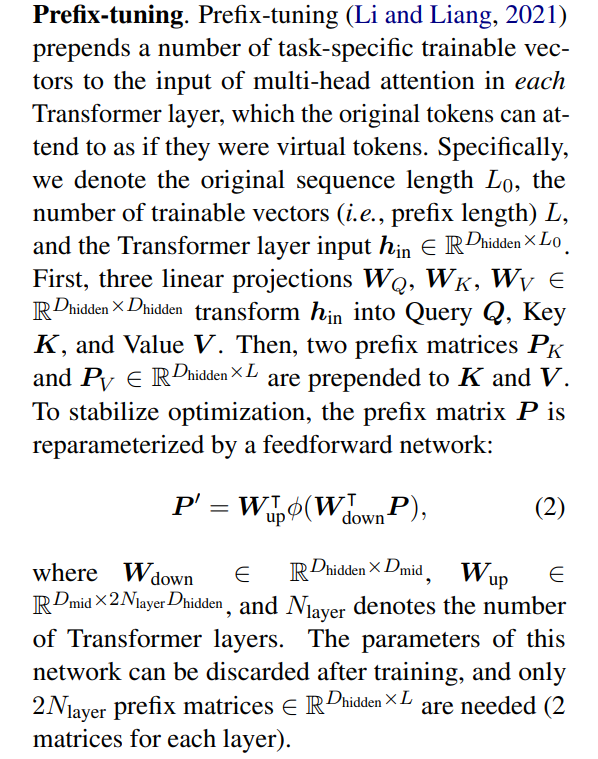

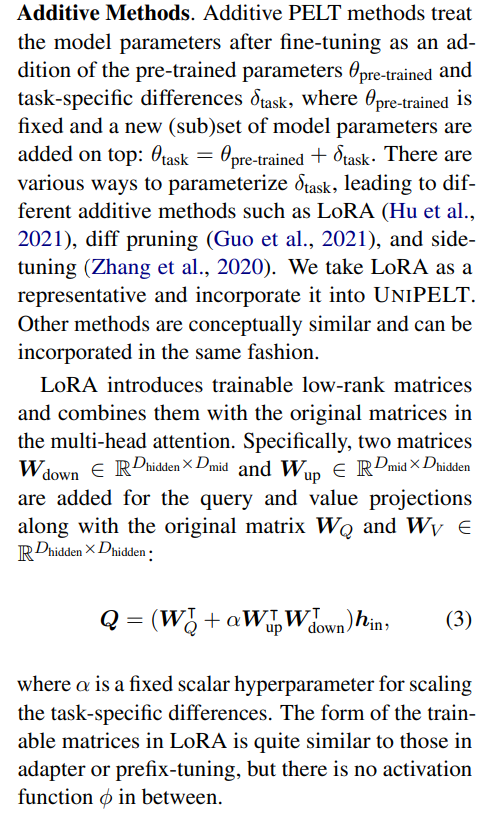

В качестве альтернативы можно исправить всю PLM и представить небольшое количество новых обучаемых параметров. Примечательные примеры в этой категории включают адаптер (Houlsby et al., 2019) и его расширения (Pfeiffer et al., 2021; Karimi Mahabadi et al., 2021b), префикс-настройка (Li and Liang, 2021) и его удлинители (Lester et al., 2021) и дополнительные методы (Guo et at. Et at. 2021).

Далее мы кратко опишем эти методы, чтобы облегчить внедрение нашей предложенной основы. Иллюстрация показана на рис. 1 для лучшего понимания.

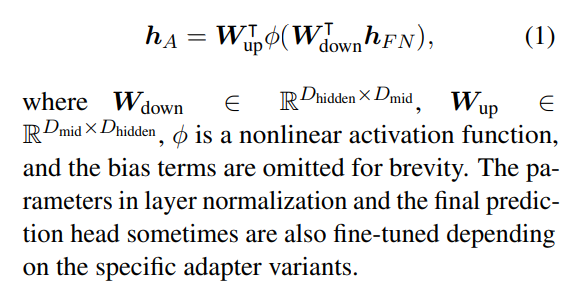

АдаптерПолем Адаптер (Houlsby et al., 2019) добавляет обучаемый слой узкого места после сети при питании в каждом уровне трансформатора PLM. Слоя узкого места состоит из проекционной пары Down+UP, которая сокращается и восстанавливает размер скрытых состояний токена. Математически, если мы обозначаем выходной сигнал сети при питании после остаточного соединения и нормализации слоя как HF n со спрятанным размером Dhidden и DMID размера узкого размера, то вывод узкого уровня HA: HA: HA:

Показано, что Dapter находится наравне с тонкой настройкой, а иногда демонстрирует лучшую эффективность в условиях с низким ресурсом (He et al., 2021). Более поздние исследования распространяют адаптер для многоязычных (Pfeiffer et al., 2020b) и многозадачных (Karimi Mahabadi et al., 2021b), или еще больше уменьшить его обучаемые параметры (Karimi Mahabadi et al.

Префикс-настройка первоначально оценивается на генерацию естественного языка, и мы адаптируем его к пониманию задач. Последующий метод с именем resckttuning (Lester et al., 2021) дополнительно снижает задачи, конкретные параметры, ограничивая префикс до первого уровня, но выполняет только конкурентоспособные с очень большими размерами моделей (миллиарды общих параметров) и, таким образом, не рассматривается в нашем исследовании. Обратите внимание, что префикс-настройка (или настройка быстрого настройки) отличается от методов точной настройки на основе быстрого настройки (Schick and Schütze, 2021; Gao et al., 2021) (см. Приложение A для конкретных различий).

3 объединения методов шкура

3.1 Составление задач

3.2 Предложенный метод

Мотивация и интуиция.Во время анализа отдельных методов шкура мы наблюдаем, что различные методы шкура демонстрируют различные характеристики и работают довольно по -разному по одной и той же задаче. Например, префикс-настройка, как правило, хорошо выполняет задачи вывода естественного языка независимо от размера данных обучения. Также, как видно на рис. 1 и сек. 2, различные методы шкура часто включают в себя различные части архитектуры PLM (например, перед многоугольником внимания для настройки префикса и после питательного слоя для адаптера), что делает возможным комбинировать множественные методы шкура без (непосредственно), мешая друг другу.

В свете двух вышеупомянутых наблюдений мы предлагаем унифицированную структуру шкура, Unipelt, которая использует гибридный подход, включив несколько методов PELT в качестве подмодулей. На высоком уровне Unipelt улучшается по сравнению с отдельными методами шкура из -за двух факторов. Во -первых, Unipelt учится активировать (увеличенный вес) подмодулы, которые наилучшим образом соответствуют текущей задаче или конкретной образе данных и деактивируют (понижен весом) остальные. Во -вторых, мы обнаруживаем, что Unipelt обычно работает лучше, чем приобретать наилучшие результаты всех его подмодулей, используемых индивидуально для каждой задачи, что позволяет предположить, что могут быть некоторые составные эффекты, которые приводят к лучшей эффективности модели, когда используются множественные методы шкура (которые изменяют различные части PLM).

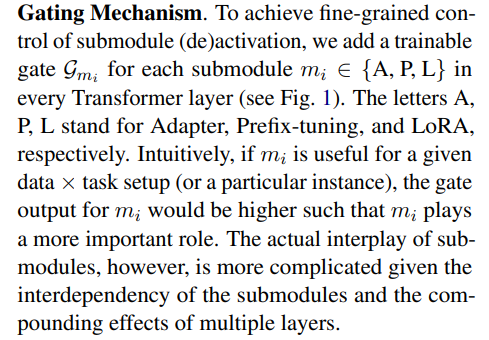

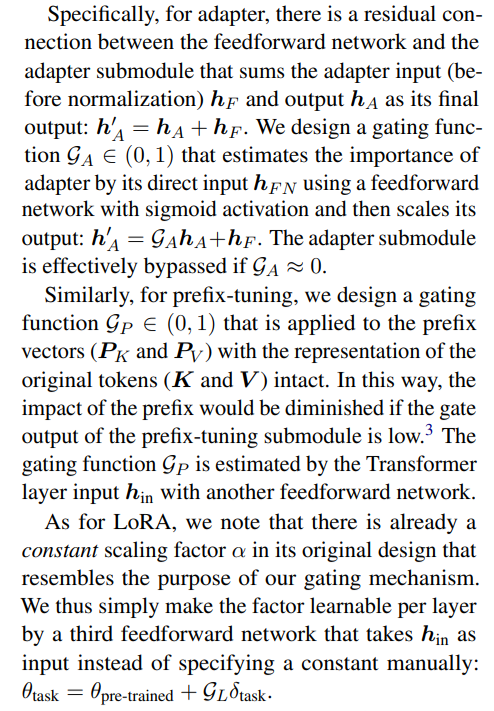

Далее мы представим, как различные методы PELT могут быть включены в Unipelt с помощью механизма стробирования.

Несмотря на кажущуюся простоту Unipelt, мы отмечаем, что это нетривиально для единого подхода хорошо работать в разных сценариях. Наносительное объединение различных методов шкура в качестве гибридного подхода может привести к смешанной или худшей производительности, чем использование отдельных методов, как это наблюдалось как в наших экспериментах, так и в предыдущих исследованиях (Hu et al., 2021).

Авторы:

(1) Юнинг Мао, Университет Иллинойса Урбана-Шампейн и работа была выполнена во время стажировки в Meta AI (yuningm2@illinois.edu);

(2) Ламберт Матиас, Meta AI (mathiasl@fb.com);

(3) Rui Hou, Meta AI (rayhou@fb.com);

(4) Amjad Almahairi, Meta AI (aalmah@fb.com);

(5) Хао Ма, Мета Ай (haom@fb.com);

(6) Цзявей Хан, Университет Иллинойса Урбана-Шампейн (hanj@illinois.edu);

(7) Wen-tau Yih, Meta AI (scottyih@fb.com);

(8) Мадиан Хабса, Meta AI (mkhabsa@fb.com).

Эта статья есть

[3] Настройка префикса не может быть полностью исключена в виде адаптера или LORA из-за работы SoftMax в многоуровневом внимании.

Оригинал