Предлагаемые два этапа обнаружения аномалий с нулевым разглашением и доказательством

3 января 2024 г.:::информация Этот документ доступен на arxiv под лицензией CC BY-NC-SA 4.0 DEED.

Авторы:

(1) Shanshan Han & Qifan Zhang, UCI;

(2) Вэньсюань Ву, Техасский университет A&M;

(3) Baturalp Buyukates, Yuhang Yao & Weizhao Jin, USC;

(4) Салман Авестимер, USC & ФедМЛ.

:::

Таблица ссылок

Предлагаемое двухэтапное обнаружение аномалий

Проверяемое обнаружение аномалий с использованием ZKP

3 ПРЕДЛАГАЕМОЕ ДВУХЭТАПНОЕ ОБНАРУЖЕНИЕ АНОМАЛИЙ

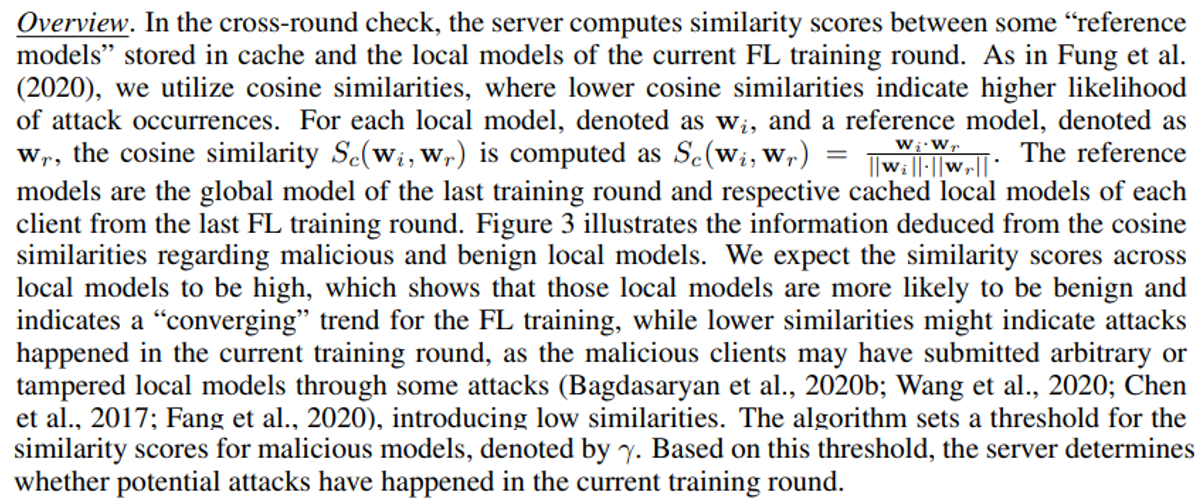

3.1 КРУГЛАЯ ПРОВЕРКА

Цель перекрестной проверки — определить, произошли ли атаки в текущей итерации FL. Ниже мы сначала даем общее представление об алгоритме, а затем объясняем его более подробно.

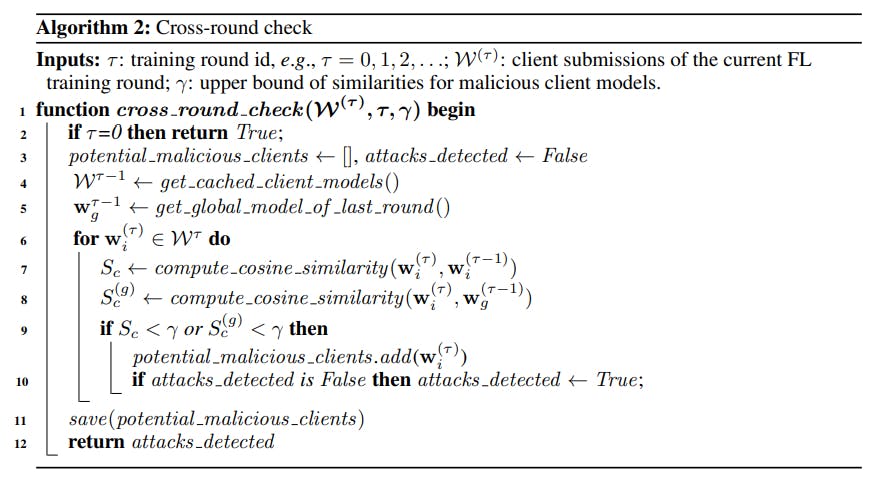

Алгоритм перекрестной проверки представлен в алгоритме 2, который состоит из следующих шагов.

Шаг 1. Инициализация. Сервер загружает эталонные модели, включая глобальную модель из последнего раунда обучения FL, а также кэшированные локальные модели, которые считаются «безопасными» из предыдущего раунда обучения FL. (Строки 4 и 5). Для первого раунда, в котором нет эталонной глобальной модели и кэшированных локальных моделей, алгоритм предполагает наличие атак и пропускает этап перекрестной проверки, чтобы сразу перейти ко второму этапу.

Шаг 3. Возвращает индикатор потенциальных атак. Если какая-либо модель клиента обнаруживается как «потенциально вредоносная», сервер выводит индикатор того, что атаки могли произойти в текущем раунде FL, а затем алгоритм вводит следующий этап — дальнейшая проверка и удаление вредоносных клиентских моделей.

3.2 ОБНАРУЖЕНИЕ АНОМАЛИЙ МЕЖДУ КЛИЕНТАМИ

Мы даем обзор этапа межклиентского обнаружения и подробно рассказываем об алгоритме.

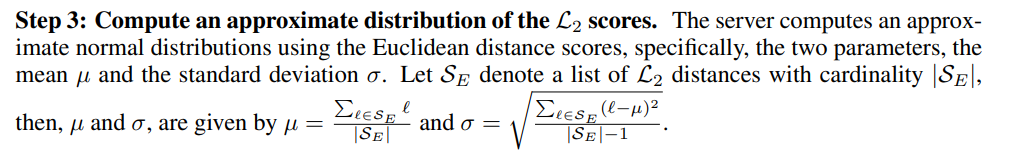

Обзор. При межклиентском обнаружении сервер использует правило трех сигм для дальнейшего определения того, действительно ли произошли атаки на потенциально вредоносных клиентов, определенных на первом этапе. Из агрегации удаляются только те локальные модели, которые на этом этапе снова помечены как «вредоносные». На каждой итерации FL сервер вычисляет оценку L2 между каждой локальной моделью и приблизительной средней моделью. Затем сервер использует эти оценки для вычисления приблизительного нормального распределения. На основе правила трех сигм сервер вычисляет границу для фильтрации потенциально вредоносных клиентских моделей. Алгоритм показан в алгоритме 3. Ниже мы объясним алгоритм по шагам.

Шаг 1. Получите среднюю модель. Наш алгоритм принимает глобальную модель, вычисленную после удаления всех вредоносных локальных моделей в последнем раунде, в качестве средней модели для текущего раунда FL. Для первого раунда обучения FL, в котором нет базовой модели, наш алгоритм использует mKrum для вычисления приблизительной средней модели. Поскольку сервер FL не знает количества потенциальных злонамеренных клиентов, мы установили m равным L/2, чтобы вычислить приблизительную среднюю модель, основанную на предположении, что количество вредоносных клиентов меньше L/2, где L — количество клиентов в каждом раунде FL. Такая приблизительная средняя модель используется для расчета расстояний L2 для локальных моделей в текущем раунде обучения FL.

Шаг 2. Вычисление оценок для каждой клиентской модели. Алгоритм использует среднюю модель, обозначенную как wavg , и использует ее для вычисления L 2 балла (т.е.. Евклидово расстояние) для каждой локальной модели wi как Si = ||wiI − wavg || в текущем тренировочном раунде FL.

Шаг 4. Удалите вредоносные локальные модели на основе правила трех сигм и показателей L2. Граница удаления вредоносных клиентов определяется как стандартное отклонение λ (λ > 0) среднего значения как µ + λσ. . Сервер считает локальные модели с баллами выше границы «аномальными локальными моделями» и удаляет их из агрегации. Обратите внимание, что мы принимаем только одну сторону границ правила трех сигм, поскольку предпочитаем более низкие оценки L2, которые указывают на то, что локальная модель «ближе» к средней модели. Таким образом, мы не отфильтровываем клиентские модели с рейтингом ниже µ − λσ.

Шаг 5: Рассчитайте новую среднюю модель для последующей итерации FL. После удаления вредоносных клиентских моделей сервер использует безопасные локальные модели для расчета средней модели для следующего раунда.

Оптимизация вычислений и хранения. Алгоритм 2 и Алгоритм 3 используют локальные и глобальные модели для вычисления оценок (т. е. сходства косинусов в Алгоритме 2 и расстояний L2 в Алгоритме 3), что требует хранения полных моделей клиентов в кэш и использовать их в вычислениях. Чтобы уменьшить размер кэша и время вычислений, аналогично Fung et al. (2020) мы используем слой, который может представлять всю модель, называемый «уровнем важности», вместо использования полных моделей. Интуитивно мы выбираем предпоследний слой, так как он содержит больше информации обо всей модели. Мы экспериментально проверим это в разделе 5.

Оригинал