Механика моделей вознаграждения в RLHF

17 января 2024 г.:::информация Авторы:

(1) Натан Ламберт, Институт искусственного интеллекта Аллена;

(2) Роберто Каландра, Технический университет Дрездена.

:::

Таблица ссылок

Понимание несоответствия целей

3 Фон

3.1 Обучение модели вознаграждения

Модели вознаграждения обучаются с использованием данных о предпочтениях человека, которые чаще всего состоят из задачи, заданной в подсказке модели, т. е. запроса или инструкции, и оценок выполнения или ответа. Обратная связь может состоять из выбора лучшего из групп ответов (Ziegler et al., 2019), оценок и ранжирования группы ответов-кандидатов (Ouyang et al., 2022), выбора между парой ответов (Bai et al., 2022). ., 2022) (выберите лучший ответ между двумя вариантами) и даже более детальные данные (Z. Wu et al., 2023). Нанятым работникам обычно даются подробные инструкции о том, каким стилям, явлениям или ценностям следует отдать приоритет в своих ярлыках.

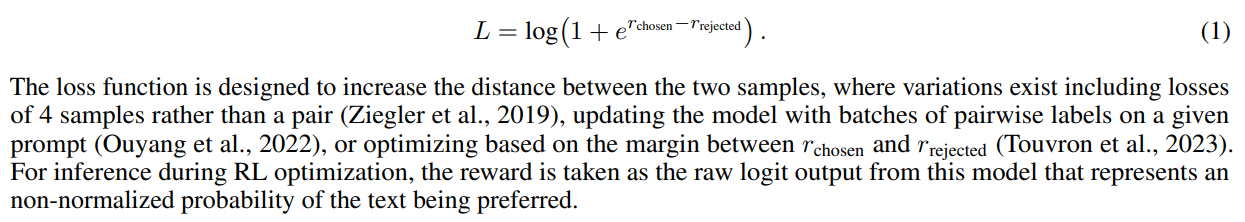

Модели вознаграждения, обученные для RLHF, чаще всего обучаются как классификаторы между выбранным и отклоненным завершением для запроса перед оптимизацией с помощью RL, где они возвращают скалярное значение для каждого фрагмента текста. Учитывая два варианта завершения y из подсказки x и баллы, которые они получают в результате скалярного вывода r из изначально необученной головы значения в LLM или модели ценности, следует потеря для модели вознаграждения (Askell et al., 2021; Оуян и др., 2022)

3.2 Углубленное изучение языка

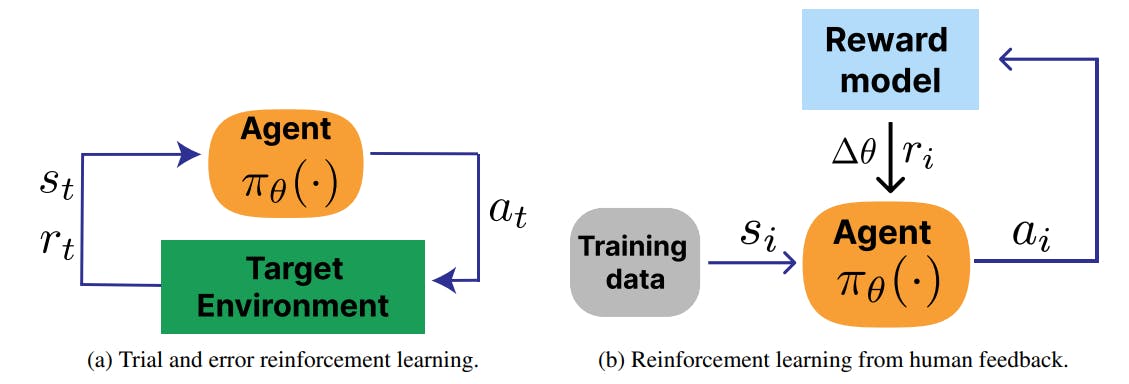

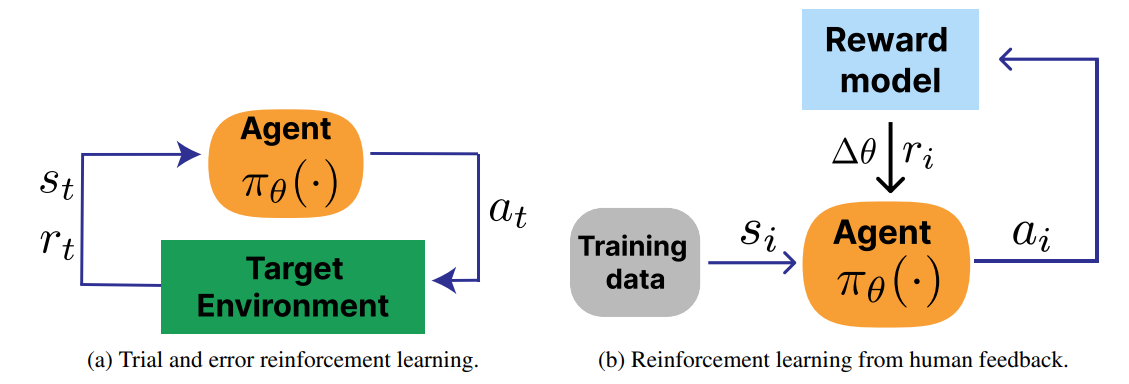

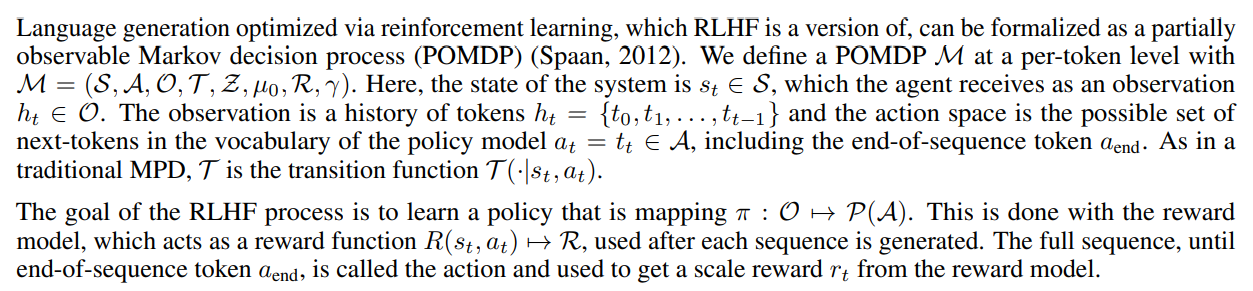

В рамках LLM генерирующая модель называется моделью политики. В RLHF коэффициент дисконтирования вознаграждения установлен равным 1, и никаких дальнейших действий для данной подсказки не предпринимается, что делает проблему контекстуальной бандитской проблемой. Пример петли RLHF показан на рис. 2b в сравнении со стандартной петлей RL, показанной на рис. 2a.

:::информация Этот документ доступен на arxiv по лицензии CC 4.0.

:::

Оригинал

Recent Post

-

Вы буквально наняты, если у вас есть один навык

15 июля 2025 г. -

LLMS: Как построить Superintelligence AI? [Подсказка: хранение]

15 июля 2025 г. -

Может ли ваш LLM обработать счету? Я проверил 5 - вот правда

15 июля 2025 г. -

Новое исследование разбивает RLM ROI по вариантам использования бизнеса

15 июля 2025 г. -

Понимание финансовых последствий развертывания LLM

15 июля 2025 г.

Categories

- Python

- blockchain

- web

- hackernoon

- вычисления

- вычислительные компоненты

- цифровой дом

- игры

- аудио

- домашний кинотеатр

- Интернет

- Мобильные вычисления

- сеть

- фотосъемка видео

- портативные устройства

- программного обеспечения

- телефон и связь

- телевидение

- видео

- мир технологий

- умные гиды

- облако

- искусственный интеллект

- се

- Samsung

- умные города

- digitaltrends

- отели

- Startups

- Venture

- Crypto

- Apps

- безопасность

- техника и работа

- cxo

- мобильность

- разработчик

- 5г

- майкрософт

- инновации

- Права и свободы

- Законодательство и право

- Политика и общество

- Космическая промышленность

- Информационные технологии

- Технологии

- Образование

- Научные исследования

- Автомобильная промышленность

- Программная инженерия

- IT и технологии

- Веб-разработка

- Программирование

- Автоматизация

- Карьерный рост

- Программирование и анализ данных

- Трудоустройство

- Политика

- Искусственный интеллект

- ИТ-технологии

- Программное обеспечение

- Экологическая политика

- Образование и рынок труда

- Политика и право

- Microsoft Teams и SharePoint

- Информационная безопасность

- Кибербезопасность

- Налоги

- Образование и карьера

- Интернет и технологии

- Технологии, Государственные услуги

- Политика и технологии

- Разработка программного обеспечения

- Разработка ПО

- Машинное обучение

- Налогообложение, технологии, открытый исходный код

- Финансы и налоги

- Технологии, Интернет, Экология

- Интернет, безопасность

- Технологии и политика

- Операционные системы

- Профессиональная разработка

- Технологии, Безопасность

- Интернет и общество

- Финансовая индустрия

- Налоговый учёт

- Общественное здравоохранение

- Технологическая отрасль

- Юриспруденция

- Технологии и государство

- Здоровье и фитнес

- IT-инфраструктура

- Технологии и ИИ

- Здравоохранение

- IT

- Технологии, Экономика

- Музыка и технологии

- Здоровье и питание

- IT и безопасность

- Бизнес и предпринимательство

- Технологии, Программное обеспечение

- Технологии и инновации

- Технологии, данные, этика

- Технологии и Интернет

- Технологии и SaaS

- Медицина и здравоохранение

- Онлайн-видеосервисы

- Финансы и технологии

- Чтение и саморазвитие

- Экономика и бизнес

- Безопасность данных

- Удаленная работа

- Авиация и технологии

- Технологии, Игры

- Энергетика

- Социальные сети, безопасность, технологии

- Саморазвитие

- Безопасность информации

- Бизнес и карьера

- Технологии и отношения

- Игровая индустрия

- Компьютерная индустрия

- Математика, Искусственный интеллект

- Наука и технологии

- Технологии и безопасность

- Технологии, Удаленная работа, Бизнес

- Видеоигры

- Технологии, Искусственный интеллект, Этика

- Технологии, социальные сети, 6G

- Технологии, Программирование, AI, Разработка ПО

- Программирование, Разработка ПО, Технологии

- Животные

- Технологии, Искусственный интеллект

- Программирование, карьера, технологии, обучение

- Бизнес и технологии

- Технологии, Безопасность данных

- Астрономия и физика

- Продуктивность, личное развитие

- Медиа и Технологии

- Программирование и Искусственный Интеллект

- Социальные сети

- Политика и экономика

- Технологии, Медицина, Искусственный интеллект

- Технологии и управление

- Космос и астрономия

- Общество и политика

- Космические исследования

- Веб-дизайн

- Искусственный интеллект и безопасность данных

- Технологии, Безопасность, Конфиденциальность

- Экологическая проблема

- Технологии, Погода

- Авиация

- Транспортная сфера

- Технологии и бизнес

- Игровая промышленность

- Телевидение и реклама

- Аналитика данных

- Технологии и кибербезопасность

- Маркетинг

- Технологии и гаджеты

- Технологии, Авиация, Инновации

- Финансы и инвестиции

- Технологии и общество

- Рыночный анализ

- Космология

- Данные и бизнес

- IT и программирование

- Технологии и право

- Программирование и разработка

- Медицинские технологии

- Авиационная промышленность

- Технологии и искусственный интеллект

- Генетическая инженерия

- Бизнес и инвестиции

- Компьютерная промышленность

- Психология и социология

- Образование и технологии

- Рынок труда

- Технологии, Стартапы

- Технологии, Приватность, Чтение

- Маркетинг и продажи

- Виртуальная реальность

- Технологии, Смартфоны, Маркетинг

- Технологии, Бизнес, Личностный рост

- Экологические проблемы

- Экономика и технологии

- IT и карьера

- Интернет и безопасность

- Разработка и технологии

- Биотехнологии

- Интернет-магазины, кибербезопасность

- Финансы

- Безопасность и технологии

- Экономика

- Защита данных

- Data Science

- Карьера и работа

- Финансовый успех, мошенничество, маркетинг

- Безопасность

- Экология

- Космическая индустрия

- Программирование, Python, Обучение

- Технологии искусственного интеллекта

- Технологии, Дизайн, iOS

- Программирование, DevOps, Kubernetes

- Социальные сети и пропаганда

- Корпоративная этика

- Управление IT-инфраструктурой

- Здоровье и медицина

- Медицина

- Медицинская промышленность

- Разработка и дизайн

- Искусственный интеллект, Диагностика систем

- Образование и психология

- Технологии, Автомобильная промышленность

- Автомобили и путешествия

- Астрономия и космология

- Программирование и технологии

- IT, работа в офисе, эмоциональный интеллект

- Компьютерная техника

- Здоровье и благополучие

- Управление персоналом

- Политика и управление

- Бизнес и экономика

- Социальные сети, Пропаганда, Информационная безопасность

- Технологии и автоматизация

- Геймдизайн

- Экология и технологии

- CRM-системы, IT-инфраструктура

- Права человека

- Цифровая цензура, свобода слова, технологии

- Технологии, Искусственный интеллект, Работа

- Наука о данных

- Астрономия, Наука

- Интернет и цифровые технологии

- Технологии, управление

- Интернет и связь

- Технологии и конфиденциальность

- Интернет и свобода слова

- Психология и социальные науки

- Книги и литература

- Работа и карьера

- Финансовые технологии

- Психология и саморазвитие

- IT, программирование, сети

- Технологии, Видеоигры

- Экология и энергетика

- Космонавтика

- Медицина и технологии

- Игры и развлечения

- Музыкальная индустрия

- Логистика и складирование

- Бизнес и финансы

- Экология и окружающая среда

- Правозащита

- Социальные сети и дезинформация

- Технологии и рынок труда

- Технологии, Искусственный интеллект, Рынок труда

- Технологии и будущее

- Медицина и здоровье

- Социальные медиа

- Экология, политика, общество

- Экономика и Финансы

- Разработка игр

- Пропаганда и дезинформация

- Медицинские исследования

- Онлайн-знакомства

- Политика и СМИ

- Энергетика и электромобили

- Климатические изменения

- Технологии, Рынок труда

- IT и управление данными

- Безопасность и кибербезопасность

- Интернет-технологии

- Психология и личностное развитие

- Технологии, Мессенджеры

- Цифровые технологии

- Здоровье и самосовершенствование

- Технологии и AI

- Технологии и спорт

- IT, Разработка программного обеспечения

- Экология и климат

- Космос и технологии

- Юридическая сфера

- Безопасность в интернете

- Программирование, Искусственный Интеллект, Качество ПО

- Технологии и мессенджеры

- Социальная справедливость

- Технологическая индустрия

- Личностное развитие, Time-менеджмент, Психология

- Бизнес и менеджмент

- Технологии, Микросхемы, Автономные системы

- Фриланс и предпринимательство

- Социальные сети и искусственный интеллект

- Криминальные дела

- Социальные сети, Маркетинг

- Энергетика и экология

- Технологии, Искусственный Интеллект, Полиция

- Программирование, Искусственный интеллект, Рынок труда

- Социальные сети, дезинформация, анализ данных

- Потребительские права

- Образование и наука

- Технологии и правосудие

- Технологии, Безопасность, Автомобили

- Энергетика и окружающая среда

- Личностное развитие

- Технологии и экономика

- Медиа и коммуникации

- Миграция и иммиграция

- Личностный рост