Итеративное применение RLHF в языковых моделях

17 января 2024 г.:::информация Авторы:

(1) Натан Ламберт, Институт искусственного интеллекта Аллена;

(2) Роберто Каландра, Технический университет Дрездена.

:::

Таблица ссылок

Понимание несоответствия целей

5 обсуждений

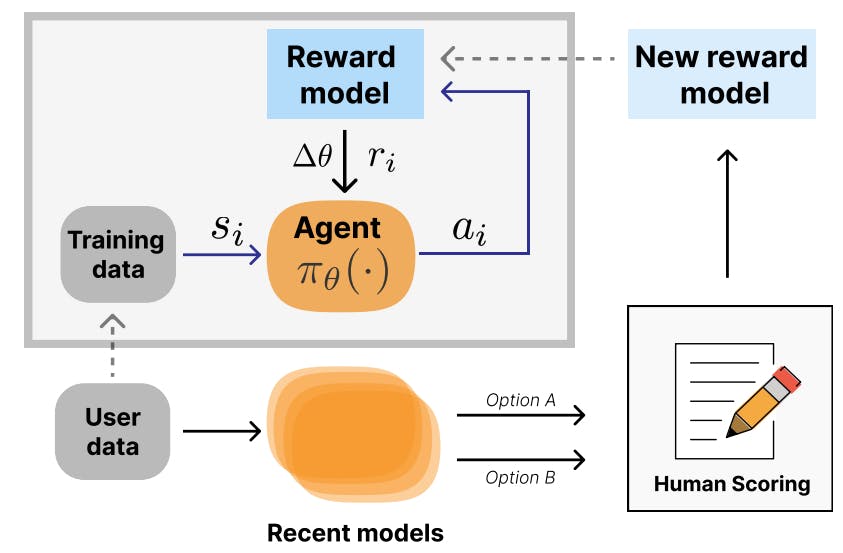

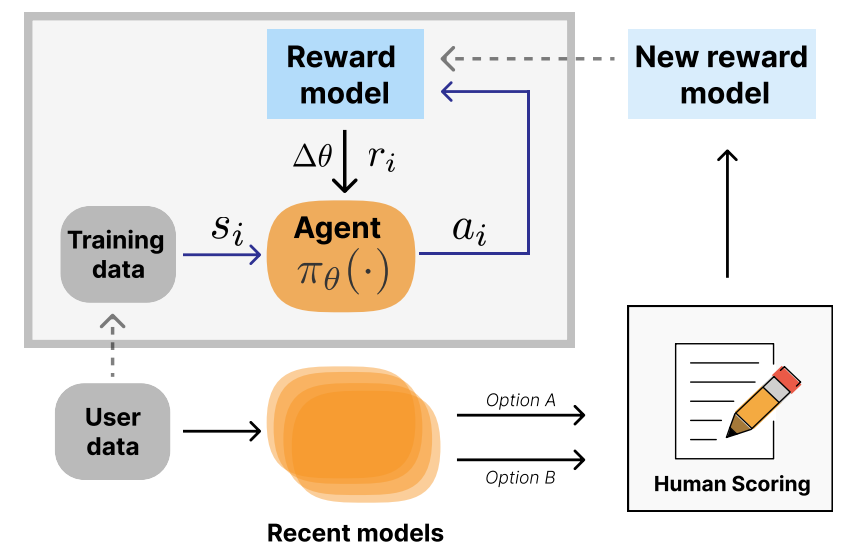

Итеративное развертывание RLHF Итеративная форма развертывания RLHF, при которой модели вознаграждения переобучаются на основе пользовательских данных, что вызывает второй цикл обратной связи, показано на рис. 4. Шульман (2023) обсуждает, как это используется в ChatGPT для устранения таких проблем, как уклончивость, многословие и другие неожиданные и нежелательные качества. Проектирование в этой среде еще больше усложняет инженерные задачи, но позволяет итеративно устранять несоответствия. Этот стиль итеративного развертывания RL понимается как экзогенная обратная связь (Гилберт, Дин, Зик и Ламберт, 2022) и может иметь социальные последствия.

В этом пространстве есть некоторая литература, но расширить соответствующие работы до масштабов использования современных LLM будет сложно. Например, Зур и Арци (2022) демонстрируют теоретические результаты по оптимизации внешнего цикла моделей, настроенных на инструкции.

Контекстные бандиты Изменения, внесенные в RL-оптимизацию RLHF, превращают ее в проблему контекстуальных бандитов, где агент выполняет одно действие, а динамика абстрагируется в одну пару траектория-награда. Работа в этой области исследовала потенциал интеграции частичных, искаженных или зашумленных отзывов людей в процесс оптимизации (Нгуен, Дауме III и Бойд-Грабер, 2017).

Подраздел дуэльных бандитов еще больше конкретизировал проблему, которая тесно связана с RLHF, но в основном в теоретической работе с гораздо меньшими моделями, наборами данных и задачами. Юэ, Бродер, Кляйнберг и Йоахимс (2012) объясняют это пространство в работе, показывая теоретические границы:

«В отличие от традиционных подходов, которые требуют, чтобы абсолютное вознаграждение выбранной стратегии было измеримым и наблюдаемым, наша установка предполагает только наличие (зашумленной) двоичной обратной связи об относительном вознаграждении двух выбранных стратегий. Этот тип относительной обратной связи особенно уместен в приложениях, где абсолютные награды не имеют естественной шкалы или их трудно измерить... но где легко провести парные сравнения».

Это, хотя и тесно связано с RLHF, потребует серьезных экспериментов, чтобы его можно было применить. Другие использовали это в работе, изучая непосредственно человеческие предпочтения (Секхари, Шридхаран, Сан и Ву, 2023) или неявную обратную связь с людьми (Магакян и др., 2022).

:::информация Этот документ доступен на arxiv по лицензии CC 4.0.

:::

Оригинал

Recent Post

-

Помимо прототипа: 15 с трудом заработанные уроки для доставки готовых к производству агентов ИИ

9 июля 2025 г. -

Грок «улучшен», по словам Элона, но сейчас он вызывает больше проблем, чем когда -либо

9 июля 2025 г. -

Что 300 ГБ исследований ИИ показывает о истинных пределах «нулевого выстрела» интеллекта

9 июля 2025 г. -

Как модели искусственного интеллекта считаются концепциями на изображениях и текстах

9 июля 2025 г. -

Анализ влияния частоты предварительной подготовки на производительность с нулевым выстрелом в мультимодальных моделях

9 июля 2025 г.

Categories

- Python

- blockchain

- web

- hackernoon

- вычисления

- вычислительные компоненты

- цифровой дом

- игры

- аудио

- домашний кинотеатр

- Интернет

- Мобильные вычисления

- сеть

- фотосъемка видео

- портативные устройства

- программного обеспечения

- телефон и связь

- телевидение

- видео

- мир технологий

- умные гиды

- облако

- искусственный интеллект

- се

- Samsung

- умные города

- digitaltrends

- отели

- Startups

- Venture

- Crypto

- Apps

- безопасность

- техника и работа

- cxo

- мобильность

- разработчик

- 5г

- майкрософт

- инновации

- Права и свободы

- Законодательство и право

- Политика и общество

- Космическая промышленность

- Информационные технологии

- Технологии

- Образование

- Научные исследования

- Автомобильная промышленность

- Программная инженерия

- IT и технологии

- Веб-разработка

- Программирование

- Автоматизация

- Карьерный рост

- Программирование и анализ данных

- Трудоустройство

- Политика

- Искусственный интеллект

- ИТ-технологии

- Программное обеспечение

- Экологическая политика

- Образование и рынок труда

- Политика и право

- Microsoft Teams и SharePoint

- Информационная безопасность

- Кибербезопасность

- Налоги

- Образование и карьера

- Интернет и технологии

- Технологии, Государственные услуги

- Политика и технологии

- Разработка программного обеспечения

- Разработка ПО

- Машинное обучение

- Налогообложение, технологии, открытый исходный код

- Финансы и налоги

- Технологии, Интернет, Экология

- Интернет, безопасность

- Технологии и политика

- Операционные системы

- Профессиональная разработка

- Технологии, Безопасность

- Интернет и общество

- Финансовая индустрия

- Налоговый учёт

- Общественное здравоохранение

- Технологическая отрасль

- Юриспруденция

- Технологии и государство

- Здоровье и фитнес

- IT-инфраструктура

- Технологии и ИИ

- Здравоохранение

- IT

- Технологии, Экономика

- Музыка и технологии

- Здоровье и питание

- IT и безопасность

- Бизнес и предпринимательство

- Технологии, Программное обеспечение

- Технологии и инновации

- Технологии, данные, этика

- Технологии и Интернет

- Технологии и SaaS

- Медицина и здравоохранение

- Онлайн-видеосервисы

- Финансы и технологии

- Чтение и саморазвитие

- Экономика и бизнес

- Безопасность данных

- Удаленная работа

- Авиация и технологии

- Технологии, Игры

- Энергетика

- Социальные сети, безопасность, технологии

- Саморазвитие

- Безопасность информации

- Бизнес и карьера

- Технологии и отношения

- Игровая индустрия

- Компьютерная индустрия

- Математика, Искусственный интеллект

- Наука и технологии

- Технологии и безопасность

- Технологии, Удаленная работа, Бизнес

- Видеоигры

- Технологии, Искусственный интеллект, Этика

- Технологии, социальные сети, 6G

- Технологии, Программирование, AI, Разработка ПО

- Программирование, Разработка ПО, Технологии

- Животные

- Технологии, Искусственный интеллект

- Программирование, карьера, технологии, обучение

- Бизнес и технологии

- Технологии, Безопасность данных

- Астрономия и физика

- Продуктивность, личное развитие

- Медиа и Технологии

- Программирование и Искусственный Интеллект

- Социальные сети

- Политика и экономика

- Технологии, Медицина, Искусственный интеллект

- Технологии и управление

- Космос и астрономия

- Общество и политика

- Космические исследования

- Веб-дизайн

- Искусственный интеллект и безопасность данных

- Технологии, Безопасность, Конфиденциальность

- Экологическая проблема

- Технологии, Погода

- Авиация

- Транспортная сфера

- Технологии и бизнес

- Игровая промышленность

- Телевидение и реклама

- Аналитика данных

- Технологии и кибербезопасность

- Маркетинг

- Технологии и гаджеты

- Технологии, Авиация, Инновации

- Финансы и инвестиции

- Технологии и общество

- Рыночный анализ

- Космология

- Данные и бизнес

- IT и программирование

- Технологии и право

- Программирование и разработка

- Медицинские технологии

- Авиационная промышленность

- Технологии и искусственный интеллект

- Генетическая инженерия

- Бизнес и инвестиции

- Компьютерная промышленность

- Психология и социология

- Образование и технологии

- Рынок труда

- Технологии, Стартапы

- Технологии, Приватность, Чтение

- Маркетинг и продажи

- Виртуальная реальность

- Технологии, Смартфоны, Маркетинг

- Технологии, Бизнес, Личностный рост

- Экологические проблемы

- Экономика и технологии

- IT и карьера

- Интернет и безопасность

- Разработка и технологии

- Биотехнологии

- Интернет-магазины, кибербезопасность

- Финансы

- Безопасность и технологии

- Экономика

- Защита данных

- Data Science

- Карьера и работа

- Финансовый успех, мошенничество, маркетинг

- Безопасность

- Экология

- Космическая индустрия

- Программирование, Python, Обучение

- Технологии искусственного интеллекта

- Технологии, Дизайн, iOS

- Программирование, DevOps, Kubernetes

- Социальные сети и пропаганда

- Корпоративная этика

- Управление IT-инфраструктурой

- Здоровье и медицина

- Медицина

- Медицинская промышленность

- Разработка и дизайн

- Искусственный интеллект, Диагностика систем

- Образование и психология

- Технологии, Автомобильная промышленность

- Автомобили и путешествия

- Астрономия и космология

- Программирование и технологии

- IT, работа в офисе, эмоциональный интеллект

- Компьютерная техника

- Здоровье и благополучие

- Управление персоналом

- Политика и управление

- Бизнес и экономика

- Социальные сети, Пропаганда, Информационная безопасность

- Технологии и автоматизация

- Геймдизайн

- Экология и технологии

- CRM-системы, IT-инфраструктура

- Права человека

- Цифровая цензура, свобода слова, технологии

- Технологии, Искусственный интеллект, Работа

- Наука о данных

- Астрономия, Наука

- Интернет и цифровые технологии

- Технологии, управление

- Интернет и связь

- Технологии и конфиденциальность

- Интернет и свобода слова

- Психология и социальные науки

- Книги и литература

- Работа и карьера

- Финансовые технологии

- Психология и саморазвитие

- IT, программирование, сети

- Технологии, Видеоигры

- Экология и энергетика

- Космонавтика

- Медицина и технологии

- Игры и развлечения

- Музыкальная индустрия

- Логистика и складирование

- Бизнес и финансы

- Экология и окружающая среда

- Правозащита

- Социальные сети и дезинформация

- Технологии и рынок труда

- Технологии, Искусственный интеллект, Рынок труда

- Технологии и будущее

- Медицина и здоровье

- Социальные медиа

- Экология, политика, общество

- Экономика и Финансы

- Разработка игр

- Пропаганда и дезинформация

- Медицинские исследования

- Онлайн-знакомства

- Политика и СМИ

- Энергетика и электромобили

- Климатические изменения

- Технологии, Рынок труда

- IT и управление данными

- Безопасность и кибербезопасность

- Интернет-технологии

- Психология и личностное развитие

- Технологии, Мессенджеры

- Цифровые технологии

- Здоровье и самосовершенствование

- Технологии и AI

- Технологии и спорт

- IT, Разработка программного обеспечения

- Экология и климат

- Космос и технологии

- Юридическая сфера

- Безопасность в интернете

- Программирование, Искусственный Интеллект, Качество ПО

- Технологии и мессенджеры