7 основных инструментов для локальной разработки LLM на MacOS в 2025 году

27 июня 2025 г.Способность бежатьБольшие языковые модели (LLMS)Местный в местном масштабе изменил развитие ИИ, особенно для тех из нас наmacOSПолем Это приносит непревзойденныеконфиденциальностьВконтроль затрат, иОфлайн -возможностиПолем Но чтобы по -настоящему использовать эту силу в 2025 году, вам нужно больше, чем просто модельный файл; Вам нужен надежный инструментарий. Создаете ли вы приложения, настраиваемые на AI, настраиватьПоиск дополненного поколения (Rag)Иметь правильную локальную настройку является ключевым.

Забудьте полагаться исключительно наоблачные APIс их метками и вопросами конфиденциальности данных. Давайте погрузимся в7 Основных инструментовЭто в этом году перезарядит ваш местный рабочий процесс разработки LLM на MacOS, что сделает его более эффективным, мощным и приятным.

1Оллама: ваши ворота в местные LLMS

Что это такое:

Олламаэто инструмент с открытым исходным кодом, который резко упрощает загрузку, настройку и запуск последних LLMS с открытым исходным кодом (например, Llama 3, Mistral, Gemma 2, Phi-3 и многих других) непосредственно на вашей машине. Он предоставляет простой интерфейс командной строки и локальную конечную точку API.

Почему это важно:

Ollama - это двигатель, который делает местные эксперименты LLM доступными. Он устраняет большую часть сложности управления моделями, позволяя быстро переключаться и переключаться между различными моделями. Для разработчиков ИИ на MacOS это основополагающая часть для большинства местных работ LLM.

Влияние рабочего процесса:

Получите от нуля, чтобы вызвать мощный местный LLM за считанные минуты. Легко проверить различные архитектуры модели и размеры для ваших конкретных потребностей. Его локальный API обеспечивает бесшовную интеграцию с вашими пользовательскими приложениями.

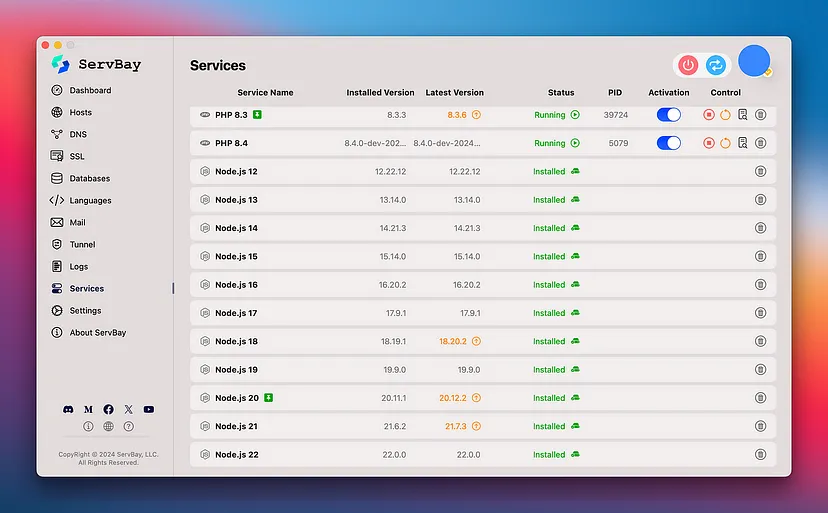

2Servbay: Объединенная местная среда развития

Что это такое:

ПокаОлламазапускает модели,Сервисявляется местной средой локальной разработки для MacOS, которая управляетОлламаи все остальные услуги, которые может понадобиться вашему приложению для искусственного интеллекта. Это включает в себя несколько версийПитонВNode.js, базы данных, какPostgresqlилиMysql, веб -серверы (nginx, caddy) и многое другое через чистый графический интерфейс.

Почему это важно:

Приложения ИИ редко существуют в вакууме. Вам часто понадобитсяБэкэнд Python(например, колба/django) илиNode.js apiЧтобы взаимодействовать с вашей LLM, обслуживаемым OLLAMA, возможно, базой данных для хранения результатов или контекста для RAG. Servbay гарантирует, что эти услуги гармонично работают с конкретными версиями, без конфликтов, и их легко управлять наряду с Олламой.

Влияние рабочего процесса:

Настройка на один клик для Ollama в более широкой, управляемой среде Dev. Легко переключитьсяPHPВПитон, илиNode.jsВерсии для различных компонентов проекта искусственного интеллекта. Управляйте базами данных, критически важными для ваших приложений для ИИ. Это панель управления для всего вашего локального стека ИИ.

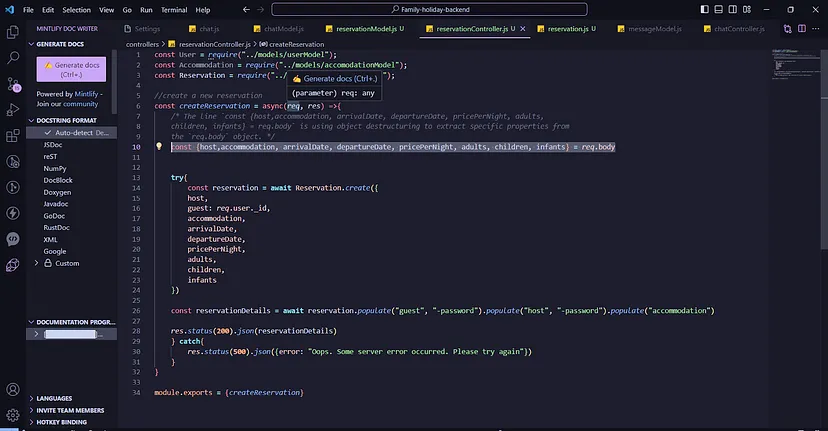

3VS Code + AI-расширения: ваша кодировка кабина

Что это такое:

Visual Studio Codeостается доминирующим редактором кода по какой -то причине: он быстрый, гибкий и имеет невероятную экосистему расширений. Для разработки ИИ в 2025 году расширения какGitHub Copilot, конкретные структуры инструментов (например, для Langchain или Lmamaindex), а также инструменты, которые помогают взаимодействовать с локальными API LLM, являются незаменимыми.

Почему это важно:

ПисьмоПитонилиJavaScriptЧтобы взаимодействовать с местными LLMS, строительство Frontends для ваших приложений для ИИ или создание сложных подсказок, все это происходит здесь. Расширения искусственного интеллекта обеспечивают интеллектуальное завершение кода, помогают отладить AI-специфическую логику и даже помочь в создании тестовых случаев или документации.

Влияние рабочего процесса:

Более быстрая разработка кода, лучшее качество кода и более легкая интеграция возможностей LLM в ваши проекты, все в знакомой и мощной среде редактирования.

4Open Webui (или аналогичный): интерактивная игровая площадка LLM

Что это такое:

ПокаОлламаЗапускает модели через CLI, такие инструменты, какОткройте Webui(ранее Ollama webui) или другие новые решения, такие какLibrechatилиЛОБЕХАТПредоставьте удобный интерфейс на основе чата для взаимодействия с местом работыОлламамодели. Многие поддерживают многомодерное взаимодействие, функции RAG и быстрое управление.

Почему это важно:

Для быстрого быстрого инженера, ответов на тестирование модели и общего взаимодействия без написания кода для каждого запроса выделенный пользовательский интерфейс неоценим. Эти инструменты часто предлагают функции, помимо того, что основноеОллама КлиПредоставляет, например, история разговора, переключение моделей на лету, а иногда даже документируйте взаимодействие для тряпки.

Влияние рабочего процесса:

Значительно ускоряет оперативную итерацию и оценку модели. Позволяет легче демонстрировать местные возможности LLM. Многие поддерживают тряпку, позволяя вам общаться с вашими документами.

5Chromadb / lancedb: ваш местный векторный магазин для тряпки

Что это такое:

Для строительства приложений сПоиск дополненного поколения (Rag)- Где вы предоставляете LLMS с пользовательскими знаниями - векторная база данных имеет важное значение. Варианты с открытым исходным кодом, такие какChromadbилиLancedbпредназначены для того, чтобы быть легким и простым в местном уровне для разработки.

Почему это важно:

RAG - это доминирующий шаблон для того, чтобы сделать LLMS более полезными с конкретными частными данными. Эти локальные векторные базы данных позволяют вам создавать, хранить и запрашивать встраивания из ваших документов на вашем Mac, гарантируя, что ваша база знаний остается частной.

Влияние рабочего процесса:

Разработайте и тестируйте тряпичные трубопроводы от сквозного на местном уровне. Легко экспериментируйте с различными стратегиями встраивания и документируйте Chunking, не полагаясь на облачный вектор DBS во время фазы разработки. Servbay может помочь управлять средой Python, необходимой для их запуска.

6Bruno / Postman: Освоение местных API LLM

Что это такое:

Ваши местные LLM (черезОллама) разоблачить API (обычно на Localhost: 11434). Такие инструменты, как открытый источникБруноили хорошо известныйPostmanнеобходимы для тестирования этих локальных конечных точек API, запросов на создание и осмотра ответов. Это также важно, если вы создаете свой собственный API вокруг LLM.

Почему это важно:

Предоставляет структурированный способ взаимодействия с API LLM для более сложных задач, переработки партии или при разработке приложения, которое будет программно вызвать LLM. Подход Bruno's Friendly, который является бонусом для вызова версий ваших коллекций вызовов API.

Влияние рабочего процесса:

Эффективно отлаживайте свои локальные взаимодействия API LLM, автоматизируйте тестирование различных подсказок или параметров и убедитесь, что бэкэнд вашего приложения может правильно общаться с локальной моделью ИИ.

7Git & github/gitlab: версии ваших шедевров AI

Что это такое:

Бесспорные чемпионы контроля версий. Для проектов искусственного интеллекта,Git(и платформы любятGitHubилиГитлаб) не только для кода; Это важно для отслеживания подсказок, конфигураций моделей, наборов данных (или указателей на них) и экспериментов.

Почему это важно:

Воспроизводимость является ключом в ИИ. Версия, управляющая вашими подсказками, параметрами и кодом, который организует ваши взаимодействия LLM, позволяет отслеживать эксперименты, вернуться к предыдущим версиям и эффективно сотрудничать.

Влияние рабочего процесса:

Обеспечивает безопасную сеть для экспериментов. Облегчает командную работу по проектам искусственного интеллекта. Помогает документировать эволюцию ваших подсказок и конфигураций модели.

Развитие сLlms локальноНа вашем Mac в 2025 году невероятно расширяет возможности. Объединив прямой доступ к доступу моделиОлламас надежным управлением окружающей средойСервис, мощный редактор, какПротив кода, хороший пользовательский интерфейс LLM, локальная векторная база данных дляТряпичный, Инструменты тестирования API и управление твердыми версиями, вы создаете частный, экономичный и высокопроизводительный стек разработки искусственного интеллекта.

Этот инструментарий позволяет эффективно перемещаться от идеи к приложению с AI, все это обеспечивая обеспечение безопасности ваших данных, и ваш рабочий процесс оптимизирован на вашем компьютере MacOS.

Каковы ваши инструменты для локальной разработки LLM?Поделитесь своими любимыми в комментариях!

Оригинал