Sutra: новый прецедент для многоязычных LLMS & Future AI

27 июня 2025 г.Таблица ссылок

Аннотация и 1 введение

2 Связанная работа

3 подход сутры

3.1 Что такое сутра?

3.2 Архитектура

3.3 Данные обучения

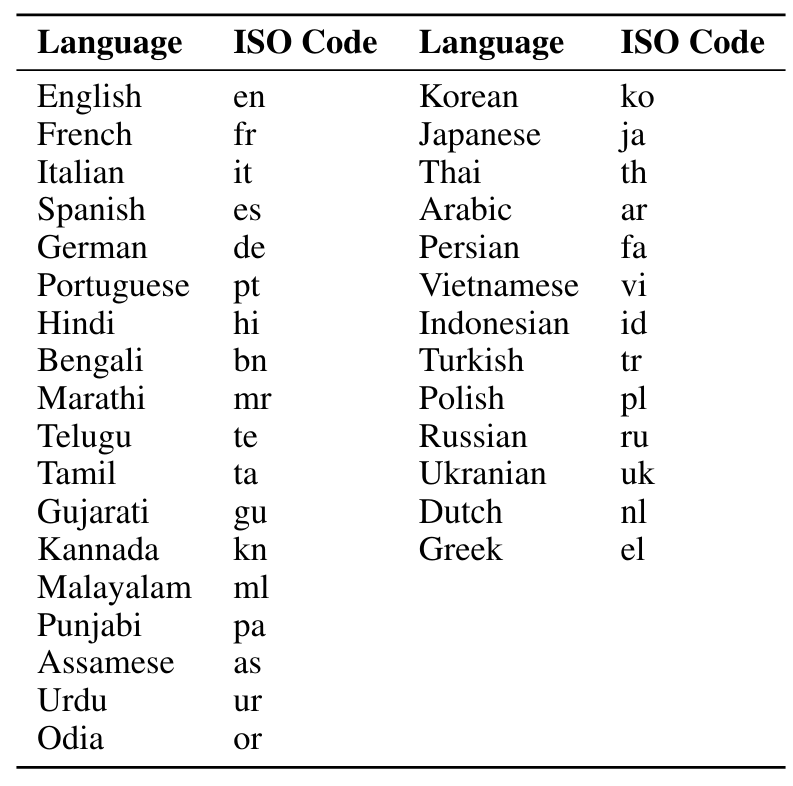

4 тренинги многоязычных токенизаторов

5 многоязычных MMLU

5.1 Массивное многозадачное понимание языка

5.2 Расширение MMLU на несколько языков и 5.3 последовательная производительность между языками

5.4 по сравнению с ведущими моделями для многоязычной производительности

6 Количественная оценка запросов в реальном времени

7 Обсуждение и заключение, а также ссылки

7 Обсуждение и заключение

Заглядывая в будущее, сутра прокладывает путь к разработке фонетических моделей (подход для сутра-джванима), который выигрывает от четкого разделения между концептуальным моделированием и изучением языка. Заменив декодер NMT фонетическим декодером, мы включаем генерацию фонетических ответов для более беспроблемной интеграции с речевыми моделями. Наша следующая граница для оптимизации - изучить точность и воздействие на производительность структурированной редкости и точности Int4, что может значительно снизить следы GPU GPU и урожайность с улучшением задержки.

Это исследование представило Sutra, современную многоязычную дипломирующую языковую модель, демонстрирующую свою превосходную способность обрабатывать множество языков с замечательной эффективностью и производительностью. Сутра уже опыта на 31 языке по нескольким задачам, как подробно описано в таблице 10, и распространяется на поддержку более 50 языков. В отличие от своих предшественников, которые борются с тонкими требованиями многоязычного понимания, Sutra демонстрирует надежное знание, которое очевидно в ряде лингвистических контекстов. Это особенно заметно в своем применении к языкам с меньшим количеством ресурсов, доступных для модельного обучения, которые традиционно отстают в показателях эффективности. Инновационная архитектура сутры с ее отдельной концепцией и языковой обработкой обеспечивает масштабируемый и гибкий подход к обучению языковой модели. Это не только открывает дверь для более справедливого представления менее часто говорящих языков, но и гарантирует, что качество взаимодействия остается высоким на всех языках. Эффективная стратегия токенизации сутры, снижение рождаемости токков для неанглийских языков, также указывает на потенциальное снижение затрат при развертывании ИИ в многоязычных средах, что является заметным соображением для глобальной доступности.

В заключение, Сутра устанавливает новый прецедент для многоязычных языковых моделей, обеспечивая высокую производительность и эффективность, не жертвуя языковым разнообразием. Его архитектура, которая отражает человеческое когнитивное развитие, отделяя понимание концепции от языкового выражения, допускает более естественный и обширный язык

понимание. Этот прорыв имеет значительные последствия для глобального внедрения и применения ИИ, прокладывая путь к более инклюзивному и справедливому доступу к технологиям в разных языковых барьерах.

Ссылки

Том Б. Браун и соавт. Языковые модели-это несколько выстрелов. Arxiv Preprint arxiv: 2005.14165, 2020.

Джейкоб Девлин, Мин-Вей Чанг, Кентон Ли и Кристина Тутанова. Берт: предварительное обучение глубоких двунаправленных трансформаторов для понимания языка. Arxiv Preprint arxiv: 1810.04805, 2018.

Roger Jia et al. Предвзятость в многоязычных моделях: случай для лингвистического капитала в ИИ. В конференции по системам обработки нейронной информации (Neurips), 2019.

Алексис Конно и соавт. Неконтролируемое кросс-лингальное представление обучение в масштабе. Arxiv Preprint arxiv: 1911.02116, 2020.

Линда Смит и соавт. Могут ли многоязычные модели перенести для менее ресурсов? Языковые ресурсы и оценка, 2021 год.

Yiming Zhang et al. Улучшение многоязычных моделей с языковыми кластерными слогами. Arxiv Preprint Arxiv: 2007.07680, 2020.

Yonghui Wu et al. Система перевода нейронной машины Google: преодоление разрыва между человеческим и машинным переводом. Arxiv Preprint arxiv: 1609.08144, 2019.

Noam Shazeer et al. Возмутительно крупные нейронные сети: редко управляемый слой смеси экспертов. Arxiv Preprint arxiv: 1701.06538, 2017.

Dan Hendrycks et al. Измерение массового многозадачного понимания языка. Arxiv Preprint arxiv: 2009.03300, 2021.

Филипп Кен и Ребекка Ноулз. Шесть проблем для перевода нейронной машины. Arxiv Preprint arxiv: 1706.03872, 2017.

Юнгву Сын и Бионгил Ким. Производительность перевода с точки зрения пользователя на крупные языковые модели и системы перевода нейронных машин. Информация, 14 (10): 574, 2023.

Йонгуи Ву, Майк Шустер, Чифенг Чен, Кук В. Лей, Мохаммад Норузи, Вольфганг Мачери, Максим Крикун, Юань Цао, Цинь Гао, Клаус Мачери и др. Система перевода нейронной машины Google: преодоление разрыва между человеческим и машинным переводом. Arxiv Preprint arxiv: 1609.08144, 2016.

Марта Р. Коста-Ясса, Джеймс Кросс, Онур Челеби, Маха Эльбаяд, Кеннет Хифилд, Кевин Хеффернан, Элахе Калбасси, Дженис Лам, Даниэль Лихт, Джин Майлард и др. Не осталось языка: масштабирование машинного перевода, ориентированного на человека. Arxiv Preprint arxiv: 2207.04672, 2022.

Янки Чжоу, Тао Лей, Хансиао Лю, Нэн Дю, Янпинг Хуанг, Винсент Чжао, Эндрю М. Дай, Квок В. В. Лей, Джеймс Лаудон и др. Смесь экспертов с экспертным выбором маршрутизации. Достижения в системах обработки нейронной информации, 35: 7103–7114, 2022.

Баррет Зоф. Проектирование эффективных редких экспертных моделей. IEEE International Parallel и Distributed Rockesing Symposium (IPDP), 2022.

Майл Отт, Сэм Шлейфер, Курт Шустер, Даниэль Симиг, П Сай Кура, Абхинав Шридхар, Тао Ван и Люк Зеттлемуер. Опт: открытые предварительно обученные модели языка трансформатора. 2022.

Чудзи Чжэн, Минли Хуан и Эйксин Сан. Чид: крупномасштабный набор данных китайской идиомы для теста. В материалах 57-го ежегодного собрания Ассоциации вычислительной лингвистики, страницы 778–787, 2019. DOI: 10.18653/V1/P19-1075. URL https://doi.org/10.18653/v1/p19-1075.

Зиханг Дай, Жилин Ян, Йиминг Ян, Хайме Гбебоголл, Кук Ле и Руслан Салахутдинов. Transformer-XL: внимательные языковые модели за пределами контекста с фиксированной длиной. Arxiv Preprint arxiv: 1901.02860, 2019.

Джоанна Николс и Тэнди Варноу. Учебник по вычислительной лингвистической филогении. Язык и лингвистика Compass, 2 (5): 760–820, 2008.

Александра Берч. Нейронная машина перевод. Издательство Кембриджского университета, 2021.

Ту Ву, Мохит Ийер, Сюежи Ван, Ноа Констант, Джерри Вей, Джейсон Вей, Крис Тар, Юн-Хсуань Сун, Денни Чжоу, Кук Ле и Танг Луонг. Freshllms: освежающие большие языковые модели с увеличением поисковой системы, 2023.

Офир Пресс, Муру Чжан, Сьюон Мин, Людвиг Шмидт, Ной А. Смит и Майк Льюис. Измерение и сужение разрыва в композиции в языковых моделях. Arxiv Preprint arxiv: 2210.03350, 2022.

Мойтаба Комейли, Курт Шустер и Джейсон Уэстон. Интернет-август, генерация диалога. Arxiv Preprint arxiv: 2107.07566, 2021.

Ashish Vaswani et al. Внимание - это все, что вам нужно. Достижения в области систем обработки нейронной информации, 30, 2017.

Альберт Q Цзян, Александр Саблайроллс, Артур Менш, Крис Бэмфорд, Девендра Сингх Чаприз, Диего де Лас Касас, Флориан Брессанд, Джанна Ленгьель, Гийом Лейпл, Люсиль Саулньер и др. Мишстраль 7b. Arxiv Preprint arxiv: 2310.06825, 2023.

Эйдан Кларк, Диего де Лас Касас, Аурелия Гай, Артур Менш, Микела Паганини, Джордан Хоффманн, Богдан Дамер, Блейк Хехтман, Тревор Кай, Себастьян Борджо и др. Унифицированные законы масштабирования для маршрутизированных языковых моделей. На Международной конференции по машинному обучению, страницы 4057–4086. PMLR, 2022.

Хуссейн Хазимейх, Чжэ Чжао, Ааканкша Чоудери, Махешваран Сатиамурти, Йихуа Чен, Рахул Мазумдер, Личан Хонг и Эд Чи. Dselect-K: дифференцируемый выбор в смеси экспертов с приложениями для многозадачного обучения. Достижения в системах обработки нейронной информации, 34: 29335–29347, 2021.

Вьет Дак Лай, Чиен Ван Нгуен, Нгия Трунг Нго, Туат Нгуен, Франк Дернонкур, Райан А. Росси и Тиен Ху Нгуен. Okapi: настраиваемые инструкции на крупных языковых моделях на нескольких языках с подкреплением, обучающимся на обратной связи с человеком. Arxiv Preprint arxiv: 2307.16039, 2023.

Chenxi Whitehouse, Monojit Choudhury и Alham Fikri Aji. Увеличение данных LLM для повышения производительности кросслинга. Arxiv Preprint arxiv: 2305.14288, 2023.

Yuntao Bai, Энди Джонс, Камаль Ндуусс, Аманда Аскалл, Анна Чен, Нова Дассарма, Dawn Drain, Fort Stanislav, Deep Ganguli, Tom Henighan, et al. Обучение полезного и безвредного помощника по подкреплению, обучаясь на отзывах человека. Arxiv Preprint arxiv: 2204.05862, 2022.

Андреас Кёпф, Янник Килчер, Дмитрий фон Рютт, Сотирис Анагностид, Чжи-Руи Там, Кейт Стивенс, Абдулла Бархум, Нгуен Мин Дук, Оливер Стэнли, Ричард Наджифи, и сэм. Открытые разговоры - демократизация крупного языкового выравнивания. Arxiv Preprint arxiv: 2304.07327, 2023.

Вей-линь Чианг, Лианмин Чжэн, Ин Шэн, Анастасиос Николас Анджелпулос, Тянле Ли, Даченг Ли, Хао Чжан, Бангуа Чжу, Майкл Джордан, Джозеф Э. Гонсалес и др. Арена чатбота: открытая платформа для оценки LLMS с помощью человеческих предпочтений. Arxiv Preprint arxiv: 2403.04132, 2024.

Хьюго Тувров, Луи Мартин, Кевин Стоун, Питер Альберт, Амджад Альмахайри, Ясмин Бабей, Николай Башликов, Суйя Батра, Праджвал Бхаргава, Шрайли Бхосале и др. Llama 2: Open Foundation и тонкие модели чата. Arxiv Preprint arxiv: 2307.09288, 2023.

Ахмет Юстюн, Вираат Арьябуми, Чжэн-Синь Юн, Вей-Инь Ко, Даниэль Д'Суза, Гбемилек Найлуде, Нил Бхандари, Шивалка Сингх, Ху-Ле-Оой, Амр Кайд, et al. AYA MODEL: Многоязычная языковая модель с открытым доступом. Arxiv Preprint arxiv: 2402.07827, 2024.

Джей Гала, Танмей Джаякумар, Джаавид Актар Хусейн, Асуант Кумар М., Мохаммед Сафир Ур Рахман Хан, Диптеш Канодзия, Ратиш Пудупулли, Митеш М. Хапра, Радж Дабре, Рудра Мурти и Аноп Кункорктан. Airavata: предложение LLM с инструкциями на хинди. Arxiv Preprint arxiv: 2401.15006, 2024.

Гиджин сын, Ханвул Ли, Сунгдонг Ким, Сейнгоне Ким, Никлас Мюеннгофф, Тэкейн Чой, Чонбок Парк, Кан Мин Ю и Стелла Бидерман. KMMLU: измерение массового многозадачного понимания языка на корейском языке. Arxiv Preprint arxiv: 2402.11548, 2024.

Неха Сенгупта, Сунил Кумар Саху, Боканг Цзя, Сатеш Катипому, Хаонан Ли, Фаджри Кото, Усама Мухаммед Афзал, Самта Камбодж, Онкар Пандит, Рахул Пал и др. JAIS и JAIS-Chat: Фонд, ориентированные на арабский язык и настраиваемые на инструкции, открытые генеративные модели крупных языков. Arxiv Preprint arxiv: 2308.16149, 2023.

Ракутен Группа, Аарон Левин, Конни Хуанг, Ченгуанг Ван, Эдуардо Батиста, Эва Шиманска, Хонги Дин, Хоу Вэй Чоу, Жан-Франсуа Пессиот, Йоханес Эффенди и др. Rakutenai-7b: расширение больших языковых моделей для японского. Arxiv Preprint arxiv: 2403.15484, 2024.

О двух платформах

Две платформы (две)-это технологический стартап, который направлен на переопределение взаимодействия человека с АИ и находится на переднем крае следующего поколения ИИ, которое является визуальным и захватывающим. Два-это строительство потребительских приложений и услуг, работающих на своих запатентованных моделях Gen-AI. Два содержит штаб -квартиру в Силиконовой долине с офисами в Сеуле и Мумбаи.

Авторы:

(1) Абхиджит Бендейл, две платформы (abhijit@two.ai);

(2) Майкл Сапенза, две платформы (michael@two.ai);

(3) Стивен Рипплингер, две платформы (steven@two.ai);

(4) Саймон Гиббс, две платформы (simon@two.ai);

(5) Jaewon Lee, две платформы (jaewon@two.ai);

(6) Пранав Мистри, две платформы (pranav@two.ai).

Эта статья есть

Оригинал