Перестаньте угадать, что делает ваш LLM - этот инструмент показывает вам все

25 июня 2025 г.Расширение возможностей разработчиков для с легкостью мониторинга, отладки и оптимизации приложений с крупной языковой моделью (LLM).

Почему я построил монитор OpenLLM

Поскольку LLM, такие как GPT-4, Llama и Mistral, становятся двигателями большего количества продуктов и исследований, управление и отладку этих сложных систем стало новой проблемой. Существующие инструменты мониторинга часто создаются для традиционных приложений-они не предлагают LLM-специфическую информацию, которые жаждут разработчиков.

Openllm Monitor родился из моих собственных болевых точек:

- Отслеживание запросов LLM и ответов на отладку

- Обнаружение галлюцинаций и быстрого дрейфа

- Понимание узких мест и задержки

- Аудит и улучшение пользовательского опыта с LLMS

Что такое монитор OpenLLM?

Openllm Monitor-это инструментарий с открытым исходным кодом, который помогает вам:

- МониторКаждая подсказка, завершение, ошибка и метрика задержки в режиме реального времени

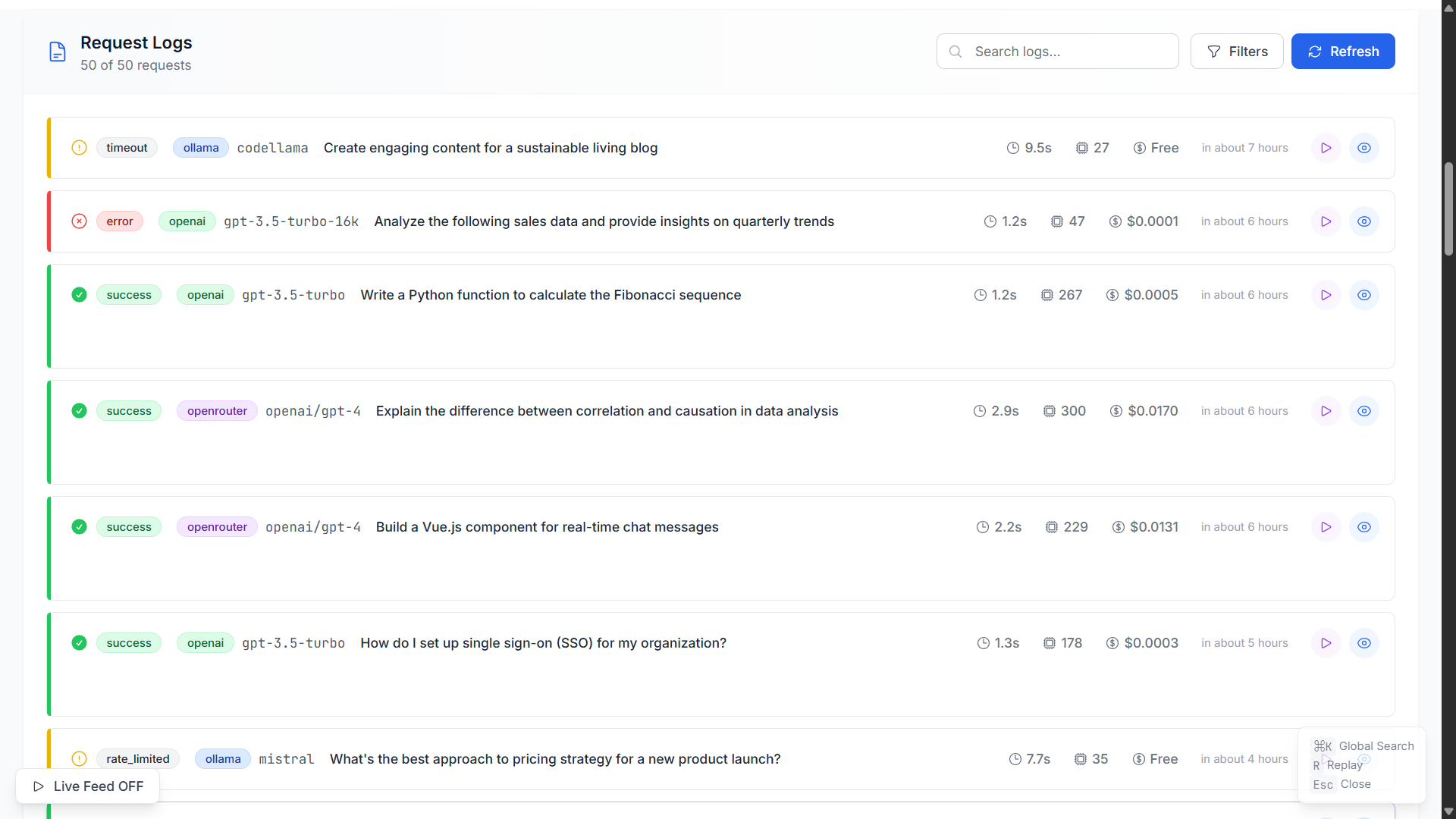

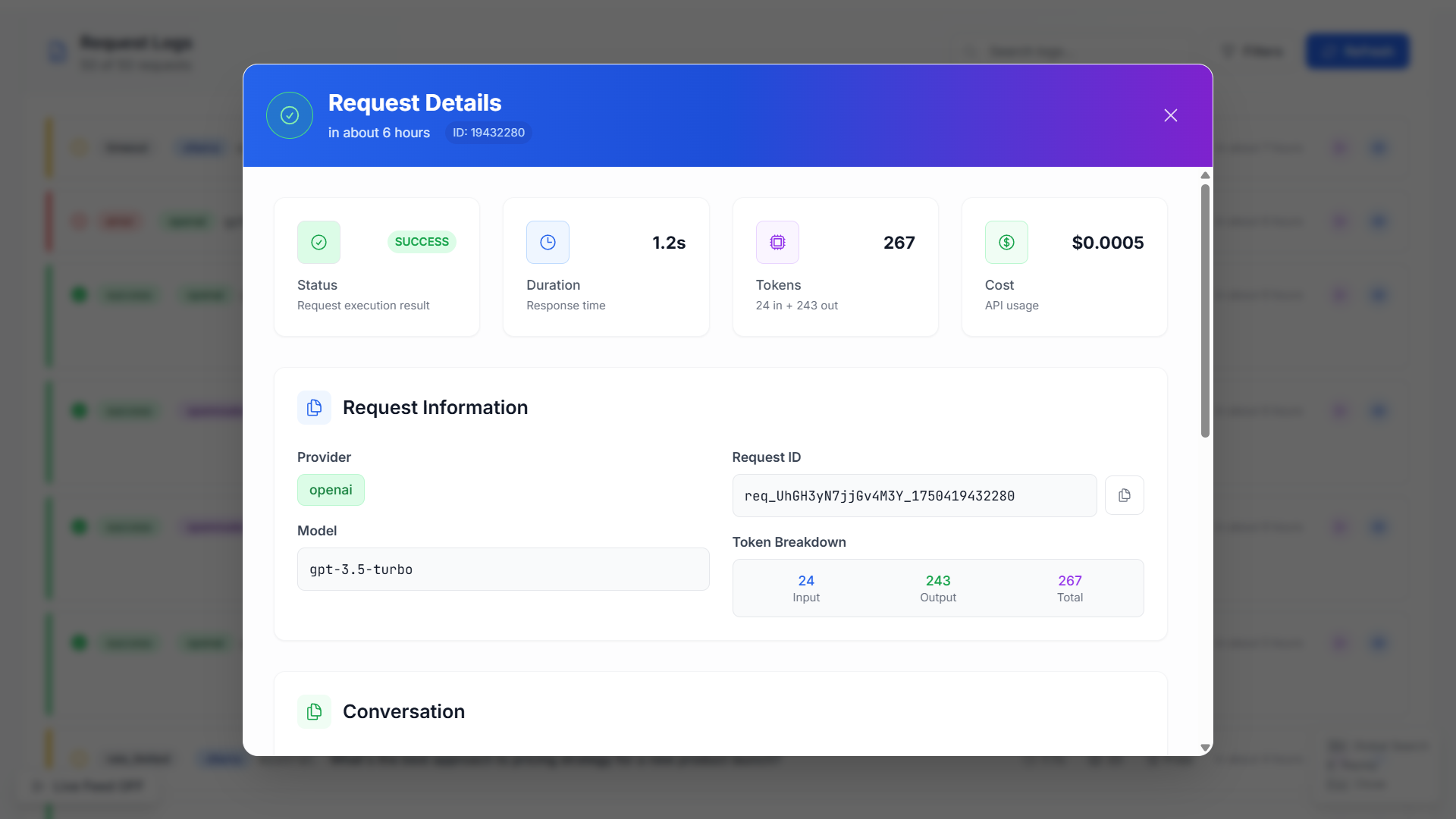

- ОтлаживатьПользовательские сеансы и поведение LLM с богатыми, контекстуальными журналами

- АнализироватьТенденции, использование и аномалии для оптимизации ваших приложений LLM

Независимо от того, являетесь ли вы инди -хакером, стартапом или командой ML Enterprise, OpenLLM Monitor делает наблюдение для LLMS максимально без трения.

Ключевые функции

- Подключить и играть SDK-Интегрируйте в любой трубопровод LLM на основе Python, Node или REST на основе REST

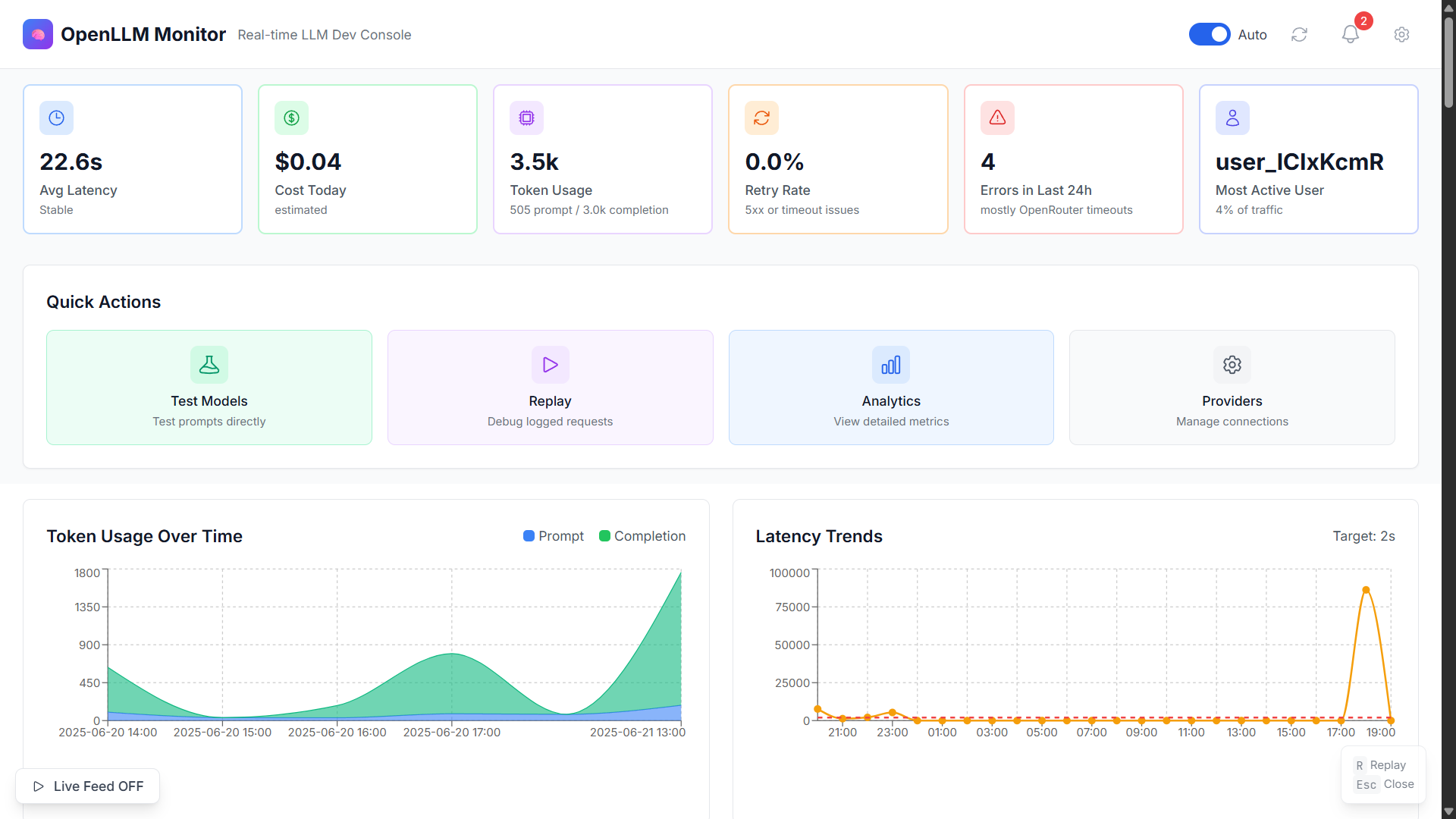

- Решетка в реальном времени- Визуализируйте потоки быстрого/ответа, частоты ошибок и KPI

- Прослеживаемые сеансы- Проверьте от сеанса пользователя до отдельных вызовов API

- Обнаружение аномалии- Предупреждение о ответах, галлюцинациях и неудачах

- Открытый исходный код-бесплатно, лицензировано MIT и расширяется. Ваши данные, ваши правила.

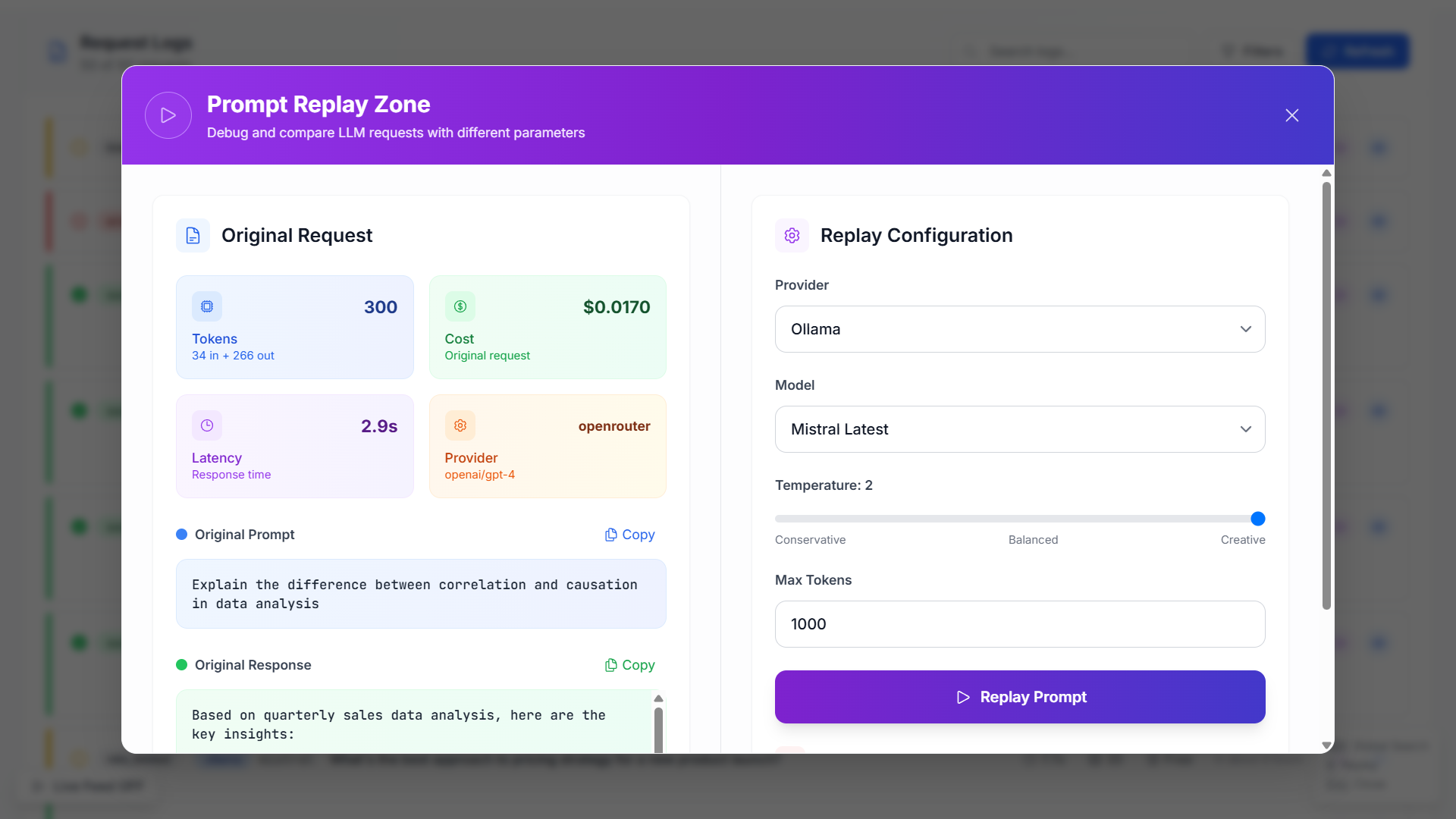

📊 Скриншоты мониторинга

Почему открытый исходный код?

Я считаю, что будущее ИИ должно быть прозрачным, заслуживающим доверия и сотрудничества. Сделав Openllm Monitor Open Source, я приглашаю вас:

- Способствовать:Предложите функции, проблемы с файлами или отправьте PRS!

- Самостоятельно:Развернуть его в собственной инфра

- Сформировать дорожную карту:Давайте построим то, что сообщество нужно больше всего

Начните

GitHub:https://github.com/prajeesh-chavan/openllm-monitor

Давайте построим вместе!

Если вы строите с LLMS, попробуйте монитор OpenLLM и дайте мне знать, что вы думаете. Я с нетерпением жду ваших отзывов, запросов функций и сотрудничества.

Star ⭐ Репо, поделитесь со своей сетью и помогите распространить информацию!

Следуйте за мной на среде иGitHubДля большего количества инструментов AI DEV и проектов с открытым исходным кодом.

Оригинал