PHI-3-Mini: 3,8B Powerhouse Reshiping LLM на вашем телефоне

5 июля 2025 г.Таблица ссылок

Аннотация и 1 введение

2 технические характеристики

3 академические тесты

4 Безопасность

5 Слабость

6 Phi-3-Vision

6.1 Технические спецификации

6.2 академические тесты

6.3 Безопасность

6.4 Слабость

Ссылки

Пример подсказки для тестов

B Авторы (алфавитный)

C подтверждения

Абстрактный

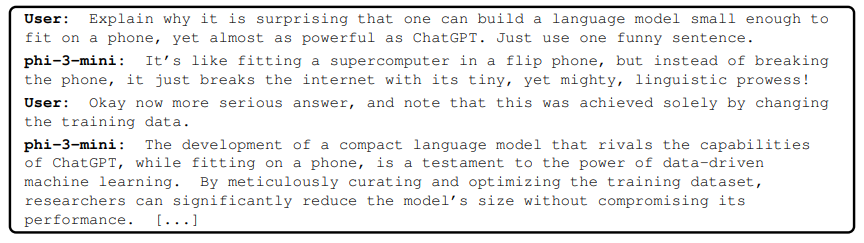

Мы вводим Phi-3-Mini, модель языка параметров 3,8 млрд. Параметров, обученная 3,3 триллионам токенов, чья общая производительность, измеряемая как по академическим показателям, так и внутренним тестированию, соперничает с такими моделями, как микстральный 8x7b и GPT-3,5 (например, Phi-3-Mini, достигнутые 69% на MML и 8,38 на Mt-Brence, несмотря на то, что он достаточно, на малос, на малосном, на маловом, на MT, на малос, на малос, на малос, на малос, на MMLE, на MT, на малосном, на малосном, на MMLE, на малосном, на малосном, на MMLE, на малосном, на MMLE, на MMLE, на малосном, на малосном, на MMLE, на малосном уровне, на малосном уровне. Инновация полностью заключается в нашем наборе данных для обучения, масштабированной версии, используемой для PHI-2, состоящей из сильно отфильтрованных общедоступных веб-данных и синтетических данных. Модель также дополнительно выровнена для надежности, безопасности и формата чата. Мы также предоставляем некоторые начальные результаты масштабирования параметров с моделями 7B и 14B, обученными для 4,8T токенов, называемых PHI-3-SMALL и PHI-3-Medium, что значительно более способно, чем PHI-3-Mini (например, соответственно 75% и 78% на MMLU и 8,7 и 8.9 на MT-Bench). Кроме того, мы также вводим Phi-3-Vision, модель параметров 4,2 миллиарда, основанная на PHI-3-Mini с сильными возможностями рассуждений для изображений и текстовых подсказок.

1 Введение

Поразительный прогресс ИИ за последние несколько лет может быть в значительной степени связан с серьезными усилиями по всему миру в отношении масштабирования до постоянных моделей и наборов данных. Большие языковые модели (LLMS) неуклонно увеличивались в размере от всего лишь миллиарда параметров всего пять лет назад (GPT-2 имел 1,5 миллиарда параметров [RWC+ 19]) до Trillion Parameters сегодня. Толчок для этих усилий возникает в казалось бы, предсказуемом улучшении, которое можно получить путем обучения крупных моделей, так называемых законов масштабирования [KMH+ 20, HBM+ 22, MRB+ 23]. Однако эти законы предполагают «фиксированный» источник данных. Это предположение в настоящее время значительно нарушено существованием самих Frontier LLM, которые позволяют нам взаимодействовать с данными новыми способами. В наших предыдущих работах по моделям PHI [GZA+ 23, LBE+ 23, JBA+ 23] было показано, что комбинация фильтрации общедоступных веб-данных на основе LLM и синтетических данных, созданных LLM, обеспечивает производительность в более мелких языковых моделях, которые обычно видели только в гораздо более крупных моделях. Например, наша предыдущая модель, обученная этому рецепту данных, PHI-2 (параметры 2,7B), соответствовала производительности моделей в 25 раз больше, обученных регулярным данным. В этом отчете мы представляем новую модель, PHI-3-Mini (3,8B Параметры), обученная для токенов 3,3T на более крупных и более продвинутых версиях наборов данных, используемых в PHI-2. С его небольшим размером, Phi-3-Mini можно легко сделать локально на современном телефоне (см. Рисунок 2), но он достигает качества, которое кажется непревзойденным с такими моделями, как Mixtral 8x7b [JSR+ 24] и GPT-3.5.

Эта статья есть

Авторы:

(1) Мара Абдин;

(2) Сэм Аде Джейкобс;

(3) Аммар Ахмад Аван;

(4) jyoti aneja;

(5) Ахмед Авадаллах;

(6) Hany Awadalla;

(7) Нгуен Бах;

(8) Амит Бахри;

(9) Араш Бахтиари;

(10) Цзянмин Бао;

(11) Харкират Бел;

(12) Алон Бенхайм;

(13) Миша Биленко;

(14) Йохан Бьорк;

(15) Sébastien Bubeck;

(16) Цин Цай;

(17) Мартин Кай;

(18) Caio César Teodoro Mendes;

(19) Вейджу Чен;

(20) Вишрав Чаудхари;

(21) Донг Чен;

(22) Дундонг Чен;

(23) Йен-Чун Чен;

(24) Йи-Линг Чен;

(25) Парул Чопра;

(26) Xiyang Dai;

(27) Элли Дель Джирно;

(28) Густаво де Роза;

(29) Мэтью Диксон;

(30) Ронен Эльдан;

(31) Виктор Фаросо;

(32) Дэн Итер;

(33) Мэй Гао;

(34) мин Гао;

(35) Цзянфенг Гао;

(36) Амит Гарг;

(37) Абхишек Госвами;

(38) Сурия Гунасекар;

(39) Эмман Хайдер;

(40) Junheng Hao;

(41) Рассел Дж. Хьюитт;

(42) Джейми Хьюнх;

(43) Mojan Javaheripi;

(44) Синь Джин;

(45) Пьеро Кауфманн;

(46) Никос Карампатцциакис;

(47) Dongwoo Kim;

(48) Махоуд Хадеми;

(49) Лев Куриленко;

(50) Джеймс Р. Ли;

(51) Инь Тэт Ли;

(52) Юаньжи Ли;

(53) Юншенг Ли;

(54) Чен Лян;

(55) Ларс Лиден;

(56) CE Liu;

(57) Менгхен Лю;

(58) Вайшунг Лю;

(59) Эрик Лин;

(60) Zeqi Lin;

(61) Чонг Луо;

(62) Пиюш Мадан;

(63) Мэтт Маццола;

(64) Ариндам Митра;

(65) Хардик Моди;

(66) ANH NGUYEN;

(67) Брэндон Норик;

(68) Барун Патра;

(69) Даниэль Перес-Бекер;

(70) Портет Томаса;

(71) Рейд Прайзант;

(72) Хейанг Цинь;

(73) Марко Радмилак;

(74) Корби Россет;

(75) Самбудха Рой;

(76) Olatunji Ruwase;

(77) Олли Саарикиви;

(78) Амин Саид;

(79) Адил Салим;

(80) Майкл Сантакрос;

(81) Шитал Шах;

(82) Нин Шан;

(83) Хитеши Шарма;

(84) Свадхин Шукла;

(85) Sia Song;

(86) Масахиро Танака;

(87) Андреа Тупини;

(88) Синь Ван;

(89) Лиджуань Ван;

(90) Чуню Ван;

(91) Ю Ван;

(92) Рэйчел Уорд;

(93) Гуанхуа Ван;

(94) Филипп Витте;

(95) haiping wu;

(96) Майкл Уайетт;

(97) бен Сяо;

(98) может XU;

(99) Цзяхан Сюй;

(100) Weijian Xu;

(101) Сонали Ядав;

(102) вентилятор Ян;

(103) Цзяньвей Ян;

(104) Зийи Ян;

(105) Йифан Ян;

(106) Донган Ю;

(107) Лу Юань;

(108) Chengruidong Zhang;

(109) Кирилл Чжан;

(110) Цзянвен Чжан;

(111) Ли Лина Чжан;

(112) И Чжан;

(113) Юэ Чжан;

(114) Юнан Чжан;

(115) Ксирен Чжоу.

Оригинал