NVIDIA объявляет о новом классе суперкомпьютеров и других услуг центра обработки данных, ориентированных на ИИ

1 июня 2023 г.28 мая на конференции COMPUTEX в Тайбэе NVIDIA анонсировала множество новых аппаратных и сетевых инструментов, многие из которых ориентированы на использование искусственного интеллекта. Новая линейка включает суперкомпьютер класса DGX GH200 с производительностью 1 экзафлопс; более 100 вариантов конфигурации системы, разработанных для помощи компаниям в удовлетворении потребностей ИИ и высокопроизводительных вычислений; модульная эталонная архитектура для ускоренных серверов; и облачная сетевая платформа, построенная на основе облаков искусственного интеллекта на базе Ethernet.

Объявления — и первое публичное выступление соучредителя и генерального директора Дженсена Хуанга с начала пандемии COVID-19 — помогли NVIDIA приблизиться к заветной рыночной капитализации в 1 триллион долларов.

Перейти к:

- Чем отличается DGX GH200 для суперкомпьютеров с искусственным интеллектом?

Новые корпоративные инструменты искусственного интеллекта от NVIDIA основаны на суперкомпьютерах

Более быстрая сеть для ИИ в облаке

Спецификация сервера MGX скоро появится

Другие новости от NVIDIA на COMPUTEX

Альтернативы суперкомпьютерным чипам NVIDIA

Чем отличается DGX GH200 для суперкомпьютеров с искусственным интеллектом?

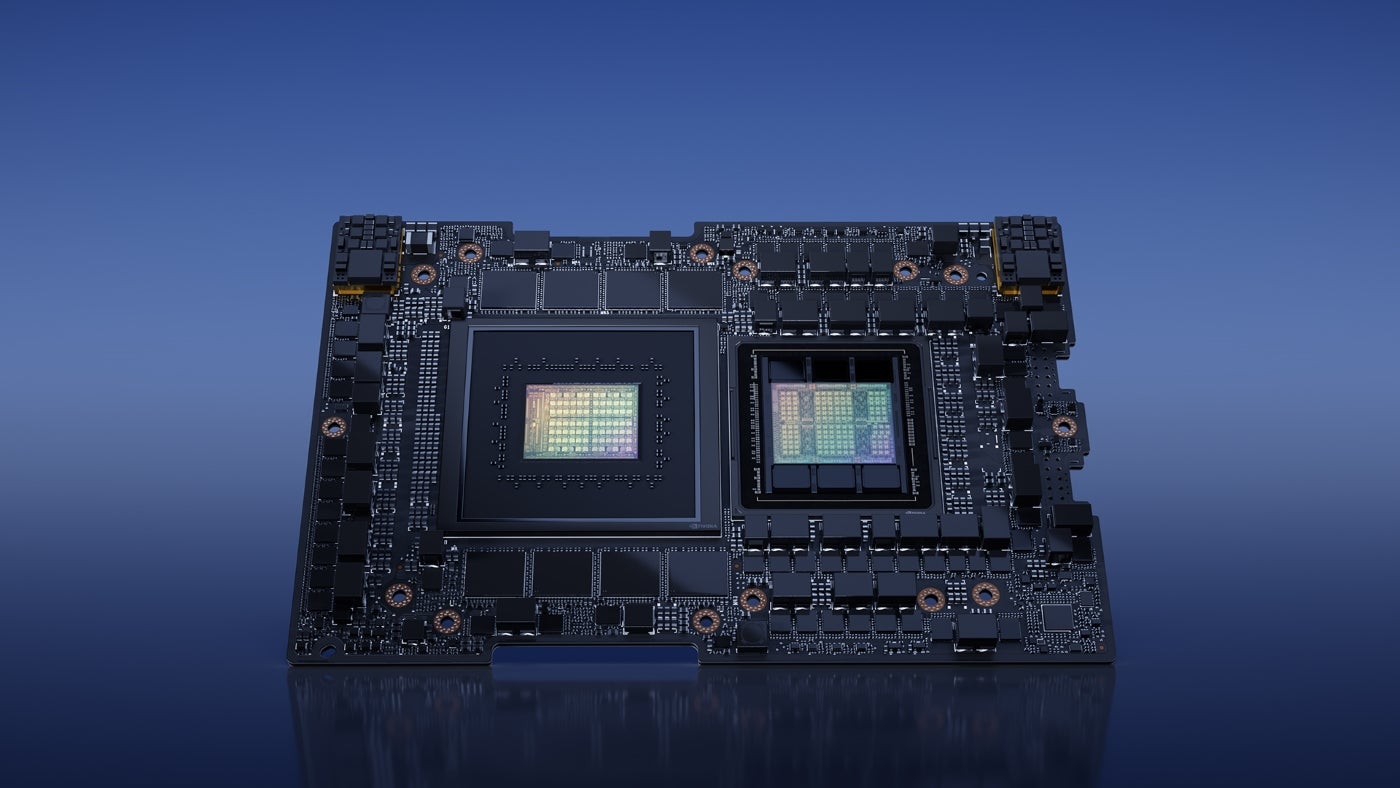

Новый класс суперкомпьютеров с искусственным интеллектом от NVIDIA использует преимущества суперчипов GH200 Grace Hopper и межсоединения NVIDIA NVLink Switch System для запуска приложений на языке генеративного искусственного интеллекта, рекомендательных систем и рабочих нагрузок по анализу данных (рис. A). Это первый продукт, в котором используются как высокопроизводительные микросхемы, так и новейшее межсоединение.

Рисунок А

Сначала NVIDIA предложит DGX GH200 Google Cloud, Meta и Microsoft. Затем он планирует предложить дизайн DGX GH200 в качестве плана поставщикам облачных услуг и другим гиперскейлерам. Ожидается, что он будет доступен к концу 2023 года.

DGX GH200 предназначен для того, чтобы организации могли запускать ИИ из своих собственных центров обработки данных. 256 суперчипов GH200 в каждом блоке обеспечивают производительность в 1 экзафлоп и 144 терабайта общей памяти.

В частности, NVIDIA объяснила, что система коммутации NVLink позволяет чипам GH200 обходить традиционное соединение PCIe между ЦП и ГП, увеличивая пропускную способность и снижая энергопотребление.

Марк Лохмейер, вице-президент по вычислениям в Google Cloud, отметил в пресс-релизе NVIDIA, что новые чипы Hopper и система коммутации NVLink могут «устранить ключевые узкие места в крупномасштабном ИИ».

«Обучение больших моделей ИИ традиционно является ресурсоемкой и трудоемкой задачей, — сказал Гириш Баблани, корпоративный вице-президент по инфраструктуре Azure в Microsoft, в пресс-релизе NVIDIA. «Возможность DGX GH200 работать с наборами данных размером в терабайт позволит разработчикам проводить расширенные исследования в большем масштабе и на более высоких скоростях».

NVIDIA также сохранит некоторые возможности суперкомпьютеров для себя; компания планирует работать над собственным суперкомпьютером под названием Helios, работающим на четырех системах DGX GH200.

Новые корпоративные инструменты искусственного интеллекта от NVIDIA основаны на суперкомпьютерах

Еще одна новая услуга, библиотека NVIDIA AI Enterprise, призвана помочь организациям получить доступ к программному уровню новых предложений ИИ. Он включает в себя более 100 фреймворков, предварительно обученных моделей и средств разработки. Они подходят для разработки и развертывания производственного ИИ, включая генеративный ИИ, компьютерное зрение, речевой ИИ и другие.

По требованию эксперты NVIDIA по ИИ смогут помочь с развертыванием и масштабированием ИИ-проектов. Это может помочь развернуть ИИ на платформах центров обработки данных от VMware и Red Hat или в системах, сертифицированных NVIDIA.

SEE: Это самые производительные суперкомпьютеры в мире.

Более быстрая сеть для ИИ в облаке

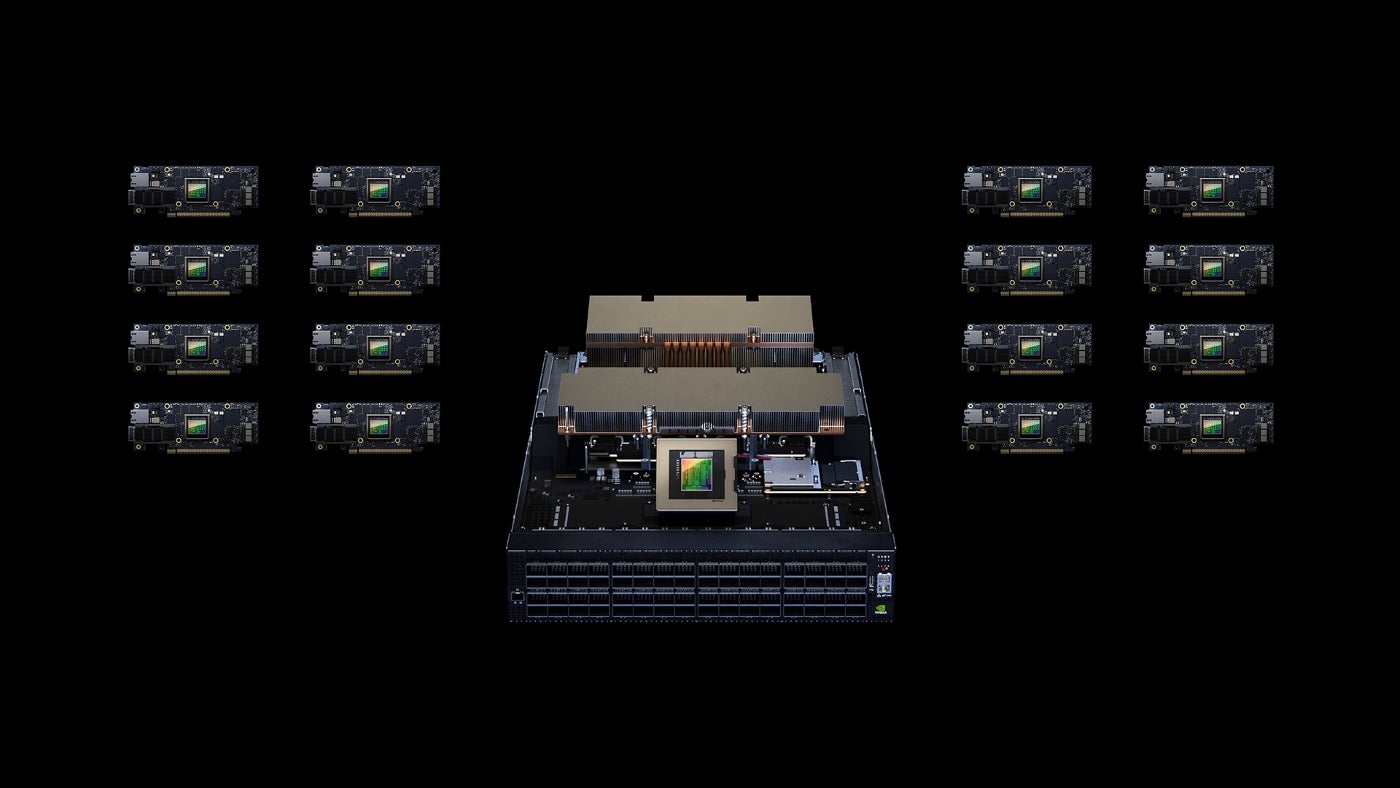

NVIDIA хочет ускорить работу облаков искусственного интеллекта на основе Ethernet с помощью ускоренной сетевой платформы Spectrum-X (рис. B).

Рисунок Б

«NVIDIA Spectrum-X — это новый класс сетей Ethernet, который устраняет барьеры для рабочих нагрузок искусственного интеллекта следующего поколения, способных преобразовать целые отрасли, — сказал Гилад Шейнер, старший вице-президент по сетевым технологиям в NVIDIA, в пресс-релизе.

Spectrum-X может поддерживать облака ИИ с 256 портами 200 Гбит/с, подключенными к одному коммутатору, или 16 000 портов в двухуровневой топологии «позвоночный-лист».

Spectrum-X делает это, используя Spectrum-4, Ethernet-коммутатор 51 Тбит/с, созданный специально для сетей ИИ. Усовершенствованные расширения RoCE, объединяющие коммутаторы Spectrum-4, DPU BlueField-3 и оптику NVIDIA LinkX, создают сквозную сеть 400GbE, оптимизированную для облаков ИИ, заявила NVIDIA.

Spectrum-X и связанные с ним продукты (коммутаторы Spectrum-4, DPU BlueField-3 и оптика 400G LinkX) доступны уже сейчас, включая интеграцию с экосистемой Dell Technologies, Lenovo и Supermicro.

Спецификация сервера MGX скоро появится

Что касается других новостей об ускорении производительности в центрах обработки данных, NVIDIA выпустила спецификацию сервера MGX. Это модульная эталонная архитектура для производителей систем, работающих над ИИ и высокопроизводительными вычислениями.

«Мы создали MGX, чтобы помочь организациям запустить корпоративный ИИ, — сказал Каустубх Сангхани, вице-президент по продуктам GPU в NVIDIA.

Производители смогут указать свои предпочтения GPU, DPU и CPU в рамках исходной базовой архитектуры системы. MGX совместим с текущими и будущими форм-факторами серверов NVIDIA, включая 1U, 2U и 4U (с воздушным или жидкостным охлаждением).

В настоящее время SoftBank работает над созданием сети центров обработки данных в Японии, которые будут использовать суперчипы GH200 и системы MGX для предоставления услуг 5G и генеративных приложений искусственного интеллекта.

QCT и Supermicro приняли MGX и выпустят его на рынок в августе.

Другие новости от NVIDIA на COMPUTEX

NVIDIA объявила о ряде других новых продуктов и услуг, основанных на работе и использовании искусственного интеллекта:

- WPP и NVIDIA Omniverse объединились, чтобы объявить о новом движке для маркетинга. Движок контента сможет генерировать видео и изображения для рекламы.

Интеллектуальная производственная платформа Metropolis for Factory позволяет создавать индивидуальные системы контроля качества и управлять ими.

Avatar Cloud Engine (ACE) для игр — это базовая служба для разработчиков видеоигр. Он позволяет анимированным персонажам обращаться к ИИ для генерации речи и анимации.

Альтернативы суперкомпьютерным чипам NVIDIA

Не так много компаний или клиентов стремятся к ИИ и супервычислительным скоростям, которые обеспечивают чипы NVIDIA Grace Hopper. Основным конкурентом NVIDIA является AMD, производящая Instinct MI300. Этот чип включает в себя ядра ЦП и ГП и, как ожидается, будет работать на суперкомпьютере El Capitan с производительностью 2 экзафлопс.

Intel предложила чип Falcon Shores, но недавно объявила, что он не будет выпускаться одновременно с процессором и графическим процессором. Вместо этого он изменил дорожную карту, чтобы сосредоточиться на искусственном интеллекте и высокопроизводительных вычислениях, но не на ядрах ЦП.

Оригинал