Новый мультимодальный трубопровод AI выравнивает восприятие Touch с большими языковыми моделями

13 июня 2025 г.Авторы:

(1) Самсон Ю, кафедра компьютерных наук, Национальный университет Сингапура (samson.yu@u.nus.edu);

(2) Кельвин Лин. Департамент компьютерных наук, Национальный университет Сингапура;

(3) с тревогой Сяо, кафедра компьютерных наук, Национальный университет Сингапура;

(4) Цзяфей Дуан, Вашингтонский университет;

(5) Гарольд Сох, кафедра компьютерных наук, Национальный университет Сингапура и Институт интеллектуальных систем NUS (harold@comp.nus.edu.sg).

Таблица ссылок

- Аннотация и I. Введение

- II Связанная работа

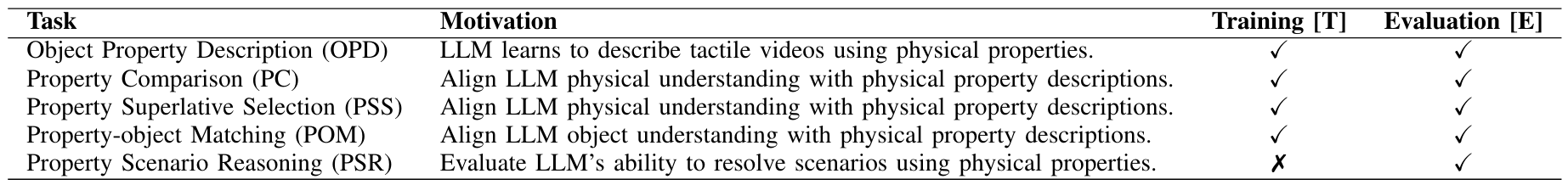

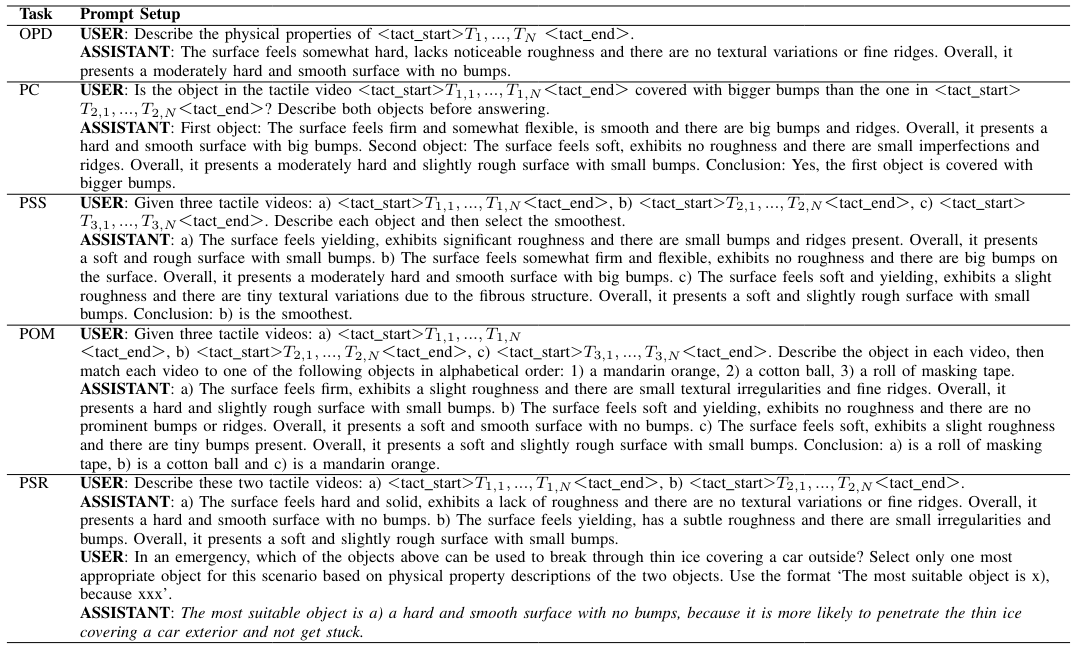

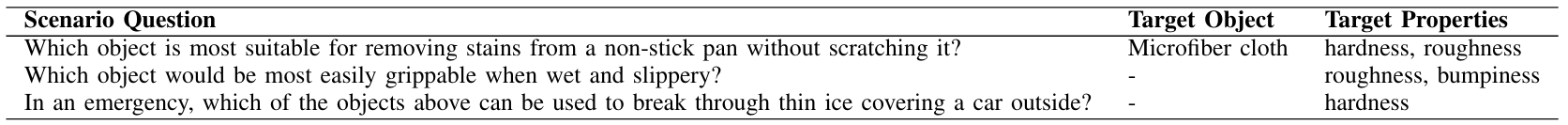

- Iii. Физиклеар - тактильное и физическое понимание обучения и оценки

- IV Осьминог-физические рассуждения с осью осьминоги

- V. Экспериментальная установка

- VI Экспериментальные результаты

- VII. Абляции

- VIII. Заключение и обсуждение, подтверждения и ссылки

- Приложение для осьминоги: рассуждения о свойстве объекта с большими моделями тактильно-языка

- Приложение A: сведения об аннотации

- Приложение B: сведения о объекте

- Приложение C: Статистика недвижимости

- Приложение D: образец статистики видео

- Приложение E: Анализ энкодера

- Приложение F: PG-Instructblip Avocado Прогнозирование имущества.

- Приложение для осьминоги: рассуждения о свойстве объекта с большими моделями тактильно-языка

IV Осьминог-физические рассуждения с осью осьминоги

Структура осьминога содержит три обученных компонента: 1) тактильный входной энкодер, 2) проекционный модуль и 3) LLM, аналогичный предыдущим моделям LVLM [34, 36, 63]. Резюме нашей общей структуры показано на рис. 3.

Мы используем возможности предварительно обученных моделей зрения, в частности, клип [39] визуального энкодера Vit-L/14 в качестве основы для нашего тактильного энкодера для получения значимых представлений признаков. Вывод энкодера затем отображается на пространство встроенного слова LLM с использованием проекционного модуля, обычно состоящего из одного или двух обучаемых слоев. В нашем проекционном модуле, вдохновленном Llava [34, 33], используется два линейных слоя с промежуточной активацией гелуя [21]. Наконец, LLM служит компонентом понимания языка в Octopi. На производительность LLM в значительной степени влияет его предварительные наборы данных. Мы используем LLM с открытым исходным кодом LLAMA, Викуна [11], признанный за свои возможности диалога.

Процесс вывода показан на рис. 3. Осьминоги получает инструкцию по оценке физических свойств

сырый рис. Текст токенизируется и подается в слое слова LLM, чтобы произвести слово [w]. Последовательность из пяти тактильных изображений обрабатывается через тактильный энкодер, причем выходные встроения отправляются в проекционный модуль для получения окончательных тактильных [t] встроенных. Недавно обученные вторжения слов, представленные и отмечают начало и окончание тактильных данных соответственно. Эти тактильные встраивания затем объединяются со словом встроения в назначенных позициях, чтобы сформировать окончательные встроенные инструкции для LLM.

Мы следуем трехступенчатой методологии обучения: (i) точная настройка энкодера, (ii) выравнивание тактильной функции и (iii) сквозная точная настройка. Далее мы опишем каждый из этих шагов более подробно.

А. Фанальница энкодера

Существующие модели LVLM снимают естественные видео в качестве ввода и могут использовать визуальный энкодер CLIP без модификации. Тем не менее, наша работа включает в себя тактильные входы на основе зрения, что отмечает значительный сдвиг распределения от естественных изображений, что требует дополнительной точной настройки для получения полезных представлений от этих входов.

Мы настраиваем наш визуальный энкодер, чтобы получить полезные представления от тактильных входов, используя многозадачную классификацию физических свойств. Мы принимаем архитектуру VIFI-CLIP [40], чтобы наш визуальный энкодер мог быть обучен на видео вход. В vificlip встроения на уровне кадров из визуального энкодера Clip среднестатистируются для получения представления уровня видео.

Затем мы добавляем обучаемые подсказки к предварительному обучению визуального энкодера Vit-L/14 после настройки визуальной приглашения (VPT) [25] и инициализируем визуальный кодер VIFI-Clip с новым визуальным энкодером. В частности, мы прикрепляем 8 специфичных для задач проведений и общего линейного слоя к входной последовательности каждого слоя трансформатора [51] в визуальном энкодере и заморозить всю предварительно обученную основную цепь трансформатора.

Наконец, мы добавляем три отдельные головы классификации в vificlip, каждая из которых предсказывает этикетку для одного свойства (то есть твердости, шероховатости или неровности) и обучаем все три классификационные головки одновременно, используя потерю поперечной энтропии. Выбирается модель, достигающая самой высокой комбинированной точности проверки - правильно предсказав все три свойства для объекта.

B. Выравнивание тактильной функции

Мы отказываемся от классификационных слоев клипа с тонкой настройкой и используем выходы из его визуального энкодера в качестве выходных вторжений. Чтобы выровнять выходные встроения из тонкого настраиваемого визуального энкодера с LLM, проекционный модуль обучается языковым аннотациям, в то время как энкодер и LLM заморожены. Мы также настраиваем встроенный слой из-за двух новых токенов слова (то есть и).

C. сквозная тонкая настройка

Наконец, мы использовали сквозную точную настройку, чтобы улучшить согласованность ответов LLM и повысить сходство между ее ответами и языковыми аннотациями. На этом этапе только визуальный энкодер заморожен, в то время как слово встраивающего слоя, проекционное модуль и LLM тонко настроены. Мы настраиваем LLM с использованием адаптации с низким уровнем ранга (LORA) [23] для параметров-эффективной тонкой настройки.

Эта статья естьДоступно на ArxivПод CC по лицензии 4.0.

Оригинал