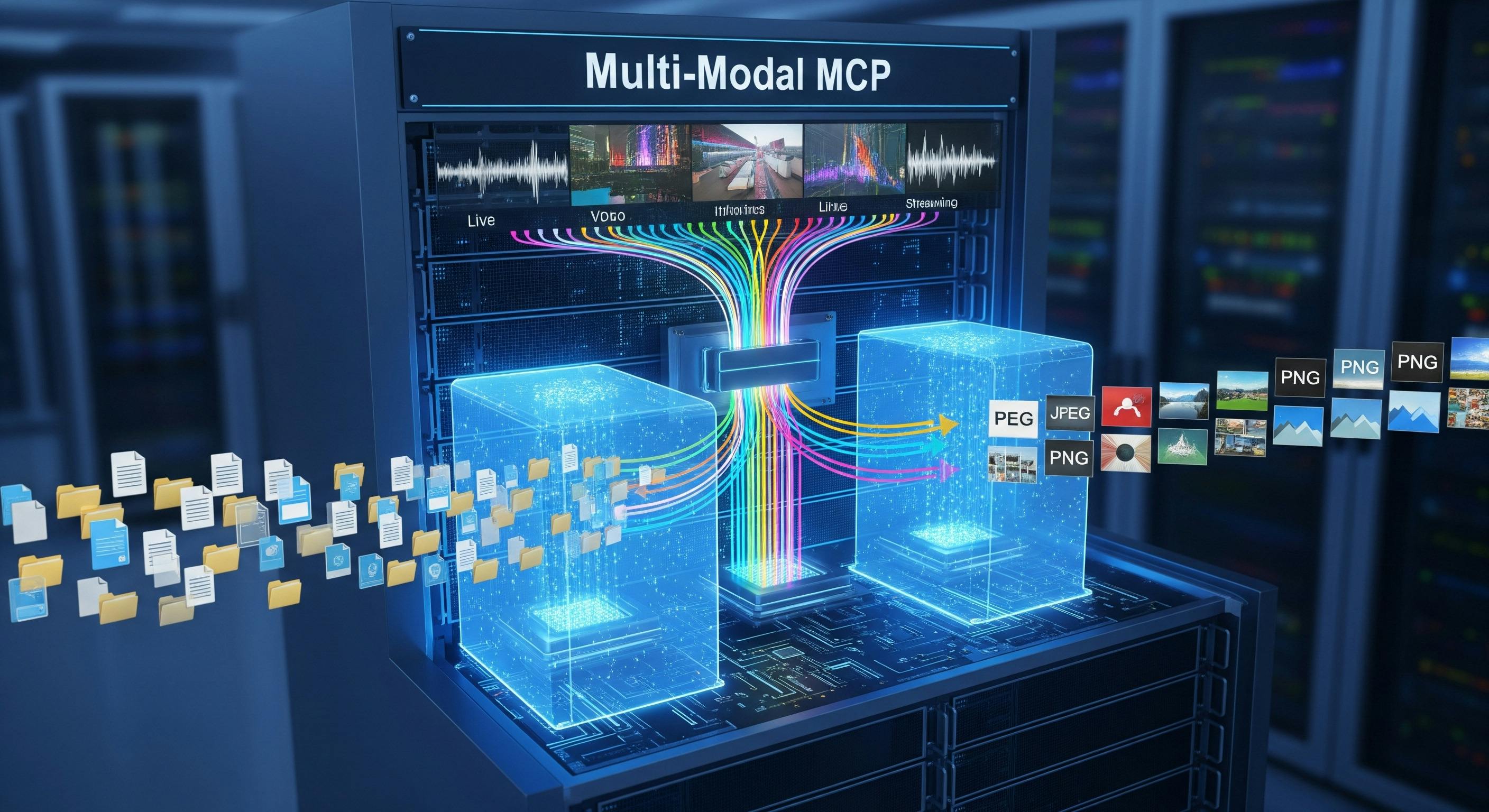

Многомодальные серверы MCP: обработка файлов, изображений и потоковых данных

18 августа 2025 г.Введение

Протокол контекста модели (MCP) представляет собой стандартизированный подход для обеспечения связи между моделями языка ИИ и внешними источниками данных посредством реализаций структурированных серверов. Текущие реализации MCP в основном фокусируются на текстовых взаимодействиях с запросом-ответом, ограничивая их применимость сценариями, требующими богатых средств массовой информации и возможностей обработки данных в реальном времени.

Растущий спрос на системы искусственного интеллекта, способный обрабатывать различные методы данных, включая двоичные файлы, данные изображений, аудиотоки и входы датчиков в реальном времени,-обеспечивает расширение архитектур сервера MCP помимо традиционных парадигм только для текста. Современные приложения требуют беспроблемной интеграции многомодальных потоков данных в рабочих процессах AI, представляя значительные технические проблемы в управлении памятью, эффективности сети и адаптации протокола.

В этой статье представлен всесторонний анализ многомодальных шаблонов реализации сервера MCP, отвечающих на технические требования для обработки загрузки файлов, обработки изображений и потоковых данных в пределах спецификации MCP. Исследование состоит из стратегий обработки, эффективных памяти, методов сетевой оптимизации и соображений безопасности производственного класса, необходимых для развертывания в масштабе предприятия.

Основной вклад этой работы включает в себя разработку архитектурных моделей для многомодальной обработки данных на серверах MCP, реализации алгоритмов потоковой передачи памяти и создание лучших практик для интеграции услуг облачного хранения с инфраструктурой MCP. Кроме того, в этой статье представлен анализ характеристик производительности в различных подходах обработки данных и представляет проверенные реализации кода, подходящие для производственных сред.

Объем этого исследования охватывает три основные области: механизмы статической обработки файлов для загрузки документов и носителей, возможности обработки изображений в режиме реального времени с интеграцией компьютерного зрения и архитектуры потоковых данных для непрерывного управления потоком данных. Каждая область рассматривает конкретные технические проблемы, включая соблюдение протокола, оптимизацию ресурсов и соображения масштабируемости.

Понимание многомодальных данных в контексте MCP

A. Типы многомодальных данных

Многомодальные данные в реализации сервера MCP включают три основные категории, каждая из которых представляет различные технические проблемы для интеграции протокола. Статические файлы представляют собой первую категорию, включая форматы документов (PDF, DOCX, TXT), файлы изображений (JPEG, PNG, TIFF), аудиозаписи (WAV, MP3, FLAC) и видеоконтент (MP4, AVI, MOV). Эти файлы обычно варьируются от килобит до гигабайт по размеру и требуют полной передачи до начала обработки.

Потоковые данные представляют вторую категорию, характеризующуюся непрерывным потоком данных, требующим возможностей обработки в реальном времени. Это включает в себя прямые видео-каналы, аудиотоки из микрофонов или сетевых источников, данные датчиков с устройств IoT и информацию о телеметрии в реальном времени. Потоковые данные представляют уникальные проблемы из-за его временного характера и требования к обработке с низкой задержкой.

Гибридный контент образует третью категорию, включая богатые документы со встроенными носителями, интерактивными презентациями и сложными структурами данных, объединяющими несколько модальностей. Эти форматы требуют специализированных возможностей анализа и часто включают извлечение и обработку отдельных компонентов отдельно при сохранении структурных отношений.

B. Проблемы в мультимодальной реализации MCP

Управление памятью представляет собой основную техническую проблему в мультимодальной реализации MCP. Крупная обработка файлов может быстро исчерпать доступную системную память, особенно когда несколько параллельных запросов включают изображения с высоким разрешением или расширенный аудио/видеоконтент. Традиционные структуры сообщений MCP, разработанные для текстовых взаимодействий, требуют тщательной адаптации для обработки двоичных данных без ущерба для стабильности системы.

Эффективность сети представляет значительные проблемы при передаче больших бинарных полезных нагрузок по каналам MCP. Формат сообщений на основе JSOL в протоколе представляет собой кодирующие накладные расходы, особенно при использовании кодирования Base64 для двоичных данных, что приводит к увеличению размера передачи примерно на 33%. Кроме того, задержка сети и ограничения полосы пропускания влияют на опыт пользователей при работе с большими переводами файлов или сценариями потоковой передачи в реальном времени.

Протоколы соблюдения требований возникают из -за исходных предположений MCP в отношении структуры сообщений и ограничений размера. Спецификация явно не учитывает обработку бинарных данных, требуя, чтобы реализователи разработали пользовательские стратегии кодирования при сохранении совместимости с существующими клиентами MCP и инфраструктурой.

Уязвимости безопасности существенно увеличиваются при обработке многомодальных данных. Загрузки файлов вводят риски, включая инъекцию вредоносных программ, атаки прохождения каталогов и истощение ресурсов через негабаритные загрузки. Библиотеки обработки изображений могут содержать уязвимостей, используемые с помощью изготовленных входных файлов, в то время как потоковые данные могут быть использованы для атак с отрицанием отказа в ходе непрерывных передач с большим объемом.

C. Обзор шаблонов архитектуры

Подходы прямого встраивания включают включение двоичных данных непосредственно в полезные нагрузки сообщения MCP с использованием схем кодирования, таких как Base64 или шестнадцатеричное представление. Этот шаблон обеспечивает обработку атомных сообщений, но вводит значительные накладные расходы с точки зрения размера сообщений и требований к обработке. Прямое встраивание оказывается подходящим для небольших файлов (обычно менее 1 МБ), где простота перевешивает проблемы с эффективностью.

Подходы на основе эталон используют механизмы внешнего хранилища, передачу только метаданные и токены доступа с помощью сообщений MCP. Двоичные данные находятся в облачных службах хранения, локальных файловых системах или специальных медиа -серверах, в то время как сообщения MCP содержат ссылки, включающие поиск. Этот шаблон оптимизирует использование сети и скорость обработки сообщений, но вводит сложность в управлении справочниками и проблемами потенциальной согласованности.

Синхронные модели обработки завершают все операции обработки данных в рамках цикла ответа на запрос, обеспечивая немедленную доступность результатов, но потенциально вызывая проблемы с тайм-аутом с большими файлами или сложными задачами обработки. Этот подход обеспечивает предсказуемое поведение и упрощенную обработку ошибок, но может не эффективно масштабироваться для ресурсов.

Асинхронные модели обработки инициируют операции обработки и немедленно возвращаются с информацией о состоянии, требуя отдельных механизмов для поиска результатов. Этот шаблон позволяет обрабатывать большие файлы и сложные рабочие процессы обработки без блокирования взаимодействий с клиентами, но вводит сложность в системах управления состояниями и результатов.

Стратегии передачи потоковой передачи постепенно обрабатывают данные по мере того, как они становятся доступными, обеспечивая обработку в реальном времени и снижение требований к памяти. Стратегии перевода отбрасывают разделяют большие файлы на управляемые сегменты, обрабатывая каждую самостоятельно, сохраняя при этом общую согласованность работы. Оба подхода требуют сложных механизмов буферизации и управления потоком для обеспечения надежной работы в различных условиях сети.

Обработка файлов на серверах MCP

Обработка файлов на серверах MCP требует тщательной интеграции возможностей обработки бинарных данных в рамках структуры сообщений на основе JSOL. Протокол контекста модели SDK предоставляет стандартизированные шаблоны для реализации файловых операций с помощью инструментов и ресурсов, обеспечивая безопасную и эффективную обработку различных типов файлов при сохранении соответствия протоколам.

A. Основная реализация загрузки файлов

Фундаментальный механизм загрузки файлов использует инструменты MCP для обработки бинарных данных Base64. Реализация расширяет класс MCP Server для обработки операций файлов с помощью зарегистрированных инструментов:

from mcp.server import Server

from mcp.types import Tool, Resource, TextContent

import base64

import hashlib

from pathlib import Path

class FileUploadMCPServer:

def __init__(self, upload_directory: Path, max_file_size: int = 50 * 1024 * 1024):

self.upload_directory = upload_directory

self.max_file_size = max_file_size

self.upload_directory.mkdir(parents=True, exist_ok=True)

self.server = Server("file-upload-server")

self._register_tools()

self._register_resources()

def _register_tools(self):

@self.server.list_tools()

async def list_tools() -> list[Tool]:

return [Tool(

name="upload_file",

description="Upload file with Base64-encoded binary content",

inputSchema={

"type": "object",

"properties": {

"file_data": {"type": "string", "description": "Base64-encoded file content"},

"filename": {"type": "string", "description": "Original filename"},

"mime_type": {"type": "string", "description": "File MIME type"}

},

"required": ["file_data", "filename"]

}

)]

@self.server.call_tool()

async def call_tool(name: str, arguments: dict):

if name == "upload_file":

result = await self._process_upload(arguments)

return [TextContent(type="text", text=str(result))]

async def _process_upload(self, args: dict) -> dict:

try:

binary_data = base64.b64decode(args["file_data"])

if len(binary_data) > self.max_file_size:

return {"status": "error", "message": "File size exceeds limit"}

file_hash = hashlib.sha256(binary_data).hexdigest()[:16]

safe_filename = f"{file_hash}_{args['filename']}"

file_path = self.upload_directory / safe_filename

file_path.write_bytes(binary_data)

return {

"status": "success",

"file_uri": f"file:///{safe_filename}",

"size": len(binary_data),

"hash": file_hash

}

except Exception as e:

return {"status": "error", "message": str(e)}

B. Управление загрузкой загрузки

Крупная обработка файлов требует механизмов переворота для предотвращения истощения памяти и обеспечения надежной передачи. Реализация загруженной загрузки управляет сеансами загрузки с помощью инструментов MCP Stateful:

from mcp.server import Server

from mcp.types import Tool, Resource, TextContent

import time

import tempfile

class ChunkedUploadServer:

def __init__(self, upload_dir: Path, chunk_size: int = 4 * 1024 * 1024):

self.upload_dir = upload_dir

self.chunk_size = chunk_size

self.active_sessions = {}

self.server = Server("chunked-upload-server")

self._register_chunked_tools()

def _register_chunked_tools(self):

@self.server.list_tools()

async def list_tools() -> list[Tool]:

return [

Tool(name="init_chunked_upload", description="Initialize chunked upload session",

inputSchema={"type": "object", "properties": {

"filename": {"type": "string"},

"total_size": {"type": "integer"},

"total_chunks": {"type": "integer"}

}, "required": ["filename", "total_chunks"]}),

Tool(name="upload_chunk", description="Upload single file chunk",

inputSchema={"type": "object", "properties": {

"session_id": {"type": "string"},

"chunk_index": {"type": "integer"},

"chunk_data": {"type": "string"}

}, "required": ["session_id", "chunk_index", "chunk_data"]}),

Tool(name="finalize_upload", description="Complete chunked upload",

inputSchema={"type": "object", "properties": {

"session_id": {"type": "string"}

}, "required": ["session_id"]})

]

@self.server.call_tool()

async def call_tool(name: str, arguments: dict):

if name == "init_chunked_upload":

session_id = hashlib.sha256(f"{arguments['filename']}{time.time()}".encode()).hexdigest()

temp_file = tempfile.NamedTemporaryFile(dir=self.upload_dir, delete=False)

self.active_sessions[session_id] = {

"filename": arguments["filename"],

"total_chunks": arguments["total_chunks"],

"received_chunks": set(),

"temp_file": temp_file.name

}

temp_file.close()

return [TextContent(type="text", text=f'{{"session_id": "{session_id}"}}')]

elif name == "upload_chunk":

return [TextContent(type="text", text=str(await self._process_chunk(arguments)))]

elif name == "finalize_upload":

return [TextContent(type="text", text=str(await self._finalize_session(arguments["session_id"])))]

async def _process_chunk(self, args: dict) -> dict:

session_id = args["session_id"]

if session_id not in self.active_sessions:

return {"status": "error", "message": "Invalid session"}

session = self.active_sessions[session_id]

chunk_data = base64.b64decode(args["chunk_data"])

with open(session["temp_file"], "r+b") as f:

f.seek(args["chunk_index"] * self.chunk_size)

f.write(chunk_data)

session["received_chunks"].add(args["chunk_index"])

remaining = session["total_chunks"] - len(session["received_chunks"])

return {"status": "chunk_received", "remaining_chunks": remaining}

async def _finalize_session(self, session_id: str) -> dict:

if session_id not in self.active_sessions:

return {"status": "error", "message": "Invalid session"}

session = self.active_sessions[session_id]

if len(session["received_chunks"]) != session["total_chunks"]:

return {"status": "error", "message": "Missing chunks"}

final_path = self.upload_dir / session["filename"]

Path(session["temp_file"]).rename(final_path)

del self.active_sessions[session_id]

return {"status": "completed", "file_uri": f"file:///{session['filename']}"}

C. Проверка файлов и интеграция хранения

Комплексная проверка файлов включает в себя обнаружение типа MIME и проверку подписи. Сервер проверки реализует проверку безопасности с помощью инструментов MCP:

from mcp.server import Server

from mcp.types import Tool, Resource, TextContent

import magic

class FileValidationServer:

ALLOWED_TYPES = {'image/jpeg', 'image/png', 'application/pdf', 'text/plain'}

def __init__(self):

self.server = Server("file-validation-server")

self._register_validation_tools()

def _register_validation_tools(self):

@self.server.call_tool()

async def call_tool(name: str, arguments: dict):

if name == "validate_file":

return [TextContent(type="text", text=str(await self._validate_file(arguments["file_uri"])))]

async def _validate_file(self, file_uri: str) -> dict:

try:

file_path = Path("uploads") / file_uri[8:] # Remove file:/// prefix

mime_type = magic.from_file(str(file_path), mime=True)

if mime_type not in self.ALLOWED_TYPES:

return {"valid": False, "reason": "Unsupported file type"}

# Signature verification

with file_path.open('rb') as f:

header = f.read(512)

if not self._verify_signature(header, mime_type):

return {"valid": False, "reason": "Invalid file signature"}

return {"valid": True, "mime_type": mime_type, "size": file_path.stat().st_size}

except Exception as e:

return {"valid": False, "reason": str(e)}

def _verify_signature(self, header: bytes, mime_type: str) -> bool:

signatures = {

'image/jpeg': b'\xff\xd8\xff',

'image/png': b'\x89PNG\r\n\x1a\n',

'application/pdf': b'%PDF-'

}

expected_sig = signatures.get(mime_type)

return header.startswith(expected_sig) if expected_sig else True

Интеграция облачного хранилища обеспечивает масштабируемое настойчивость файлов через службы S3:

from mcp.server import Server

from mcp.types import Tool, Resource, TextContent

import boto3

class S3StorageServer:

def __init__(self, bucket_name: str):

self.bucket_name = bucket_name

self.s3_client = boto3.client('s3')

self.server = Server("s3-storage-server")

self._register_storage_tools()

def _register_storage_tools(self):

@self.server.call_tool()

async def call_tool(name: str, arguments: dict):

if name == "upload_to_s3":

return [TextContent(type="text", text=str(await self._upload_to_s3(arguments)))]

async def _upload_to_s3(self, args: dict) -> dict:

try:

file_path = Path("uploads") / args["filename"]

with file_path.open('rb') as f:

self.s3_client.upload_fileobj(f, self.bucket_name, args["s3_key"])

return {

"status": "success",

"s3_uri": f"s3://{self.bucket_name}/{args['s3_key']}",

"bucket": self.bucket_name

}

except Exception as e:

return {"status": "error", "message": str(e)}

Представленные реализации демонстрируют готовые к производству шаблоны обработки файлов на серверах MCP, включая проверку безопасности, эффективную обработку памяти и масштабируемую интеграцию хранения. Эти шаблоны обеспечивают надежные операции файлов при сохранении соответствия спецификациям протокола MCP и обеспечивая интеграцию с услугами облачной инфраструктуры.

Обработка изображений на серверах MCP

A. Стратегии кодирования данных изображений

Передача данных изображения через структуру протокола контекста модели (MCP) требует тщательного рассмотрения методологий кодирования для оптимизации как производительности, так и совместимости. MCP SDK предоставляет несколько подходов для обработки данных изображения в структуре сообщений протокола, каждый из которых представляет различные преимущества и ограничения.

Кодирование Base64 представляет собой наиболее широко принятый подход для внедрения данных двоичных изображений в полезные нагрузки сообщения JSON. Этот метод кодирования обеспечивает совместимость со стандартными анализаторами JSON при сохранении целостности данных во время передачи. Тем не менее, кодирование Base64 вводит 33% накладных расходов в размере данных, что может значительно повлиять на производительность при обработке больших изображений или высокочастотных потоков изображений:

from mcp import Server, types

import base64

from typing import Optional

class ImageProcessingServer:

def __init__(self):

self.server = Server("image-processor")

async def handle_base64_image(

self,

image_data: str,

content_type: str = "image/jpeg"

) -> types.TextContent:

"""Process Base64 encoded image data."""

try:

# Decode Base64 image data

binary_data = base64.b64decode(image_data)

# Process image using decoded binary data

processed_result = await self._process_image_binary(

binary_data,

content_type

)

return types.TextContent(

type="text",

text=f"Image processed successfully. Size: {len(binary_data)} bytes"

)

except Exception as e:

return types.TextContent(

type="text",

text=f"Image processing failed: {str(e)}"

)

Двуичная обработка данных через MCP Resources обеспечивает альтернативный подход, который устраняет кодирование накладных расходов. Подход, основанный на ресурсах, обеспечивает прямую бинарную передачу при сохранении соответствия протоколам с помощью надлежащих схем URI.

Внешние эталонные шаблоны предлагают оптимальную эффективность сети, передавая только идентификаторы ресурсов, а не полные данные изображения. Эта методология оказывается особенно выгодной в распределенных системах, где хранение и обработка изображений происходят на нескольких узлах:

from mcp.server.models import InitializationOptions

import aiohttp

from pathlib import Path

class ExternalImageHandler:

def __init__(self, server: Server):

self.server = server

self.session: Optional[aiohttp.ClientSession] = None

async def initialize_session(self):

"""Initialize HTTP session for external image fetching."""

self.session = aiohttp.ClientSession()

async def fetch_external_image(self, image_uri: str) -> bytes:

"""Fetch image data from external URI."""

if not self.session:

await self.initialize_session()

async with self.session.get(image_uri) as response:

if response.status == 200:

return await response.read()

else:

raise ValueError(f"Failed to fetch image: HTTP {response.status}")

B. Обработка изображений в реальном времени

Обработка изображений в реальном времени на серверах MCP требует эффективной обработки непрерывных потоков изображений при сохранении низкой задержки и высокой пропускной способности. Асинхронная архитектура MCP SDK позволяет не блокировать операции обработки изображений, которые могут обрабатывать несколько одновременных запросов обработки изображений.

Изменение размера изображений и преобразования формата представляют собой фундаментальные операции в трубопроводах обработки изображений в реальном времени. Реализация использует библиотеку Python PIL (подушка) в сочетании с возможностями обработки сообщений MCP SDK:

from PIL import Image

import io

from mcp.types import Tool, TextContent

import asyncio

class RealTimeImageProcessor:

def __init__(self):

self.server = Server("realtime-image-processor")

self.processing_queue = asyncio.Queue(maxsize=100)

async def register_tools(self):

"""Register image processing tools with MCP server."""

resize_tool = Tool(

name="resize_image",

description="Resize image to specified dimensions",

inputSchema={

"type": "object",

"properties": {

"image_data": {"type": "string", "description": "Base64 encoded image"},

"width": {"type": "integer", "minimum": 1},

"height": {"type": "integer", "minimum": 1},

"format": {"type": "string", "enum": ["JPEG", "PNG", "WEBP"]}

},

"required": ["image_data", "width", "height"]

}

)

await self.server.register_tool(resize_tool, self.handle_resize_image)

async def handle_resize_image(self, arguments: dict) -> list[TextContent]:

"""Handle image resize operations."""

try:

# Decode image data

image_bytes = base64.b64decode(arguments["image_data"])

image = Image.open(io.BytesIO(image_bytes))

# Perform resize operation

resized_image = image.resize(

(arguments["width"], arguments["height"]),

Image.Resampling.LANCZOS

)

# Convert to specified format

output_format = arguments.get("format", "JPEG")

output_buffer = io.BytesIO()

resized_image.save(output_buffer, format=output_format)

# Encode result

result_b64 = base64.b64encode(output_buffer.getvalue()).decode('utf-8')

return [TextContent(

type="text",

text=f"Image resized successfully to {arguments['width']}x{arguments['height']}"

)]

except Exception as e:

return [TextContent(

type="text",

text=f"Image resize operation failed: {str(e)}"

)]

Возможности извлечения метаданных усиливают рабочие процессы обработки изображений, предоставляя важные характеристики изображения и встроенную информацию. Извлечение данных ESIF, размерных свойств и информация о цветовом пространстве позволяет интеллектуальную обработку решений и оптимизацию контента.

C. Обработка изображений, эффективная для памяти

Эффективность памяти представляет собой критическое соображение в системах обработки изображений, особенно при обработке больших изображений или сценариях обработки с большим объемом. MCP SDK поддерживает потоковые шаблоны обработки изображений, которые минимизируют следование памяти посредством инкрементной обработки данных.

Потоковая обработка изображений позволяет обрабатывать большие изображения без загрузки полных файлов в память. Этот подход оказывается необходимым при обработке изображений с высоким разрешением или при работе с ограничениями памяти:

import asyncio

from contextlib import asynccontextmanager

from typing import AsyncGenerator

class StreamingImageProcessor:

def __init__(self, max_memory_mb: int = 100):

self.max_memory_bytes = max_memory_mb * 1024 * 1024

self.server = Server("streaming-image-processor")

@asynccontextmanager

async def memory_bounded_processing(self):

"""Context manager for memory-bounded image processing."""

initial_memory = self._get_memory_usage()

try:

yield

finally:

# Ensure memory cleanup

current_memory = self._get_memory_usage()

if current_memory - initial_memory > self.max_memory_bytes:

await self._force_garbage_collection()

async def process_image_stream(

self,

image_stream: AsyncGenerator[bytes, None]

) -> AsyncGenerator[bytes, None]:

"""Process image data in streaming fashion."""

async with self.memory_bounded_processing():

chunk_buffer = bytearray()

async for chunk in image_stream:

chunk_buffer.extend(chunk)

# Process when buffer reaches optimal size

if len(chunk_buffer) >= 8192: # 8KB chunks

processed_chunk = await self._process_image_chunk(

bytes(chunk_buffer)

)

yield processed_chunk

chunk_buffer.clear()

# Process remaining data

if chunk_buffer:

final_chunk = await self._process_image_chunk(

bytes(chunk_buffer)

)

yield final_chunk

def _get_memory_usage(self) -> int:

"""Get current memory usage in bytes."""

import psutil

process = psutil.Process()

return process.memory_info().rss

async def _force_garbage_collection(self):

"""Force garbage collection to free memory."""

import gc

gc.collect()

await asyncio.sleep(0) # Yield control to event loop

D. Практические варианты использования

Системы анализа изображений и аннотации значительно выигрывают от структурированного протокола связи MCP. Интеграция компьютерного зрения через библиотеки, такие как OpenCV, обеспечивает сложные возможности анализа изображений на серверах MCP. Система регистрации инструментов протокола облегчает экспозицию сложных операций анализа изображений в качестве доступных инструментов.

Рабочие процессы обработки изображений партии используют асинхронные возможности MCP для обработки нескольких изображений одновременно при сохранении реагирования на систему. Реализация очередей обработки и рабочих пулов обеспечивает масштабируемые пакетные операции, которые могут адаптироваться к различным требованиям рабочей нагрузки.

Фильтрация изображений в реальном времени и обработка эффектов демонстрирует способность MCP обрабатывать интерактивные сценарии манипулирования изображениями. Характеристики связи с низкой задержкой протокола MCP позволяют отзывчивым пользовательским интерфейсам для приложений редактирования изображений, обеспечивая немедленную обратную связь для операций преобразования изображений.

Реализация потоковых данных

A. Потоковые архитектурные шаблоны

Реализация возможностей потоковых данных в рамках протокола контекста модели требует тщательного архитектурного рассмотрения для поддержания соответствия протоколам при одновременном обеспечении передачи данных в реальном времени. MCP SDK предоставляет основополагающие потоковые примитивы, которые могут быть расширены для поддержки различных шаблонов потоковой передачи, включая события, посвященные серверу, двунаправленную связь и управление обратным давлением.

Серверные события через MCP используют возможности асинхронной обработки сообщений протокола для доставки непрерывных потоков данных для клиентов. Этот шаблон оказывается особенно эффективным для сценариев, требующих однонаправленного потока данных, таких как сенсорная телеметрия, потоковая передача журнала или данные мониторинга в реальном времени. Архитектура MCP SDK, управляемая событиями, облегчает реализацию шаблонов событий сервера через систему уведомлений:

from mcp import Server, types

from mcp.server.models import InitializationOptions

import asyncio

class StreamingMCPServer:

def __init__(self):

self.server = Server("streaming-server")

self.setup_streaming_tools()

def setup_streaming_tools(self):

@self.server.call_tool()

async def start_stream(arguments: dict) -> list[types.TextContent]:

stream_id = arguments.get("stream_id")

# Use MCP notification system for streaming

await self.server.request_context.session.send_notification(

types.LoggingNotification(

level="info",

data=f"Starting stream {stream_id}"

)

)

return [types.TextContent(

type="text",

text=f"Stream {stream_id} initiated"

)]

@self.server.list_resources()

async def list_stream_resources() -> list[types.Resource]:

return [

types.Resource(

uri=f"stream://data/{i}",

name=f"Stream {i}",

mimeType="application/octet-stream"

) for i in range(5)

]

Двунаправленная потоковая передача в стиле WebSocket расширяет возможности протокола MCP для поддержки интерактивных сценариев потоковой передачи, где как клиент, так и сервер участвуют в непрерывном обмене данными. Этот шаблон обеспечивает сложные приложения в реальном времени, такие как совместное редактирование, анализ живых данных или интерактивное моделирование.

Обработка обратного давления представляет собой критический компонент надежных потоковых реализаций. Асинхронная архитектура MCP SDK обеспечивает механизмы управления потоком, которые предотвращают истощение памяти и поддерживают стабильность системы в различных условиях нагрузки. Эффективное управление обратным давлением гарантирует, что потребители, находящиеся вниз по течению, могут обрабатывать данные с устойчивыми темпами без подавляющих системных ресурсов.

B. Потоковая передача данных в реальном времени

Обработка звука в реальном времени демонстрирует практическое применение потоковых паттернов данных на серверах MCP. Аудио-потоки требуют обработки с низкой задержкой и непрерывного потока данных для поддержания приемлемого пользовательского опыта. Реализация использует потоковые возможности MCP SDK в сочетании с библиотеками обработки аудио:

from mcp import Server, types

import base64

class AudioStreamProcessor:

def __init__(self):

self.server = Server("audio-stream-processor")

self.setup_audio_tools()

def setup_audio_tools(self):

@self.server.call_tool()

async def process_audio(arguments: dict) -> list[types.TextContent | types.BlobResourceContents]:

audio_b64 = arguments.get("audio_data")

audio_bytes = base64.b64decode(audio_b64)

# Process audio and return both text analysis and processed audio

analysis = f"Processed {len(audio_bytes)} bytes of audio data"

return [

types.TextContent(type="text", text=analysis),

types.BlobResourceContents(

uri="processed://audio/output",

blob=base64.b64encode(audio_bytes).decode(),

mimeType="audio/wav"

)

]

@self.server.read_resource()

async def read_audio_buffer(uri: str) -> str | bytes:

if uri.startswith("buffer://audio/"):

# Return buffered audio data

return b"buffered_audio_data"

raise ValueError(f"Unknown audio resource: {uri}")

Трубопровод обработки в реальном времени должен иметь различные показатели прибытия данных, сохраняя при этом постоянную производительность обработки. Адаптивные стратегии буферизации обеспечивают плавную работу в разных условиях сети и обработке.

C. Буферизация и управление очередью

Эффективное управление буферами является основой надежных систем потокового данных. Круглые буферы обеспечивают эффективное использование памяти для непрерывных потоков данных, сохраняя при этом предсказуемые следы памяти. Реализация круговых буферных схем на серверах MCP обеспечивает последовательные характеристики производительности независимо от продолжительности потока.

Приоритетные очереди включают сложные сценарии обработки данных, где различные типы данных или источники требуют дифференцированной обработки. Эта возможность оказывается важной в мультимодальных потоковых приложениях, где видео, аудио и датчики и датчики требуют скоординированной обработки с различными уровнями приоритета:

from mcp import Server, types

from mcp.server.models import InitializationOptions

import asyncio

class PriorityStreamManager:

def __init__(self):

self.server = Server("priority-stream-manager")

self.setup_priority_tools()

def setup_priority_tools(self):

@self.server.call_tool()

async def enqueue_priority_data(arguments: dict) -> list[types.TextContent]:

priority = arguments.get("priority", 0)

data_uri = arguments.get("data_uri")

# Use MCP resource system for priority data

resource = types.Resource(

uri=f"priority://{priority}/{data_uri}",

name=f"Priority {priority} Data",

mimeType="application/json"

)

# Send notification about queued data

await self.server.request_context.session.send_notification(

types.LoggingNotification(

level="info",

data=f"Queued priority {priority} data: {data_uri}"

)

)

return [types.TextContent(

type="text",

text=f"Data queued with priority {priority}"

)]

@self.server.list_resources()

async def list_priority_resources() -> list[types.Resource]:

return [

types.Resource(

uri=f"priority://{p}/stream",

name=f"Priority {p} Stream",

mimeType="application/octet-stream"

) for p in [1, 2, 3]

]

Применение границ памяти предотвращает неограниченный рост памяти в длительных потоковых приложениях. Механизмы обработки переполнения обеспечивают изящную деградацию при превышении обработки, поддерживая стабильность системы при сохранении критической целостности данных.

D. Оптимизация производительности

Асинхронные шаблоны обработки максимизируют пропускную способность в приложениях потоковых данных, обеспечивая одновременную обработку нескольких потоков данных. Поддержка MCP SDK Async/Await облегчает неблокирующие операции ввода-вывода, которые эффективно масштабируются с увеличением количества потоков.

Стратегии объединения соединений оптимизируют использование ресурсов при обработке нескольких одновременных потоков. Эффективное управление соединением снижает накладные расходы и улучшает реакцию системы, особенно в сценариях, включающих многочисленные кратковременные потоковые соединения.

Механизмы очистки ресурсов обеспечивают надлежащую утилизацию системных ресурсов при прекращении потоков. Оптимизация сбора мусора предотвращает утечки памяти и поддерживает постоянную производительность в течение расширенных периодов работы:

from mcp import Server, types

from mcp.server.models import InitializationOptions

class OptimizedStreamProcessor:

def __init__(self):

self.server = Server("optimized-stream-processor")

self.setup_optimized_streaming()

def setup_optimized_streaming(self):

@self.server.call_tool()

async def manage_stream_resources(arguments: dict) -> list[types.TextContent]:

operation = arguments.get("operation")

stream_id = arguments.get("stream_id")

if operation == "start":

# Create MCP resource for stream

resource_uri = f"stream://managed/{stream_id}"

await self.server.request_context.session.send_notification(

types.ProgressNotification(

progressToken=stream_id,

progress=0,

total=100

)

)

return [types.TextContent(

type="text",

text=f"Managed stream {stream_id} started at {resource_uri}"

)]

elif operation == "cleanup":

# Cleanup stream resources

await self.server.request_context.session.send_notification(

types.LoggingNotification(

level="info",

data=f"Cleaning up stream {stream_id}"

)

)

return [types.TextContent(

type="text",

text=f"Stream {stream_id} cleaned up"

)]

@self.server.read_resource()

async def read_stream_resource(uri: str) -> str | bytes:

if uri.startswith("stream://managed/"):

stream_id = uri.split("/")[-1]

return f"Stream data for {stream_id}".encode()

raise ValueError(f"Unknown stream resource: {uri}")

E. Усовершенствованные сценарии потоковой передачи

Возможности для вещания с несколькими клиентами обеспечивают эффективные модели распределения данных от одного ко многим. Архитектура MCP SDK поддерживает сценарии потоковой передачи, где источники данных обслуживают несколько потребляющих клиентов одновременно. Этот шаблон оказывается необходимым для приложений в режиме реального времени, живого мониторинга данных и совместных сред.

Агрегация потока из нескольких источников представляет сложные координационные проблемы, которые требуют сложных стратегий буферизации и синхронизации. Выравнивание на основе времени обеспечивает когерентное представление данных при сочетании потоков с различными характеристиками и моделями прибытия.

Аналитика в реальном времени на потоковых данных демонстрирует интеграцию обработки трубопроводов с непрерывными потоками данных. Статистический анализ, обнаружение тенденций и идентификация аномалии могут быть выполнены на потоковых данных без прерывания первичного потока данных. Реализация использует методы скользящего окна и постепенные методы вычисления для поддержания низкой задержки, предоставляя значимые аналитические идеи.

Обработка краев для прерывания потока, повторного подключения и восстановления данных обеспечивает надежную работу в производственных средах. Механизмы устойчивости к неисправности поддерживают целостность данных и доступность услуг, несмотря на перерывы в сети или сбои обработки.

Реализация потоковых данных на серверах MCP требует тщательного баланса между эффективностью, надежностью и эффективностью ресурсов. Правильный дизайн архитектуры позволяет масштабируемые потоковые решения, которые могут адаптироваться к различным требованиям рабочей нагрузки при сохранении постоянного качества обслуживания.

Управление памятью и производительность

А. Память памяти

Эффективность памяти на многомодальных серверах MCP требует стратегической реализации моделей обработки данных, которые минимизируют потребление ресурсов при сохранении соответствия протоколам.

Ленивые стратегии загрузки на серверах MCP позволяют инициализации отложенного ресурса до тех пор, пока не произойдет фактический доступ к данным. Этот подход оказывается особенно эффективным при обработке больших файлов или наборов данных, где для обработки могут потребоваться только части данных. Система ресурсов MCP облегчает ленивую загрузку с помощью ссылок на ресурсы на основе URI, которые могут быть разрешены по требованию:

from mcp import Server, types

from mcp.server.models import InitializationOptions

import weakref

class LazyLoadingMCPServer:

def __init__(self):

self.server = Server("lazy-loading-server")

self.resource_cache = weakref.WeakValueDictionary()

self.setup_lazy_resources()

def setup_lazy_resources(self):

@self.server.list_resources()

async def list_lazy_resources() -> list[types.Resource]:

return [

types.Resource(

uri=f"lazy://dataset/{i}",

name=f"Dataset {i}",

mimeType="application/octet-stream"

) for i in range(1000) # Large dataset count

]

@self.server.read_resource()

async def read_lazy_resource(uri: str) -> str | bytes:

# Check cache first

if uri in self.resource_cache:

return self.resource_cache[uri]

# Load only when requested

if uri.startswith("lazy://dataset/"):

dataset_id = uri.split("/")[-1]

data = await self._load_dataset_chunk(dataset_id)

self.resource_cache[uri] = data

return data

raise ValueError(f"Unknown lazy resource: {uri}")

async def _load_dataset_chunk(self, dataset_id: str) -> bytes:

# Simulate loading large dataset chunk

return f"Dataset chunk {dataset_id} data".encode()

Паттерны генератора обеспечивают эффективную обработку больших наборов данных путем получения данных постепенно, а не загружая полные наборы данных в память. Потоковые возможности протокола MCP поддерживают обработку данных на основе генератора с помощью шаблонов доступа на основе ресурсов, которые поддерживают низкие следов памяти.

Методы картирования памяти для очень больших файлов обеспечивают повышение эффективности эффективности работы на уровне операционной системы, которые снижают требования к памяти приложения. При интеграции с обработкой ресурсов MCP файлы отображения памяти позволяют эффективно доступ к крупным наборам данных без явных накладных расходов на управление памятью.

Б. Мониторинг ресурсов

Эффективный мониторинг ресурсов является основой оптимизации производительности на производственных серверах MCP. Реализация возможностей мониторинга требует интеграции с сбором метрик на уровне системы при сохранении соответствия протоколам MCP. Отслеживание использования памяти, профилирование производительности и анализ использования ресурсов дает важную информацию для усилий по оптимизации.

Интеграция мониторинга памяти на серверах MCP позволяет отслеживать шаблоны потребления ресурсов в реальном времени. Система мониторинга может использовать систему уведомлений MCP для предоставления непрерывных обновлений использования памяти и характеристик производительности:

from mcp import Server, types

import psutil

import asyncio

from contextlib import asynccontextmanager

class MonitoredMCPServer:

def __init__(self):

self.server = Server("monitored-server")

self.monitoring_enabled = True

self.setup_monitoring_tools()

def setup_monitoring_tools(self):

@self.server.call_tool()

async def get_memory_stats(arguments: dict) -> list[types.TextContent]:

process = psutil.Process()

memory_info = process.memory_info()

stats = {

"rss_mb": memory_info.rss / 1024 / 1024,

"vms_mb": memory_info.vms / 1024 / 1024,

"percent": process.memory_percent()

}

return [types.TextContent(

type="text",

text=f"Memory usage: RSS={stats['rss_mb']:.1f}MB, "

f"VMS={stats['vms_mb']:.1f}MB, "

f"Percent={stats['percent']:.1f}%"

)]

@self.server.call_tool()

async def start_memory_monitoring(arguments: dict) -> list[types.TextContent]:

interval = arguments.get("interval", 5)

asyncio.create_task(self._memory_monitoring_loop(interval))

return [types.TextContent(

type="text",

text=f"Memory monitoring started with {interval}s interval"

)]

async def _memory_monitoring_loop(self, interval: int):

while self.monitoring_enabled:

process = psutil.Process()

memory_mb = process.memory_info().rss / 1024 / 1024

if memory_mb > 500: # Alert threshold

await self.server.request_context.session.send_notification(

types.LoggingNotification(

level="warning",

data=f"High memory usage detected: {memory_mb:.1f}MB"

)

)

await asyncio.sleep(interval)

Возможности профилирования производительности позволяют определить узкие места и возможности оптимизации в реализациях сервера MCP. Сбор данных профилирования может быть интегрирован с системой инструментов MCP для обеспечения анализа и отчетности по требованию.

C. Производительность

Производительность производительности на серверах MCP требует всестороннего измерения пропускной способности, задержки и использования ресурсов в разных операционных сценариях. Система сравнительного анализа должна учитывать накладные расходы протокола MCP, обеспечивая значимые показатели эффективности для руководства оптимизации.

Системы сбора метрик собирают данные производительности в нескольких измерениях, включая время обработки запросов, шаблоны распределения памяти и использование сети. Интеграция сбора метрик с системой уведомлений MCP обеспечивает возможности мониторинга производительности и оповещения в режиме реального времени.

Стратегии тестирования нагрузки подтверждают производительность сервера MCP в реалистичных условиях эксплуатации. Структура тестирования должна моделировать различные модели взаимодействия клиента при измерении характеристик отклика системы и шаблонов потребления ресурсов:

from mcp import Server, types

import time

import statistics

from collections import defaultdict

class BenchmarkingMCPServer:

def __init__(self):

self.server = Server("benchmarking-server")

self.metrics = defaultdict(list)

self.setup_benchmarking_tools()

def setup_benchmarking_tools(self):

@self.server.call_tool()

async def run_benchmark(arguments: dict) -> list[types.TextContent]:

test_type = arguments.get("test_type", "latency")

iterations = arguments.get("iterations", 100)

if test_type == "latency":

results = await self._benchmark_latency(iterations)

elif test_type == "throughput":

results = await self._benchmark_throughput(iterations)

else:

raise ValueError(f"Unknown benchmark type: {test_type}")

return [types.TextContent(

type="text",

text=f"Benchmark results: {results}"

)]

@self.server.call_tool()

async def get_performance_report(arguments: dict) -> list[types.TextContent]:

report = await self._generate_performance_report()

return [types.TextContent(

type="text",

text=report

)]

async def _benchmark_latency(self, iterations: int) -> dict:

latencies = []

for _ in range(iterations):

start_time = time.perf_counter()

# Simulate processing operation

await asyncio.sleep(0.001) # 1ms simulated work

end_time = time.perf_counter()

latencies.append((end_time - start_time) * 1000) # Convert to ms

return {

"mean_ms": statistics.mean(latencies),

"median_ms": statistics.median(latencies),

"p95_ms": statistics.quantiles(latencies, n=20)[18], # 95th percentile

"min_ms": min(latencies),

"max_ms": max(latencies)

}

async def _benchmark_throughput(self, iterations: int) -> dict:

start_time = time.perf_counter()

# Process multiple operations concurrently

tasks = [self._simulate_processing() for _ in range(iterations)]

await asyncio.gather(*tasks)

end_time = time.perf_counter()

total_time = end_time - start_time

return {

"operations_per_second": iterations / total_time,

"total_time_seconds": total_time,

"operations_completed": iterations

}

async def _simulate_processing(self):

# Simulate typical MCP server processing

await asyncio.sleep(0.005) # 5ms simulated work

Инструменты идентификации узкого места анализируют данные о производительности, чтобы выделить возможности оптимизации. Эти инструменты интегрируются с системой ресурсов MCP для предоставления подробного анализа характеристик производительности системы и моделей использования ресурсов.

D. Соображения масштабирования

Горизонтальные шаблоны масштабирования позволяют серверам MCP распределять загрузку обработки по нескольким экземплярам сервера при сохранении согласованности протокола. Реализация стратегий балансировки нагрузки требует тщательного рассмотрения государственных операций и моделей обмена ресурсами, присущими многомодальным сценариям обработки данных.

Стратегии балансировки нагрузки должны учитывать государственный характер многих многомодальных операций обработки. Аффинность сеанса, последовательная маршрутизация ресурсов и распределенные стратегии кэширования обеспечивают правильное масштабирование работы при сохранении согласованности данных и непрерывности обработки.

Политики распределения ресурсов определяют, как распределяются вычислительные ресурсы среди одновременных операций обработки. Динамическое распределение ресурсов на основе характеристик рабочей нагрузки и уровней приоритетов оптимизирует использование системы при сохранении качества гарантий обслуживания.

Архитектура масштабирования должна иметь различные модели рабочей нагрузки, типичные для мультимодальных приложений, включая требования к обработке взрыва, устойчивые высокопроизводительные сценарии и ресурсные операции. Политики адаптивного масштабирования реагируют на изменение модели спроса при сохранении эффективности экономии и целевых показателей производительности.

Распределенные архитектуры сервера MCP требуют координационных механизмов, которые поддерживают соответствие протоколам в рамках нескольких экземпляров сервера. Обнаружение сервиса, управление конфигурацией и паттерны взаимосвязи между серверной связью обеспечивают беспрепятственное масштабирование при сохранении простоты и характеристик надежности протокола MCP.

Оптимизация производительности на многомодальных серверах MCP требует всестороннего понимания моделей управления памятью, характеристик использования ресурсов и требований масштабирования. Интеграция методов мониторинга, сравнительного анализа и оптимизации в рамках MCP позволяет разработать высокопроизводительные системы, которые могут эффективно обрабатывать сложные многомодальные рабочие нагрузки обработки данных при сохранении принципов проектирования протокола и надежности.

Безопасность и проверка данных

A. Проверка файла

Проверка файлов представляет собой критический компонент безопасности на многомодальных серверах MCP, что требует всесторонней проверки загруженного контента до начала операций обработки. MCP SDK предоставляет механизмы для реализации надежных конвейеров валидации, которые обеспечивают целостность данных, предотвращая при этом вредоносное содержание с компрометирования безопасности системы.

Проверка типа файла представляет собой основной защитный механизм против атак на основе контента. Реализация проверки подписи файла, проверки типа MIME и анализа контента гарантирует, что загруженные файлы соответствуют ожидаемым форматам. Система управления ресурсами протокола MCP облегчает проверку безопасности с помощью контролируемых шаблонов доступа к ресурсам:

from mcp import Server, types

import magic

import hashlib

from pathlib import Path

class SecureFileValidator:

def __init__(self):

self.server = Server("secure-file-validator")

self.allowed_mime_types = {

'image/jpeg', 'image/png', 'image/gif', 'image/webp',

'audio/wav', 'audio/mp3', 'video/mp4', 'application/pdf'

}

self.max_file_size = 100 * 1024 * 1024 # 100MB limit

self.setup_validation_tools()

def setup_validation_tools(self):

@self.server.call_tool()

async def validate_file(arguments: dict) -> list[types.TextContent]:

file_uri = arguments.get("file_uri")

expected_type = arguments.get("expected_type")

validation_result = await self._comprehensive_file_validation(

file_uri, expected_type

)

if validation_result["valid"]:

return [types.TextContent(

type="text",

text=f"File validation passed: {validation_result['details']}"

)]

else:

await self.server.request_context.session.send_notification(

types.LoggingNotification(

level="error",

data=f"File validation failed: {validation_result['error']}"

)

)

return [types.TextContent(

type="text",

text=f"File validation failed: {validation_result['error']}"

)]

@self.server.read_resource()

async def read_validated_file(uri: str) -> str | bytes:

if not uri.startswith("validated://"):

raise ValueError("Access denied: file not validated")

# Extract original URI and verify validation status

original_uri = uri.replace("validated://", "")

if await self._is_file_validated(original_uri):

return await self._read_secure_file(original_uri)

else:

raise ValueError("Access denied: file validation required")

async def _comprehensive_file_validation(self, file_uri: str, expected_type: str) -> dict:

try:

# File size validation

file_size = await self._get_file_size(file_uri)

if file_size > self.max_file_size:

return {

"valid": False,

"error": f"File size {file_size} exceeds limit {self.max_file_size}"

}

# MIME type validation using magic bytes

file_content = await self._read_file_header(file_uri, 2048)

detected_mime = magic.from_buffer(file_content, mime=True)

if detected_mime not in self.allowed_mime_types:

return {

"valid": False,

"error": f"MIME type {detected_mime} not allowed"

}

if expected_type and detected_mime != expected_type:

return {

"valid": False,

"error": f"MIME type mismatch: expected {expected_type}, got {detected_mime}"

}

# Content hash validation

file_hash = await self._calculate_file_hash(file_uri)

return {

"valid": True,

"details": f"Type: {detected_mime}, Size: {file_size}, Hash: {file_hash[:16]}"

}

except Exception as e:

return {

"valid": False,

"error": f"Validation error: {str(e)}"

}

Пределы размера и квоты предотвращают атаки истощения ресурсов при сохранении стабильности системы в различных условиях нагрузки. Реализация прогрессивной проверки размера в процессах загрузки файлов позволяет досрочно завершить негабаритные трансферы, минимизировать потребление ресурсов и улучшая реакцию системы.

Интеграция сканирования вредоносных программ обеспечивает расширенные возможности обнаружения угроз посредством интеграции с внешними службами безопасности. Архитектура сервера MCP обеспечивает модульную интеграцию сканирующих двигателей, сохраняя при этом соответствие протокола и эффективность работы.

Процессы дезинфекции контента удаляют потенциально вредные элементы из загруженных файлов при сохранении законной целостности данных. Стратегии дезинфицирования варьируются в зависимости от типа файла, но последовательно сосредотачиваются на устранении исполняемого контента, векторах впрыска скриптов и метаданных, которые могут поставить под угрозу безопасность системы.

B. Контроль доступа

Механизмы управления доступом в серверах MCP требуют структуры аутентификации и авторизации, которые плавно интегрируются с системами управления инструментом и ресурсами протокола. Реализация контроля доступа на основе ролей позволяет мелкозернистому управлению разрешениями при сохранении простоты работы.

Образцы аутентификации для операций с файлами используют возможности управления сеансами MCP для создания и поддержания безопасных идентификаторов клиентов. Аутентификация на основе токков, проверка сертификатов и управление жизненным циклом сеанса убедитесь, что только авторизованные клиенты могут получить доступ к возможностям обработки конфиденциальных файлов:

from mcp import Server, types

import jwt

import time

from typing import Optional

class SecureAccessMCPServer:

def __init__(self, secret_key: str):

self.server = Server("secure-access-server")

self.secret_key = secret_key

self.active_sessions = {}

self.setup_security_tools()

def setup_security_tools(self):

@self.server.call_tool()

async def authenticate_client(arguments: dict) -> list[types.TextContent]:

username = arguments.get("username")

credentials = arguments.get("credentials")

if await self._validate_credentials(username, credentials):

session_token = await self._create_session_token(username)

return [types.TextContent(

type="text",

text=f"Authentication successful. Session token: {session_token}"

)]

else:

await self.server.request_context.session.send_notification(

types.LoggingNotification(

level="warning",

data=f"Authentication failed for user: {username}"

)

)

return [types.TextContent(

type="text",

text="Authentication failed"

)]

@self.server.call_tool()

async def access_protected_resource(arguments: dict) -> list[types.TextContent]:

session_token = arguments.get("session_token")

resource_path = arguments.get("resource_path")

operation = arguments.get("operation", "read")

if not await self._verify_session_token(session_token):

return [types.TextContent(

type="text",

text="Access denied: invalid session token"

)]

username = await self._get_username_from_token(session_token)

if not await self._check_resource_permission(username, resource_path, operation):

await self._log_access_attempt(username, resource_path, operation, False)

return [types.TextContent(

type="text",

text=f"Access denied: insufficient permissions for {operation} on {resource_path}"

)]

await self._log_access_attempt(username, resource_path, operation, True)

return [types.TextContent(

type="text",

text=f"Access granted for {operation} on {resource_path}"

)]

async def _create_session_token(self, username: str) -> str:

payload = {

'username': username,

'iat': time.time(),

'exp': time.time() + 3600 # 1 hour expiration

}

token = jwt.encode(payload, self.secret_key, algorithm='HS256')

self.active_sessions[token] = username

return token

async def _verify_session_token(self, token: str) -> bool:

try:

payload = jwt.decode(token, self.secret_key, algorithms=['HS256'])

return token in self.active_sessions and payload['exp'] > time.time()

except jwt.InvalidTokenError:

return False

async def _log_access_attempt(self, username: str, resource: str, operation: str, success: bool):

status = "SUCCESS" if success else "DENIED"

await self.server.request_context.session.send_notification(

types.LoggingNotification(

level="info",

data=f"Access {status}: {username} attempted {operation} on {resource}"

)

)

Паттерны авторизации реализуют контроль доступа на основе ролей, который отображает идентификации пользователей с конкретными разрешениями на эксплуатацию. Система авторизации интегрируется с механизмом регистрации инструментов MCP для обеспечения соблюдения ограничений доступа на уровне протокола, гарантируя, что несанкционированные клиенты не могут вызывать ограниченные операции.

Регистрация аудита отражает комплексные модели доступа и события безопасности для соответствия и судебно -медицинской экспертизы. Система регистрации использует структуру уведомлений MCP для обеспечения отчетности о событиях безопасности в реальном времени, сохраняя при этом подробные исторические записи для анализа безопасности.

C. Конфиденциальность данных

Соображения конфиденциальности данных на многомодальных серверах MCP включают требования к шифрованию, личную обработку информации и структуры соответствия нормативным требованиям. Реализация механизмов, сохраняющих конфиденциальность, гарантирует, что конфиденциальные данные остаются защищенными на протяжении всего конвейера обработки при сохранении операционной эффективности.

Стратегии шифрования защищают данные как в состоянии покоя, так и в пути, внедряя стандартные криптографические протоколы отрасли, которые защищают конфиденциальную информацию. Двуичные возможности обработки данных протокола MCP поддерживают зашифрованную передачу данных без ущерба для эффективности протокола или совместимости.

Лично идентифицируемая информация (PII) Системы обнаружения автоматически идентифицируют и классифицируют конфиденциальные элементы данных в загруженном контенте. Автоматическое обнаружение PII обеспечивает соответствующие процедуры обработки и соответствовать правилам защиты данных:

from mcp import Server, types

import re

from cryptography.fernet import Fernet

class PrivacyProtectedMCPServer:

def __init__(self):

self.server = Server("privacy-protected-server")

self.encryption_key = Fernet.generate_key()

self.fernet = Fernet(self.encryption_key)

self.pii_patterns = {

'ssn': re.compile(r'\b\d{3}-\d{2}-\d{4}\b'),

'email': re.compile(r'\b[A-Za-z0-9._%+-]+@[A-Za-z0-9.-]+\.[A-Z|a-z]{2,}\b'),

'phone': re.compile(r'\b\d{3}-\d{3}-\d{4}\b'),

'credit_card': re.compile(r'\b\d{4}[-\s]?\d{4}[-\s]?\d{4}[-\s]?\d{4}\b')

}

self.setup_privacy_tools()

def setup_privacy_tools(self):

@self.server.call_tool()

async def scan_for_pii(arguments: dict) -> list[types.TextContent]:

text_content = arguments.get("text_content", "")

pii_findings = await self._detect_pii(text_content)

if pii_findings:

# Log PII detection event

await self.server.request_context.session.send_notification(

types.LoggingNotification(

level="warning",

data=f"PII detected: {list(pii_findings.keys())}"

)

)

sanitized_content = await self._sanitize_pii(text_content, pii_findings)

return [types.TextContent(

type="text",

text=f"PII detected and sanitized. Found: {list(pii_findings.keys())}"

)]

else:

return [types.TextContent(

type="text",

text="No PII detected in content"

)]

@self.server.call_tool()

async def encrypt_sensitive_data(arguments: dict) -> list[types.TextContent]:

data_content = arguments.get("data_content")

# Encrypt sensitive data

encrypted_data = self.fernet.encrypt(data_content.encode())

encrypted_b64 = encrypted_data.decode('utf-8', errors='ignore')

return [types.TextContent(

type="text",

text=f"Data encrypted successfully. Length: {len(encrypted_data)} bytes"

)]

async def _detect_pii(self, text: str) -> dict:

findings = {}

for pii_type, pattern in self.pii_patterns.items():

matches = pattern.findall(text)

if matches:

findings[pii_type] = len(matches)

return findings

async def _sanitize_pii(self, text: str, findings: dict) -> str:

sanitized_text = text

for pii_type, pattern in self.pii_patterns.items():

if pii_type in findings:

sanitized_text = pattern.sub(f'[REDACTED_{pii_type.upper()}]', sanitized_text)

return sanitized_text

Общие требования по защите данных (GDPR) (GDPR) требуют комплексных процедур обработки данных, которые уважают отдельные права на конфиденциальность, одновременно обеспечивая законные операции по обработке данных. Реализация прав на субъект данных, управление согласия и функции переносимости данных обеспечивает соблюдение нормативных требований при сохранении функциональности системы.

Методы конфиденциальности, такие как дифференциальная конфиденциальность, гомоморфное шифрование и безопасные многопартийные вычисления, могут быть интегрированы с серверами MCP для обеспечения расширенной аналитики при защите индивидуальной конфиденциальности. Эти методы дают ценную информацию при сохранении сильных гарантий конфиденциальности для конфиденциальных сценариев обработки данных.

Структура безопасности и проверки данных на многомодальных серверах MCP требует комплексной интеграции механизмов проверки, контроля доступа и защиты конфиденциальности. Реализация этих мер безопасности в рамках протокола MCP гарантирует, что многомодальные операции обработки данных поддерживают высокие стандарты безопасности при сохранении при эксплуатации протокола и характеристик эффективности.

Интеграция с облачными службами

А. Интеграция AWS

Интеграция веб-сервисов Amazon с многомодальными серверами MCP обеспечивает масштабируемое облачное хранилище, возможности обработки и управляемое использование услуг при сохранении соответствия протоколам. MCP SDK обеспечивает бесшовную интеграцию для сервисов AWS, в частности Amazon S3 для хранения объектов, AWS Lambda для обработки без сервера и Amazon Rekognition для возможностей анализа изображений.

Паттерны интеграции S3 используют систему ресурсов MCP для абстрактных операций облачного хранения за стандартными интерфейсами MCP. Этот подход обеспечивает прозрачный доступ в облако хранилище, сохраняя при этом согласованность протокола и упрощая клиентские взаимодействия. Реализация использует интеграцию AWS SDK в архитектуре сервера MCP для предоставления надежных возможностей облачного хранения:

from mcp import Server, types

import boto3

import base64

from botocore.exceptions import ClientError

class AWSS3MCPServer:

def __init__(self, aws_access_key: str, aws_secret_key: str, region: str):

self.server = Server("aws-s3-server")

self.s3_client = boto3.client(

's3',

aws_access_key_id=aws_access_key,

aws_secret_access_key=aws_secret_key,

region_name=region

)

self.default_bucket = "mcp-multimodal-storage"

self.setup_s3_tools()

def setup_s3_tools(self):

@self.server.call_tool()

async def upload_to_s3(arguments: dict) -> list[types.TextContent]:

file_content = arguments.get("file_content") # Base64 encoded

object_key = arguments.get("object_key")

bucket_name = arguments.get("bucket", self.default_bucket)

content_type = arguments.get("content_type", "application/octet-stream")

try:

# Decode file content

file_data = base64.b64decode(file_content)

# Upload to S3

self.s3_client.put_object(

Bucket=bucket_name,

Key=object_key,

Body=file_data,

ContentType=content_type,

Metadata={

'uploaded_via': 'mcp_server',

'content_length': str(len(file_data))

}

)

# Generate S3 URI for MCP resource system

s3_uri = f"s3://{bucket_name}/{object_key}"

await self.server.request_context.session.send_notification(

types.LoggingNotification(

level="info",

data=f"File uploaded to S3: {s3_uri}"

)

)

return [types.TextContent(

type="text",

text=f"Upload successful: {s3_uri}"

)]

except ClientError as e:

error_msg = f"S3 upload failed: {str(e)}"

await self.server.request_context.session.send_notification(

types.LoggingNotification(

level="error",

data=error_msg

)

)

return [types.TextContent(

type="text",

text=error_msg

)]

@self.server.list_resources()

async def list_s3_resources() -> list[types.Resource]:

try:

response = self.s3_client.list_objects_v2(

Bucket=self.default_bucket,

MaxKeys=100

)

resources = []

for obj in response.get('Contents', []):

resources.append(types.Resource(

uri=f"s3://{self.default_bucket}/{obj['Key']}",

name=obj['Key'],

mimeType=self._infer_mime_type(obj['Key'])

))

return resources

except ClientError:

return []

@self.server.read_resource()

async def read_s3_resource(uri: str) -> str | bytes:

if not uri.startswith("s3://"):

raise ValueError("Invalid S3 URI format")

# Parse S3 URI

uri_parts = uri[5:].split('/', 1)

bucket_name = uri_parts[0]

object_key = uri_parts[1]

try:

response = self.s3_client.get_object(

Bucket=bucket_name,

Key=object_key

)

return response['Body'].read()

except ClientError as e:

raise ValueError(f"Failed to read S3 object: {str(e)}")

def _infer_mime_type(self, filename: str) -> str:

extension = filename.lower().split('.')[-1]

mime_types = {

'jpg': 'image/jpeg', 'jpeg': 'image/jpeg', 'png': 'image/png',

'mp3': 'audio/mpeg', 'wav': 'audio/wav', 'mp4': 'video/mp4',

'pdf': 'application/pdf', 'txt': 'text/plain'

}

return mime_types.get(extension, 'application/octet-stream')

Integration AWS Lambda обеспечивает обработку многомодальных данных без сервера в рабочих процессах сервера MCP. Функции Lambda могут быть вызваны инструментами MCP для выполнения интенсивной обработки при сохранении эффективного использования ресурсов и оптимизации затрат.

Amazon Rekognition Integration предоставляет возможности компьютерного зрения, которые улучшают рабочие процессы обработки изображений и видео. Интеграция использует услуги AWS управляемых ИИ, одновременно выявляя функциональность через стандартные интерфейсы инструментов MCP.

B. Образцы лазурных и GCP

Модели интеграции Microsoft Azure фокусируются на хранилище Blob Blob для масштабируемого хранения объектов и когнитивных служб Azure для анализа контента с AI. Архитектура сервера MCP размещает шаблоны сервиса Azure с помощью аналогичных подходов к управлению ресурсами и регистрации инструментов.

Интеграция хранилища Blob Blob Blob следует аналогичным образом с интеграцией S3, используя SDK SDK Azure Storage в реализации сервера MCP. Контейнерные организации хранения эффективно отображают иерархии ресурсов MCP, что позволяет интуитивно понятному обнаружению ресурсов и моделям доступа.

Интеграция Google Cloud Platform Platform подчеркивает Google Cloud Storage и Integration Services Services. Объединенный подход GCP API упрощает сложность интеграции, обеспечивая комплексные возможности многомодальной обработки через управляемые услуги:

from mcp import Server, types

from google.cloud import storage

from google.cloud import vision

import base64

class GCPIntegratedMCPServer:

def __init__(self, project_id: str, credentials_path: str):

self.server = Server("gcp-integrated-server")

self.project_id = project_id

self.storage_client = storage.Client.from_service_account_json(credentials_path)

self.vision_client = vision.ImageAnnotatorClient.from_service_account_json(credentials_path)

self.setup_gcp_tools()

def setup_gcp_tools(self):

@self.server.call_tool()

async def analyze_image_with_vision(arguments: dict) -> list[types.TextContent]:

image_b64 = arguments.get("image_data")

analysis_type = arguments.get("analysis_type", "labels")

try:

# Decode image

image_data = base64.b64decode(image_b64)

image = vision.Image(content=image_data)

# Perform analysis based on type

if analysis_type == "labels":

response = self.vision_client.label_detection(image=image)

labels = response.label_annotations

results = [f"{label.description}: {label.score:.2f}" for label in labels[:5]]

elif analysis_type == "text":

response = self.vision_client.text_detection(image=image)

texts = response.text_annotations

results = [text.description for text in texts[:3]]

elif analysis_type == "faces":

response = self.vision_client.face_detection(image=image)

faces = response.face_annotations

results = [f"Face {i+1}: confidence {face.detection_confidence:.2f}"

for i, face in enumerate(faces)]

else:

results = ["Unknown analysis type"]

return [types.TextContent(

type="text",

text=f"Vision API analysis ({analysis_type}): {', '.join(results)}"

)]

except Exception as e:

return [types.TextContent(

type="text",

text=f"Vision API analysis failed: {str(e)}"

)]

@self.server.call_tool()

async def upload_to_gcs(arguments: dict) -> list[types.TextContent]:

bucket_name = arguments.get("bucket_name")

blob_name = arguments.get("blob_name")

file_content = arguments.get("file_content") # Base64 encoded

try:

bucket = self.storage_client.bucket(bucket_name)

blob = bucket.blob(blob_name)

# Decode and upload content

file_data = base64.b64decode(file_content)

blob.upload_from_string(file_data)

gcs_uri = f"gs://{bucket_name}/{blob_name}"

return [types.TextContent(

type="text",

text=f"Upload to GCS successful: {gcs_uri}"

)]

except Exception as e:

return [types.TextContent(

type="text",

text=f"GCS upload failed: {str(e)}"

)]

Интеграция Cloud Functs Integration позволяет автоматически управляемым событиям шаблоны обработки, которые автоматически реагируют на многомодальные события данных. Архитектуры на основе триггеров облегчают трубопроводы в реальном времени, которые динамически масштабируются на основе требований рабочей нагрузки.

Без сервера шаблоны развертывания оптимизируют характеристики затрат и масштабируемости путем устранения накладных расходов управления инфраструктурой при сохранении высоких стандартов доступности и производительности.

C. Гибридные облачные стратегии

Стратегии распределения файлов с несколькими облаками обеспечивают географическое распределение данных, реализацию избыточности и предотвращение блокировки поставщиков при сохранении единого доступа через интерфейсы MCP. Реализация многоклетных архитектур требует тщательной координации операций хранения, управления согласованностью и процедур отказа.

Механизмы аварийного переключения обеспечивают непрерывную доступность обслуживания, несмотря на отключения индивидуальных облачных поставщиков или сбои в региональном обслуживании. Автоматизированные процедуры отказоустойчивости сохраняют непрерывность обслуживания при минимизации потери данных и деградации производительности в течение переходных периодов.

Стратегии оптимизации затрат сбалансированы требованиями к эффективности с эксплуатационными расходами в нескольких облачных провайдерах. Выбор динамического поставщика на основе характеристик рабочей нагрузки, географической близости и моделей ценообразования оптимизирует общую стоимость владения при сохранении стандартов качества обслуживания:

from mcp import Server, types

import asyncio

from typing import Dict, List

class HybridCloudMCPServer:

def __init__(self):

self.server = Server("hybrid-cloud-server")

self.cloud_providers = {

'aws': {'priority': 1, 'available': True, 'cost_factor': 1.0},

'azure': {'priority': 2, 'available': True, 'cost_factor': 0.9},

'gcp': {'priority': 3, 'available': True, 'cost_factor': 1.1}

}

self.setup_hybrid_tools()

def setup_hybrid_tools(self):

@self.server.call_tool()

async def distribute_file_multicloud(arguments: dict) -> list[types.TextContent]:

file_content = arguments.get("file_content")

replication_factor = arguments.get("replication_factor", 2)

# Select optimal cloud providers

selected_providers = await self._select_optimal_providers(replication_factor)

upload_results = []

for provider in selected_providers:

try:

result = await self._upload_to_provider(provider, file_content)

upload_results.append(f"{provider}: {result}")

except Exception as e:

upload_results.append(f"{provider}: Failed - {str(e)}")

return [types.TextContent(

type="text",

text=f"Multi-cloud distribution: {'; '.join(upload_results)}"

)]

@self.server.call_tool()

async def check_provider_status(arguments: dict) -> list[types.TextContent]:

status_report = []

for provider, config in self.cloud_providers.items():

availability = "Available" if config['available'] else "Unavailable"

status_report.append(

f"{provider.upper()}: {availability} "

f"(Priority: {config['priority']}, Cost: {config['cost_factor']}x)"

)

return [types.TextContent(

type="text",

text="Provider Status: " + "; ".join(status_report)

)]

async def _select_optimal_providers(self, count: int) -> List[str]:

# Sort providers by priority and availability

available_providers = [

(provider, config) for provider, config in self.cloud_providers.items()

if config['available']

]

# Sort by priority, then by cost factor

available_providers.sort(key=lambda x: (x[1]['priority'], x[1]['cost_factor']))

return [provider for provider, _ in available_providers[:count]]

async def _upload_to_provider(self, provider: str, file_content: str) -> str:

# Simulate cloud provider upload

await asyncio.sleep(0.1) # Simulate network delay

return f"Upload successful to {provider}"

Географические соображения распределения оптимизируют местонахождение данных и соблюдение региональных правил защиты данных. Стратегическое размещение реплик данных на основе географии пользователей, нормативных требований и характеристик производительности повышает опыт пользователя при сохранении стандартов соответствия.

Интеграция облачных сервисов с многомодальными серверами MCP обеспечивает масштабируемые, экономически эффективные и высокодоступные системы, которые используют управляемые облачные возможности, сохраняя при этом согласованность протокола. Гибридные облачные стратегии обеспечивают гибкость, избыточность и оптимизацию, которые повышают устойчивость системы и эффективность работы при сохранении при этом простоты и характеристик надежности, присущих дизайну протокола MCP.

Реальные варианты использования и примеры

A. Трубопровод обработки документов

Трубопроводы обработки документов представляют собой комплексные мультимодальные рабочие процессы, которые демонстрируют полные возможности серверов MCP при обработке различных типов контента в рамках объединенных архитектур обработки. Эти трубопроводы интегрируют анализ PDF, оптическое распознавание символов, преобразование формата и операции извлечения метаданных при сохранении эффективного использования ресурсов и масштабируемых характеристик обработки.

Подбор PDF и извлечение текста представляют собой фундаментальные операции в рабочих процессах обработки документов. Реализация использует специализированные библиотеки, интегрированные в архитектуру сервера MCP для предоставления надежных возможностей анализа документов. Система управления ресурсами протокола MCP облегчает эффективную обработку крупных сборов документов, одновременно обеспечивая оптимизацию гранулированного доступа и оптимизации обработки:

from mcp import Server, types

import PyPDF2

from PIL import Image

import pytesseract

import base64

import io

class DocumentProcessingMCPServer:

def __init__(self):

self.server = Server("document-processing-server")

self.supported_formats = ['pdf', 'docx', 'txt', 'png', 'jpg', 'jpeg']

self.setup_document_tools()

def setup_document_tools(self):