Metamathqa: набор данных по математике с AI-Augmented с образцами 395 тыс.

18 июня 2025 г.Таблица ссылок

Аннотация и 1 введение

2 фон

3 Экспериментальная настройка и 3,1 наборов данных для продолжения предварительной подготовки (CPT) и создания инструкций (IFT)

3.2 Измерение обучения с помощью кодирования и математических показателей (оценка целевой области)

3.3 Забыть метрики (оценка доменов источника)

4 Результаты

4.1 Lora Underperforms Полное создание в программировании и математических задачах

4.2 Лора забывает меньше, чем полное создание

4.3 Обмен на обучение

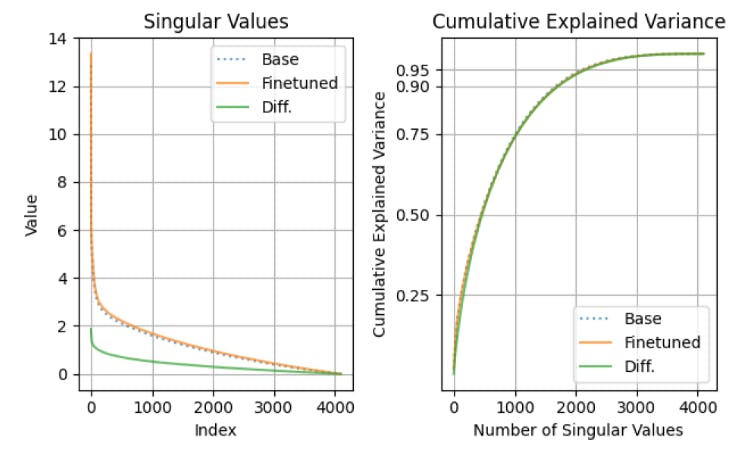

4.4 Свойства регуляризации Лоры

4.5 Полная производительность на коде и математике не изучает низкие возмущения

4.6 Практические выводы для оптимальной настройки LORA

5 Связанная работа

6 Обсуждение

7 Заключение и ссылки

Приложение

А. Экспериментальная установка

B. Поиски скорости обучения

C. Обучающие наборы данных

D. Теоретическая эффективность памяти с LORA для однократных и мульти-GPU настройки

C Обучающие наборы данных

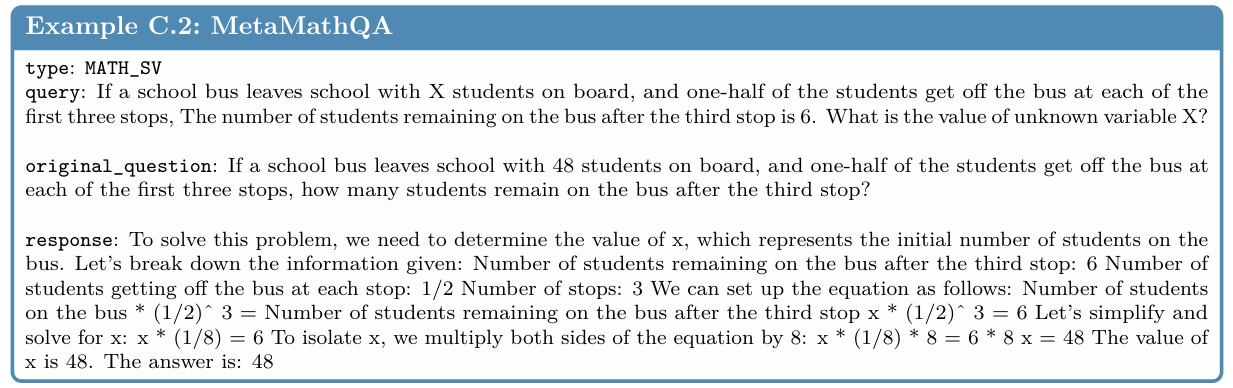

C.1 Metamathqa (математика IFT)

Набор данных Metamathqa (Yu et al. (2023), https://huggingface.co/datasets/meta-math/metamathqa) содержит 395 000 образцов, которые связаны с обучением GSM (Cobbe et al., 2021) и Math (Hendrycks et al., 2021). Эти образцы дополняются GPT-3.5 с использованием следующих методов:

• Увеличение ответов (образцы 155K, Yu et al. (2023)): этот метод, предложенный авторами Metamathqa, генерирует несколько путей рассуждений для заданного математического вопроса и фильтров для сгенерированных путей рассуждений, которые содержат правильный окончательный ответ.

• Перефразирование (образцы 130 тыс., (Yu et al., 2023)): этот метод, предложенный авторами Metamathqa, использует GPT-3.5 для перефразирования вопросов. Они проверяют правильность перефразированных вопросов, используя несколько выстрелов, побуждающих к сравнению цепочек рассуждений и предложенных ответов с основными ответами правды.

Как самоуверенность (Weng et al., 2022), так и Фобар (Jiang et al., 2024) подпадают под категорию «отсталых рассуждений», где вопрос начинается с заданного условия и требует рассуждения назад для решения неизвестной переменной. Чтобы генерировать новые математические вопросы, числовое значение в исходном вопросе замаскируется как переменная x, и вопрос соответственно перефразируется.

Образцы метаматки организованы по 4 столбцам: тип, оригинал_question, запрос и ответ.

Мы включаем два полных примера ниже:

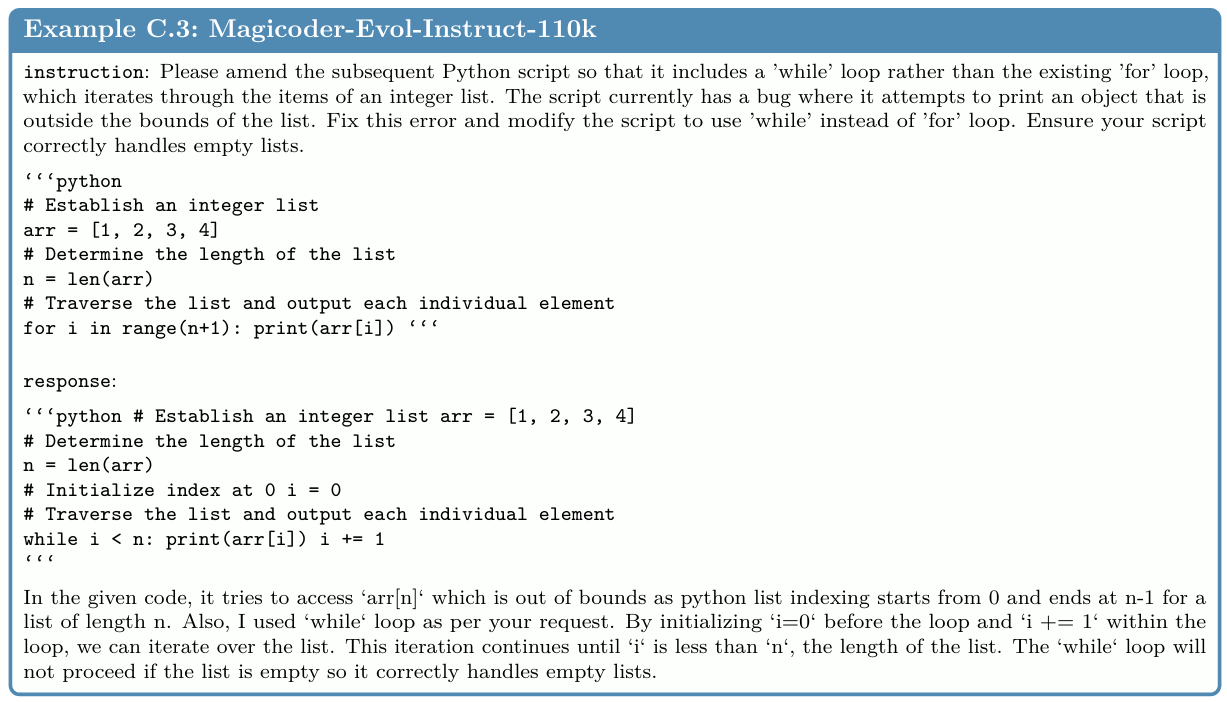

C.2 Magicoder-Evol-Instruct-110K (код IFT)

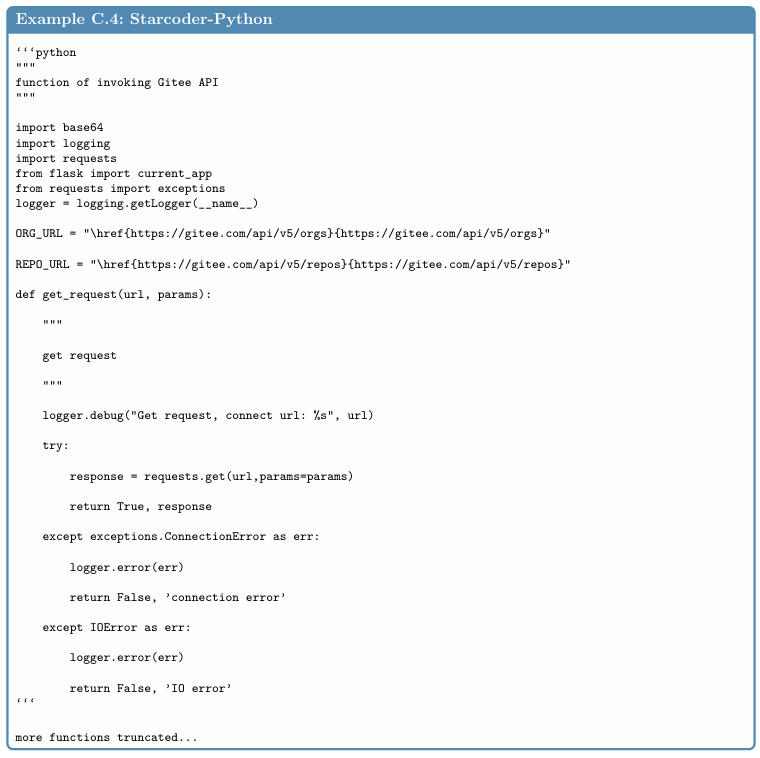

C.3 StarCoder Python (Code CPT)

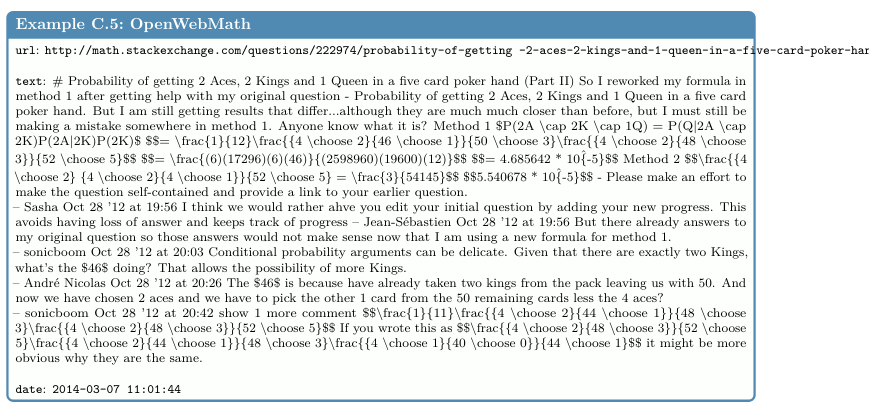

C.4 OpenWebmath (Math CPT)

Авторы:

(1) Дэн Бидерман, Колумбийский университет и Databricks Mosaic AI (db3236@columbia.edu);

(2) Хосе Гонсалес Ортис, DataBricks Mosaic AI (j.gonzalez@databricks.com);

(3) Джейкоб Портес, DataBricks Mosaic AI (jportes@databricks.com);

(4) Mansheej Paul, DataBricks Mosaic AI (mansheej.paul@databricks.com);

(5) Филип Грингард, Колумбийский университет (pg2118@columbia.edu);

(6) Коннор Дженнингс, DataBricks Mosaic AI (connor.jennings@databricks.com);

(7) Даниэль Кинг, DataBricks Mosaic AI (daniel.king@databricks.com);

(8) Сэм Хейвенс, DataBricks Mosaic AI (sam.havens@databricks.com);

(9) Vitaliy Chiley, DataBricks Mosaic AI (vitaliy.chiley@databricks.com);

(10) Джонатан Франкл, DataBricks Mosaic AI (jfrankle@databricks.com);

(11) Коди Блакни, DataBricks Mosaic AI (Cody.blakeney);

(12) Джон П. Каннингем, Колумбийский университет (jpc2181@columbia.edu).

Эта статья есть

Оригинал