Lionw превосходит Adamw в Lora и полную настройку задач

18 июня 2025 г.Таблица ссылок

Аннотация и 1 введение

2 фон

3 Экспериментальная настройка и 3,1 наборов данных для продолжения предварительной подготовки (CPT) и создания инструкций (IFT)

3.2 Измерение обучения с помощью кодирования и математических показателей (оценка целевой области)

3.3 Забыть метрики (оценка доменов источника)

4 Результаты

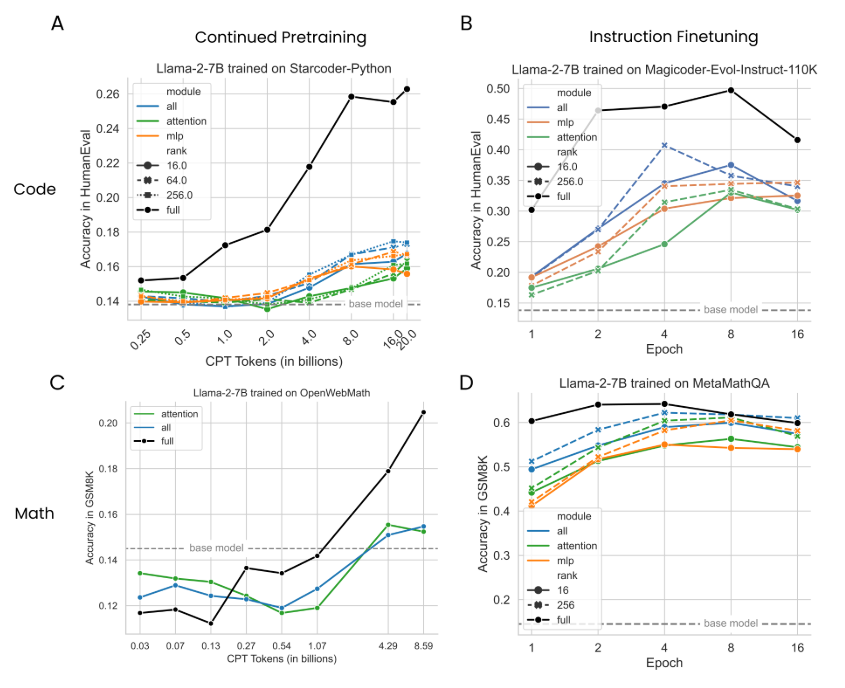

4.1 Lora Underperforms Полное создание в программировании и математических задачах

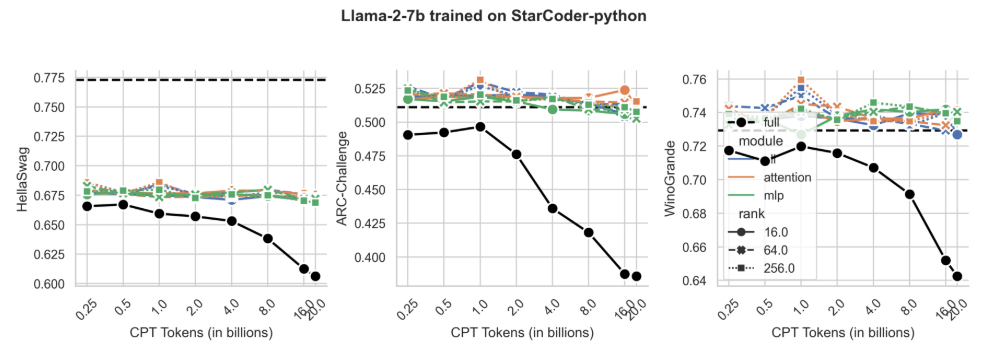

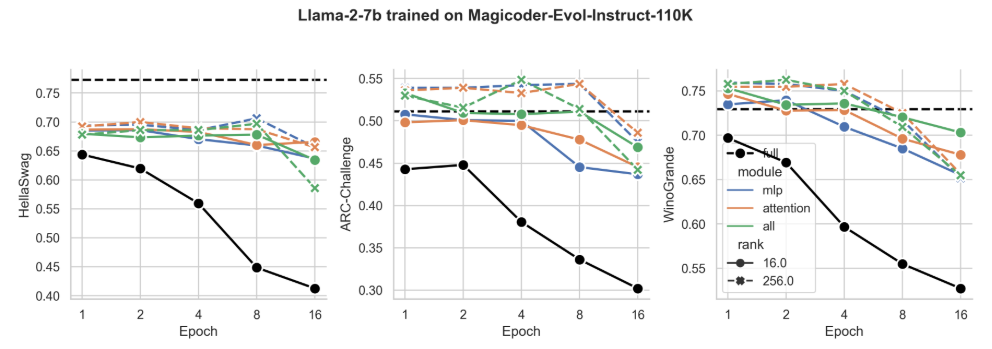

4.2 Лора забывает меньше, чем полное создание

4.3 Обмен на обучение

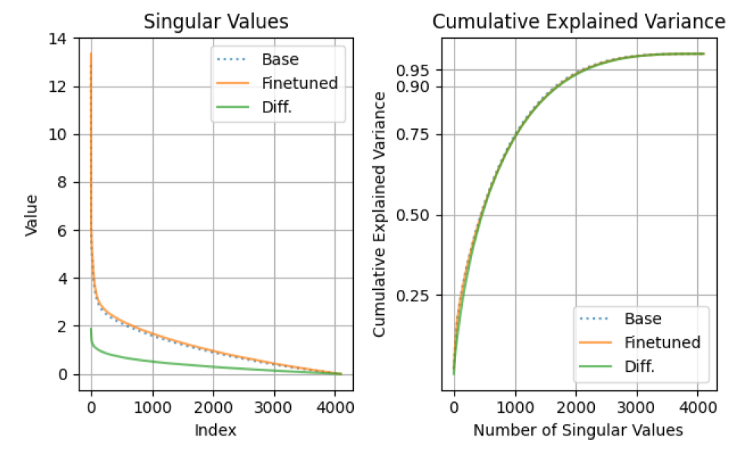

4.4 Свойства регуляризации Лоры

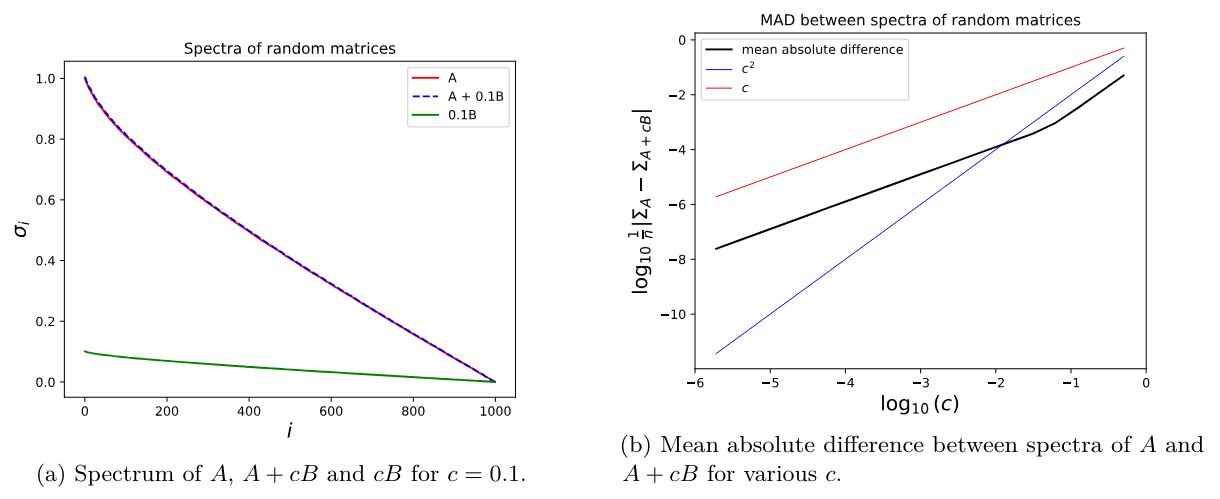

4.5 Полная производительность на коде и математике не изучает низкие возмущения

4.6 Практические выводы для оптимальной настройки LORA

5 Связанная работа

6 Обсуждение

7 Заключение и ссылки

Приложение

А. Экспериментальная установка

B. Поиски скорости обучения

C. Обучающие наборы данных

D. Теоретическая эффективность памяти с LORA для однократных и мульти-GPU настройки

Экспериментальная установка

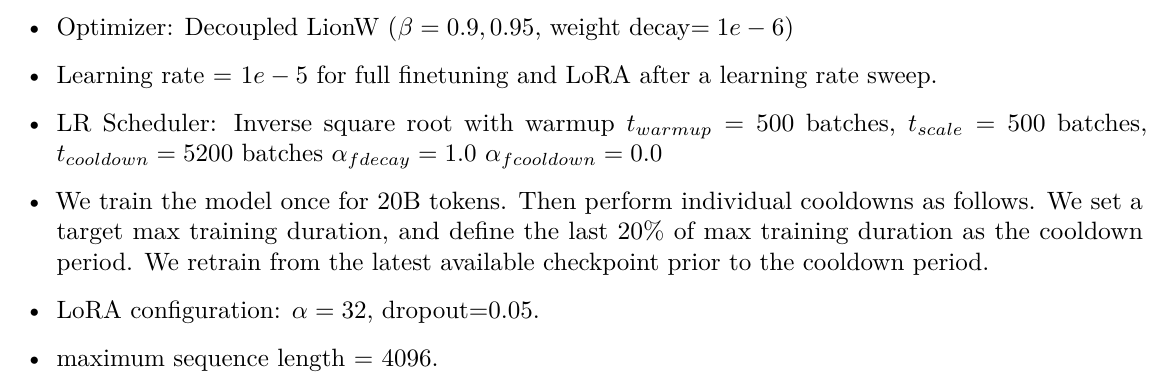

Код cpt.

Math Cpt.

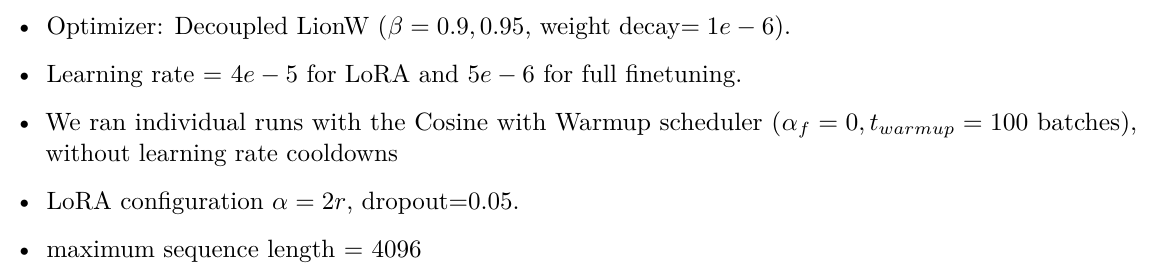

Код ift.

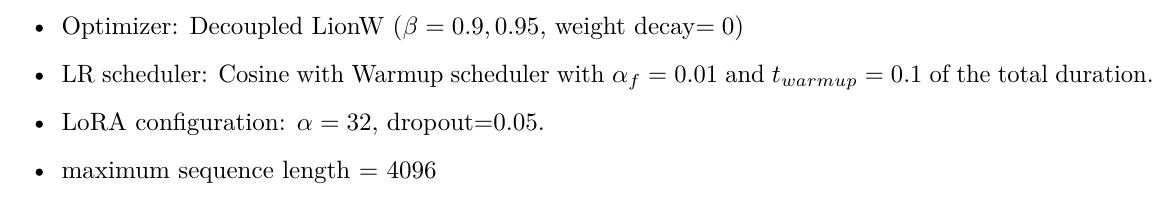

Математика ift.То же самое, что и IFT, кроме этого

• Максимальная длина последовательности = 1024

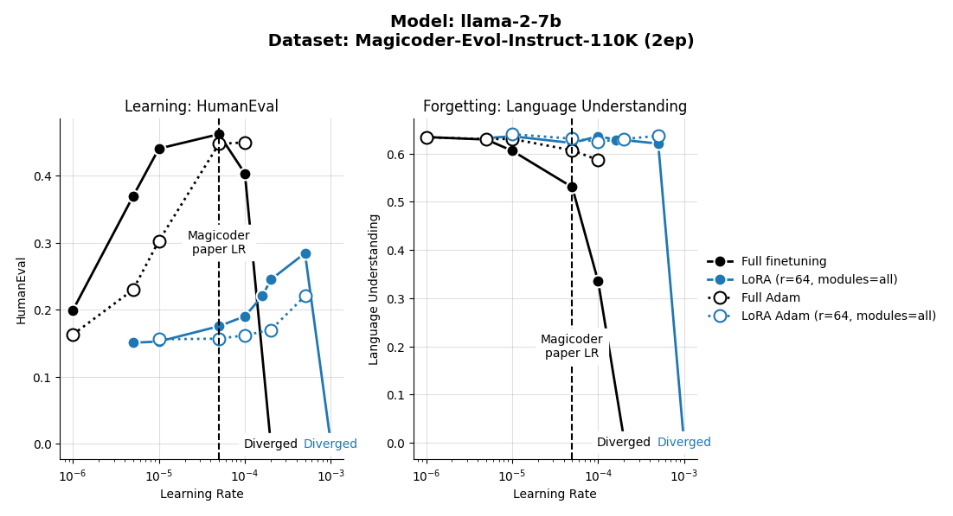

Мы сравнили два оптимизатора, тренируясь для двух эпох магических показателей-EVOL-Instruct-110K, используя различные показатели обучения. Мы обнаружили, что Decoucted Lionw превзошел DeCoucoupdAdamw на Humaneval как для Lora, так и для полного создания, и по показателям обучения, как видно на рис. S1.

B Поиск курса обучения

Для IFT мы находим, что Lora LRS должен быть на порядок выше. Для более длинного CPT эти эффекты более тонкие.

B.1 Анализ чувствительности к уровню обучения между оптимизаторами

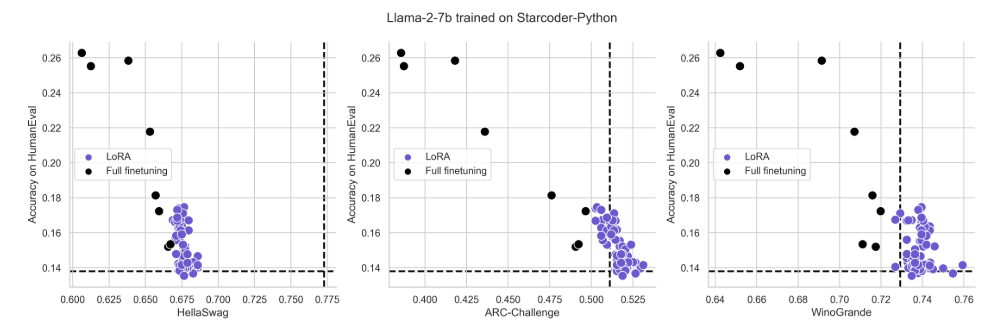

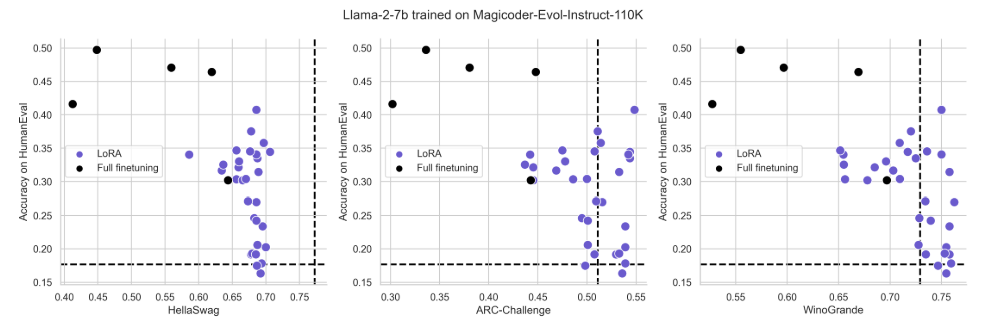

Рисунок S4: те же данные, что и на рис. 3

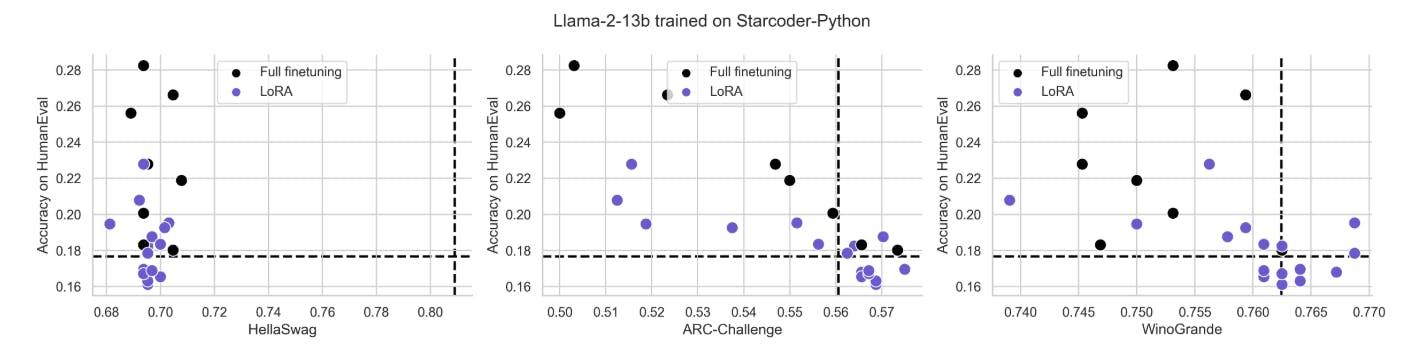

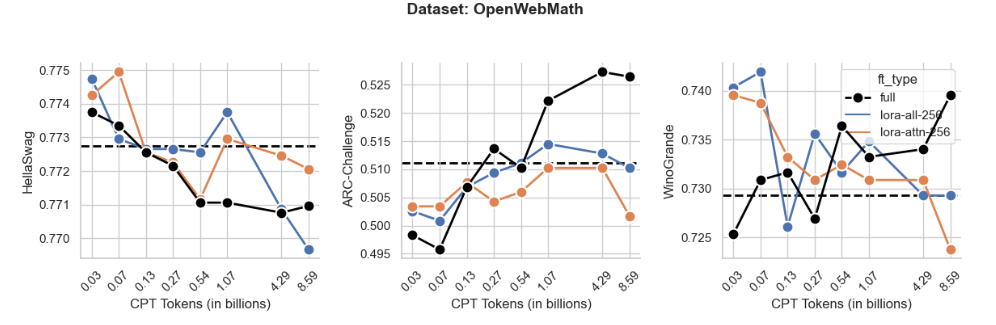

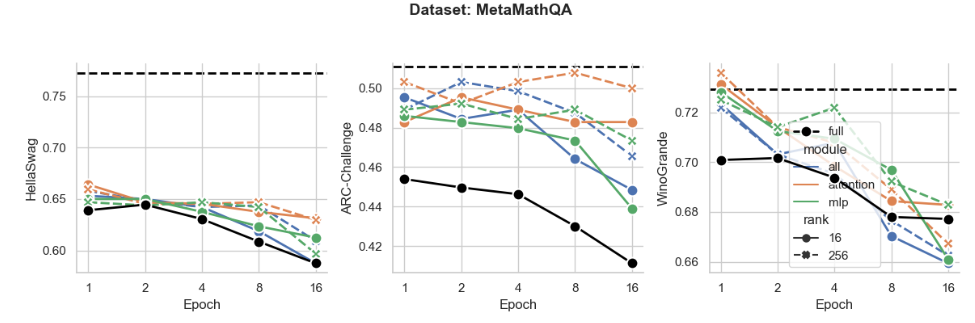

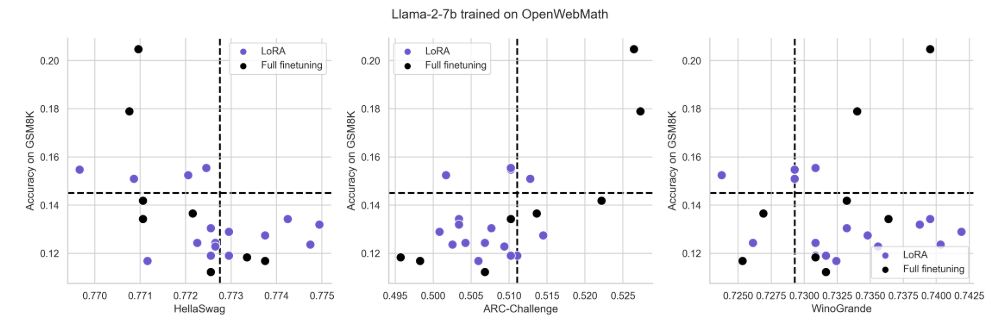

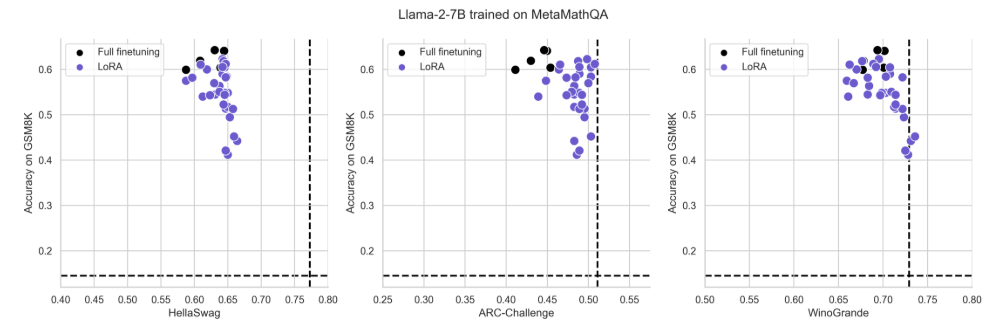

Рисунок S5: те же данные, что и на рис. 4, нанесенные для отдельных задач Hellaswag, Arc-Challenge и Winogrande

Авторы:

(1) Дэн Бидерман, Колумбийский университет и Databricks Mosaic AI (db3236@columbia.edu);

(2) Хосе Гонсалес Ортис, DataBricks Mosaic AI (j.gonzalez@databricks.com);

(3) Джейкоб Портес, DataBricks Mosaic AI (jportes@databricks.com);

(4) Mansheej Paul, DataBricks Mosaic AI (mansheej.paul@databricks.com);

(5) Филип Грингард, Колумбийский университет (pg2118@columbia.edu);

(6) Коннор Дженнингс, DataBricks Mosaic AI (connor.jennings@databricks.com);

(7) Даниэль Кинг, DataBricks Mosaic AI (daniel.king@databricks.com);

(8) Сэм Хейвенс, DataBricks Mosaic AI (sam.havens@databricks.com);

(9) Vitaliy Chiley, DataBricks Mosaic AI (vitaliy.chiley@databricks.com);

(10) Джонатан Франкл, DataBricks Mosaic AI (jfrankle@databricks.com);

(11) Коди Блакни, DataBricks Mosaic AI (Cody.blakeney);

(12) Джон П. Каннингем, Колумбийский университет (jpc2181@columbia.edu).

Эта статья есть

Оригинал