Зажигание генеративной силы: Multi-Token LLM для расширенного текстового обобщения

25 июля 2025 г.Таблица ссылок

Аннотация и 1. Введение

2. Метод

3. Эксперименты по реальным данным

4. Абляции на синтетических данных

5. Почему это работает? Некоторые предположения

6. Связанная работа

7. Заключение, Заявление о воздействии, воздействие на окружающую среду, подтверждения и ссылки

A. Дополнительные результаты по самопрокативному декодированию

Б. Альтернативные архитектуры

C. Скорость тренировок

D. МАГАЗИН

E. Дополнительные результаты по поведению масштабирования модели

F. Подробности о CodeContests Manetuning

G. Дополнительные результаты по сравнению с естественным языком

H. Дополнительные результаты по абстрактному текстовому суммированию

I. Дополнительные результаты по математическим рассуждениям на естественном языке

J. Дополнительные результаты по индукционному обучению

K. Дополнительные результаты по алгоритмическим рассуждениям

L. Дополнительные интуиции по многоцелевым прогнозам

М. Обучение гиперпараметры

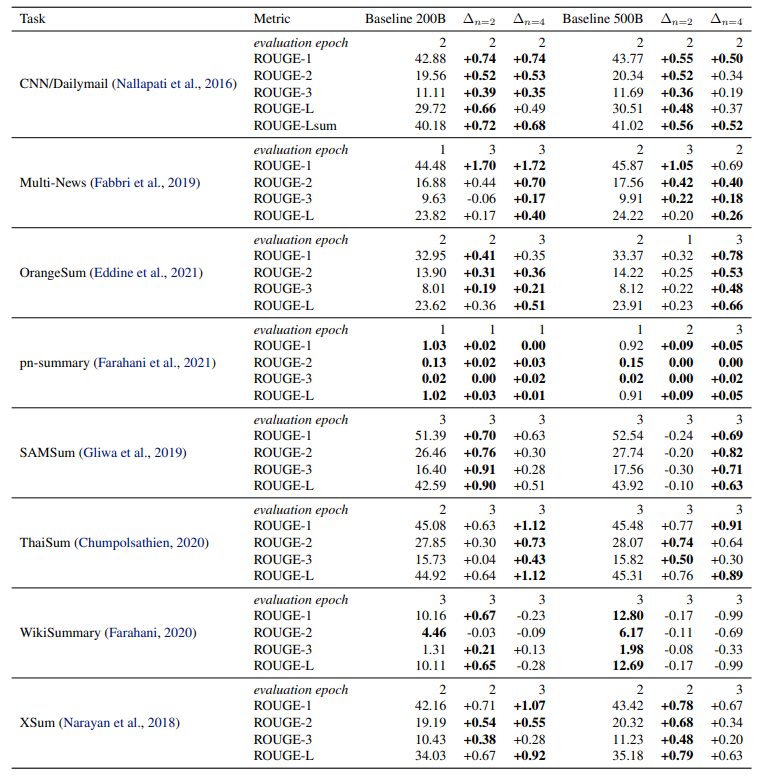

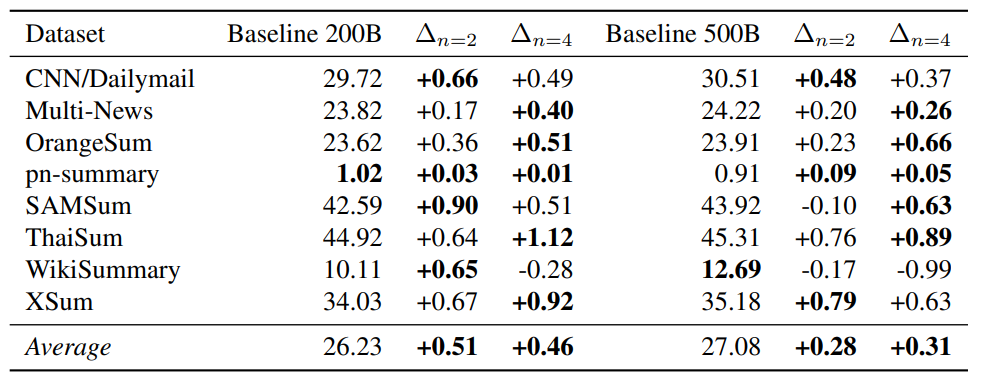

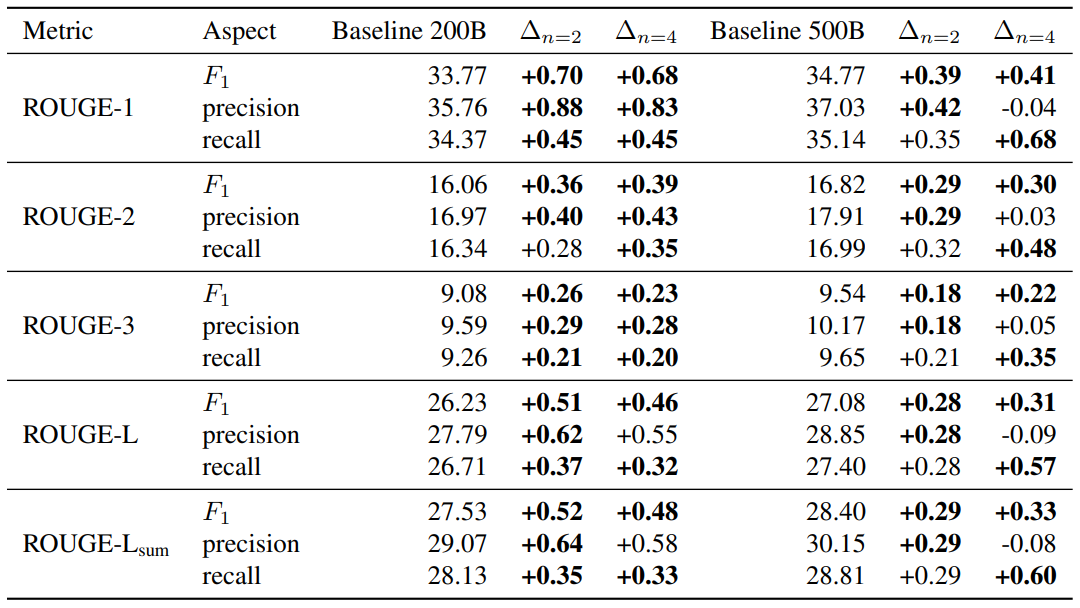

H. Дополнительные результаты по абстрактному текстовому суммированию

В этом разделе мы сообщаем о исчерпывающих результатах оценки по задачам суммирования для моделей параметров 7B, обученных по токенам 200b и 500b естественного языка из раздела 3.7.

Авторы:

(1) Фабиан Глокл, ярмарка в Meta, Cermics Ecole des Ponts Paristech и равный вклад;

(2) Badr Youbi Idrissi, Fair at Meta, Lisn Université Paris-Saclayand и равный вклад;

(3) Baptiste Rozière, ярмарка в Meta;

(4) Дэвид Лопес-Паз, ярмарка в Meta и последний автор;

(5) Габриэль Синнев, ярмарка в Meta и последний автор.

Эта статья есть

Оригинал