Гипертрансформатор: генерация модели для контролируемого и полуконтролируемого обучения с несколькими выстрелами

17 апреля 2024 г.:::информация Этот документ доступен на arxiv под лицензией CC 4.0.

Авторы:

(1) Андрей Жмогинов, Google Research & {azhmogin,sandler,mxv}@google.com;

(2) Марк Сэндлер, Google Research & {azhmogin,sandler,mxv}@google.com;

(3) Макс Владимиров, Google Research & {azhmogin,sandler,mxv}@google.com.

:::

Таблица ссылок

- Аннотация и введение

- Установка проблемы и сопутствующие работы

- Гипертрансформатор

- Эксперименты

- Выводы и ссылки

- Пример механизма самообслуживания для контролируемого обучения

- Параметры модели B

- C Дополнительные контролируемые эксперименты

- Зависимость D от параметров и исследования абляции

- Карты внимания изученных моделей трансформаторов

- F Визуализация сгенерированных весов CNN

- G Дополнительные таблицы и рисунки

3 ГИПЕРТРАНСФОРМАТОР

В этом разделе мы описываем наш подход к краткосрочному обучению, который мы называем ГИПЕРТРАНСФОРМАТОРОМ (HT), и обосновываем выбор механизма самообслуживания в качестве его основы.

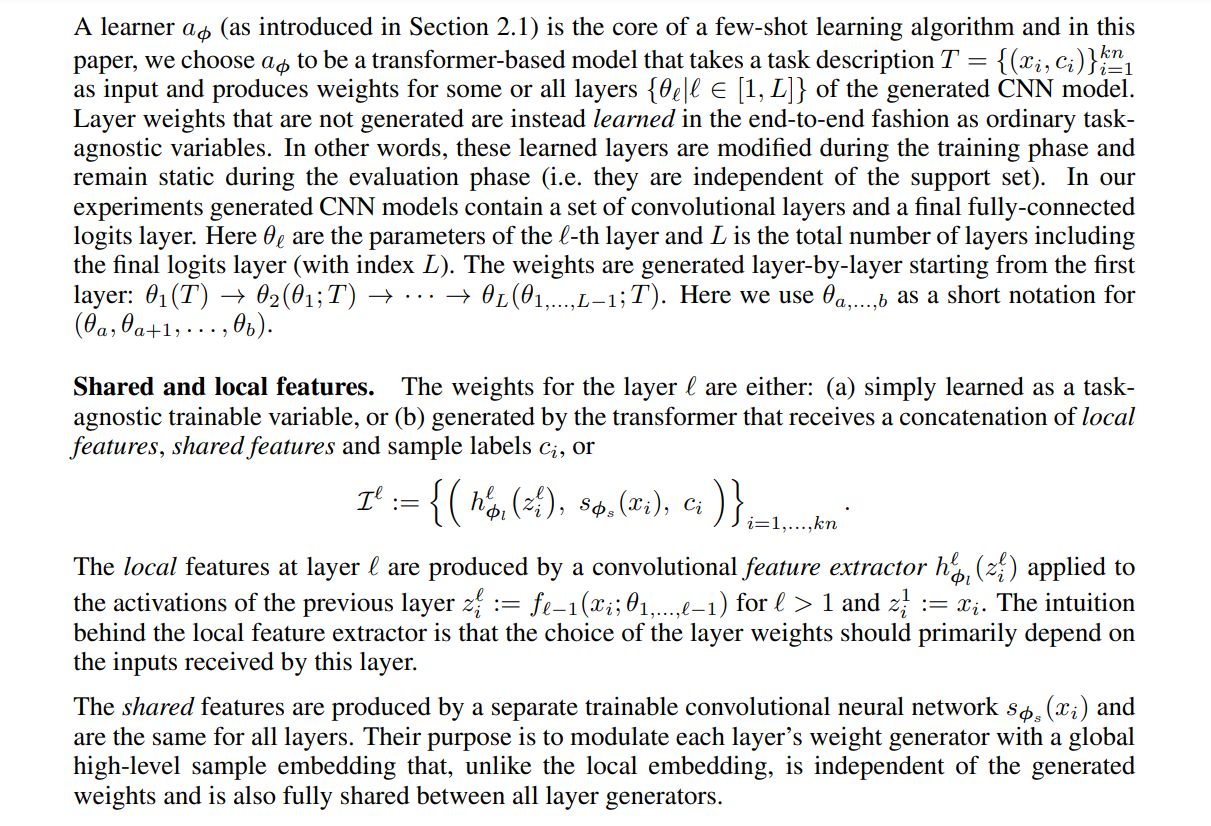

3.1 МОДЕЛЬ ОБУЧЕНИЯ НЕСКОЛЬКО КАДРОВ

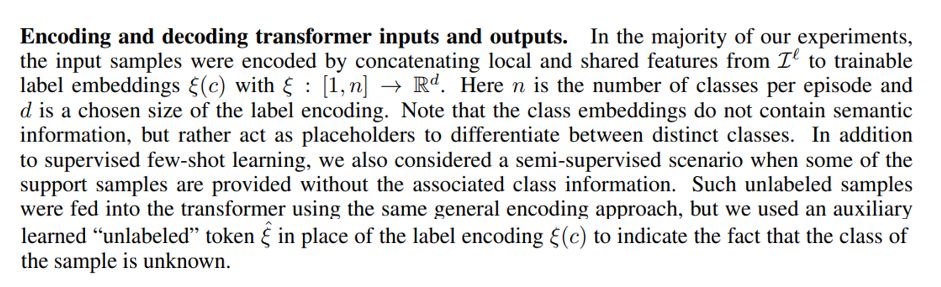

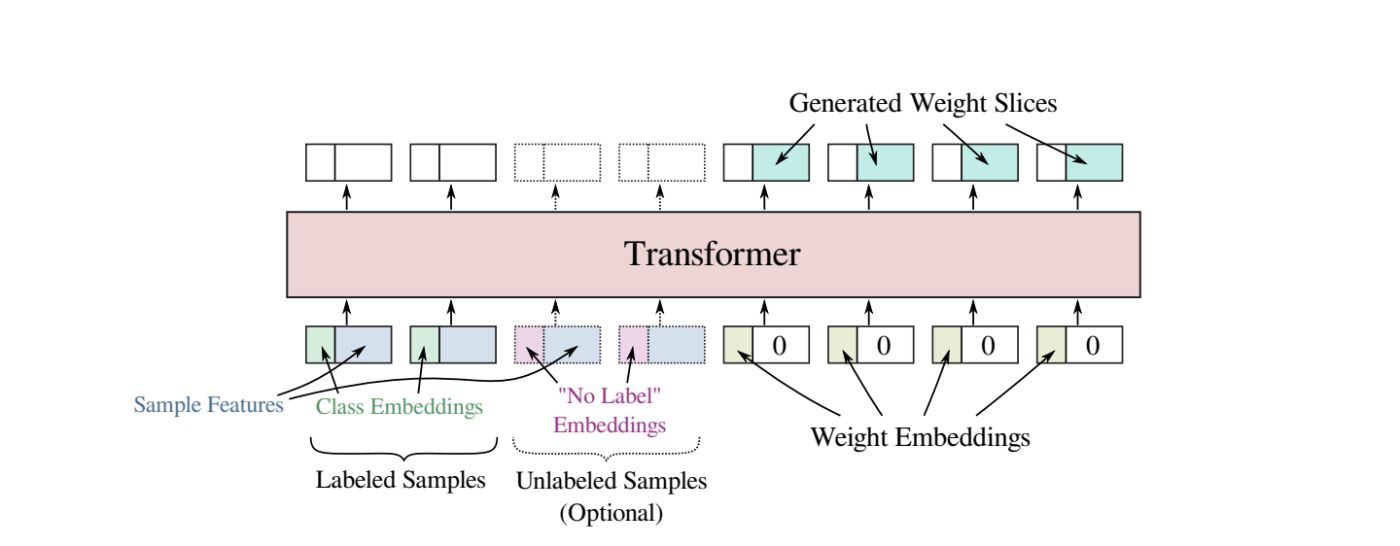

Наряду с входными выборками последовательность, передаваемая в преобразователь, также заполнялась специальными обучаемыми токенами-заполнителями, каждый из которых связан с определенным фрагментом генерируемого весового тензора. Каждый такой токен представлял собой обучаемый d-мерный вектор, дополненный нулями до размера токена входной выборки. После того, как вся входная последовательность была обработана преобразователем, мы считываем выходные данные модели, связанные с токенами-заполнителями весовых срезов, и собираем выходные весовые срезы в окончательные тензоры весов (см. рис. 2).

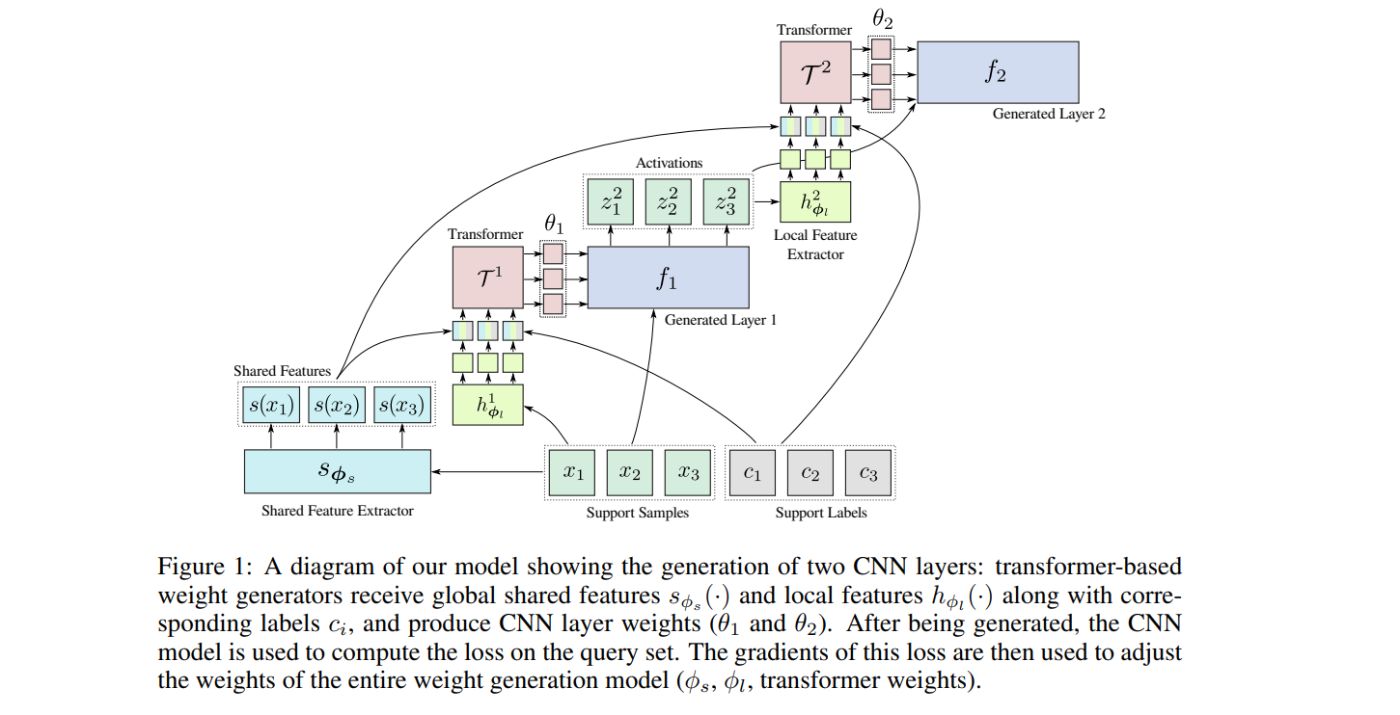

Обучение модели. Модель генерации весов использует набор поддержки для определения весов некоторых или всех слоев модели CNN. Затем вычисляется перекрестная энтропийная потеря для выборок набора запросов, которые проходят через сгенерированную модель CNN. Параметры генерации весов φ (включая модель преобразователя и веса экстрактора общих/локальных признаков) изучаются путем оптимизации этой функции потерь с использованием стохастического градиентного спуска.

3.2 ОБОСНОВАНИЕ МЕХАНИЗМА САМОВНИМАНИЯ

Выбор механизма самообслуживания для генератора веса не является произвольным. Одной из мотивирующих причин этого выбора является то, что выходные данные, создаваемые генератором с базовым самообслуживанием, по своей конструкции инвариантны к входным перестановкам, то есть перестановкам выборок в наборе обучающих данных. Это также делает его пригодным для обработки несбалансированных партий и партий с переменным количеством проб (см. раздел 4.3). Теперь мы покажем, что расчет, выполняемый моделью самообслуживания с правильно выбранными параметрами, может имитировать базовые алгоритмы обучения с несколькими попытками, что еще больше мотивирует ее полезность.

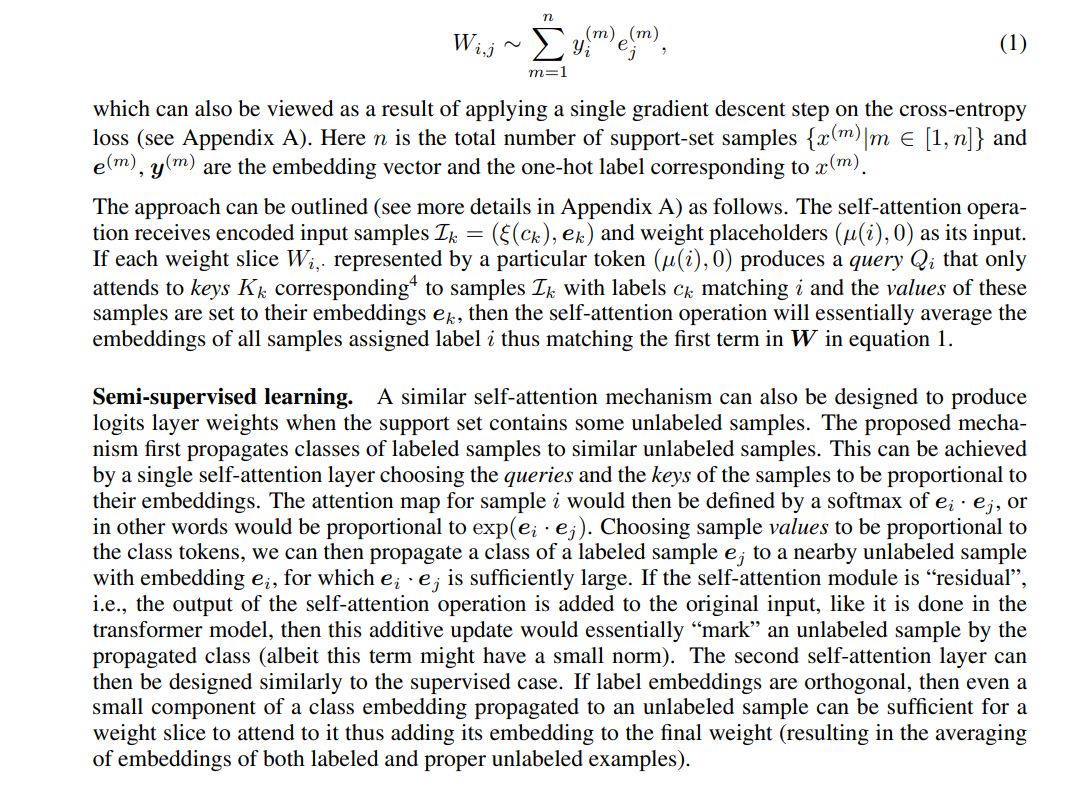

Обучение с учителем. Самообслуживание в своей элементарной форме может реализовать метод, аналогичный взвешиванию выборки на основе косинусного сходства, закодированному в слое логитс[3] с весами W:

[3] здесь мы предполагаем, что вложения e несмещены, т. е. heii = 0

[4] другими словами, уровень самообслуживания должен сопоставлять токены (µ(i), 0) с (ξ(i),...).

Оригинал