Как исследователи использовали обоснованную теорию, чтобы декодировать проблемы спилота

4 июня 2025 г.Таблица ссылок

Аннотация и 1. Введение

2. Методология и 2.1. Исследовательские вопросы

2.2. Сбор данных

2.3. Маркировка данных

2.4. Извлечение данных

2.5. Анализ данных

3. Результаты и интерпретация и 3.1. Тип проблем (RQ1)

3.2. Тип причин (RQ2)

3.3. Тип решений (RQ3)

4. Последствия

4.1. Последствия для пользователей Copilot

4.2. Последствия для команды Copilot

4.3. Последствия для исследователей

5. Угрозы достоверности

6. Связанная работа

6.1. Оценка качества кода, генерируемого Copilot

6.2. Влияние Копилота на практическое развитие и 6.3. Окончательное резюме

7. Выводы, доступность данных, подтверждения, заявление о вкладе и ссылки на кредит

2.4. Извлечение данных

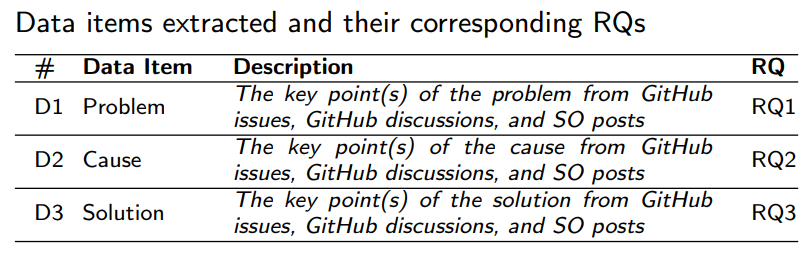

Чтобы ответить на три RQ в разделе 2.1, мы установили набор элементов данных для извлечения данных, как представлено в таблице 1 Эти три элемента данных могут быть извлечены из любой части выпуска GitHub, обсуждения или так, например, название, описание проблемы, комментарии и дискуссии.

2.4.1. Пилотные данные извлечения

Первый и третий автор провел пилотную извлечение данных по 20 случайно выбранным вопросам GitHub, 20 дискуссий и 20 постов, и в случае любых расхождений, второй автор был вовлечен для достижения консенсуса. Результаты показали, что три элемента данных могут быть извлечены из нашего набора данных. Основываясь на наблюдении, мы установили следующие критерии для формального извлечения данных: (1) Если та же проблема была идентифицирована несколькими пользователями, мы записали ее только один раз. (2) Если было выявлено несколько проблем в одном и том же выпуске GitHub, обсуждении GitHub, или около того, мы записали каждый из них отдельно. (3) Для проблемы, в которой указано многочисленные причины, мы записали только причину, подтвержденную репортером проблемы или командой Copilot в качестве основной причины. (4) Для проблемы, в которой есть несколько предложенных решений, мы записали только решения, которые были подтверждены репортером проблемы или командой Copilot, чтобы фактически решить проблему.

2.4.2. Формальное извлечение данных

Первая и третья авторы провели формальное извлечение данных из отфильтрованного набора данных для извлечения элементов данных. Впоследствии они обсудили и достигли консенсуса со вторым автором в отношении несоответствий, чтобы гарантировать, что процесс извлечения данных придерживался заранее определенных критериев. Каждый извлеченный элемент данных несколько раз проверялся тремя авторами, чтобы обеспечить точность. Результаты извлечения данных были скомпилированы и регистрированы в MS Excel (Zhou et al., 2024).

Важно отметить, что не все собранные данные включают причину и решение проблемы. Хотя мы выбрали закрытые проблемы GitHub и ответили на дискуссии GitHub и, таким образом, публикации на этапе сбора данных, специфика каждой части данных значительно варьируется. Иногда респонденты, связанная с копированием, могут предложить решение без подробного анализа этой проблемы, мешая нам извлечь основные причины. В других ситуациях, хотя причина проблемы была идентифицирована, пользователь не описывал конкретный процесс разрешения. Например, пользователь обнаружил, что это копило »Не могу работать правильно на удаленном сервере VSCODE »и понял, что это было из -за«Плохая сеть», но не предоставил никаких подробных решений (обсуждение № 14907). Кроме того, даже когда некоторые ответы предоставили как причины, так и решения, они могут не быть приняты или доказаны в эффективности репортера проблемы или членов команды Copilot. Например, пользователь попросил«Способ создать GitHub Copilot в Google Colab», но пользователь не принял и не ответил на три предложенных ответа (так что #72431032). Поэтому мы не можем рассматривать какой -либо из трех ответов как эффективное решение его проблемы.

2.5. Анализ данных

Чтобы ответить на три RQS, сформулированные в разделе 2, мы провели анализ данных, используя открытые методы кодирования и постоянного сравнения, которые являются двумя широко используемыми методами из заземленной теории во время качественного анализа данных (Stol et al., 2016). Открытое кодирование не ограничивается ранее существовавшими теоретическими структурами; Вместо этого он поощряет исследователей генерировать коды на основе фактического содержания в данных. Эти коды представляют собой описательные суммации данных, направленные на то, чтобы захватить основные темы. В постоянном сравнении исследователи непрерывно сравнивают кодированные данные, динамически переработали и корректируют категории на основе их сходств и различий.

Конкретный процесс анализа данных включает в себя четыре шага: 1) Первый автор тщательно рассмотрел собранные данные, а затем назначил описательные коды, которые кратко инкапсулировали основные темы. Например, проблема в обсуждении #10598 была закодирована как«Прекратил вносить встроенные предложения», о чем сообщил пользователь, который заметил, что его ранее функционирующий копило внезапно прекратил предоставлять предложения кода в Vscode. 2) Первый автор сравнил различные коды, чтобы определить закономерности, общие черты и различия между ними. Благодаря этому итеративному процессу сравнения, аналогичные коды были объединены в типы и категории более высокого уровня. Например, Кодекс обсуждения #10598, наряду с другими кодами akin, сформированный в тип сбоя функциональности, который дополнительно относится к категорииОперацияПолем Как только возникла неопределенность, первый автор участвовал в дискуссиях со вторым и третьим авторами, чтобы достичь консенсуса. Следует отметить, что из -за природы постоянного сравнения как типов, так и категорий прошли несколько раундов уточнения, прежде чем достичь их окончательной формы. 4) Первоначальная версия результатов анализа была дополнительно подтверждена вторым и третьим авторами, и подход согласованного соглашения (Campbell et al., 2013) был использован для решения конфликтов. Окончательные результаты представлены в разделе 3.

Авторы:

(1) Xiyu Zhou, Школа компьютерных наук, Университет Ухан, Ухан, Китай (xiyuzhou@whu.edu.cn);

(2) Пенг Лян (автор -корреспондент), Школа компьютерных наук, Университет Ухан, Ухан, Китай (liangp@whu.edu.cn);

(3) Beiqi Zhang, Школа компьютерных наук, Университет Ухан, Ухан, Китай (zhangbeiqi@whu.edu.cn);

(4) Зенгьян Ли, Школа компьютерных наук, Центральный Китайский Университет, Ухан, Китай (Zengyangli@ccnu.edu.cn);

(5) Аакаш Ахмад, Школа компьютеров и коммуникаций, Университет Ланкастера Лейпциг, Лейпциг, Германия (ahmad.aakash@gmail.com);

(6) Mojtaba Shahin, Школа компьютерных технологий, Университет RMIT, Мельбурн, Австралия (mojtaba.shahin@rmit.edu.au);

(7) Мухаммед Васим, факультет информационных технологий, Университет Цзиваскила, Jyväskylä, Финляндия (muhammad.m.waseem@jyu.fi).

Эта статья есть

Оригинал