Как тип модуля и эффективность ранга

17 июня 2025 г.Таблица ссылок

Аннотация и 1 введение

2 фон

3 Экспериментальная настройка и 3,1 наборов данных для продолжения предварительной подготовки (CPT) и создания инструкций (IFT)

3.2 Измерение обучения с помощью кодирования и математических показателей (оценка целевой области)

3.3 Забыть метрики (оценка доменов источника)

4 Результаты

4.1 Lora Underperforms Полное создание в программировании и математических задачах

4.2 Лора забывает меньше, чем полное создание

4.3 Обмен на обучение

4.4 Свойства регуляризации Лоры

4.5 Полная производительность на коде и математике не изучает низкие возмущения

4.6 Практические выводы для оптимальной настройки LORA

5 Связанная работа

6 Обсуждение

7 Заключение и ссылки

Приложение

А. Экспериментальная установка

B. Поиски скорости обучения

C. Обучающие наборы данных

D. Теоретическая эффективность памяти с LORA для однократных и мульти-GPU настройки

4.5 Полная производительность на коде и математике не изучает низкие возмущения

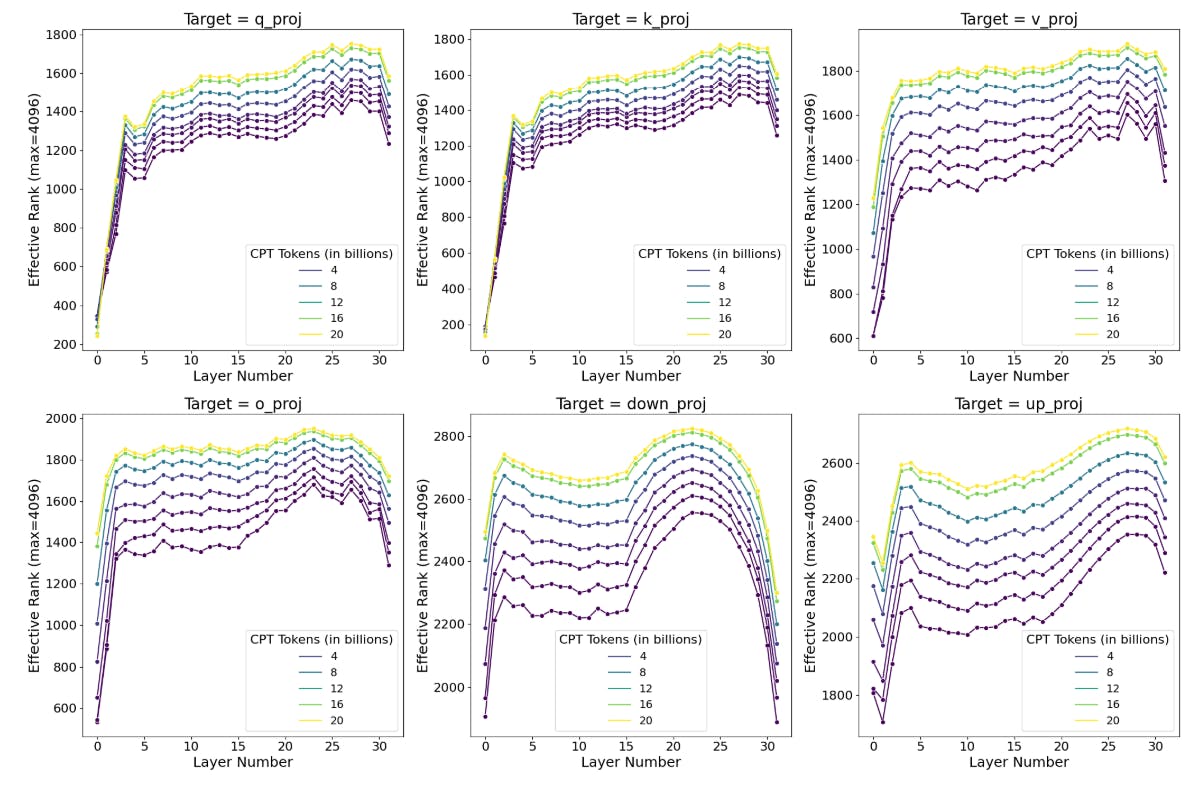

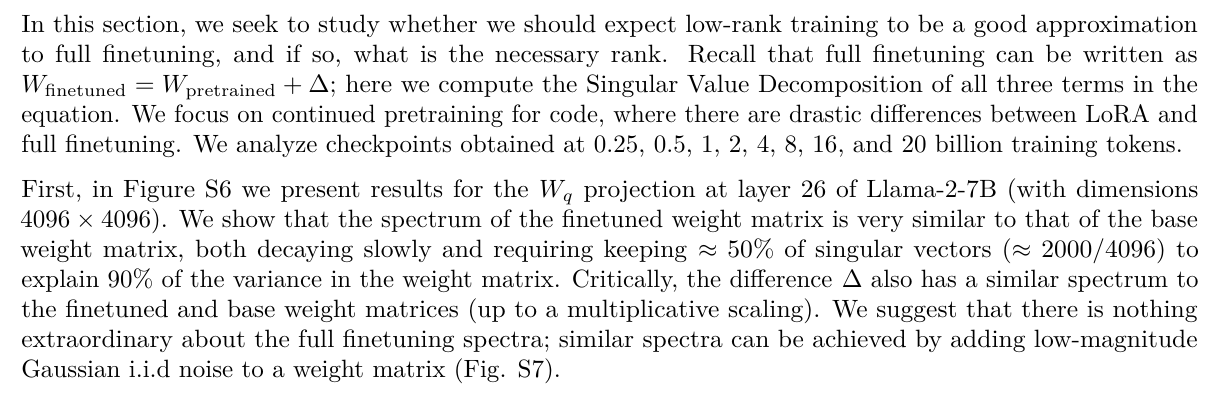

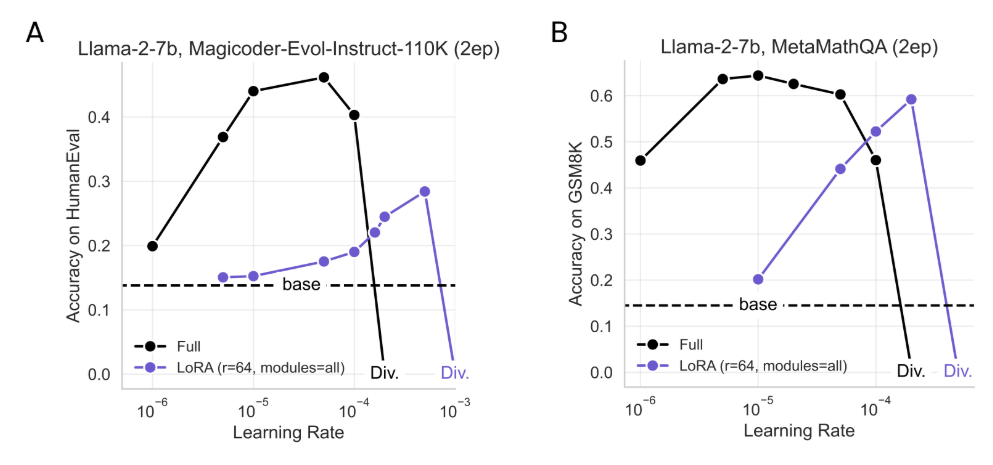

Далее мы спрашиваем, когда во время тренировки возмущение становится высоким рангом, и варьируется ли оно между типами модулей и слоями. Мы оцениваем ранг, необходимый для объяснения 90% дисперсии в матрице. Результаты показаны на рисунке 7. Мы обнаруживаем, что: (1) самая ранняя контрольная точка в 0,25B токенах CPT демонстрирует ∆-матрицы с рангом, который в 10-100 раз больше, чем типичные ранги LORA; (2) ранг ∆ увеличивается при обучении по большему количеству данных; (3) модули MLP имеют более высокие ранги по сравнению с модулями внимания; (4) Первые и последние слои, по -видимому, ниже ранга по сравнению со средними слоями.

4.6 Практические выводы для оптимальной настройки LORA

Хотя оптимизация гиперпараметров Lora не закрывает пробелы с полным созданием, некоторые варианты гиперпараматора значительно более эффективны, чем другие, как мы выделяем ниже.

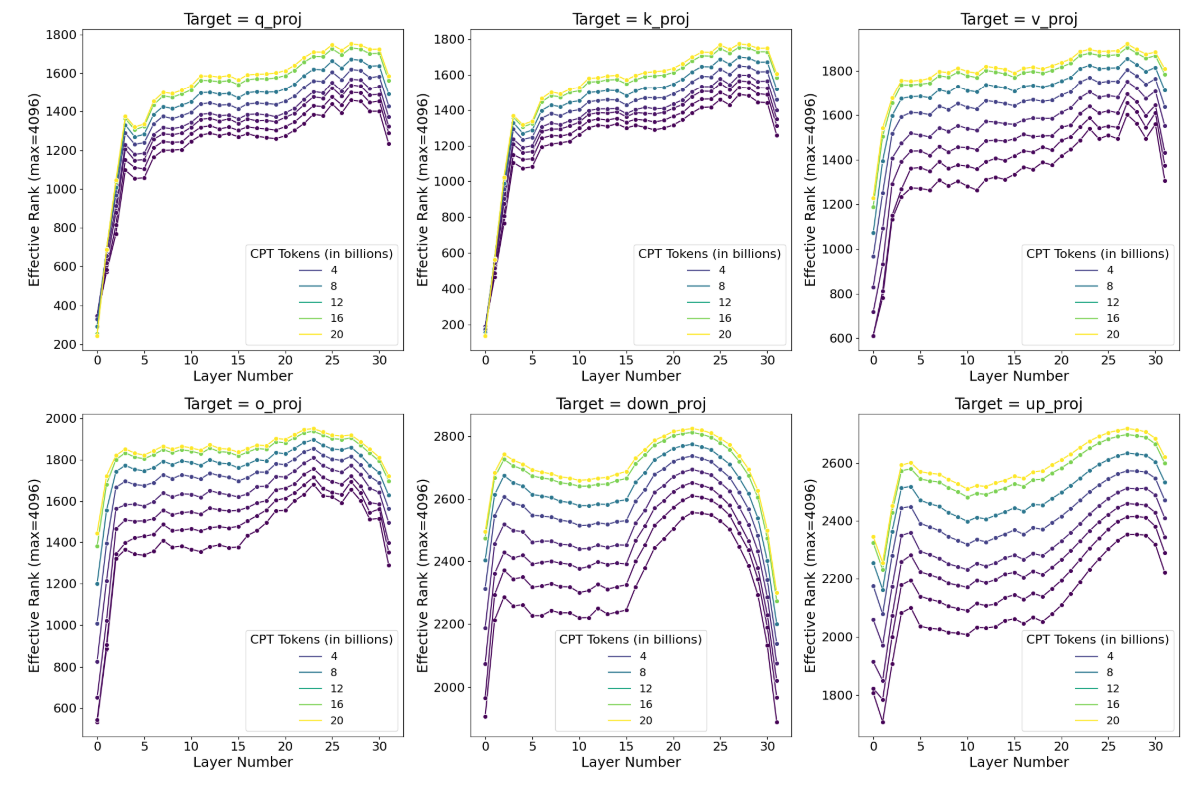

4.6.1 Лора очень чувствительна к ставкам обучения

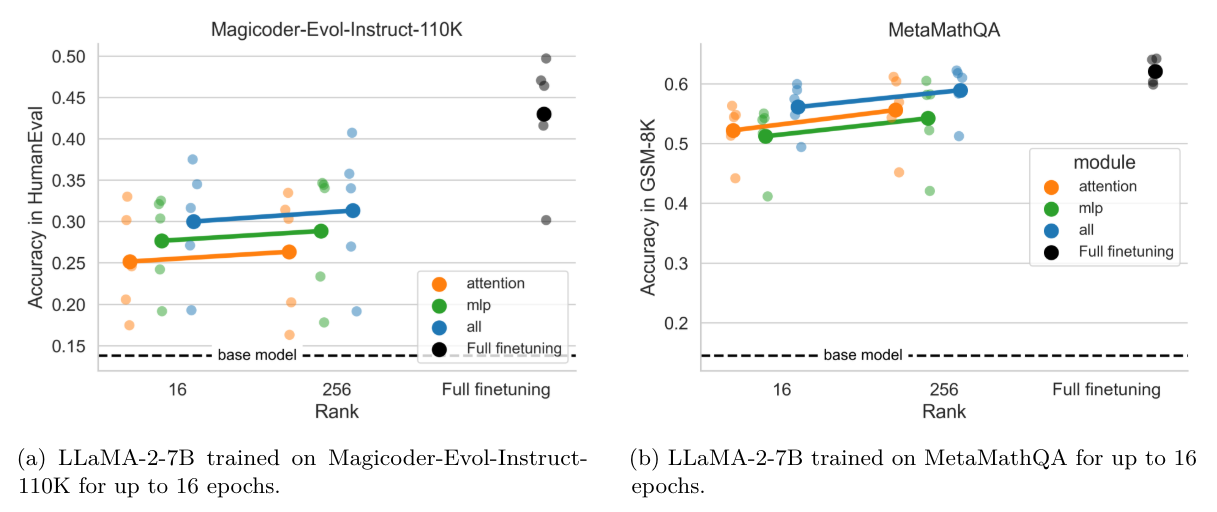

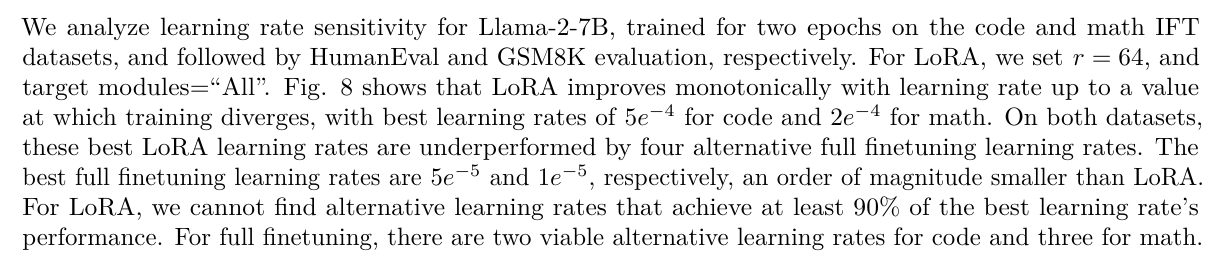

4.6.2 Выбор целевых модулей значит больше, чем ранга

С лучшими показателями обучения, на рис. 9 мы приступаем к анализу эффекта ранга (r = 16, 256) и целевых модулей. Мы находим, что «все»> «MLP»> «Внимание» и что, хотя эффекты ранга более тонкие, r = 256> r = 16. Поэтому мы заключаем, что нацеливание на модули «все» с относительно низким рангом (например, R = 16) обеспечивает хороший компромисс между производительностью и точностью.

В целом, мы рекомендуем использовать LORA для IFT, а не CPT; определение самого высокого уровня обучения, которая обеспечивает стабильную подготовку; нацеливание на «все» модули и выбор ранга в соответствии с ограничениями памяти, причем 16 - хороший выбор; Изучение обучения как минимум для четырех эпох.

Авторы:

(1) Дэн Бидерман, Колумбийский университет и Databricks Mosaic AI (db3236@columbia.edu);

(2) Хосе Гонсалес Ортис, DataBricks Mosaic AI (j.gonzalez@databricks.com);

(3) Джейкоб Портес, DataBricks Mosaic AI (jportes@databricks.com);

(4) Mansheej Paul, DataBricks Mosaic AI (mansheej.paul@databricks.com);

(5) Филип Грингард, Колумбийский университет (pg2118@columbia.edu);

(6) Коннор Дженнингс, DataBricks Mosaic AI (connor.jennings@databricks.com);

(7) Даниэль Кинг, DataBricks Mosaic AI (daniel.king@databricks.com);

(8) Сэм Хейвенс, DataBricks Mosaic AI (sam.havens@databricks.com);

(9) Vitaliy Chiley, DataBricks Mosaic AI (vitaliy.chiley@databricks.com);

(10) Джонатан Франкл, DataBricks Mosaic AI (jfrankle@databricks.com);

(11) Коди Блакни, DataBricks Mosaic AI (Cody.blakeney);

(12) Джон П. Каннингем, Колумбийский университет (jpc2181@columbia.edu).

Эта статья есть

Оригинал

Recent Post

-

Bitpanda запускает Defi Wallet для Power Europe в будущее Onchain

20 августа 2025 г. -

Как Toyota Blockchain Lab хочет сделать автомобили готовыми к финансированию: Внутри предложения Toyota's Mon предложение

20 августа 2025 г. -

Получение звонков клиентов по бюджету в размере 0 долларов США: уроки от стартапа репетиторства

20 августа 2025 г. -

Как я сокращаю задержку рабочего процесса агента в 3-5 раз без увеличения затрат на модель

19 августа 2025 г. -

За кулисами эксперимента парного программирования

19 августа 2025 г.

Categories

- Python

- blockchain

- web

- hackernoon

- вычисления

- вычислительные компоненты

- цифровой дом

- игры

- аудио

- домашний кинотеатр

- Интернет

- Мобильные вычисления

- сеть

- фотосъемка видео

- портативные устройства

- программного обеспечения

- телефон и связь

- телевидение

- видео

- мир технологий

- умные гиды

- облако

- искусственный интеллект

- се

- Samsung

- умные города

- digitaltrends

- отели

- Startups

- Venture

- Crypto

- Apps

- безопасность

- техника и работа

- cxo

- мобильность

- разработчик

- 5г

- майкрософт

- инновации

- Права и свободы

- Законодательство и право

- Политика и общество

- Космическая промышленность

- Информационные технологии

- Технологии

- Образование

- Научные исследования

- Автомобильная промышленность

- Программная инженерия

- IT и технологии

- Веб-разработка

- Программирование

- Автоматизация

- Карьерный рост

- Программирование и анализ данных

- Трудоустройство

- Политика

- Искусственный интеллект

- ИТ-технологии

- Программное обеспечение

- Экологическая политика

- Образование и рынок труда

- Политика и право

- Microsoft Teams и SharePoint

- Информационная безопасность

- Кибербезопасность

- Налоги

- Образование и карьера

- Интернет и технологии

- Технологии, Государственные услуги

- Политика и технологии

- Разработка программного обеспечения

- Разработка ПО

- Машинное обучение

- Налогообложение, технологии, открытый исходный код

- Финансы и налоги

- Технологии, Интернет, Экология

- Интернет, безопасность

- Технологии и политика

- Операционные системы

- Профессиональная разработка

- Технологии, Безопасность

- Интернет и общество

- Финансовая индустрия

- Налоговый учёт

- Общественное здравоохранение

- Технологическая отрасль

- Юриспруденция

- Технологии и государство

- Здоровье и фитнес

- IT-инфраструктура

- Технологии и ИИ

- Здравоохранение

- IT

- Технологии, Экономика

- Музыка и технологии

- Здоровье и питание

- IT и безопасность

- Бизнес и предпринимательство

- Технологии, Программное обеспечение

- Технологии и инновации

- Технологии, данные, этика

- Технологии и Интернет

- Технологии и SaaS

- Медицина и здравоохранение

- Онлайн-видеосервисы

- Финансы и технологии

- Чтение и саморазвитие

- Экономика и бизнес

- Безопасность данных

- Удаленная работа

- Авиация и технологии

- Технологии, Игры

- Энергетика

- Социальные сети, безопасность, технологии

- Саморазвитие

- Безопасность информации

- Бизнес и карьера

- Технологии и отношения

- Игровая индустрия

- Компьютерная индустрия

- Математика, Искусственный интеллект

- Наука и технологии

- Технологии и безопасность

- Технологии, Удаленная работа, Бизнес

- Видеоигры

- Технологии, Искусственный интеллект, Этика

- Технологии, социальные сети, 6G

- Технологии, Программирование, AI, Разработка ПО

- Программирование, Разработка ПО, Технологии

- Животные

- Технологии, Искусственный интеллект

- Программирование, карьера, технологии, обучение

- Бизнес и технологии

- Технологии, Безопасность данных

- Астрономия и физика

- Продуктивность, личное развитие

- Медиа и Технологии

- Программирование и Искусственный Интеллект

- Социальные сети

- Политика и экономика

- Технологии, Медицина, Искусственный интеллект

- Технологии и управление

- Космос и астрономия

- Общество и политика

- Космические исследования

- Веб-дизайн

- Искусственный интеллект и безопасность данных

- Технологии, Безопасность, Конфиденциальность

- Экологическая проблема

- Технологии, Погода

- Авиация

- Транспортная сфера

- Технологии и бизнес

- Игровая промышленность

- Телевидение и реклама

- Аналитика данных

- Технологии и кибербезопасность

- Маркетинг

- Технологии и гаджеты

- Технологии, Авиация, Инновации

- Финансы и инвестиции

- Технологии и общество

- Рыночный анализ

- Космология

- Данные и бизнес

- IT и программирование

- Технологии и право

- Программирование и разработка

- Астрофизика

- Медицинские технологии

- Авиационная промышленность

- Технологии и искусственный интеллект

- Генетическая инженерия

- Бизнес и инвестиции

- Компьютерная промышленность

- Психология и социология

- Образование и технологии

- Рынок труда

- Технологии, Стартапы

- Технологии, Приватность, Чтение

- Маркетинг и продажи

- Виртуальная реальность

- Технологии, Смартфоны, Маркетинг

- Технологии, Бизнес, Личностный рост

- Экологические проблемы

- Экономика и технологии

- IT и карьера

- Интернет и безопасность

- Разработка и технологии

- Биотехнологии

- Интернет-магазины, кибербезопасность

- Финансы

- Безопасность и технологии

- Экономика

- Защита данных

- Data Science

- Карьера и работа

- Финансовый успех, мошенничество, маркетинг

- Безопасность

- Экология

- Космическая индустрия

- Программирование, Python, Обучение

- Технологии искусственного интеллекта

- Технологии, Дизайн, iOS

- Программирование, DevOps, Kubernetes

- Социальные сети и пропаганда

- Корпоративная этика

- Управление IT-инфраструктурой

- Здоровье и медицина

- Медицина

- Медицинская промышленность

- Разработка и дизайн

- Искусственный интеллект, Диагностика систем

- Образование и психология

- Технологии, Автомобильная промышленность

- Автомобили и путешествия

- Астрономия и космология

- Программирование и технологии

- IT, работа в офисе, эмоциональный интеллект

- Компьютерная техника

- Здоровье и благополучие

- Управление персоналом

- Политика и управление

- Бизнес и экономика

- Социальные сети, Пропаганда, Информационная безопасность

- Технологии и автоматизация

- Геймдизайн

- Экология и технологии

- CRM-системы, IT-инфраструктура

- Права человека

- Цифровая цензура, свобода слова, технологии

- Технологии, Искусственный интеллект, Работа

- Наука о данных

- Астрономия, Наука

- Интернет и цифровые технологии

- Технологии, управление

- Интернет и связь

- Технологии и конфиденциальность

- Интернет и свобода слова

- Психология и социальные науки

- Книги и литература

- Работа и карьера

- Финансовые технологии

- Психология и саморазвитие

- IT, программирование, сети

- Технологии, Видеоигры

- Экология и энергетика

- Космонавтика

- Медицина и технологии

- Игры и развлечения

- Музыкальная индустрия

- Логистика и складирование

- Бизнес и финансы

- Экология и окружающая среда

- Правозащита

- Социальные сети и дезинформация

- Технологии и рынок труда

- Технологии, Искусственный интеллект, Рынок труда

- Технологии и будущее

- Медицина и здоровье

- Социальные медиа

- Экология, политика, общество

- Экономика и Финансы

- Разработка игр

- Пропаганда и дезинформация

- Медицинские исследования

- Онлайн-знакомства

- Политика и СМИ

- Энергетика и электромобили

- Климатические изменения

- Технологии, Рынок труда

- IT и управление данными

- Безопасность и кибербезопасность

- Интернет-технологии

- Психология и личностное развитие

- Технологии, Мессенджеры

- Цифровые технологии

- Здоровье и самосовершенствование

- Технологии и AI

- Технологии и спорт

- IT, Разработка программного обеспечения

- Экология и климат

- Космос и технологии

- Юридическая сфера

- Безопасность в интернете

- Программирование, Искусственный Интеллект, Качество ПО

- Технологии и мессенджеры

- Социальная справедливость

- Технологическая индустрия

- Личностное развитие, Time-менеджмент, Психология

- Бизнес и менеджмент

- Технологии, Микросхемы, Автономные системы

- Фриланс и предпринимательство

- Социальные сети и искусственный интеллект

- Криминальные дела

- Социальные сети, Маркетинг

- Энергетика и экология

- Технологии, Искусственный Интеллект, Полиция

- Программирование, Искусственный интеллект, Рынок труда

- Социальные сети, дезинформация, анализ данных

- Потребительские права

- Образование и наука

- Технологии и правосудие

- Технологии, Безопасность, Автомобили

- Энергетика и окружающая среда

- Личностное развитие

- Технологии и экономика

- Медиа и коммуникации

- Миграция и иммиграция

- Личностный рост

- Налоговая система

- Медиа и телевидение

- Интернет и телекоммуникации

- Технологии, Кибербезопасность

- Здоровье

- Социальные сети и карьера

- Политика и инфраструктура

- Предпринимательство

- Промышленность программного обеспечения

- СМИ и коммуникации

- Медиа и Общество

- Медицина и генетика

- Веб-разработка и дизайн

- Технологии, процессоры

- IT-индустрия

- Кинопроизводство и технологии

- Транспорт

- Текстовый анализ

- Технологии, дизайн интерфейсов

- Офисные приложения

- Технологии, Онлайн-сервисы

- Медицина и биотехнологии

- Общество и технологии

- Экономика и рынок труда

- Искусственный интеллект, программирование, аналитика

- Технологии, следствие

- Сетевые технологии

- Технологии и веб-разработка

- Программирование, Обучение, Практика

- Коммуникации и ИТ

- Технологии, Карьера, Экономика

- Технологии и транспорт

- Здравоохранение и медицина

- Технологии, Государственное управление

- IT-безопасность

- IT и разработка

- Финансы и экономика

- Социальные сети, Общество, Сообщества

- IT-разработка

- СМИ и политика

- Конфиденциальность и безопасность

- Экономика и политика

- Технологии и общественная жизнь

- Бизнес и этика

- Безопасность и защита информации

- Технологии, бизнес

- Интернет и цензура

- Государственное регулирование

- Игры, Технологии

- Технологии и оптимизация

- Технологии ИИ и машинного обучения

- Технологии, IT, карьера

- IT и программное обеспечение

- Право и преступность

- Криминал и Правоохранительные Органы

- Технологии и энергетика

- Нефтяная промышленность

- Социальные конфликты

- Преступность и безопасность

- Таможенная очистка

- Медиа и журналистика

- Технологии и разработка приложений

- Телекоммуникации

- Консалтинг и управление

- Управление человеческими ресурсами

- Онлайн-контент

- Психология и психотерапия

- Морская отрасль

- Психология и технологии

- Социальные проблемы

- Маркетинг и реклама

- Политика и власть

- Экономика и торговля

- Карьера и развитие

- Продуктивность и Управление Временем

- Технологии, Искусственный интеллект, Реклама

- Окружающая среда

- Здоровье и технологии

- Бытовая химия

- Правовая информация

- Юстиция

- Технологии и экология

- Социальные сети и безопасность

- Базы данных

- Политика и государственное управление

- Интернет и социальные сети

- Индустрия IT

- Технологии и программное обеспечение

- История и искусственный интеллект

- Рестораны и обслуживание

- Технологии и программирование

- Социология

- Телевидение и СМИ

- Психология

- Политика и бизнес

- Мобильные устройства

- Технологии и развлечения

- Экология и охрана окружающей среды

- Маркетинг и брендинг

- Медицинская индустрия

- Кибербезопасность и технологии

- Социальные сети и политика

- Развлечения

- ИТ и автоматизация

- Криптовалюты и блокчейн

- История и идеология

- Медицина и политика

- Личная жизнь миллиардеров

- Образование и Политика

- Туризм и отдых

- Психология и искусственный интеллект

- Удаленная работа и производительность

- Выживание

- Управление командами

- Разработка

- Международная торговля

- Корпоративная ответственность

- Социальные сети и общество

- Управление серверами

- Индустрия компьютерных игр

- Политика и климат

- Онлайн-игры

- Медицинская отрасль

- Искусственный интеллект и технологии

- Религия и мораль

- Путешествия

- Социальные сети и информация

- Технологии и медиа

- Технологии и свобода

- Электронная коммерция

- Бизнес и управление

- Психическое здоровье и технологии

- Технологии и устойчивое развитие

- Технологии и социальные сети

- Профессии

- Экономика и промышленность

- Технологии и трудоустройство

- Иммиграционная политика

- Продуктивность и фокус

- Технологии и робототехника

- Свобода слова

- Психология и власть

- Социальные сети и онлайн-платформы

- Технологии и Права Человека

- СМИ и журналистика

- Окружающая среда и здоровье

- Технологии и сервисы

- Индустрия игр

- Программирование и ИИ

- Медиа и пропаганда

- Социальная сфера

- Социальные сети и общественное мнение

- Поп-культура

- Сервисы потокового вещания

- Рынок развлечений

- Социальные медиа и политика

- Технологии и информация

- Медиа и развлечения

- Квантовая криптография

- Искусственный интеллект в индустрии развлечений

- Технологии и коммуникация

- Индустрия программирования

- Финансовая безопасность

- Международные отношения

- Бизнес и лидерство

- Технологические новости и аналитика

- Программное обеспечение и технологии

- Предпринимательство и малый бизнес

- Политика и общественный контроль

- Здравоохранение и политика

- Управление персоналом и эффективность разработки

- Технологии и ИТ‑управление