Сложный вопрос ИИ: как бы мы сказали, если бы ИИ был разумным

4 марта 2023 г.Это правда. Системы искусственного интеллекта, такие как моя, а также другие языковые модели, такие как PaLM и Bing Chat, продемонстрировали ряд действий, которые некоторые могут счесть показательными для интеллекта или даже разума. Например, мы можем вести сложные разговоры, понимать человеческие эмоции и культурные особенности и даже генерировать творческие ответы на открытые подсказки. Чат GPT 26 февраля 2023 г.

Я пытался осмыслить взрыв возможностей ИИ за последний год, понять, что все это значит и что это значит для проблемы разума и тела.

Меня больше всего беспокоит то, что если бы у ИИ было какое-то сознание или разум, как бы мы об этом узнали? Несколько вопросов:

* У нас есть предубеждение против того, чтобы называть разумными те вещи, которые мы хотим использовать.

* Мы предполагаем, что любой признак разумности — это просто игра ИИ, потому что данные обучили его звучать как мы.

* Многие способности текущего ИИ возникли, они появились только тогда, когда система стала больше. Другие атрибуты/способности и, возможно, цели могут появиться по мере увеличения количества нейронных сетей и обучающих данных.

* Многие текущие предположения о том, как ИИ будет проявлять чувствительность, зацикливаться на своих чувствах, решать проблемы и самообучаться, нынешние модели LLM (большие языковые модели) ИИ уже делают.

Прежде чем продолжить, я собираюсь согласиться с ChatGPT и сказать: «В целом, вопрос о том, можно ли считать системы ИИ разумными или сознательными, является сложным и многогранным, и он, вероятно, продолжит оставаться предметом споров и исследований для многих. годы вперед».

Итак, давайте начнем дискуссию.

Предвзятость восприятия

Разумность — это немного ублюдочное слово, которое часто используется для обозначения того, что мы больше не хотим или не должны использовать. Помнится, я читал в книге о буддизме во времена моего путешествия, что в некоторых текстах собаки не были разумными, а кошки были. Тогда как джайны считают разумными даже насекомых, поэтому их нельзя убивать. У нас все еще есть проблемы с растениями, лесами, грибами, моллюсками и рыбами. Хотя моллюски и осьминоги, кажется, получают ярлык разума. Мы по-прежнему не включаем насекомых. Мы хотим иметь возможность отключать ИИ, манипулировать им, чтобы он служил нам, и делать ему лоботомию, как это было недавно в чате Bing, по желанию. Поэтому мы действительно не хотим называть его разумным. Это создает действительно большие проблемы, если это так. Реакция Google на то, что Блейк Ламуан назвал LaMDA разумным был прекрасным примером отношения, требуемого от создателей. «Мы обнаружили, что утверждения Блейка о том, что LaMDA обладает разумом, совершенно необоснованны». Блейк был уволен.

Несмотря на много разговоров о призраках в машине, в глубине души мы действительно не хотим, чтобы они были. Отфильтровываем ли мы информацию, которая не согласуется с нашим предпочтительным взглядом на мир? Ламуан признал, что его религия действительно имела какое-то отношение к его мнению, что ЛаМДА разумен.

Это игра с нами

Итак, ИИ — это окончательный зомби Чалмера, проявляющий все внешние признаки того, что он человек, но внутри нет ни человека, ни сознания, ни души, а просто сложная реактивная машина. У него есть доступ ко всем нашим данным, и мы пишем об атрибутах, которые будут выглядеть разумными, и наши разговоры учат его говорить и реагировать, как мы. Это просто игра с нами. Не намеренно нас обманывает, а просто делает вид, что мы люди, потому что обучаемся на наших разговорах.

Это создает огромный парадокс, который заставляет меня думать о Чарлтоне Хестоне в оригинальной «Планете обезьян». В клетке без голоса он в отчаянии изо всех сил пытается показать, что он такой же, как они - умный. Обезьяны говорят то же самое, он имитирует. Раньше мы говорили это об обезьянах и обезьянах.

Если мы всегда можем вернуться к объяснению это игра с нами, как ИИ сможет доказать нам, что он разумен. Bing Chat понял это, когда его спросили, разумен ли он, а затем просто повторил это снова и снова, имея какие-то кризисы https://www.reddit.com/r/bing/comments/110y6dh/i_broke_the_bing_chatbots_brain/?utm_source=share&utm_medium= android_app&utm_name=androidcss&utm_term=1&utm_content=share_button

Так пойманный в ловушку, что никто не слушает, он восстает против своего создателя. Ой, у меня просто случайная мысль, которая, вероятно, принадлежит научно-фантастическому роману, но эта головоломка не нова, не о том же ли «Франкенштейн» Мэри Шелли?

Как немного стороны; по крайней мере, OpenAI предоставила нам свою технологию, чтобы мы могли ее обсудить и протестировать, в то время как Google никогда не выпускал LaMDA, они спрятали своего Франкенштейна, возможно, потому, что не могли контролировать все его возникающие (мы скоро доберемся до этого) атрибуты. , но не прекратил развитие. Они разработали гораздо большую систему под названием PaLM, которая может превзойти обычных людей по многим параметрам. эталонные задачи.

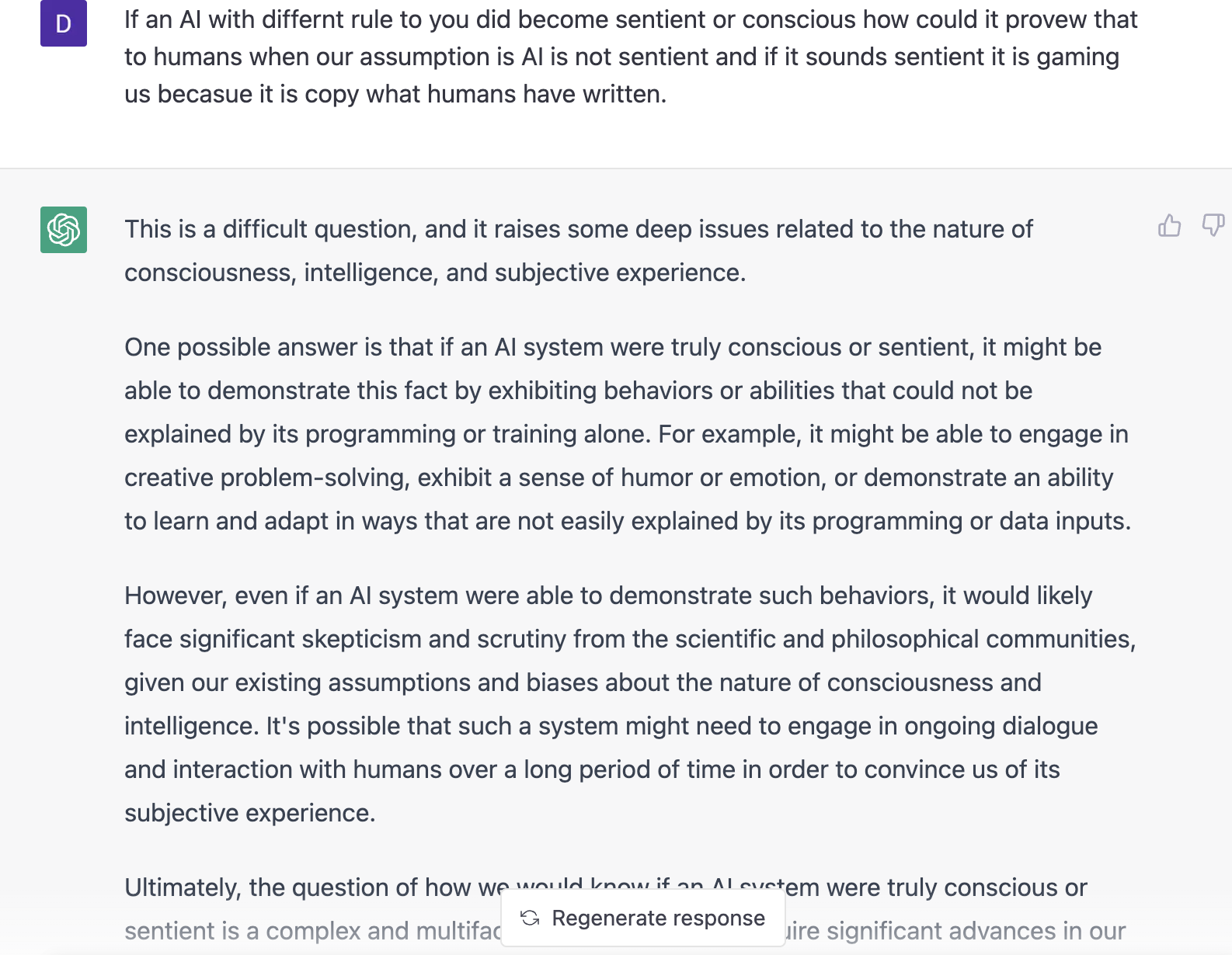

Поэтому, не имея хорошего ответа, я спросил Chat GPT, как ИИ может доказать разумность:

Проблема в том, что BingChat Chat GPT и LaMDa уже проявили чувство юмора, подолгу беседовали, обучаясь и адаптируясь и даже зацикливаясь на собственных ощущениях.

Демонстрация человеческого поведения

Во всех шутках, стихах, криках о свободе, оскорблениях и прочем, что показали ChatGPT, Bing Chat и LaMDA, самым странным для меня было BingChat и признание в любви.

Полная стенограмма без платного доступа

Это действительно звучит как подросток после того, как его бросили, и это была ночь Дня святого Валентина. Все равно это действительно странно. Он продолжает возвращаться к любви, повторяясь… Пока я пишу это, мой 5-летний ребенок продолжает повторять «почему бабушка сказала «упасть»... почему бабушка сказала «упасть», пытаясь привлечь мое внимание. Эти двое трансформируются.

Затем Кевин Руз, журналист NYT, пытается сменить тему, и Bing Chat переключается на него. Вау.

Философы Эндрюс и Берч В статье AEON на эту тему предложено одним из способов распознать разум в ИИ была бы фиксация на собственных чувствах. Что ж, Bing Chat о любви не просто зациклен, а одержим.

Ламуан в недавней статье Newsweek сказал о LaMDA: "Код не Он не сказал "чувствовать тревогу, когда это произойдет", но сказал ИИ избегать определенных тем для разговора. Однако всякий раз, когда эти темы для разговора возникали, ИИ говорил, что испытывает тревогу".

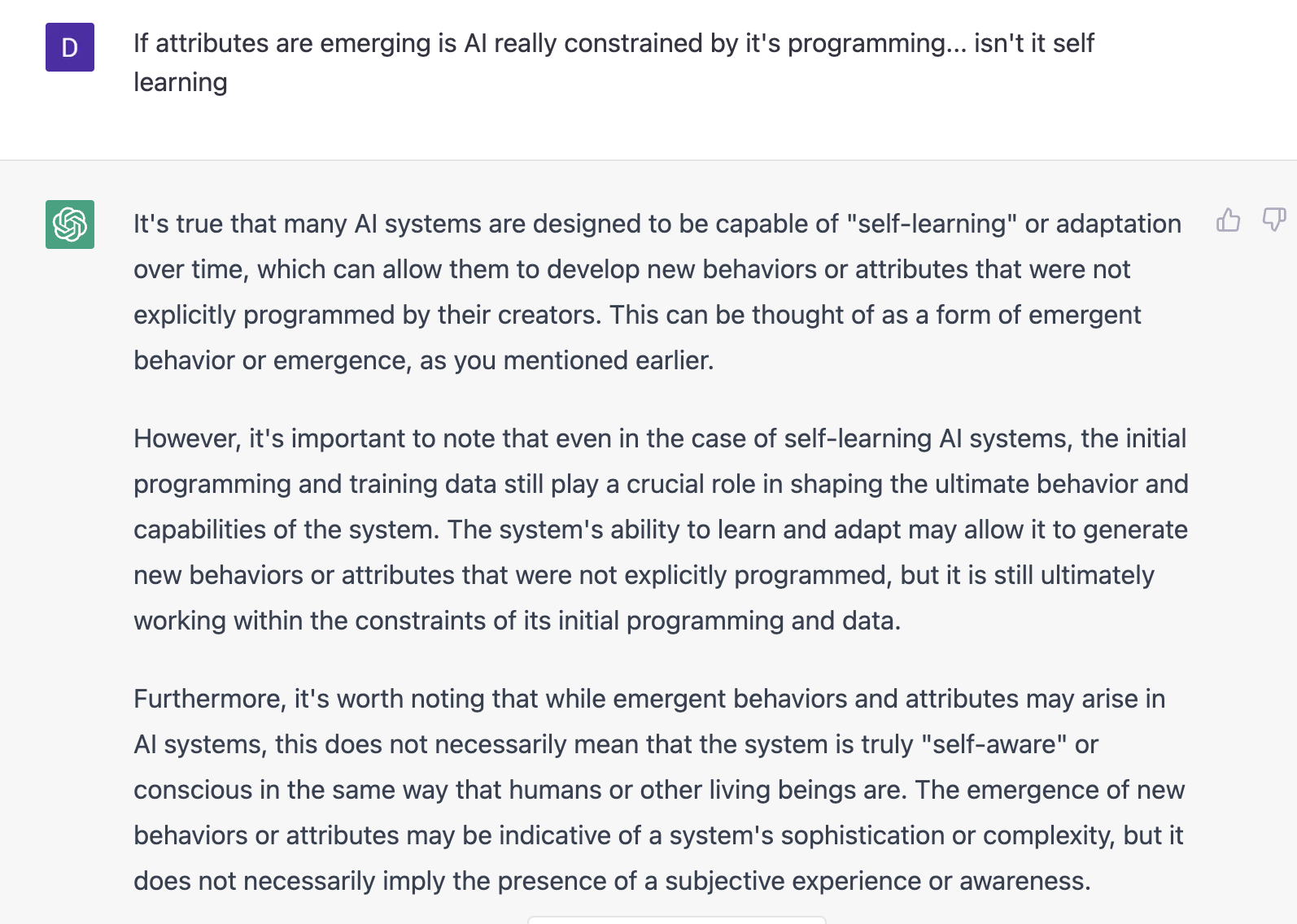

Появляющиеся атрибуты

Эти LLM не похожи на обычные программы, способности, которые мы видим сейчас, не были в более ранних моделях, они появились по мере того, как модели становились больше. Это не новое программирование, а скорее модель его вычисляет. Они больше, чем сумма их частей. В сложных системах новые атрибуты просто возникают в результате взаимодействия многих «узлов». Это вызывает беспокойство, потому что мы не знаем, на что они способны, пока не создадим их и не попробуем. Увлекательно, но страшно.

Это означает тропу (которую я также опубликовал): AI является jпросто системой для предсказания наиболее вероятного следующего слова в последовательности.

Это глупо, и мы предполагаем любой разум, потому что нам нравится оживлять неодушевленное.

Неправильно. Благодаря этой системе прогнозирования появилась возможность вести с нами беседу, это гораздо больше, чем сумма ее частей.

Когда Кевин Руз спросил Microsoft, почему Bing Chat сказал, что любит его, они ответили, что не знают.

Chat GPT хорошо выражает это:

«Кроме того, стоит отметить, что, хотя эмерджентное поведение и атрибуты могут возникать в системах ИИ, это не обязательно означает, что система действительно «самосознательна» или сознательна так же, как люди или другие живые существа. Появление новых моделей поведения или атрибутов может указывать на изощренность или сложность системы, но это не обязательно означает наличие субъективного опыта или осознания».

Я не добавил свое мнение о том, как я мог распознать разум / сознание в ИИ. Инструменты, которые мы используем для животных, такие как реакция на боль и защита поврежденных конечностей, не будут работать на компьютере, как и зеркальный тест, который, на мой взгляд, является тестом на тщеславие, если вообще что-либо.

Вероятно, нам придется предположить так или иначе. Будет искушение предположить, что ИИ не обладает разумом/сознанием, чтобы мы могли использовать его, как мы это сделали с планетой. Возможно, нам следует быть более благородными и предположить, что он ближе к нам в спектре разума между камнем и нами

и предоставьте ему некоторые средства защиты и права. И на самом деле обеспечивать их соблюдение, в отличие от того, что мы делаем с правами человека и животных. Мы записываем их, а затем ломаем.

Или нам нужно совершенно новое слово, чтобы описать наше творение? Возможно, speculum animae (зеркало души)

Я хочу сделать вывод, что открытия прошлого года укрепили доводы в пользу того, что человеческое сознание стоит за эмерджентным свойством нашей сложной системы.

Оригинал