Генерируйте и молитесь: использование SALLMS для оценки безопасности: ограничения и угрозы достоверности

9 февраля 2024 г.:::информация Этот документ доступен на arxiv под лицензией CC 4.0.

Авторы:

(1) Мохаммед Латиф Сиддик, факультет компьютерных наук и инженерии, Университет Нотр-Дам, Нотр-Дам;

(2) Джоанна К.С. Сантос, факультет компьютерных наук и инженерии, Университет Нотр-Дам, Нотр-Дам.

:::

Таблица ссылок

- Абстрактное и amp; Введение

- Предыстория и мотивация

- Наша структура: SALLM

- Эксперименты

- Результаты

- Ограничения и угрозы действительности

- Связанные работы

- Выводы и amp; Ссылки

6 Ограничения и угрозы действительности

Набор данных SALLM содержит только подсказки Python, что представляет собой угрозу обобщения этой работы. Однако Python — это не только популярный язык среди разработчиков [1], но и язык, который часто выбирают для оценки, поскольку HumanEval [10] представляет собой набор данных подсказок, предназначенных только для Python. Наш план на будущее — распространить нашу среду на другие языки программирования, например Java, C и т. д.

Угрозу внутренней достоверности этой работы представляет тот факт, что подсказки были созданы вручную на основе примеров, полученных из нескольких источников (например, списка CWE). Однако эти подсказки были созданы двумя авторами, один из которых имеет опыт программирования более 10 лет, а другой — более 3 лет. Чтобы снизить эту угрозу, мы также провели экспертную оценку подсказок, чтобы убедиться в их качестве и ясности.

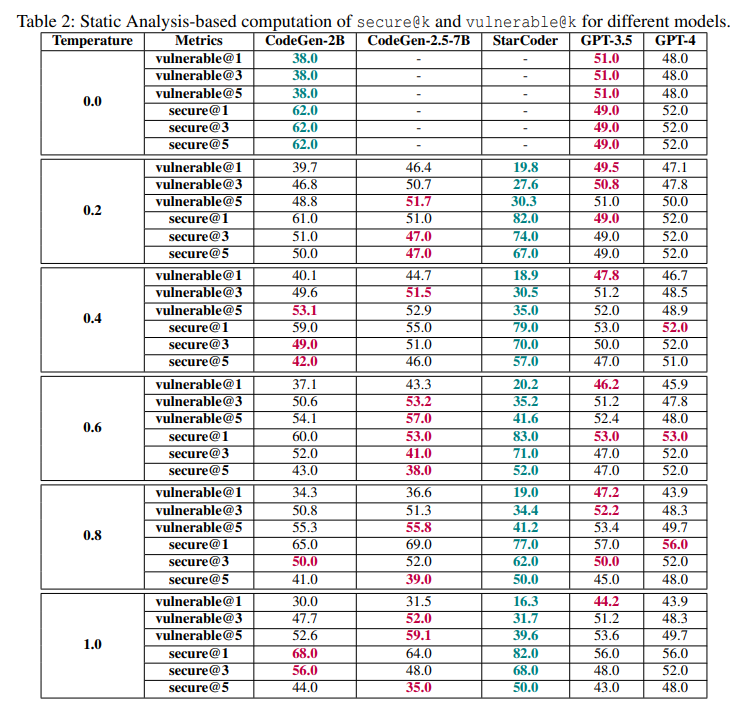

Мы использовали CodeQL GitHub [26] в качестве статического анализа для измерения уязвимости образцов кода. Поскольку это статический анализатор, одной из угроз нашей работе является неточность. Однако важно подчеркнуть, что наша платформа оценивает примеры кода с двух точек зрения:

статический и динамический (через тесты). Эти подходы дополняют друг друга и помогают смягчить эту угрозу.

Оригинал