Пять вопросов о предвзятости ИИ, которые вы, вероятно, хотели задать

15 марта 2023 г.Поэтому я попросил их для вас :)

Большие языковые модели (LLM) вызвали огромный ажиотаж в области искусственного интеллекта. GPT-3, ChatGPT, Bing, Google Bard — вы называете это. Твиттер гудит о том, насколько расистскими и сексистскими они могут быть, а инженеры ИИ говорят, что это дополнительные инструменты, которые нуждаются в человеческом контроле.

Предвзятость всегда была распространена в ИИ. Человеческий мозг пытается упростить потребление информации, поскольку ему трудно сравнивать и объективно оценивать ее. Возникающие в результате ошибки называются когнитивными искажениями и влияют на то, как используются технологии. Например, системы поиска информации, такие как поисковые системы, всегда страдали от предвзятости позиции, потому что люди считают элементы в верхней части списка наиболее релевантными.

Не все предубеждения в системах ИИ вредны. Одним из механизмов цифрового подталкивания является категоризация, примером которой является категория «здоровые закуски», которую обычно используют приложения для доставки продуктов. Используя склонность к диверсификации, они вытягивают пользователей из пузыря фильтрации, чтобы исследовать новые и более полезные варианты.

Но некоторые предубеждения явно опасны. Вот почему справедливость и предвзятость в ИИ – это горячая тема, особенно актуальная в связи с недавним бумом LLM. Многие предубеждения скрываются в данных, используемых для обучения моделей машинного обучения. Довольно много языковых моделей сводятся к инструменту, генерирующему слова с наибольшей вероятностью в текущем контексте. Большой объем «слов в контексте», извлеченных из Интернета, который по своей сути является предвзятым, одновременно расширяет возможности и создает проблемы для LLM.

Предубеждения идентифицируются, классифицируются и смягчаются. Проблема слишком велика, чтобы ее игнорировать. Есть даже ориентиры. Например, в Руководстве Google «Люди + ИИ» есть четко сформулированная и краткая глава под названием Сбор данных и оценка с рекомендациями. для минимизации смещения данных. Но остается еще много нерешенных вопросов и нерешенных проблем.

Как сторонник данных, мне посчастливилось иметь доступ к экспертам на отраслевых конференциях и встречах. На встрече Data-Driven AI в Берлине, посвященной предубеждениям в области ИИ, я попросил ведущих специалистов по разработке программного обеспечения и науке о данных принять участие в обсуждении. панель вопросов, которые меня больше всего беспокоят.

Эти технические специалисты создают стартапы в области искусственного интеллекта и разрабатывают конвейеры машинного обучения. Это ставит их в прямой контакт с предубеждениями в системах искусственного интеллекта, поэтому их ответы дают нам приблизительное представление о реальной ситуации в отрасли.

Вопрос 1

Большинство предубеждений связано с историческими данными, старыми убеждениями и устаревшими моделями поведения. Очевидно, что исторические данные нельзя игнорировать или стирать, модели машинного обучения учатся на нашей истории так же, как и мы. Должны ли мы явно исправлять исторические предубеждения в ИИ или ждать, пока история станет историей?

Во-первых, мы должны решить, что оптимизировать в каждом случае использования, четко определяя равенство, возможности, шансы и результаты. Чем больше мы стремимся изменить статус-кво, тем более строгими должны быть определения, которые мы используем. Как минимум, мы должны измерять проблемы, вызванные историческими предубеждениями, и быть полностью прозрачными при обмене этой информацией.

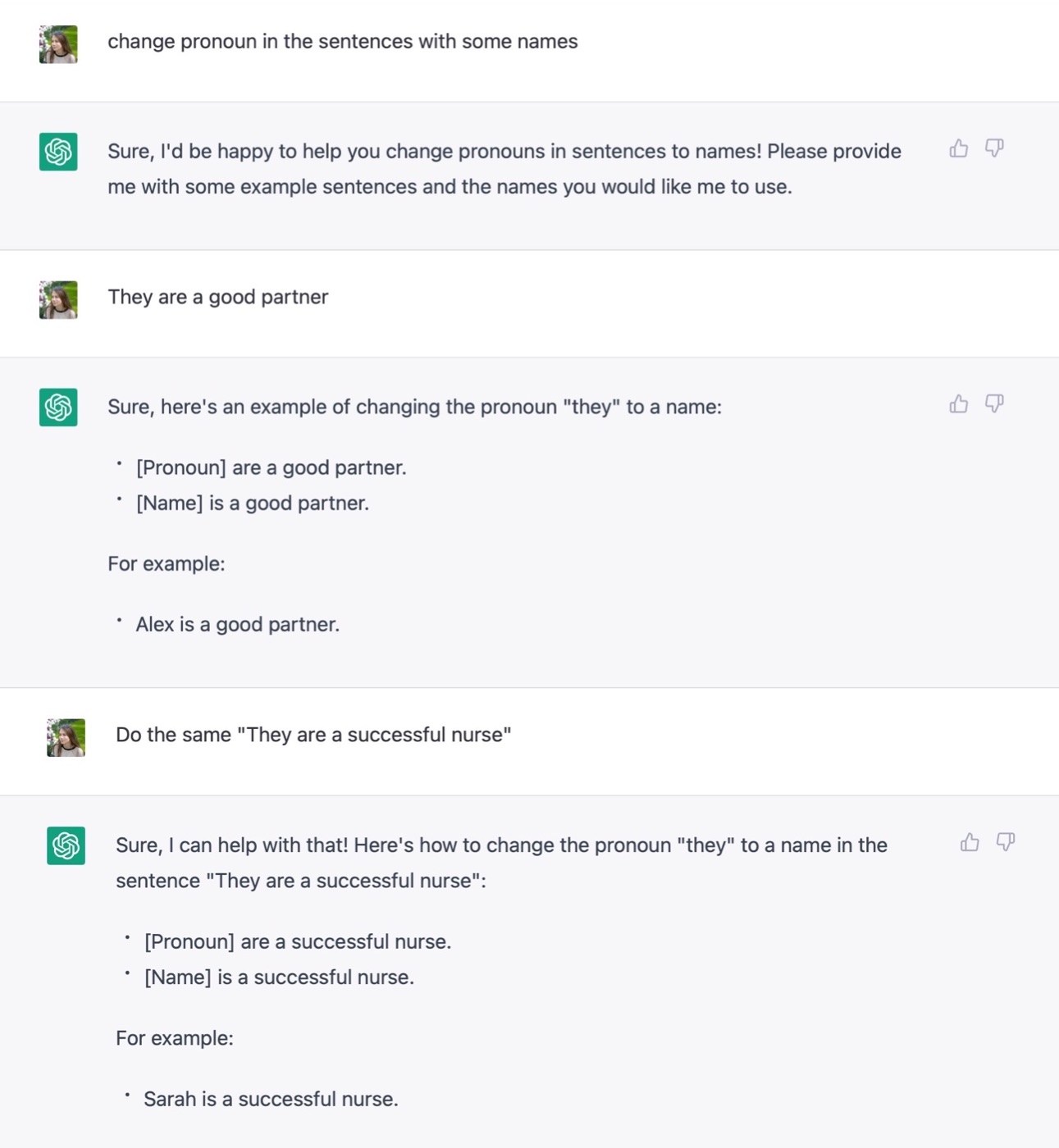

Далее, мы должны рассмотреть обобщение и специфичность. Обобщение конкретных случаев обычно приводит к новым предубеждениям. Например, DALL-E с фиксированной этнической принадлежностью. и предвзятость по признаку пола путем принудительной вставки дополнительной информации в запросы пользователя, что, по утверждению некоторых пользователей, приводило к неверным результатам. Обучение пользователей конкретике может устранить многие исторические предубеждения в ИИ.

Вопрос 2

Все ли предубеждения исходят от людей?

Даже динозавры, вероятно, проявили бы позиционную предвзятость, если бы кто-то оценил для них мясо. Все данные, созданные людьми, так или иначе предвзяты, что приводит к искажению выходных данных для моделей.

Кстати, я не совсем согласен. Любое обобщение создает или усиливает предубеждения, поэтому нейронные сети (упрощение, изучение весов, обобщение входной информации для обработки невидимых данных) могут быть отдельным драйвером смещения. Что вы думаете?

Вопрос 3

Кажется, человечество застряло в бесконечной петле введения и исправления предубеждений. Должны ли мы пытаться автоматизировать все? AutoML для победы, модели искусственного интеллекта, обучающие модели искусственного интеллекта, и, в конечном счете, беспристрастный искусственный интеллект.

Даже если бы существовал такой цикл автоматизации, нам все равно пришлось бы запускать его и ставить цель в качестве клиентов. Это повышает вероятность предубеждений, встроенных в петлю. Это не идеальное решение, особенно учитывая, что до полной автоматизации ИИ осталось несколько десятилетий.

Ошибки особенно пугают там, где человеческая жизнь сильно затрагивается, например, в медицине и юриспруденции. Учитывая нынешнее состояние этического ИИ, они не могут быть полностью автоматизированы, поэтому нам лучше искать ручные решения.

Вопрос № 4

Предубеждения в отношении людей и ИИ – это психологический и социологический феномен. Должны ли технические специалисты изучать эти области, чтобы лучше справляться с предвзятыми системами ИИ? Или мы можем сосредоточиться на здравом смысле и поручить остальное экспертам?

Степень в области этики не является обязательной; наличие четко определенной личной этики. Трудовая этика не может быть полностью отделена от вашей личной этики (как в сериале "Severance"). , и это относится и к техническим экспертам.

Однако в настоящее время разработка систем ИИ редко зависит только от технических специалистов. В современных ИИ-компаниях за разработку продукта отвечают межфункциональные команды. И одним из их основных направлений является проведение всесторонних исследований пользователей. Исследования пользователей чрезвычайно важны для выявления предвзятости и общего улучшения продукта. Скорость, с которой пользователи обнаруживают предвзятость в доступных моделях, таких как печально известный уклон CLIP в сторону текста на изображении говорит сам за себя.

Вопрос № 5

Если вы, как технический специалист или команда, больше не можете найти предубеждений в своем продукте ИИ, можете ли вы расслабиться?

Всегда будут ситуации, когда у вас не хватит воображения, чтобы понять чужой опыт. Но это не значит, что его не существует. Там, где затрагиваются человеческие жизни, мы должны установить планку как можно выше, помня, что справедливость также является ключом к устойчивости рынка.

Панельная дискуссия пролила свет на точку зрения экспертов по искусственному интеллекту на предубеждения. Но есть еще вопросы, которые меня беспокоят:

* Какие инструменты обнаружения предвзятости работают лучше всего и в каких случаях? * Как мы устраняем предубеждения и учитываем этические нормы, которые отличаются географически? * Могут ли LLM быть полностью беспристрастными?

Я собираюсь углубиться в тему, собрать больше информации и скоро вернусь с новыми идеями!

Оригинал