Развертывание вашей первой модели машинного обучения в производстве? Вот что вам нужно знать

17 февраля 2023 г.ChatGPT достиг миллиона пользователей всего за пять дней, по сравнению с двумя с половиной месяцами, которые потребовались Instagram, и двумя-тремя годами для Netflix, Airbnb и Twitter. Таким образом, многие изучают способы включения достижений AI/ML в свои приложения. Microsoft объявила о планах интегрировать ChatGPT в все свои продукты, а на прошлой неделе они запустили Bing< /a> и Edge со встроенным ChatGPT. Salesforce также недавно выпустила Einstein. Судя по всему, половина текущего пакета YCombinator теперь состоит из стартапов, работающих с ChatGPT. За, казалось бы, короткое время в области искусственного интеллекта быстрыми темпами происходят значительные инновации. Со всей этой шумихой вы планируете внедрить AI/ML в свой продукт?

https://twitter.com/gokulr/status/1620577528867074048?embedable=true

Если вы начинаете развертывание готового к работе решения машинного обучения, которое можно эффективно масштабировать для тысяч пользователей, вот несколько тем, которые следует рассмотреть:

Обработка данных

Новички часто недооценивают усилия, необходимые для обработки данных при работе с реальными наборами данных. На таких платформах, как Kaggle, Coursera и HackerRank, наборы данных обычно чисты, а функции почти не нуждаются в предварительной обработке. Наоборот, может потребоваться несколько дней, чтобы просто передать и собрать воедино все необработанные данные еще до того, как вы начнете. Возможно, вам придется разбить данные на более мелкие фрагменты и соединить их вместе позже. Прерывания соединения или потеря процесса на полпути при обработке больших наборов данных часто приводят к огромным потерям времени.

Будьте готовы потратить больше времени на поиск, обработку и преобразование данных, чем на работу с моделью. Обеспечение правильной маркировки данных, оптимизация их качества и использование правильных функций могут оказать большее влияние на ваши результаты, чем улучшение вашей модели. На самом деле поиск и обработка данных настолько важны и сложны, что превратились в целую отрасль. Крупные организации нанимают сотни людей из стран с низким уровнем заработной платы для маркировки своих данных, а компании сосредотачиваются на сохранении отношений с клиентами.

Источник данных

Реальные данные могут быть очень скудными, особенно если это не данные, которые вы собирали от пользователей с течением времени. Источник многофункциональных данных необходим для создания эффективной модели и представляет собой сложную задачу: стартапы, предоставляющие высококачественные данные для обучения, такие как Scale AI, оцениваются в миллиарды. Будучи признанным потребительским продуктом с миллионами пользователей и точек данных, данные могут быть ценным рвом на рынке — создание конвейера данных из существующих проприетарных данных может быть относительно проще.

Однако для начинающих стартапов источники данных и доступный объем могут быть ограничены. В промышленности это широко известно как проблема холодного пуска. При отсутствии значительного объема данных первой задачей является выделение ресурсов для обнаружения и построения конвейера данных. Приготовьтесь найти надежные источники данных, такие как открытые репозитории или API, имеющие отношение к вашей проблеме.

Наличие ограниченных данных не обязательно должно быть проклятием, в зависимости от отрасли. Иногда даже при небольшом количестве данных модели ИИ могут быть удивительно эффективными. Эндрю Нг, основатель Landing AI, Coursera и Google Brain, говорит, что на рынках без масштабов потребительского программного обеспечения в Интернете "< a href="https://fortune.com/2021/07/30/ai-adoption-big-data-andrew-ng-consumer-internet/">хорошие данные побеждают большие данные".

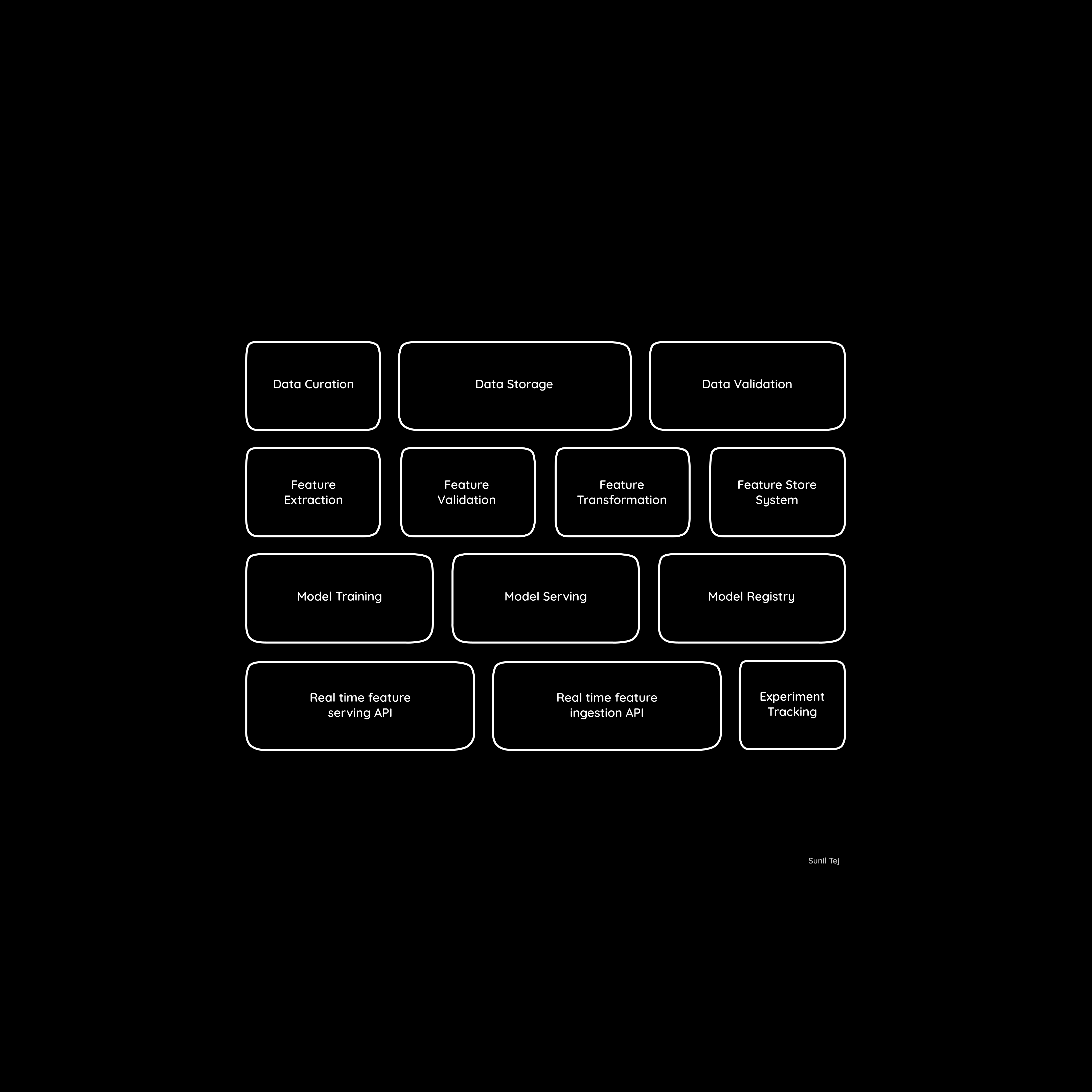

Техническая инфраструктура

Построение модели машинного обучения и работа над алгоритмами — это только часть гораздо более масштабного процесса. Чтобы развернуть вашу модель в масштабе, вам нужна необходимая техническая инфраструктура для интеграции машинного обучения в ваше приложение. В зависимости от размера вашего набора данных и вашей технической инфраструктуры запуск моделей машинного обучения может занять много времени для вычисления результатов. Чтобы предоставить пользователям результаты в режиме реального времени, вы не можете позволить им ждать, пока вы запускаете модель и вычисляете результаты на лету. Вместо этого может потребоваться предварительное вычисление результатов и планирование необходимой инфраструктуры хранения для обслуживания пользователей с помощью API по запросу.

Показатели

Среднеквадратичное отклонение (RMSD), индекс Жаккара и другие методы оценки полезны для сравнения эффективность различных алгоритмов при решении автономных задач. Однако одной лишь оптимизации RMSD или точности недостаточно, когда вы имеете дело с набором алгоритмов, необходимых для реального продукта.

Успех вашего решения машинного обучения должен измеряться с помощью метрик продукта, демонстрирующих реальные доказательства. Например, алгоритмы Facebook и Instagram оптимизируют взаимодействие пользователей — количество времени, которое пользователь тратит на прокрутку видео или изображения. Рекомендации YouTube оптимизируются в зависимости от количества минут просмотра перед выходом из рекомендаций. Для вас и вашей команды крайне важно отслеживать правильный показатель для оптимизации, а не тратить силы на усовершенствование модели, которое может не совсем помочь вашему бизнесу.

Клиентоориентированный подход

Возможно, вы создали самую точную модель машинного обучения для набора данных, но если она не решает проблему клиента, она бесполезна. Затем ваша модель становится технологией поиска проблемы, что никогда не бывает правильным подходом. Вам нужна убедительная причина того, почему AI/ML является важным строительным блоком для решения проблемы клиента. Клиенты не столько беспокоятся о технологии, сколько о том, решит ли она их проблему. Эндрю Нг рекомендует компаниям не создавать ИИ в первую очередь: компании должны строиться с учетом миссии и клиентов, а не технологий.

Во многих случаях искусственный интеллект может решить только часть проблемы. Например, Stitchfix использует искусственный интеллект для подбора персонализированных рекомендаций по стилю. чтобы облегчить работу куратора-человека в поиске правильного уникального решения для клиента. Несмотря на то, что рекомендации по стилю изначально проверяются ML от миллионов до нескольких сотен, куратор-человек принимает окончательное решение о том, что положить в коробку, чтобы клиент мог попробовать. Это связано с тем, что AI/ML не может оценивать эмоционально или на основе неуловимых данных, таких как контекст.

Наем

Учитывая темпы инноваций в области искусственного интеллекта и машинного обучения и доступные возможности, многие считают работу в области машинного обучения привлекательной карьерой. Однако, если вы нанимаете людей, не имеющих опыта работы с реальными наборами данных, вы можете обжечься. Опытные инженеры данных, которые, возможно, не работали с передовыми алгоритмами, как исследователи, часто оказываются более подходящими для быстрого вывода решений на рынок. Исследователи, как правило, хороши в анализе данных, но им может не хватать навыков, необходимых для обработки больших наборов данных и создания готовых к использованию решений.

Для небольших команд частые эксперименты и быстрая поставка имеют решающее значение для успеха. Чем больше экспериментов вы отправляете, тем лучше вы сможете анализировать результаты и, следовательно, улучшать свою модель машинного обучения. Наличие неопытных членов удерживает вас от быстрого продвижения, а также снижает моральный дух команды. Чтобы создать сильную команду машинного обучения, вам нужен баланс хакеров, которые могут быстро поставлять модели, и опытных инженеров данных, которые знают, как анализировать и работать с огромными наборами данных из реального мира.

Инструменты машинного обучения

Инструменты и библиотеки машинного обучения, такие как Tensorflow, scikit-learn и PyTorch, избавили от необходимости писать эффективные алгоритмы, широко используемые сегодня. Однако важно иметь четкое представление об основах и нюансах того, как различные алгоритмы подходят к конкретному набору данных. В дополнение к знакомству с инструментами, ключевым фактором, который отличает хорошего специалиста по данным, является способность разбивать данные на кусочки — интуитивное предвидение и способность обнаруживать закономерности, которые в противном случае могли быть упущены из виду из-за огромного размера данных. данные. Опытный глаз может заметить эти узоры за считанные минуты, а нетренированный может вообще не заметить их на недели.

Каждая из вышеперечисленных тем заслуживает тщательного изучения. Если вам интересно узнать больше, прочитайте, как Instagram создает свою ленту. и как Stitchfix строит свои алгоритмы. Чтение технических блогов – отличный способ получить представление о том, как масштабируется масштабируемое развертывание машинного обучения.

Наконец, вот несколько вопросов, которые следует рассмотреть, когда вы начинаете внедрять AI/ML в производство:

- Достаточно ли у вас данных?

- Если у вас нет данных, можете ли вы найти значимые ресурсы для создания релевантных данных для вашей проблемной области?

- Если вы строите существующую техническую архитектуру, как в нее вписывается инфраструктура машинного обучения? Какие усилия и ресурсы потребуются?

- Какой наименьший проект вы можете построить, если его результаты оправдывают вложенные ресурсы?

- Решает ли ваша модель реальную проблему клиента и оказывает ли значимое влияние на показатели вашего продукта?

Оригинал