Дипфейки: настоящая угроза кибербезопасности

14 ноября 2022 г.Технологии растут экспоненциально. С 1960-х и 1970-х годов скорость и мощность компьютеров обычно удваивались каждые полтора-два года.🚀

Но сегодня мы говорим не об этом!

<цитата>Прежде чем я начну, я хотел бы задать вопрос⁉

Вы видели видео, в котором Марк Цукерберг хвастается тем, что полностью контролирует украденные данные миллиардов людей?

https://youtu.be/Ox6L47Da0RY?embedable=true

Или видео с Сильвестром Сталлоне (Рокки), вставленным в роль Маколея Калкина в «Один дома»?😂

https://youtu.be/2svOtXaD3gg?embedable=true

Или видео с имитацией Моргана Фримена, которое выглядит таким реальным?😮

https://youtu.be/oxXpB9pSETo?embedable=true

Или популярное музыкальное видео Кендрика Ламара, в котором он превращается в О. Дж. Симпсон, Канье Уэст, Джусси Смоллетт, Уилл Смит, Коби Брайант и Нипси Хассл.🔥🔥

https://youtu.be/uAPUkgeiFVY?embedable=true

<цитата>Если да, то вы видели «дипфейк».

Что такое дипфейк?

Deepfake – это видео человека, который подвергся цифровым манипуляциям таким образом, что он выглядит кем-то другим. Дипфейки могут использоваться злонамеренно для распространения ошибочной информации.

Это ответ XXI века фотошопу. Он использует подмножество машинного обучения под названием «Глубокое обучение» для создания изображений/видео поддельных событий, отсюда и название «Глубокое подделка».

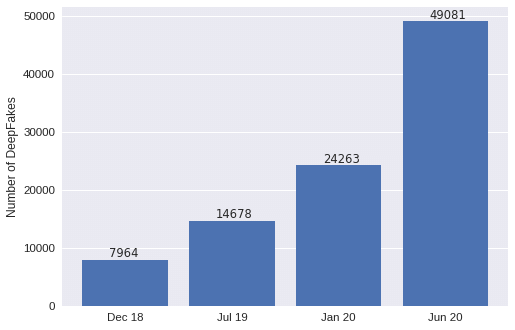

Его использование растет в геометрической прогрессии, и это может представлять угрозу для кибербезопасности.

Источник: Судип Танвар

Источник: Судип Танвар

Происхождение Deepfake

В 1997 году Кристоф Бреглер, Мишель Ковелл и Малкольм Слейни создали программу для автоматизации того, что некоторые киностудии могут делать с переписыванием видео.

На основе аудиовыхода программа также могла создавать свежие лицевые анимации. Эта программа была основана на более ранней работе, которая распознавала лица, создавала звук из текста и создавала первую реалистичную трехмерную модель губ. В конечном итоге отслеживание движения продвинулось так же, как и лицевая анимация. Face2Face от Мюнхенского технического университета и Synthesizing Obama Project от Вашингтонского университета были опубликованы совсем недавно, в 2016 и 2017 годах.

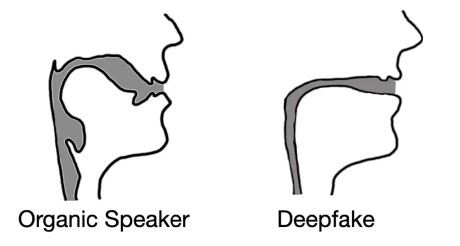

Без звука Face2Face проецирует рот актера на цель, но более ранние исследования касались синтеза человеческих голосов. Источник: Синтезирующий проект Обамы

Самым большим достижением проекта было то, что брови субъекта не двигались, когда звук переставал воспроизводиться. Раньше глубокую подделку было легче увидеть, потому что было неестественно, когда брови субъекта продолжали двигаться, пока он молчал.

Самым поразительным аспектом проекта было то, сколько времени потребовалось для вычисления 66-секундного видео с использованием NVIDIA TitanX и Core i7-5820. Этот процесс занимает всего несколько часов на стандартном оборудовании.

Существует угроза кибербезопасности

Действительно, у дипфейков есть хорошее применение, например, для улучшения медицины и образования в целом за счет создания инструментов обучения.

Его можно использовать в медицине для предоставления фиктивных пациентов, чьи данные можно использовать в исследовательских целях. Это защитит информацию о пациентах и поощрит автономию, предлагая исследователям релевантные данные.

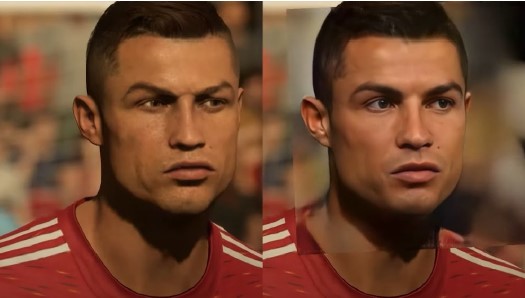

Он также довольно популярен в игровой индустрии. Графика, созданная искусственным интеллектом, может повысить скорость производства игр.

Теперь дипфейки представляют угрозу кибербезопасности для бизнеса, поскольку они могут повысить эффективность фишинговых атак и компрометации корпоративной электронной почты (BEC), облегчить мошенничество с идентификацией и исказить репутацию компании в достаточной степени, чтобы вызвать неоправданное снижение стоимости акций.

Некоторые преступники обладают необходимыми навыками для создания и использования убедительных дипфейков. Прогнозируется, что преступность как услуга будет продолжать расширяться и совершенствоваться «параллельно с современными технологиями, что приведет к автоматизации таких преступлений, как взлом, состязательное машинное обучение и дипфейки», согласно Европол.

Угрозы дипфейков делятся на четыре основные категории:

- социокультурный (вызывающий социальную нестабильность и массовую поляризацию)

- юридическое (искажение электронных доказательств)

- личное (домогательства и издевательства, порнография без согласия и эксплуатация детей в Интернете)

- стандартная кибербезопасность (вымогательство, мошенничество и манипулирование финансовыми рынками).

Поддельные фотографии на поддельных паспортах затрудняют их обнаружение. Затем их можно использовать для поддержки различных дополнительных преступлений, таких как торговля людьми, кража личных данных, незаконная иммиграция и поездки террористов.

Вымогательство может осуществляться посредством ложных обвинений в постыдном или незаконном поведении. Если приманка включает видео или голосовую запись надежного знакомого, фишинг может выйти на новый уровень. Нападения BEC могут сопровождаться видеосообщением и голосом, которые звучат точно так же, как известная фигура организации, например, генеральный директор. Манипулирование рынком по-прежнему представляет собой наиболее серьезную угрозу.

<цитата>Страшно, правда?💀

Как защититься от дипфейков?

- Начните с акцента на щеках и лбу. Кожа может казаться слишком морщинистой или слишком гладкой.

- Старение кожи идентично старению волос и глаз? дипфейки часто имеют несоответствующие размеры.

- Посмотрите на брови и глаза. Вы можете увидеть тени там, где и ожидали. дипфейкам часто не удается точно передать естественную физику сцены.

- Могут быть блики, поэтому обратите внимание на очки. Когда человек движется, обратите внимание на то, как меняется угол блика, потому что дипфейки часто не могут точно имитировать реальную физику освещения.

- Обратите внимание на наличие или отсутствие растительности на лице. Эта растительность на лице выглядит реалистично? Усы, бакенбарды или борода могут быть добавлены или удалены с помощью дипфейков. Подтяжка лица с помощью дипфейков часто не является полностью естественной.

- Обратите внимание на родинки на лице.

- Не моргайте. Человек моргает слишком много или недостаточно?

- Обратите внимание на размер и цвет губ, поскольку они не могут быть пропорциональны остальной части лица человека.

Наконец, Deepfake в настоящее время вызывает озабоченность, но в ближайшие несколько лет они станут еще хуже.

Я надеюсь, что в долгосрочной перспективе мы сможем бороться с этой опасностью, которая окружает нас!

н

н

н

н

н

п

н

Оригинал