Обнаружение глубоких черт: нейронные сети сражаются сами

15 июля 2025 г.Человеческое воображение - сложная вещь.Эй, «Если ты можешь мечтать об этом, ты можешь это сделать», верно? Ну, научно-фантастические писатели и провидцы представляли это на протяжении десятилетий, и вот мы. Несколько смущенные дети, не совсем уверены, что Санта перед нами настоящим. Его борода выглядит белой, живот там, подарки, и он выглядит достаточно добрым ... но можем ли мы доверять своим глазам или ушам, в этом отношении?

Каждый день я работаю, чтобы убедиться, что нейронные сети служат нам - в играх, в блокчейне и за его пределами. Но реальность такова, что мы уже живем в мире, гдеЭти же сети могут украсть ваше лицо, ваш голос, даже вашу репутацию.А что еще более страшно? Почти невозможно сказать эти подделки, кроме реальной вещи.

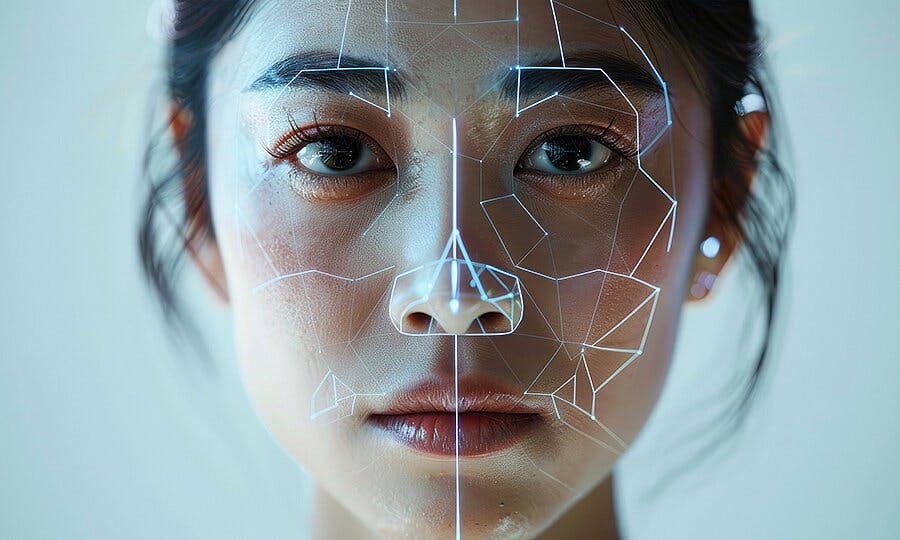

DeepFakes очень реальные, и это не эпизод «Черное зеркало». Мы можем пойти так далеко, чтобы воссоздать и дублировать людей в цифровом виде, практически невозможным. По иронии судьбы, что нам нужно для борьбы с DeepFakes, - это другие агенты искусственного интеллекта.

Борьба с огнем или ироническая петля реализма ИИ

== К 2025 году реализм DeepFake достиг совершенно нового уровня. == Раса вооружений между генераторами ИИ и детекторами стала ключевым доверительным кризисом, причем каждый прогресс в поколении опередил нашу лучшую защиту.

Передовые диффузионные модели и инструменты для текста в Video (например, клоны Sora, Heygen или D-ID) теперь позволяют легко генерировать ультрареалистичные фальшивые видео из подсказки. Эта технология уже просачивалась в неожиданные места, такие как Web3: мошенники использовали глубоководные основатели крипто -основателей, чтобы увеличить продажи токенов, и даже игровые трейлеры могут быть созданы, чтобы обмануть не существующие проекты.

Тем временем, большие технологии пытаются не отставать. Google

Но проблема в том, что мы обучаем ИИ разоблачить ИИ, но к тому времени, когда она узнает, другая модель уже лучше лжет. Это игра с кошками и мыши-ту, где наше чувство реальности-это детская площадка. В эпоху Deepfakes большой вопрос не в том, можете ли вы доверять тому, что видите, а как долго вы можете доверять своим глазам.

Обнаружение Решение. Нам нужно более быстрое обучение

Обнаружение глубокого фарма не так просто, как определить один очевидный сбой.Убедительная подделка-это сложная смесь тонких факторов: движение глаз, микроэкспрессии лица, текстура кожи и даже крошечные несоответствия между синхронизацией губ и аудио. Каждый слой реализма делает обнаружение в геометрической прогрессии.

Обнаружение глубокого фарма не так просто, как определить один очевидный сбой.Убедительная подделка-это сложная смесь тонких факторов: движение глаз, микроэкспрессии лица, текстура кожи и даже крошечные несоответствия между синхронизацией губ и аудио. Каждый слой реализма делает обнаружение в геометрической прогрессии.

Там нет такой вещи, как универсальный детектор Deepfake - каждая модель ИИ так же хороша, как набор данных, на который он был обучен. Например, Meta Image Inspector настраивается на изображения, но он может пропустить видео или аудио подделки, изготовленные с современными диффузионными моделями, такими как Gen-3-3 или Sora.

Но даже эти водяные знаки могут быть обрезаны или изменены. Вынос? Spotting DeepFakes - это не ловкость одного недостатка - это объединение десятков подсказок и доказывание подлинности, прежде чем подделки могут стать вирусными. В этой гонке AI Arms Metadata могут быть нашей последней линией защиты от мира, где мы ничего не доверяем и не сомневаемся во всем.

Никакая глубокая доля не пройдет. Как компании держат подделки

Когда DeepFakes может появиться где угодно, от фальшивых видео AMA до поддельных игровых трейлеров, компании вынуждены играть в цифровые телохранители 24/7.Многие проекты Studios и Web3 теперь экранируют пользовательский контент (UGC) от игроков и влиятельных лиц, дважды проверяя каждый клип для признаков фальсификации ИИ.

Когда DeepFakes может появиться где угодно, от фальшивых видео AMA до поддельных игровых трейлеров, компании вынуждены играть в цифровые телохранители 24/7.Многие проекты Studios и Web3 теперь экранируют пользовательский контент (UGC) от игроков и влиятельных лиц, дважды проверяя каждый клип для признаков фальсификации ИИ.

Некоторые идут дальше в игре в Deepfake Вратаря, объединяя детекторы ИИ с такими тегами происхождения, поддерживаемыми блокчейном, такими как C2PA (коалиция для продленса и подлинности контента). Несколько проектов NFT даже выпускают «сертификаты подлинности» для внутриигровых активов, выдвигая свою репутацию по прозрачности.

Проверка не только для активов.Студии теперь аутентифицируют официальные озвучки и видео -заявления для больших объявлений, трейлеров и живых AMA, чтобы остановить Deepfake PR -стихийные бедствия, прежде чем они произойдут.

Такие компании, как Adobe, Microsoft и Sony, присоединились к инициативе C2PA, чтобы подтолкнуть к общенациональным стандартам, гарантируя, что как создатели, так и игроки могут поверить, что «этот контент является реальной сделкой».

Однако это не серебряная пуля. Водяные знаки могут быть удалены, а обнаружение может выйти из строя.Тем не менее, многоуровневая защита - наша лучшая ставка против окружающей среды, где доверие постоянно находится в осаде. В этой игре сообщение простое: если ваше сообщество знает источник, они могут поверить в то, что видят.

Будущие в будущем наши глаза: доверяйте, но проверьте-затем проверьте еще раз

Будущее DeepFakes - это не только лучшая технология. Речь идет о переопределении самого доверия. К 2026 году контент, сгенерированный AI, готов доминировать в онлайн-ландшафте и дезинформации. Аналитики из Oooda Loop и другие предсказывают, что к 2026 году ИИ до 90% онлайн -контента может быть синтетически генерироваться.

«Ежедневно люди доверяют своему собственному восприятию, чтобы направлять их и рассказывать им, что реально, а что нет», - продолжили исследователи. «Слуховые и визуальные записи события часто рассматриваются как правдивый рассказ о событии.

По мере того, как синтетические носители становится дешевле и легче сделать, поскольку модели текста к видео, такие как Sora или взлетно-посадочная полоса, каждый месяц, наша защита не будет полностью запрещать подделки (это невозможно). Вместо этого нам понадобится совершенно новая культура цифровой проверки. Так же, как мы когда -то научились выявлять фишинговые электронные письма или фальшивые заголовки новостей, нам нужно будет проверить видео, голоса и «доказательства», прежде чем мы поделимся ими.

Некоторые стартапы строят плагины браузера, которые помечают подозреваемые глубокие флажки в режиме реального времени. Основные платформы могут вскоре принять теги Provenance Content Default, поэтому пользователи знают, откуда поступает каждый клип. Настоящий сдвиг не технический; это социально.

Мы должны научить общественность паузу и спросить:«Кто это сделал? Как я узнаю?»Как выразился один исследователь,«Мы не можем остановить Deepfakes. Но мы можем помочь миру заметить их быстрее, чем их можно вооружить».В эпоху ИИ иллюзий разумное сомнение может быть нашим величайшим щитом.

В заключение можно сказать, что можно сказать.

Deepfakes больше не научно не научно; Это сегодняшняя реальность. Поскольку инструменты генерации искусственного интеллекта становятся более мощными, ответственность за защиту доверия падает как на компании, так и на пользователей. Да, те, кто строит эти нейронные сети, должны пройти путь с надежными гарантиями, прозрачными инструментами происхождения и универсальными стандартами. Но пользователи тоже должны оставаться бдительными и требовать ответственности. Если мы хотим будущее, когда мы можем снова доверять своим глазам, это зависит от всех - создателей, компаний и сообществ - чтобы сделать подлинность по умолчанию.

В конце концов, если вы строите будущее, убедитесь, что это та, где правда все еще имеет шанс.

Источник изображенияздесьПолем

Оригинал