Контекстуализация сутры: достижения в многоязычных и эффективных LLMS

26 июня 2025 г.Таблица ссылок

Аннотация и 1 введение

2 Связанная работа

3 подход сутры

3.1 Что такое сутра?

3.2 Архитектура

3.3 Данные обучения

4 тренинги многоязычных токенизаторов

5 многоязычных MMLU

5.1 Массивное многозадачное понимание языка

5.2 Расширение MMLU на несколько языков и 5.3 последовательная производительность между языками

5.4 по сравнению с ведущими моделями для многоязычной производительности

6 Количественная оценка запросов в реальном времени

7 Обсуждение и заключение, а также ссылки

2 Связанная работа

Большие языковые модели и многоязычная:В области крупных языковых моделей (LLMS) наблюдается существенные достижения, особенно благодаря разработке таких моделей, как GPT-3 [Brown et al., 2020] и Bert [Devlin et al., 2018], которые установили новые критерии в понимании языка и генерации. Эти модели используют огромные объемы данных для изучения сложных шаблонов и создания последовательного текста, но их основное ограничение было сосредоточено в основном на данных английского языка. В ответ на необходимость поддержки глобального языкового разнообразия исследования расширились до многоязычных LLMS. Новаторские работы, такие как Mbert [Devlin et al., 2018] и XLM-R [Connoeau et al., 2020], продемонстрировали значительный потенциал в учебных представлениях, которые обобщают между языками. Тем не менее, эти модели часто сталкиваются с проблемами в сбалансировании производительности между языками, особенно для тех, кто менее представлен в учебных наборах [Connoeau et al., 2020]. Кроме того, по мере увеличения количества языков масштабируемость и эффективность этих моделей часто разлагаются, что требует более специализированных архитектур для эффективного обращения с разнообразием языков [Smith et al., 2021].

Нейронная машина перевод: Translation Neural Machine (NMT) был неотъемлемой частью прогресса в многоязычной производительности модели. Ранние системы NMT были ограничены сложностью их архитектур и качеством их переводов, особенно на языках с низким ресурсом [Wu et al., 2019]. Недавние исследования пересмотрели основные проблемы машинного перевода в контексте передовых крупных языковых моделей (LLMS). Работа Кона и Ноулза [2017] дает представление о постоянной актуальности таких проблем, как несоответствие доменов, предсказание редкого слова и перевод длинных предложений, даже когда LLMS показали значительные улучшения в этих областях. Кроме того, в исследовании Son и Kim [2023] изучалось производительность перевода LLM с точки зрения пользователя, подчеркивая их потенциал для улучшения перевода длинных предложений, а также выявляет постоянные проблемы, связанные с несоответствием доменов и редком прогнозировании слов. Работа Wu et al. [2016] В системе перевода нейронных машин Google также послужила эталоном для прогресса в этой области, преодолевая разрыв между человеческим и машинным переводом. Недавно работа Costa-Jussà et al. [2022] показали, что смесь архитектуры экспертов может эффективно использовать в контексте перевода нейронных машин и имеет значительный рост производительности перевода на различных языках с низким разрешением.

Смесь экспертов:Смесь экспертов (MOE) стала перспективной архитектурой для управления вычислительными затратами, связанными с масштабированием крупных языковых моделей (LLMS). Недавние исследования изучили преимущества MOE в этом контексте. Zhou et al. [2022] предложили смеси экспертов с маршрутизацией экспертов, которая позволяет динамическому распределению данных среди различных экспертов, что позволяет каждому эксперту сосредоточиться на своем опыте и достигать модельной разреженности. Аналогичным образом, Zoph [2022] исследовал дизайн эффективных редких экспертных моделей, подчеркнув важность тщательного сбалансирования количества и размеров экспертов для оптимизации производительности. Кроме того, Ott et al. [2022] представили семейство OPT открытых предварительно обученных моделей трансформатора, которые используют MOE для достижения значительных улучшений в эффективности и масштабируемости по сравнению с плотными моделями. Кроме того, Zheng et al. [2019] исследовали применение MOE в контексте наборов данных о китайской идиоме, демонстрируя потенциал этого подхода для улучшения языковых задач. Эти исследования в совокупности предполагают, что MOE может служить эффективным выбором для построения очень способных и вычислительно эффективных LLMS.

Мультимодальная LLMS:Исследователи также изучили потенциал мультимодальных крупных языковых моделей, которые могут обрабатывать и генерировать контент в разных модальностях, таких как текст, изображения и видео. Например, работа Dai et al. [2019] исследовали использование мультимодальных моделей для таких задач, как подписание изображений и ответ на визуальные вопросы, демонстрируя их способность использовать межмодальную информацию для повышения производительности. Аналогичным образом, в исследовании Николса и Варноу [2008] было изучено применение мультимодальных моделей в контексте вычислительной лингвистической филогении, подчеркивая их потенциал для раскрытия понимания из различных источников данных. Кроме того, недавние достижения в области мультимодального машинного перевода, как обсуждалось Берч [2021], показали преимущества интеграции визуальной информации в языковые модели для улучшения качества перевода.

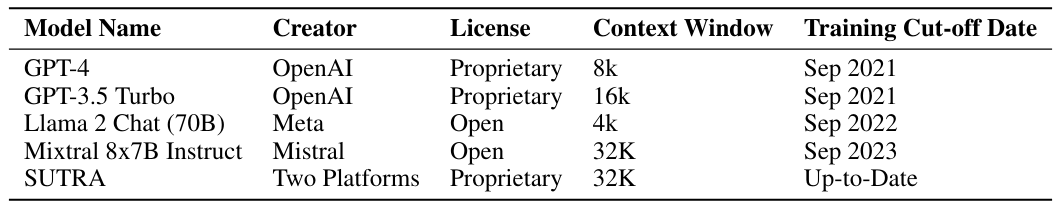

Онлайн LLMS:Современные крупные языковые модели, такие как Llama2, GPT-3.5 и GPT-4, были разработаны как всеобъемлющие чат-боты с открытым доменом, способные участвовать в расширенных диалогах по различным темам. Тем не менее, они сталкиваются с значительным ограничением: их данные заблокированы по времени, что приводит к дате отсечения знаний. Благодаря этому эти модели иногда генерируют ответы, которые являются правдоподобными, но фактически неверными, что снижает надежность их вывода, как отмечает Vu et al. [2023] и Press et al. [2022] и такие неточности часто связаны с устаревшей информацией, встроенной в параметры модели. Подробный список дат отсечения знаний для основных моделей показан в таблице 1. Хотя это может быть несколько исправлено посредством дополнительной подготовки с обратной связью с человеком или путем включения задач с интенсивными знаниями, масштабируя эти решения для размещения обновлений в реальном времени, таких как изменения в ценах на акции, остается сложным [Komeili et al., 2021]. Встроенное обучение представляет многообещающую альтернативу, позволяющую включать данные в реальном времени непосредственно в подсказки модели для руководства генерацией ответов. Хотя существуют постоянные усилия по улучшению LLM с результатами поиска в Интернете, эффективно используя эти внешние данные для повышения точности выходов LLM, все еще находится в стадии разработки. В этом контексте Sutra выделяется, представляя структурированный подход для увеличения ответа, обеспечивая возможность изучать, разумно и интерпретировать информацию из различных источников знаний.

Авторы:

(1) Абхиджит Бендейл, две платформы (abhijit@two.ai);

(2) Майкл Сапенза, две платформы (michael@two.ai);

(3) Стивен Рипплингер, две платформы (steven@two.ai);

(4) Саймон Гиббс, две платформы (simon@two.ai);

(5) Jaewon Lee, две платформы (jaewon@two.ai);

(6) Пранав Мистри, две платформы (pranav@two.ai).

Эта статья есть

Оригинал