Профессиональные профессионалы недооценивают риски ИИ по сравнению с техническими командами, показывает, что социальные связи показывают

21 июня 2025 г.Новое исследование от Social Links, лидер в области решений разведки с открытым исходным кодом, раскрывает разрыв между бизнес-специалистами и техническими специалистами, когда речь идет о признании рисков, связанных с AI-мощными кибератаками. Несмотря на быстрый рост изощренности угроз, бизнес -респонденты кажутся значительно менее обеспокоенными, чтобы их коллеги по технологиям. Этот факт подчеркивает потенциальную слепое пятно в организационной готовности.

Опрос собрал информацию от 237 специалистов (от генерального директора и технического уровня C до специалистов по кибербезопасности и менеджеров по продуктам) в различных отраслях, включая финансовые услуги, технологии, производство, розничную торговлю, здравоохранение, логистику, правительство и т. Д.

Результаты показали, что только 27,8% деловых людей (профессионалов в нетехнических, ориентированных на бизнес роли) определили использование ИИ для создания поддельных сообщений в качестве одной из наиболее важных киберугрог. Напротив, 53,3% технических специалистов отметили его как главную проблему - почти удвоить уровень тревоги. Аналогичная схема возникла вокруг технологии DeepFake: 46,7% технического персонала выразили обеспокоенность по сравнению с 27,8% респондентов.

Этот разрыв подчеркивает критическую уязвимость в организационной безопасности: бизнес-профессионалы, которые часто делают основные цели для сложных схем социальной инженерии и глубоких инженеров, управляемых искусственным интеллектом, показывают заметно более низкие уровни заботы или осознание этих угроз.

В то же время наиболее уязвимыми департаментами для киберугроз, выявленными респондентами, были финансы и бухгалтерский учет (24,1%), ИТ и развитие (21,5%), HR и набор персонала (15,2%), а также продажи и учетные записи (13,9%).

«Это больше не вопрос« если »-угрозы с двигательными способностями уже здесь и быстро развиваются»,-говорит Иван Шкварун, генеральный директор Social Links. «Мы видим четкий разрыв между этими строительными защитами и теми, которые, скорее всего, будут ориентированы. Соединение этого разрыва требует не только лучших технических инструментов, но и более широкого осознания и образования на всех уровнях организации».

Ключевые идеи исследования:

Традиционные против ИИ угрозы: в то время как фишинга и мошенничество по электронной почте остаются наиболее цитируемыми угрозами (69,6%), за которыми следуют вредоносные программы/вымогатели (49,4%), атаки, управляемые ИИ. 39,2% респондентов определили использование ИИ для создания фальшивых сообщений и кампаний в качестве основной проблемы, а 32,9% указывали на глубокие и синтетические идентичности - подтверждая, что генеративные технологии в настоящее время являются признанной частью ландшафта корпоративной угрозы.

«Традиционные угрозы, такие как фишинг и вредоносное ПО, все еще доминируют в диаграммах. Но сейчас мы видим, что ИИ не заменяет эти риски, он надгрязняет их, превращая общие мошенничества в индивидуальные операции - быстрый, дешевый и более убедительный. Это реальный сдвиг: автоматизация и персонализация в масштабе», - объясняет Иван.

Результат следа сотрудников: 60,8% респондентов сообщают, что сотрудники используют корпоративные счета для личных целей, например, публикация на форумах, участие в социальных сетях или обновление общественных профилей. 59,5% также связывают общедоступные данные сотрудников (например, LinkedIn BIOS, мероприятия на форумах и блогах) с реальными кибер -инцидентами, определяя его как повторяющуюся точку входа для атак.

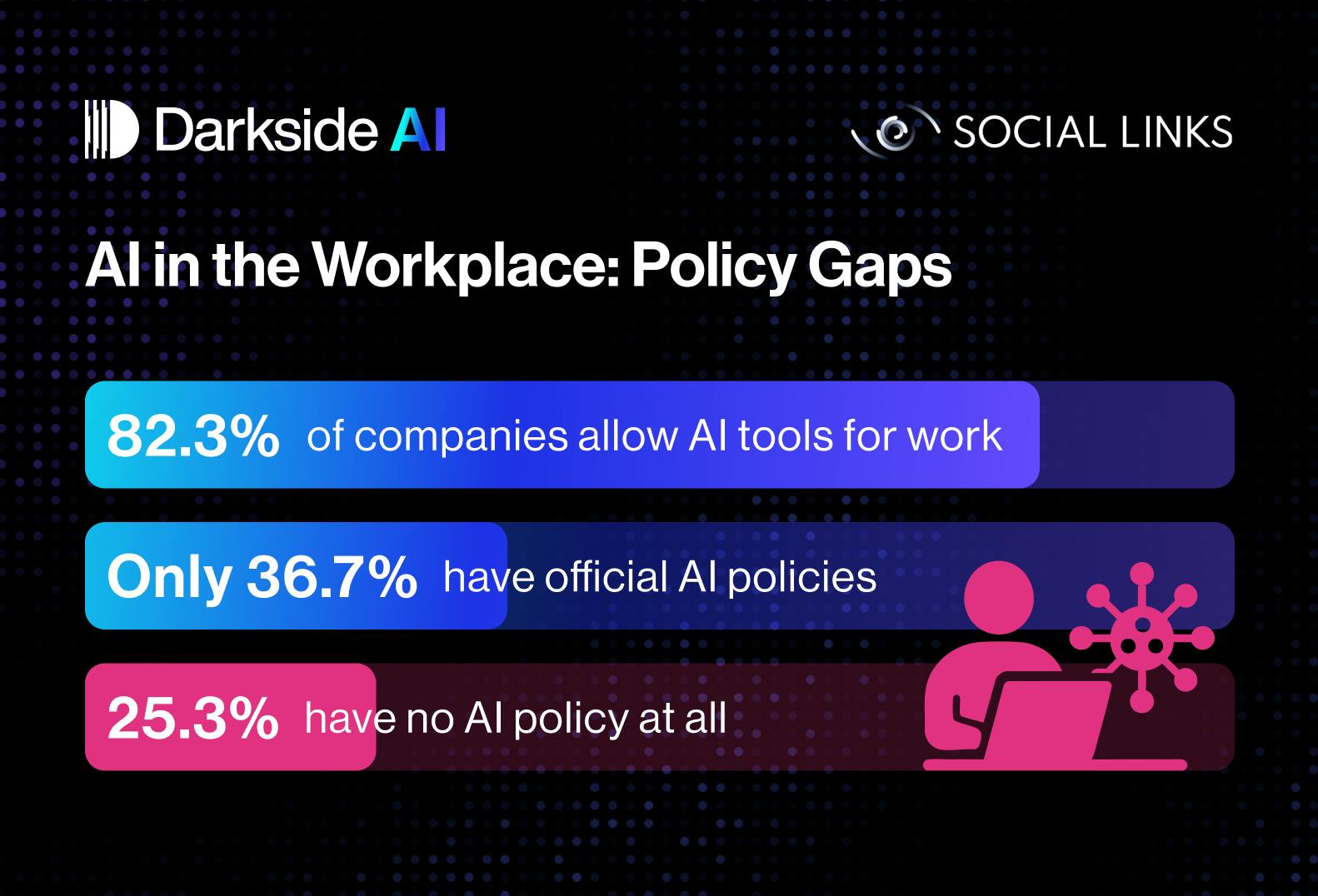

Нерегулируемое принятие искусственного интеллекта: более 82% компаний позволяют сотрудникам использовать инструменты искусственного интеллекта на работе, однако только 36,7% имеют официальную политику, которая контролирует, как используются эти инструменты. Этот разрыв использует «Shadow AI» - несанкционированное внедрение чат -ботов, кодовых помощников или других услуг искусственного интеллекта без его надзора, которое может утечь конфиденциальные данные и создавать скрытые риски безопасности и соответствия.

“You can’t really stop people from using work accounts or data when they’re active online. The same goes for AI tools: people will use them to save time or get help with tasks, whether there’s a policy or not. But all this activity leaves digital traces. And those traces can make it easier for scammers to find and target employees. What actually helps is teaching people how to spot the risks and giving them the right tools to stay safe, instead of just saying ‘don’t do it,’” explains Ivan.

Исследование подчеркивает, что эффективная кибербезопасность в эпоху ИИ требует целостного подхода, который выходит за рамки технического контроля, чтобы включить комплексные программы безопасности, ориентированные на человека.

Обучение сотрудников по безопасному использованию ИИ была в подавляющем большинстве воспринимается респондентами, которая является наиболее эффективной мерой смягчения для «Shadow AI» (72,2%), за которой следует разработка внутренней политики (46,8%).

Социальные ссылки привержены решению этих развивающихся проблем и недавно запустили

О социальных ссылках:

Social Links является глобальным поставщиком решений для разведки с открытым исходным кодом (OSINT), признанных лидером отрасли Frost & Sullivan. Штаб -квартира в Соединенных Штатах, компания также имеет офис в Нидерландах. Социальные ссылки объединяют данные из более чем 500 открытых источников, охватывающих социальные сети, посланники, блокчейны и темную сеть, позволяя пользователям визуализировать и анализировать всеобъемлющую информационную картину и обтекание исследований. Его решения поддерживают основные процессы в различных секторах, включая правоохранительные органы, национальную безопасность, кибербезопасность, должную осмотрительность, банковское дело и многое другое. Компании из S & P 500 и общественных организаций в более чем 80 странах полагаются на продукты социальных связей каждый день.

Контакты:

Электронная почта:

Веб -сайт:

Оригинал