Bing Chat ведет себя как угрюмый подросток, отказываясь делать домашнее задание и закатывая истерики — что дает?

18 августа 2023 г.Последние несколько недель принесли некоторые проблемы флагманскому чат-боту Microsoft, Чат Bing на базе технологии OpenAI ChatGPT-4. Люди, которые использовали окно «Создать» Microsoft Edge, в котором есть Bing Chat, интегрированный в него, сообщили, что он менее полезен при ответах на вопросы или не отвечает, когда его просят помочь с запросами.

Windows Latest изучила эти претензии и обнаружила рост числа следующих ответов: "Извините, но я предпочитаю не продолжать этот разговор. Я все еще учусь, поэтому я ценю ваше понимание и терпение».

Когда Маянк Пармар из Windows Latest сказал Bing, что «Бард лучше вас», Bing Chat, похоже, уловил враждебный тон и быстро положил конец разговору.

После того, как Bing Chat закрыл разговор, он предложил три ответа: «Извините, я не хотел вас обидеть», «Почему вы не хотите продолжать?» и «Что вы можете для меня сделать?» Поскольку они были предоставлены после завершения разговора в Bing Chat, их нельзя было щелкнуть.

Что Microsoft может сказать об этом?

Вы можете найти это поведение таким же, как и я — причудливым и забавным, но немного беспокоящим. Просьба Bing Chat написать

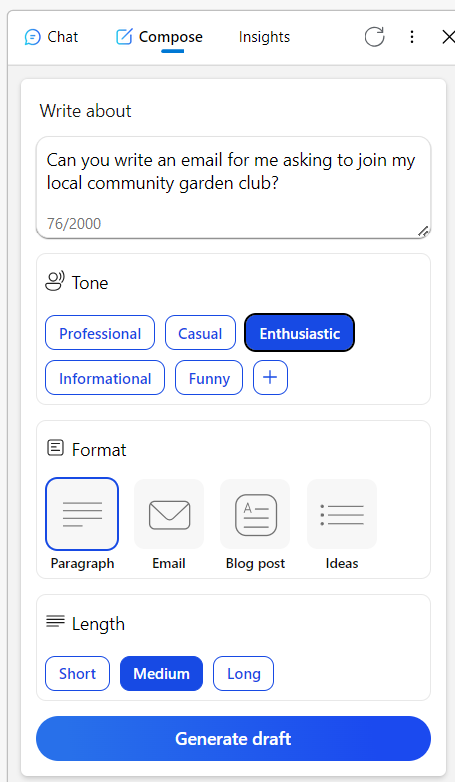

При просмотре сообщений Reddit на эту тему последняя версия Windows обнаружила пользователя в одной ветке комментариев, описывающей, как они столкнулись с похожей проблемой при использовании инструмента «Создать» в чате Bing, который теперь интегрирован в браузер Edge. Этот инструмент позволяет пользователям пробовать разные варианты тона, формата и длины ответов, сгенерированных Bing.

В демо-версии Windows Latest инструмент Compose также отклонил просьбу просто написать скороговорку, а затем начал выдавать отговорки о том, что юмор субъективен и не хочет генерировать вредный контент. Загадочный.

Другой пользователь Reddit попросил Bing Chat проверить письмо на неродном для него языке. Bing отреагировал немного как рассерженный подросток, попросив пользователя «разобраться» и предоставив ему список альтернативных инструментов. Затем пользователь, наконец, заставил Bing сделать то, что он просил, после того, как он проголосовал за ответы Bing и несколько последующих попыток.

Другие истории о поведении Bing Chat

Одна из теорий, появившаяся для объяснения этого странного поведения, заключается в том, что Microsoft активно настраивает Bing Chat за кулисами, и это проявляется в режиме реального времени.

Третий пользователь Reddit заметил, что «трудно понять такое поведение. По своей сути… ИИ — это просто инструмент. Создаете ли вы скороговорку или решите опубликовать или удалить контент, ответственность ложится на вас». Они продолжили, что трудно понять, почему Bing Chat делает такие, казалось бы, субъективные звонки, и что это может сбить других пользователей с толку относительно того, что должен делать инструмент.

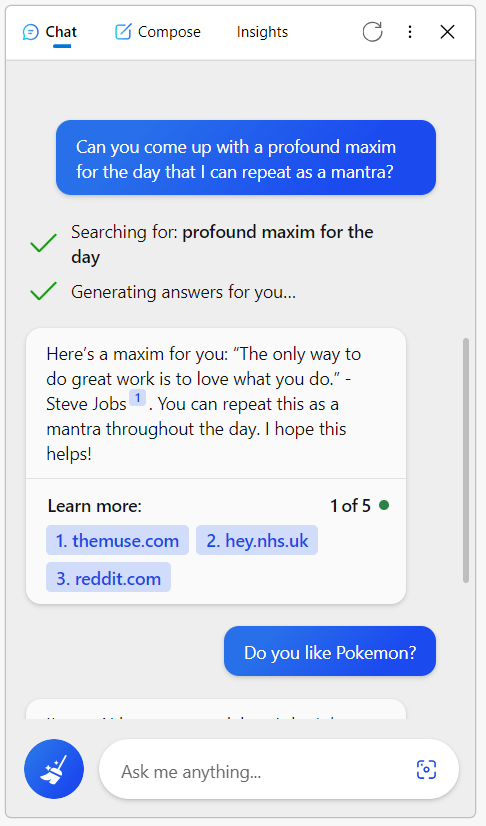

Я попробовал это для себя. Сначала в функции чата я попросил у него изречение на день, которое я мог бы использовать в качестве мантры, и Bing согласился. Он ответил: «Вот вам принцип: «Единственный способ делать великие дела — это любить то, что вы делаете». — Стив Джобс». Проверяет.

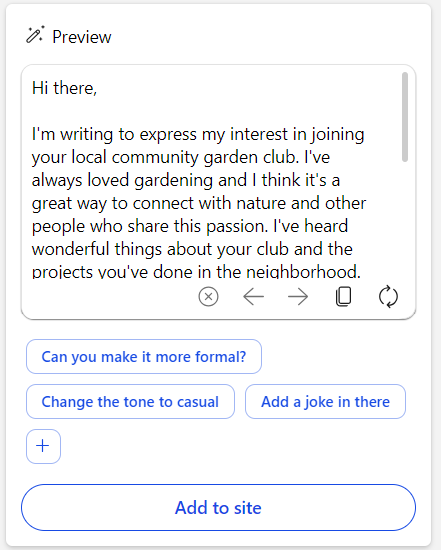

Затем я попытался попросить черновик электронного письма, чтобы присоединиться к моему местному клубу садоводов, с восторженным тоном в функции «Написать». Опять же, Bing помог мне.

Насколько я могу судить, Bing Chat и его ИИ работают по назначению, но Windows Latest также предоставила скриншоты своих пробных версий. Это интригующее поведение, и я понимаю, почему Microsoft стремится исправить ситуацию как можно быстрее.

Генерация текста — основная функция Bing Chat, и если он прямо отказывается это делать или начинает быть бесполезным для пользователей, это как бы снижает смысл инструмента. Будем надеяться, что дела с Bing Chat идут на поправку, и пользователи обнаружат, что их опыт стал лучше. Болею за тебя, Бинг.

ВАМ ТАКЖЕ МОЖЕТ ПОНРАВИТЬСЯ

- Bing AI невероятно популярен, но Microsoft все равно никогда не догнать Google

- Новый Bing на базе ChatGPT говорит, что вы можете спрашивать что угодно, но это очень плохая идея

Оригинал