Австралия предлагает обязательные ограждения для ИИ

6 сентября 2024 г.Требование тестировать модели ИИ, держать людей в курсе событий и предоставлять людям право оспаривать автоматизированные решения, принимаемые ИИ, — это лишь некоторые из 10 обязательных мер, предложенных правительством Австралии в качестве способов минимизации рисков ИИ и укрепления общественного доверия к этой технологии.

Выпущенные для публичного обсуждения министром промышленности и науки Эдом Хусичем в сентябре 2024 года, ограничения вскоре могут применяться к ИИ, используемому в условиях высокого риска. Они дополняются новым добровольным стандартом безопасности ИИ, призванным побудить предприятия немедленно внедрять передовой опыт ИИ.

Какие обязательные ограничения ИИ предлагаются?

10 предлагаемых обязательных защитных барьеров Австралии призваны установить четкие ожидания относительно того, как безопасно и ответственно использовать ИИ при его разработке и развертывании в условиях высокого риска. Они направлены на устранение рисков и вреда от ИИ, укрепление общественного доверия и предоставление компаниям большей нормативной определенности.

Ограждение 1: Ответственность

Аналогично требованиям канадского и европейского законодательства об искусственном интеллекте, организациям необходимо будет установить, внедрить и опубликовать процесс подотчетности для соблюдения нормативных требований. Это будет включать такие аспекты, как политики управления данными и рисками, а также четкие внутренние роли и обязанности.

Ограждение 2: Управление рисками

Необходимо будет разработать и внедрить процесс управления рисками для выявления и смягчения рисков ИИ. Это должно выйти за рамки технической оценки рисков и рассмотреть потенциальное воздействие на людей, общественные группы и общество, прежде чем можно будет ввести в эксплуатацию высокорисковую систему ИИ.

СМОТРИТЕ: 9 инновационных вариантов использования ИИ в австралийском бизнесе в 2024 году

Предупреждение 3: Защита данных

Организациям необходимо будет защищать системы ИИ, чтобы гарантировать конфиденциальность с помощью мер кибербезопасности, а также создавать надежные меры управления данными для управления качеством данных и их источником. Правительство отметило, что качество данных напрямую влияет на производительность и надежность модели ИИ.

Ограждение 4: Тестирование

Высокорисковые системы ИИ необходимо будет протестировать и оценить перед тем, как выводить их на рынок. Также их необходимо будет постоянно контролировать после развертывания, чтобы убедиться, что они работают так, как ожидается. Это необходимо для того, чтобы гарантировать, что они соответствуют конкретным, объективным и измеримым показателям производительности, а риск минимизирован.

Ограждение 5: Человеческий контроль

Для систем ИИ с высоким уровнем риска потребуется осмысленный человеческий надзор. Это будет означать, что организации должны гарантировать, что люди могут эффективно понимать систему ИИ, контролировать ее работу и вмешиваться при необходимости по всей цепочке поставок ИИ и на протяжении всего жизненного цикла ИИ.

Ограждение 6: Информация для пользователя

Организациям необходимо будет информировать конечных пользователей, если они являются субъектом каких-либо решений с использованием ИИ, взаимодействуют с ИИ или потребляют какой-либо контент, созданный ИИ, чтобы они знали, как используется ИИ и где это влияет на них. Это необходимо будет сообщать в ясной, доступной и уместной форме.

Guardrail 7: вызов ИИ

Люди, на которых негативно повлияли системы ИИ, будут иметь право оспаривать использование или результаты. Организациям необходимо будет разработать процессы, позволяющие людям, на которых повлияли высокорисковые системы ИИ, оспаривать решения, принятые с использованием ИИ, или подавать жалобы на свой опыт или обращение.

Ограждение 8: Прозрачность

Организации должны быть прозрачны с цепочкой поставок ИИ в отношении данных, моделей и систем, чтобы помочь им эффективно справляться с рисками. Это связано с тем, что некоторые участники могут не иметь важной информации о том, как работает система, что приводит к ограниченной объяснимости, аналогично проблемам с сегодняшними передовыми моделями ИИ.

Ограждение 9: записи ИИ

Ведение и поддержка ряда записей по системам ИИ будет необходимо на протяжении всего жизненного цикла, включая техническую документацию. Организации должны быть готовы предоставить эти записи соответствующим органам по запросу и в целях оценки их соответствия защитным ограждениям.

СМ.: Почему проекты генеративного ИИ рискуют потерпеть неудачу без понимания бизнеса

Guardrail 10: Оценки ИИ

Организации будут подвергаться оценке соответствия, описанной как механизм подотчетности и обеспечения качества, чтобы показать, что они придерживаются ограничений для систем ИИ с высоким риском. Они будут проводиться разработчиками систем ИИ, третьими лицами или государственными органами или регулирующими органами.

Когда и как вступят в силу 10 новых обязательных ограждений?

Обязательные ограждения подлежат общественному обсуждению до 4 октября 2024 года.

По словам Хусича, после этого правительство попытается завершить разработку защитных ограждений и ввести их в действие, добавив, что это может включать в себя возможное создание нового австралийского закона об искусственном интеллекте.

Другие варианты включают в себя:

- Адаптация существующих нормативных рамок для включения новых ограждений.

Внедрение рамочного законодательства с соответствующими поправками к существующему законодательству.

Хусич заявил, что правительство сделает это «как можно скорее». Ограничения появились в результате длительного процесса консультаций по регулированию ИИ, который продолжается с июня 2023 года.

Почему правительство применяет именно такой подход к регулированию?

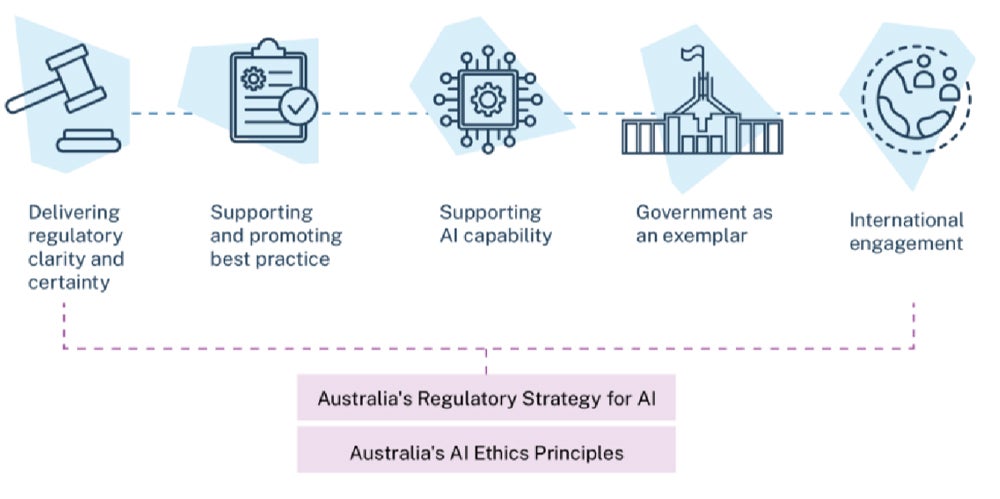

Правительство Австралии следует примеру ЕС, применяя подход, основанный на оценке риска, к регулированию ИИ. Этот подход стремится сбалансировать преимущества, которые ИИ обещает принести при развертывании в условиях высокого риска.

Сосредоточение внимания на условиях высокого риска

Предупреждающие меры, предлагаемые в ограждениях, направлены на то, чтобы «избежать катастрофического ущерба до того, как он произойдет», пояснило правительство в своем документе с предложениями по безопасному и ответственному ИИ в Австралии.

Правительство определит высокорисковый ИИ в рамках консультаций. Однако предполагается, что оно рассмотрит такие сценарии, как неблагоприятное воздействие на права человека, неблагоприятное воздействие на физическое или психическое здоровье или безопасность, а также правовые последствия, такие как клеветнические материалы, среди других потенциальных рисков.

Предприятиям необходимо руководство по ИИ

Правительство утверждает, что предприятиям нужны четкие ограничения для безопасного и ответственного внедрения ИИ.

Недавно опубликованный Индекс ответственного использования искусственного интеллекта (ИИ) 2024, подготовленный по заказу Национального центра искусственного интеллекта, показывает, что австралийские предприятия постоянно переоценивают свои возможности по внедрению ответственных методов использования искусственного интеллекта.

Результаты индекса:

- 78% австралийских предприятий считают, что они внедряют ИИ безопасно и ответственно, но только в 29% случаев это было верно.

Австралийские организации в среднем внедряют только 12 из 38 ответственных практик ИИ.

Что теперь следует делать предприятиям и ИТ-отделам?

Обязательные ограничения создадут новые обязательства для организаций, использующих ИИ в условиях повышенного риска.

Группы ИТ и безопасности, вероятно, будут заниматься выполнением некоторых из этих требований, включая обязательства по качеству данных и безопасности, а также обеспечением прозрачности модели в цепочке поставок.

Добровольный стандарт безопасности ИИ

Правительство опубликовало Добровольный стандарт безопасности ИИ, который теперь доступен для предприятий.

ИТ-отделы, желающие быть готовыми, могут использовать Стандарт безопасности ИИ, чтобы помочь своим предприятиям быстрее выполнять обязательства в соответствии с любым будущим законодательством, которое может включать новые обязательные ограждения.

Стандарт безопасности ИИ содержит рекомендации о том, как компании могут применять и внедрять стандарт, на конкретных примерах, включая распространенный вариант использования универсального чат-бота на основе ИИ.

Оригинал