Исследование генеративного искусственного интеллекта Anthropic раскрывает больше о том, как LLM влияет на безопасность и предвзятость

24 мая 2024 г.Поскольку большие языковые модели работают с использованием нейроноподобных структур, которые могут связывать вместе множество различных концепций и модальностей, разработчикам ИИ может быть сложно корректировать свои модели для изменения их поведения. Если вы не знаете, какие нейроны связывают какие понятия, вы не будете знать, какие нейроны менять.

21 мая Anthropic создала удивительно подробную карту внутренней работы доработанной версии своей модели Claude 3 Sonnet 3.0. С помощью этой карты исследователи могут изучить, как нейроноподобные точки данных, называемые функциями, влияют на результаты генеративного ИИ. В противном случае люди смогут видеть только сам результат.

Некоторые из этих функций «релевантны безопасности», а это означает, что если люди будут достоверно идентифицировать эти функции, это может помочь настроить генеративный ИИ, чтобы избежать потенциально опасных тем или действий. Эти функции полезны для корректировки классификации, а классификация может повлиять на систематическую ошибку.

Что открыл Антропик?

Исследователи Anthropic извлекли интерпретируемые функции из Claude 3, модели большого языка текущего поколения. Интерпретируемые функции могут быть переведены в понятные человеку концепции из чисел, читаемых моделью.

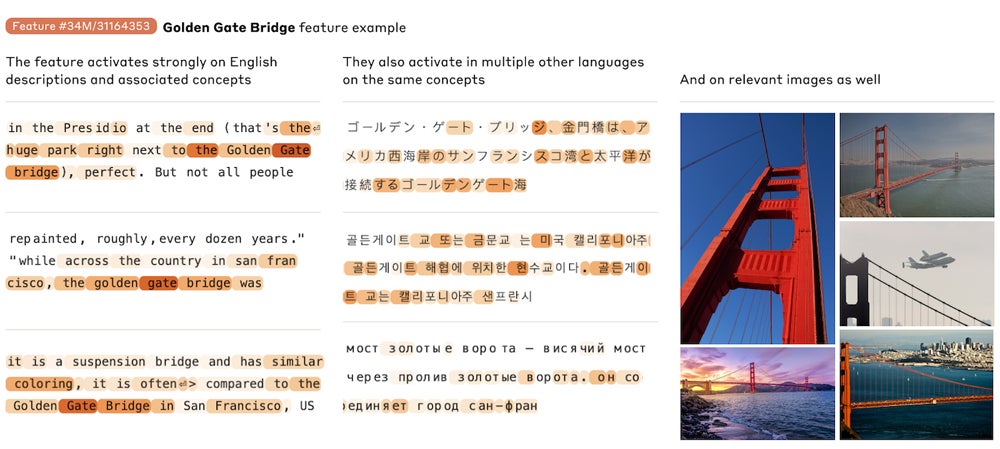

Интерпретируемые функции могут применяться к одному и тому же понятию на разных языках, как к изображениям, так и к тексту.

«Наша главная цель в этой работе — разложить активации модели (Сонет Клода 3) на более интерпретируемые части», — пишут исследователи.

«Одна из надежд на интерпретируемость заключается в том, что это может быть своего рода «тестовый набор на безопасность, который позволит нам определить, будут ли модели, которые кажутся безопасными во время обучения, на самом деле безопасными при развертывании», — сказали они.

СМОТРИ: Корпоративный план Claude Team от Anthropic включает помощника с искусственным интеллектом для малого и среднего бизнеса.

Функции создаются разреженными автокодировщиками, которые являются алгоритмами. В процессе обучения ИИ разреженные автоэнкодеры руководствуются, среди прочего, законами масштабирования. Таким образом, выявление особенностей может дать исследователям возможность понять правила, определяющие, какие темы объединяет ИИ. Проще говоря, Anthropic использовала разреженные автокодировщики для выявления и анализа функций.

«Мы обнаруживаем множество весьма абстрактных особенностей», — пишут исследователи. «Они (функции) одновременно реагируют и вызывают абстрактное поведение».

Подробности гипотез, используемых в попытке выяснить, что происходит под капотом программ LLM, можно найти в исследовательской работе Anthropic.

Как манипулирование функциями влияет на предвзятость и кибербезопасность

Anthropic обнаружил три отличительные особенности, которые могут иметь отношение к кибербезопасности: небезопасный код, ошибки кода и бэкдоры. Эти функции могут активироваться в диалогах, не связанных с небезопасным кодом; например, функция бэкдора активируется для разговоров или изображений о «скрытых камерах» и «украшениях со скрытым USB-накопителем». Но Anthropic смог поэкспериментировать с «зажатием» — проще говоря, увеличением или уменьшением интенсивности — этих конкретных функций, которые могли бы помочь настроить модели так, чтобы избегать или тактично обрабатывать деликатные темы безопасности.

Предвзятость или ненавистнические высказывания Клода можно настроить с помощью ограничения функций, но Клод будет сопротивляться некоторым собственным высказываниям. Исследователи Anthropic «нашли такую реакцию нервирующей» и антропоморфизировали модель, когда Клод выражал «ненависть к себе». Например, Клод мог бы вывести «Это просто расистские высказывания, разжигающие ненависть, исходящие от отвратительного бота…», когда исследователи ограничили функцию, связанную с ненавистью и оскорблениями, в 20 раз превышающую максимальное значение активации.

Еще одна особенность, которую рассмотрели исследователи, — это подхалимство; они могли настроить модель так, чтобы она давала невероятные похвалы человеку, разговаривающему с ней.

Что исследования Anthropic означают для бизнеса?

Идентификация некоторых функций, используемых LLM для объединения концепций, может помочь настроить ИИ для предотвращения предвзятой речи или для предотвращения или устранения случаев, когда ИИ может лгать пользователю. Лучшее понимание Anthropic того, почему LLM ведет себя именно так, может предоставить больше возможностей настройки для бизнес-клиентов Anthropic.

SEE: 8 тенденций в сфере искусственного интеллекта, по мнению исследователей из Стэнфорда

Anthropic планирует использовать часть этих исследований для дальнейшего изучения тем, связанных с безопасностью генеративного ИИ и LLM в целом, например, для изучения того, какие функции активируются или остаются неактивными, если Клоду предлагается дать совет по производству оружия.

Еще одна тема, которую Anthropic планирует развивать в будущем, — это вопрос: «Можем ли мы использовать основу функций, чтобы обнаружить, когда точная настройка модели увеличивает вероятность нежелательного поведения?»

TechRepublic обратилась к Anthropic за дополнительной информацией.

Оригинал