Ваш стек LLM не готов к производству - то, что вам не хватает

31 июля 2025 г.Резюме исполнительной власти: почему архитектура LLM является реальной сдвигом

Для CTO, инженерных лидеров и владельцев доставки

Генеративные ИИ и крупные языковые модели, в частности, больше не являются побочными проектами или просто API. Они требуют нового стиля инженерии и новой организационной дисциплины. Основной проблемой является не просто техническая новинка. LLM заменяют детерминизм на вероятность, вводят «лингвистический интерфейс» в качестве нового уровня приложения, и требуют, чтобы лидеры переосмыслили, как системы создаются, подтверждены и поддерживаются в масштабе.

Что действительно отличает этот сдвиг, так это появление нового архитектурного измерения - самой неопределенности. В системах, управляемых LLM, непредсказуемость не является незначительным раздражением или краем: она становится основной задачей дизайна на каждом уровне. Оперативная интерпретация, взаимодействие агента, логика оркестровки и даже границы внимания модели - все это источники неоднозначности, которые должны быть разработаны, а не просто контролируются или избегаются. Это новое измерение в основном меняет мастерство архитектуры программного обеспечения, требуя от команд создавать системы, которые могут адаптироваться, восстанавливаться и учиться на неизбежном дрейфе и непредсказуемости.

Заманчиво думать, что лидерство ИИ - это самая большая, яркая языковая модель или самое большое окно контекста. Но это миф. Настоящее конкурентное преимущество идет в команды, которые овладевают архитектурой - тем, кто строит, совершенствует и управляет всем стеком LLM: быстрое инженерное инженер, модульные агенты, оркестровка и поиск. В эту новую эпоху устойчивый успех ИИ связан не с необработанной моделью, а больше о коллективной дисциплине, обучении и операционной глубине вашей инженерной группы.

Почему этот сдвиг другой

- От предсказуемого кода до адаптивного языкаПолем В классических системах вы контролировали каждый вход и вывод. С LLMS вы организуете поведение в жизни, развивающуюся среду, в которой результаты зависят от обучения, контекста и быстрого дизайна, а не с трудной логикой.

- Нет больше серебряных пульПолем Каждая модель, подсказка и интеграция приносит компромиссы. Архитирование для разнообразия и изменений теперь является правилом, а не исключением.

- Опыт над книгами правилПолем Технические навыки больше не касаются запоминания статических правил, а о навигации неоднозначности, риска и быстрой итерации в стеке, которая является более мощной и менее предсказуемой.

Что на самом деле должны делать лидеры?

- Распределите приоритеты архитектуры LLM. Сделайте это темой на уровне доски. Оценить системы LLM как стратегическую инфраструктуру.

- Инвестировать в адаптивные команды. Команды по строительству и команды по производству, которым удобно работать в нескольких моделях, быстрое прототипирование и быстрое обратную связь.

- Сначала положите качество и ограждения. Версия, просмотреть и проверить каждую подсказку. Реализуйте многоуровневую проверку и контроль конфиденциальности рано, а не как запоздалая мысль.

- Upskill непрерывно. LLMS требуют новых навыков для всех - от владельцев продуктов до архитекторов. Сделайте «изучение стека» повторяющимся приоритетом.

Итог: LLMS не является дополнением к производительности. Они становятся новой основой для масштабируемого программного обеспечения, где адаптивность и надежность имеют такую же способность, как и необработанные возможности. Победителями будут те, кто освоит эту сложность, а не те, кто просто добавляет еще один инструмент в стек.

Архитектурное перегиб: от кода до разговора

В течение десятилетий программное обеспечение эволюционировало через последовательность предсказуемых слоев: монолиты к микросервисам, плотно контролируемые API до потоков, управляемых событиями. Каждый шаг улучшал модульность и масштаб, но полагался на строгие контракты, явные пути ошибки и логику, которую вы можете отладить строкой.

LLMS нарушает этот шаблон. Теперь самое важное поведение системы - logic, проверка, даже поиск знаний - написано на естественном языке, а не только в коде. Подсказки, а не вызовы функций, становятся API. То, что когда -то было закодировано, теперь спроектировано, протестировано и развивается посредством разговора и примера.

Что действительно меняется:

- Контракт ввода/вывода исчез. В системах LLM ответ представляет собой распределение вероятностей, формируемое как по приглашению, так и в контексте. Небольшое изменение формулировки может означать большое изменение в поведении.

- Логика как контент. Ключевые решения, бизнес -правила и даже регулирующие проверки включены в быстрые активы. Им можно управлять не разработчиками - и дрейфовать, мутировать или «гнить» вне кодовой базы, если не тщательно версировать.

- Неоднозначность становится нормой. Отладка перемещается от проверки кода к быстрому анализу и отслеживанию контекста. Появляются новые режимы отказа: быстрый дрейф, устойчивость знаний, галлюцинация вывода.

Почему это требует нового мышления

Старые узоры - строительство детерминизма, полагаясь на один источник истины, ожидая статической проверки - больше не работает. Вместо этого современная архитектура - это устойчивость:

- Слоирование ограждений и проверка между подсказками, оркестровкой и кодом.

- Проектирование для неоднозначности и быстрого восстановления, а не только управления.

- Инжиниринг для постоянного обучения и безопасной итерации.

Настоящая точка перегиба: архитекторы теперь работают больше похожи на проводников, чем на контроллеры, управление динамическими, адаптивными системами. Лучшие команды не пытаются устранить неопределенность - они проектируют процессы и слоистые слои, которые процветают.

Фонд -проект: три уровня современной архитектуры LLM

По мере того, как LLM становятся основополагающими для бизнес -программного обеспечения, их архитектура кристаллизовалась в три тесно интегрированных уровня. Эта структура не связана с добавлением сложности для сама по себе, что решает уникальные проблемы, и пропуск любого, что приводит к тем же производственным сбоям, независимо от размера вашей компании.

1. Сложный слой: язык как интерфейс

Сложный слой - это прямой интерфейс с моделью - где логика, правила и ограничения кодируются на естественном языке, а не только в коде.

Управление неопределенностью в том, как модель будет интерпретировать, обобщать или дрейфуйте от намерения быстрого.

Что это позволяет:

- Переводит деловые намерения в понятные задачи LLM: каждая подсказка определяет не только то, что делать, но и как.

- Кодирует логику и валидацию: подсказки могут обеспечивать соблюдение форматов, проверки здравомыслия и напрямую.

Режимы сбоя:

- Галлюцинации и несоответствие: смутные или перегруженные подсказки генерируют непредсказуемые результаты.

- Быстрый долг: неуправляемые изменения, скрытая бизнес -логика или дублированные шаблоны быстро становятся неуправляемыми.

- Стоимость взрыва: многословные или неэффективные подсказки раздувают использование токенов и эксплуатационные расходы.

Действительный совет: обработайте подсказки как код - версия их, протестировать их и отслеживать для дрейфа.

2. Агент слой: модульная экспертиза

Агент -слой вводит модульность и специализацию. Агенты похожи на плагины навыков - они инкапсулируют такие роли, как ретривер, суммализатор, валидатор или менеджер рабочего процесса.

Неопределенность умножается, поскольку логика распределяется по агентам - передача, границы ролей и обмен контекстом, все добавляют новые степени свободы и риска.

Что это позволяет:

- Разделение проблем: каждый агент владеет одной ответственностью - поиском, анализом, валидацией, оркестровкой и т. Д.

- Логика и безопасность на основе ролей: границы доступа и принятия решений применяются на одного агента.

- Поиск передовых знаний: в зрелых стеках агенты напрямую вызывают тряпку для целевых, современных знаний.

Режимы сбоя:

- Разрастание агента: перекрывающиеся, плохо документированные агенты вызывают хаос и адский ад.

- Утечки безопасности: агенты без строгой изоляции или границ данных.

- Отладка ада: отслеживание проблем в «роя» агентов со скрытыми зависимостями является болезненной без централизованных журналов и четких контрактов.

Действительный совет: Держите агенты небольшими, проверенными и хорошо документированными - просмотреть роли агента так же тщательно, как кодовые модули.

3. Слой оркестровки: адаптивные рабочие процессы и тряпка

Вверху слой оркестровки действует как «проводник» стека. Он координирует, как агенты и вызовы LLM текут, управляет государством, обеспечивает соблюдение бизнес-логики и подключается к поколению поиска (RAG).

Органируя саму неопределенность: динамически маршрутизационные задачи, поддержание хрупкого состояния, восстановление от неудач, которые не имеют детерминированного пути.

Что это позволяет:

- Сложные рабочие процессы: многоэтапные процессы между агентами, внешними API и базами знаний.

- Централизованное соответствие и аудит: деловые правила, валидация и ведение журнала обрабатываются во всем мире.

- Динамическое обогащение контекста: RAG привносит последние, наиболее актуальные знания в каждое взаимодействие - как в масштабе, так и на уровне агента.

Режимы сбоя:

- Дрейф рабочего процесса: плохо обслуживаемая оркестровка растет хрупкая и непрозрачная; Сбои становятся трудно обнаружить или исправить.

- Дрейф с тряпкой: схемы поиска оставлены неверными урожайными, несвежими или неактуальными результатами - качество выходного качества тихо падает.

- Потеря состояния: если состояние не управляется надежным, контекст и разговор теряются, что приводит к случайным или повторным сбоям.

Действительный совет: сделайте оркестровку явной, наблюдаемой и тестируемой - никогда не полагайтесь на «память» LLM для целостности состояния или рабочего процесса.

Соединение уровней

Каждый слой умножает значение других.

- Подсказки определяют логику, но только модульные агенты поддерживают ее.

- Агенты обеспечивают специализацию, но только оркестровка связывает все это вместе в масштабе.

- Rag превращает Static LLMS в живые системы, ориентированные на бизнес, но только при управлении с помощью надежных рабочих процессов.

Итог: пропустите слой, и ваша система в конечном итоге сломается - либо по стоимости, хаосу, безопасности или простой недостатке. Осредственно освоите все три, и вы создаете реальную основу для современной, адаптивной и безопасной доставки с AI.

Сдвиг мышления: сочинение, специализация, навигация на неопределенность

То, что объединяет эти слои, является не единственной «лучшей практикой», а новым инженерным мышлением. Современная архитектура LLM - это композиция (строительные системы от совместимых модулей), специализация (присваивание четких обязанностей) и, прежде всего, управление неопределенностью на каждом этапе.

Успех теперь требует гибридных, междисциплинарных команд. Быстрый инженер, дизайн агента, оркестрование и поиск - это отдельные навыки - ни одна роль не может охватить их всех. Лучшие команды сочетают лингвистическую точность, дизайн рабочего процесса и мышление на уровне системы, и они неустанно относятся к мониторинге, проверке и развитию своего стека.

Этот многослойный подход не является обязательным; Это единственный способ надежно, надежно, надежно и устойчиво масштабировать системы, надежно и устойчиво.

Быстрое проектирование (быстрое слой): новая поверхность API

В современных архитектурах LLM быстрое проектирование больше не является побочным навыком - это основной слой интерфейса, формирование логики, ограждения, обработка исключений, выходные шаблоны и даже стоимость. В тех случаях, когда классические API предоставляли детерминированные контракты, подсказки определяют поведение и границы на естественном языке - внедрение как гибкость, так и риск.

Паттерны: учебная, несколько выстрелов, цепочка мыслей, модульная и за его пределами

- Учебные подсказки: прямые, пошаговые инструкции для модели.

- Несколько выстрелов: предоставление нескольких примеров для постоянства вывода направления.

- Цепочка мыслей: поощряет модель разумно пошатнуться, повышая надежность в многоэтапных задачах.

- Модульная подсказка: разложение логики на многоразовые композиционные блоки приглашения.

Но быстрые шаблоны развиваются быстро. Расширенные подсказки могут:

- Экспресс -петли и рекурсию: инструктируя модель «повторить» до тех пор, пока не будет выполнено условие, или для рекурсивного применения в структуре данных. Это открывает дверь в итерационную логику, ранее зарезервированную для традиционного кода.

- Управление состоянием: подсказки могут явно перенести предыдущие ответы, частичные результаты или метаданные, делая разговоры и рабочие процессы. Состояние может быть передано либо через контекст («как обсуждалось ранее, ...») или встроено как переменные в шаблонные подсказки.

Эта гибкость означает, что подсказка может кодировать не только статические инструкции, но и динамическое поведение, которое конкурирует с традиционными сценариями - без написания кода.

Почему дисциплинированный быстрый дизайн не подлежит обсуждению

С большой мощностью приходит бремя обслуживания. Плохо разработанные подсказки приглашают:

- Непредсказуемые выходы («быстрый дрейф»)

- Скрытые зависимости от фразы или примеров порядка

- Эскалация затрат от неэффективных, словесных инструкций

- Риски безопасности и утечка вывода

Масштабирование систем, управляемых LLM, которые подсказываются, как первоклассные артефакты программного обеспечения: рецензируются, версируются, протестированы и задокументируются.

Инженерные практики

- Версии: хранить подсказки в управлении источником, с обзорами кода для каждого изменения.

- Тестирование: поддерживать быстрые тестовые примеры ввода/вывода - рано покройте дрейф, регрессия и галлюцинации.

- Оркестровка: интегрируйте подсказки в двигатели рабочего процесса, поддерживая цепочку, повторно и откаты в сбое.

- Guardrails: используйте явные инструкции и форматирование вывода (например, «Если вы не уверены, ответьте« неизвестно »; требуется JSON или другой структурированный вывод).

Анти-паттерны:

- Смутные, многоцелевые подсказки («Расскажи мне об этом».)

- Перегрузка подсказок со слишком большим количеством инструкций («суммировать, переводить, анализировать и объяснять риски - все сразу»)

- Отсутствие четкой спецификации вывода (свободная форма, противоречивые ответы)

Инженерная пьеса: интеграция, модульность и контроль качества

Надежная бывая инженерная практика превращает специальные инструкции в поддерживаемую, масштабируемую систему.

Лучшие шаблоны и методы интеграции

- Цепочка: Разбейте сложные рабочие процессы на пошаговые подсказки, передавая состояние/результаты от одного этапа к другой.

- Модульность: построить библиотеки шаблонов многоразового приглашения для повторной логики или структуры.

- Шаблон и параметризация. Используйте заполнители/переменные для данных, специфичных для контекста, что позволяет побуждениям адаптироваться по вариантам использования без переписывания.

Пример кода: recavle_template = «Вы менеджер проекта. На основании этого проекта краткое изложение: {ribt}, перечислите все идентифицированные риски и стратегии смягчения».

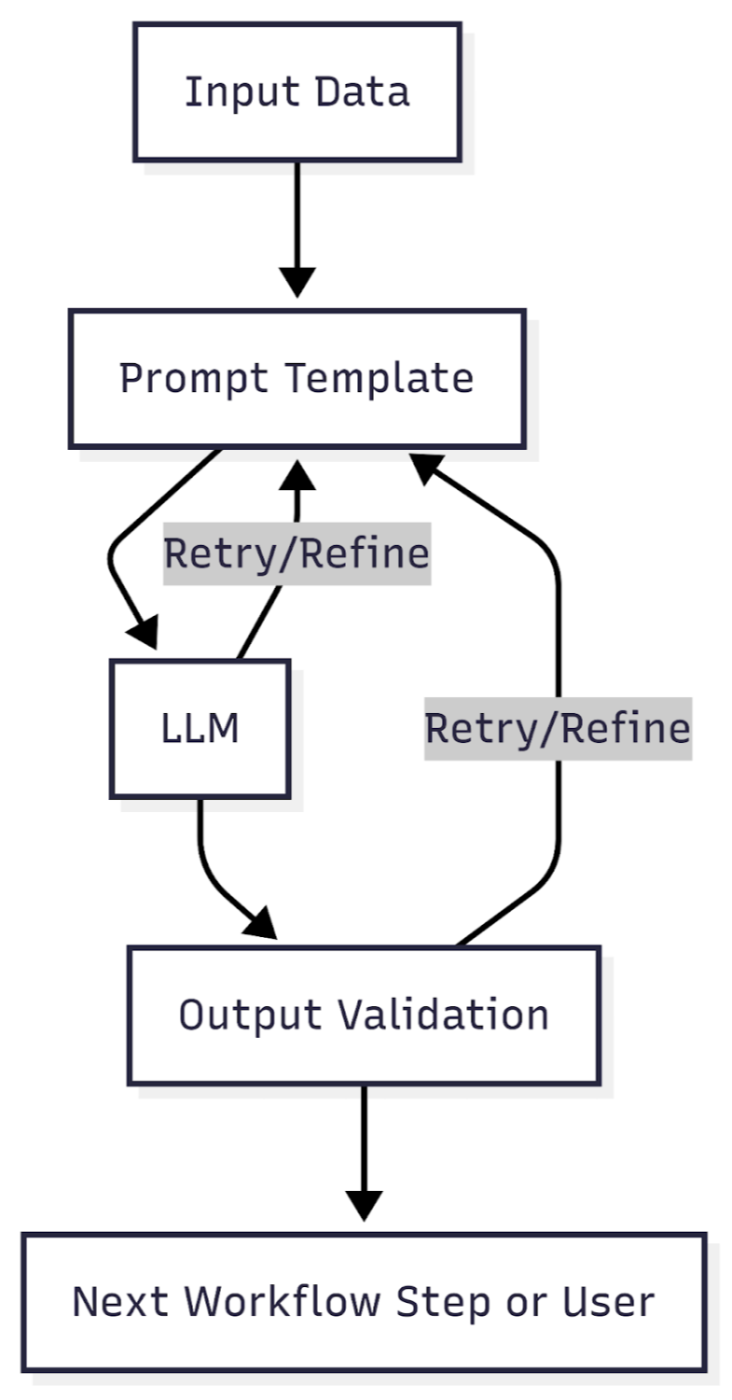

Обработка исключений и контроль качества

- Обнаружение и эскалационные сбои: ловить пустые, противоречивые или неформатные выходы; Trigger Refiers, запасные подсказки или обзор человека.

- Уровень проверки: автоматически проанализировать и проверять выходы - форматы обеспечения соблюдения, необходимые поля и бизнес -правила.

- Мониторинг: точность отслеживания, стоимость за запрос, частоты ошибок и тенденции производительности.

Реальный быстрый жизненный цикл

- Дизайн → Обзор → Тест → Развертывание → Монитор → Уточнение

Диаграмма:

Общие ошибки

- Игнорирование оперативных версий: приводит к «Ghost Bugs» и молчаливым регрессиям.

- Твердый кодирующий данные/контекст в подсказки вместо использования шаблона.

- Неспособность отслеживать качество вывода и дрейф в качестве моделей обновляется с течением времени.

Краткое содержание

Обратная техника сегодня - это не только написание умных инструкций - это создание строгого уровня интерфейса, с такой же заботой и процессом, как и традиционная разработка API или бизнес -логики. Современные подсказки могут выражать циклы, управлять состоянием и динамическими, адаптивными системами, если они спроектированы и управляются с инженерной дисциплиной.

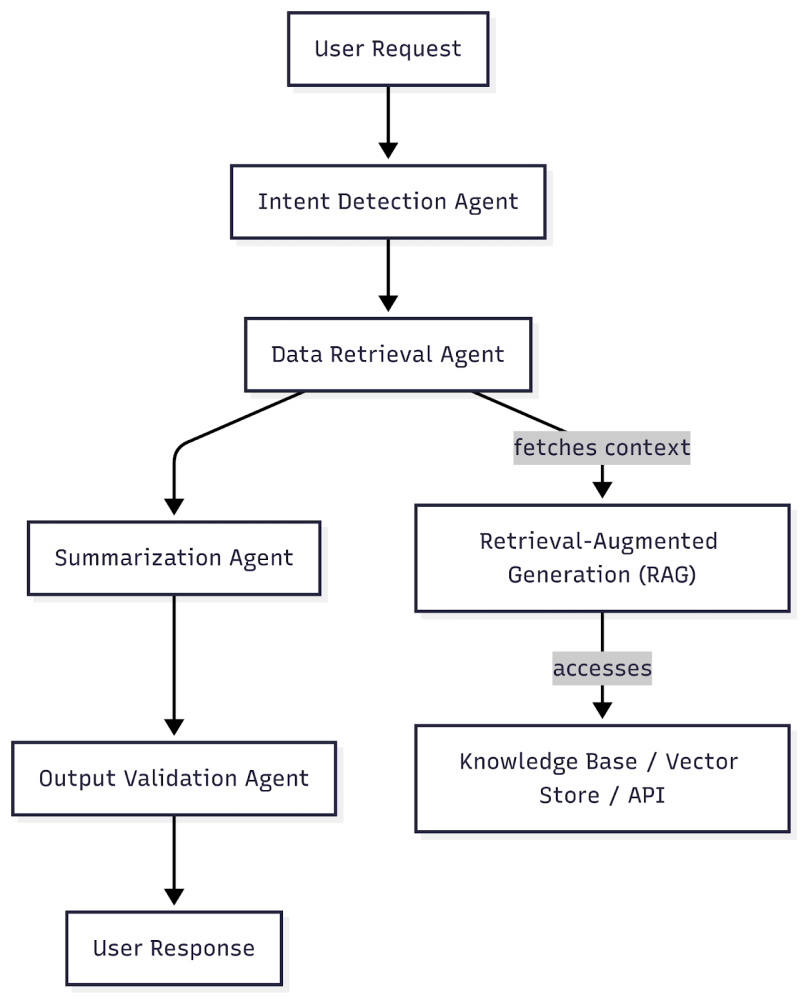

Агент слой: роль, специализация, ответственность

По мере того, как системы LLM созревают, подход «Mega-Mega-Prompt» быстро растет. Решением является слой агента - модульный композиционный слой, который инкапсулирует различные обязанности, опыт домена и логика. Агенты представляют как единицу разделения (подумайте: микросервисы, но для рассуждений и взаимодействия), так и критической поверхности для обеспечения безопасности и эксплуатационных ограждений.

Почему агенты? Модульность, специализация и границы

В уровне агента каждый агент действует как специалист:

- Разделение проблем: агентам назначаются дискретные роли - Суммизатор, развлечения данных, валидатор, менеджер рабочего процесса и т. Д. - отражение реального опыта.

- Логика на основе ролей: каждый агент кодирует логику и паттерны принятия решений, оптимизированные для ее задачи, снижая сложность и улучшая обслуживаемость.

- Границы безопасности: изолируя задачи, агенты могут обеспечить четкие границы ввода/вывода, элементы управления доступа и даже политики конфиденциальности - ограничение радиуса взрыва и потенциальная утечка данных.

Усовершенствованные шаблоны агента: прямое интеграция Rag

Основной эволюцией в архитектуре агента является прямой вызов модулей из поиска-аугментированного поколения (RAG):

- Поиск целевого знания: агенты могут извлекать только тот контекст, который им нужен, оптимизировать использование токенов и снижение шума.

- Adaptive specialization: Some agents use basic LLM capabilities, while others invoke RAG or external tools for deeper, more accurate knowledge injection.

- Стоимость и эффективность: вместо того, чтобы передавать массовый контекст каждому быстрому быстрому, тряпительному агентам работают с точностью - снижение затрат и повышение качества отклика.

Роль Рэг: на этом слое Rag не просто бэкэнд -сервис; Он становится частью «инструментария» агента - каждый агент может запросить базы знаний, магазины документов или API по мере необходимости для ее конкретной подзадачи.

Шаблоны для состава агента и ответственности

- Агенты с одним ответом: каждый агент хорошо справляется с одной вещью (например, извлечение сущностей, проверяет факты, выполняет классификацию).

- Агентная оркестровая: несколько агентов сотрудничают в последовательности или параллели, управляемые оркестровским слоем или двигателем рабочего процесса.

- Гибридные агенты: некоторые агенты смешивают возможности LLM с детерминированными логиками или инструментами поиска, адаптируются к контексту и задаче.

Пример рабочий процесс:

Безопасность, конфиденциальность и эксплуатационная практика

- Наименьшая привилегия: ограничить доступ к данным каждого агента только к тому, что необходимо.

- Аудит и прослеживаемость: действия, запросы и потоки данных журнала агента для мониторинга и соответствия.

- Изоляция: запустить чувствительные или высокие задачи в агентах с песочницей, предотвращая утечку по границам.

- Управление затратами: отслеживание токена для каждого агента и использования API, позволяя мелкозернистое бюджетирование и дросселирование.

Реальные варианты использования

- Поиск предприятия: один агент обрабатывает анализ запросов, другой извлекает документы через RAG, третий обобщает результаты.

- Соответствие нормативным требованиям: агенты обрабатывают редакцию, проверку данных и обеспечение соблюдения политики, прежде чем что -либо достигнет пользователя.

- Боты поддержки клиентов: специализированные агенты обрабатывают намерения, эскалацию, персонализацию и поиск контекста - каждая из которых имеет изолированную логику и доступ к данным.

Краткое содержание

Агент слой превращает монолитную логику подсказки в масштабируемую модульную архитектуру - отражает способ, которым современное программное обеспечение разлагается сложности. Используя агенты для разделения, специализации и безопасности, организации создают системы LLM, которые не просто более мощные, но также более безопасные, дешевле и легче поддерживать.

Слой оркестровки: рабочий процесс, тряпка и защита от будущего

По мере того, как системы LLM растут по объему и сложности, надежная доставка больше не может зависеть от изолированных подсказок или отдельных агентов. Слой оркестровки становится архитектурной основой - «дирижером», который управляет рабочими процессами, бизнес -логикой, состоянием, ограждениями и интеграциями по всему стеку.

Оркестровка: нервный центр системы

Слой оркестровки координирует каждую движущуюся часть:

- Управление рабочими процессами: организует передачу между агентами, вызовы LLM, модулями поиска и внешними API.

- Управление государством: отслеживает разговор, пользовательский контекст, промежуточные результаты и прогрессирование рабочего процесса. Это имеет решающее значение для задач с несколькими поворотами, контекстных операций и долгосрочных бизнес-процессов.

- Guardrails и Business Logic: обеспечение соблюдения политик, этапов проверки, обработки исключений и требований к соответствию - обеспечение точных и безопасных результатов.

Ключевое отличие: в традиционных архитектурах рабочие процессы кодируются как трубопроводы или технологические двигатели. С LLMS оркестровая также должна управлять вероятностным поведением, неоднозначными выходами и динамическим ветвлением, часто «адаптируясь на лету».

Тряпка: двигатель знаний

Поигрыватель Поиграть (RAG) лежит в основе этого слоя. Оркестровка определяет, когда и как:

- Получите соответствующие данные из баз знаний, векторных магазинов или API.

- Фильтруйте, проверяйте и обогатите контекст, прежде чем передавать его LLMS или агентам.

- Контроль затрат на поиск, снизить риски «галлюцинации» и оптимизировать для актуальности.

Двойные роли для тряпки:

- Системный: централизованный поиск знаний для всего рабочего процесса - инъекция глобального контекста, обновление знаний в режиме реального времени.

- Уровень агента: целевой поиск для конкретных подзадач-позволяя агентам работать с минимальным, высоким контекстом.

Образцы оркестровки и подводные камни

Общие закономерности:

- Последовательная оркестровка: линейные цепи задач/агентов (например, Parse → Retive → Summarize → Validate).

- Параллельная оркестровая: несколько агентов/процессов работают одновременно (например, извлечение различных объектов или понимания параллельно).

- Условное ветвление: динамические шаги рабочего процесса на основе промежуточных выходов LLM или действий пользователя.

Подводные камни, чтобы избежать:

- Потеря состояния: неспособность сохранять или пройти контекст между шагами, приводит к сломанным разговорам и «глупым» рабочим процессам.

- Невысокие рабочие процессы: без четкого ведения ведения журнала, отслеживания и мониторинга практически невозможно отладить или улучшить поведение системы.

- Дрейф с тряпкой: неконтролируемые запросы на поиск могут приносить нерелевантный или устаревший контекст, что со временем вызывает ухудшение выходного производства.

Будущая защита: принципы устойчивой оркестровки

- Явное управление государством: постоянные разговоры и состояния задачи в структурированных магазинах; Никогда не полагайтесь только на память LLM.

- Выходная проверка: интегрируйте слои валидации, как на основе правил, так и LLM, чтобы улавливать ошибки, галлюцинации и проблемы форматирования.

- Версия рабочие процессы: лечить логику оркестровки как код: версии, протестированные и контролируемые.

- Непрерывный мониторинг: регистрируйте каждый шаг рабочего процесса, точность измерения, задержку и стоимость; Установите оповещения о аномалиях или сбоях.

- Компонируемые оркестровки: построить рабочие процессы как модульные, реконфигурируемые компоненты: будущие обновления или модельные свопы не должны требовать переписывания всего трубопровода.

Краткое содержание

Слой оркестровки-это разница между хрупкими демонстрациями и надежными, производственными системами LLM. Управляя рабочими процессами, состоянием и контекстными знаниями, способствующими хорошо управляемой тряпкой, организации создают решения искусственного интеллекта, которые являются не просто умными, но и надежными, масштабируемыми и готовыми к тому, что будет дальше.

Тряпичная (поиск-аугментированный поколение) углубленное

Рэг сидит на пересечении гибкости LLM и необходимости точной, современной и богатой контекстом инъекции знаний.

Почему тряпка? Устранение ограничений контекста и динамических потребностей знаний

LLMS, независимо от того, насколько велик, есть фиксированные контекстные окна и статическое «отсечение знаний» на основе их последних данных обучения.

- Контекстные ограничения: даже самые крупные модели могут обрабатывать только несколько десятков страниц за раз, гораздо меньше, чем большинство баз знаний предприятия или наборы реальных документов.

- Уверяющие знания: без поиска LLMS не может ответить на вопросы о новой политике, свежих документах или изменяющейся среде.

RAG решает эти проблемы, предоставляя LLM доступ к внешним, современным источникам-обеспечивает динамическое целевое введение знаний во время вывода.

Как работает тряпка: двигатель под капюшоном

- Понимание: Учитывая пользовательский запрос или подсказку рабочего процесса, система использует поиск (Semantic/Vector Search, ключевое слово, гибрид) для получения наиболее важных документов, фактов или фрагментов данных из одного или нескольких внешних источников (базы данных, API, файловые системы и т. Д.).

- Фильтрация: полученные результаты ранжируются, отфильтрованы и иногда конденсируются - удаление шума, дубликатов или нерелевантного контекста.

- Контекстная конструкция: курируемый контекст отформатируется (в виде отрывков, фрагментов или структурированных данных) и добавляется к приглашению пользователя или вводу агента.

- Интеграция LLM: LLM получает обогащенную подсказку, которая теперь основана как на собственных знаниях, так и на последних результатах поиска, и генерирует окончательный ответ или действие.

Пример потока:

- Пользователь спрашивает о политике.

- Система извлекает последний документ из политики KB.

- LLM отвечает, ссылаясь на новые данные, а не только на его обучающий набор.

Системная против агента, доступная тряпка

- Системная тряпка: поиск управляется централизованно, кормит всех агентов/рабочих процессов из одного двигателя знаний.

- Агент, доступную тряпку: отдельные агенты вызывают поиск модулей напрямую, адаптируя запросы к своим подзадатам.

Лучшие практики инженеров

- Курация знаний: регулярно индексировать, чистить и дедуплизировать исходные данные; Установите надежные обновления трубопроводы.

- Оптимизация запросов: настройка алгоритмы поиска как для отзывания, так и для точности. Избегайте «чрезмерных» контекстов.

- Выходная проверка: всегда проверяйте вывод LLM по сравнению с полученными фактами, ответы на флаги не поддерживаются непосредственно в контексте.

- Прослеживаемость: журнал, которые источники использовались для каждого ответа. Это важно для аудитов, отладки и соответствия.

Общие случаи сбоя и как их избежать

- Дрифт запроса: по мере изменения подсказок или задач, шаблоны поиска могут стать слишком широкими или слишком узкими, отсутствующими соответствующей информацией или шумом впрыскивания.

- Уверяющий поиск: если базы знаний не обновлены или старые данные не обрезаны, LLM могут уверенно галлюцинировать устаревшие факты.

- Перегрузка контекста: слишком много полученных отрывков разбавляют качество ответа и могут выпустить важные детали из -за пределов окна контекста.

Мониторинг и оценка тряпки

- Метрики точности и отзывов: как часто используется правильная информация?

- Отслеживание затрат: мониторинг поиска API и использования токенов LLM за запрос.

- Измерение задержки: убедитесь, что тряпка не становится узким местом системы.

- Аудит: каждый вывод LLM должен быть отслеживается в его подтверждающем контексте.

Краткое содержание

Рэг-это двигатель, который мощет интеллект LLM и реальные, постоянно меняющиеся знания. При разработке и обслуживании с дисциплиной Rag превращает LLM из смагничителей с закрытыми коробками в надежные, контекстные решения проблем. Но тряпка не «установлена и забудьте» - это активная система, которая требует регулярного курирования, мониторинга и оптимизации.

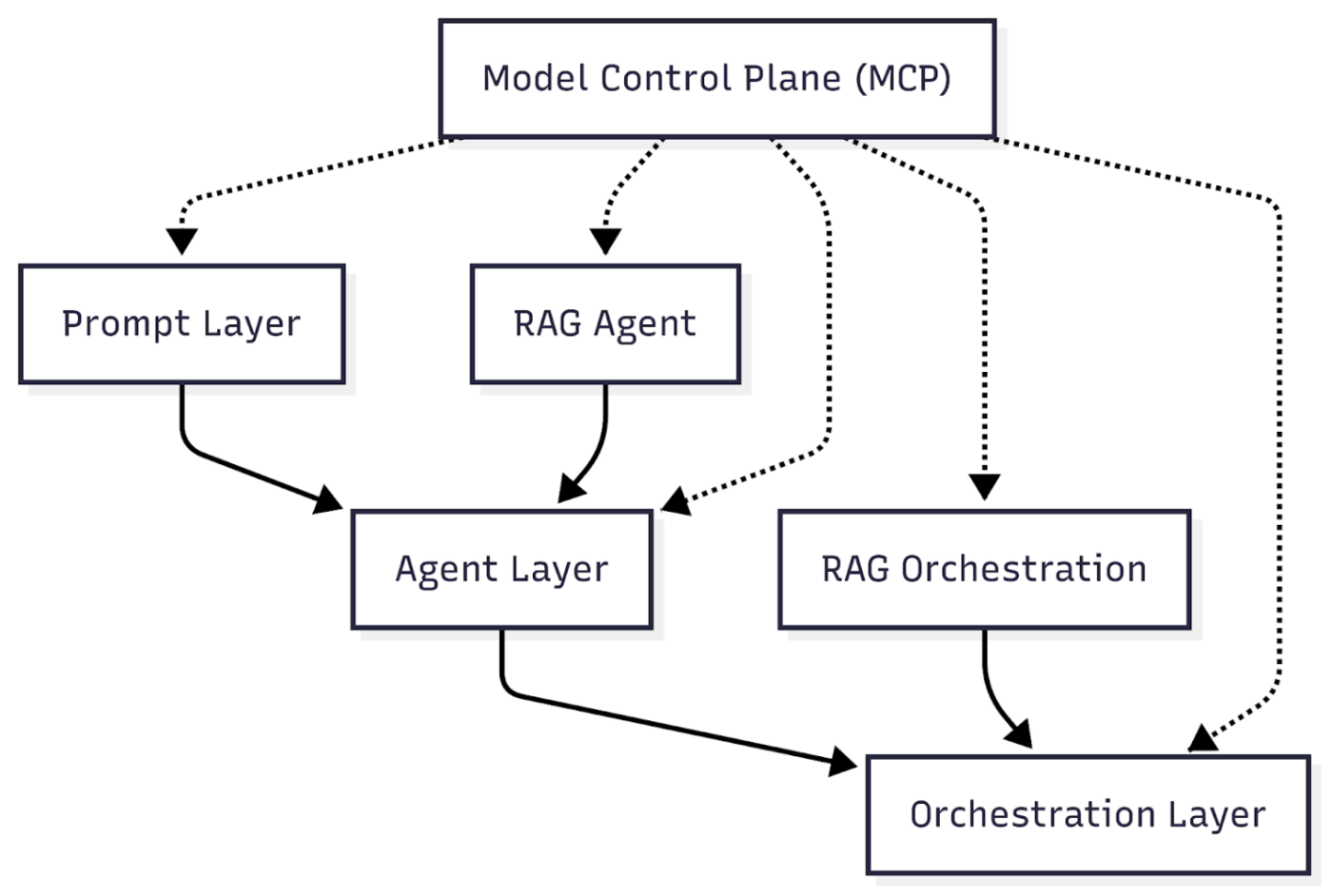

Плоскость управления модели (MCP): операционная система для LLMS

По мере того, как организации переходят от экспериментальных прототипов LLM к системам масштабирования производства, специальное управление быстро разрушается. Ответ-плоскость управления модели (MCP): централизованный политический слой, который управляет весь жизненный цикл моделей, агентов, подсказков и рабочих процессов оркестровки. Короче говоря, MCP - это доставка LLM, что является Kubernetes для микросервисов, операционной системы для надежной, безопасной и проверенной инфраструктуры ИИ.

Why is MCP a Must-Have

Без MCP:

- Разрастание: модели, агенты и подсказка пролиферируют неконтролируемыми способами - в разных командах, средах и бизнес -единицах.

- Незащитные изменения: обновления происходят из группы; Несоответствия версий, молчаливые регрессии и дрейф конфигурации становятся ежедневными рисками.

- Пробелы в безопасности и соответствии: нет единой точки для аудита, контроля доступа или обеспечения соблюдения политики. Конфиденциальные данные или экспериментальные модели проскользнули через трещины.

С MCP:

- Централизованное управление версиями: каждая модель, агент, подсказка и рабочий процесс отслеживают, версируют и откатываются по мере необходимости.

- Управление жизненным циклом: от первоначального развертывания путем тестирования, продвижения и детекции MCP обеспечивает соблюдение процессов и прозрачности.

- Безопасность и доступ: Unified RBAC (контроль доступа на основе ролей), журналы политики и журналы аудита в каждой точке контакта.

- Аудит и соответствие: сквозная прослеживаемость для каждого ответа-какие модели и данные использовались, кем и когда.

Основные функции MCP

- Реестр моделей: отслеживает все модели (Foundation, тонкая настраиваемая, экспериментальная), их версии, происхождение и статус развертывания.

- Управление приглашением и агентом: центральный магазин для всех шаблонов быстрого и агентского логики, включая историю версий и метаданные использования.

- Управление рабочим процессом: регистры и контролируют все трубопроводы оркестровки - включение обновлений, A/B -тестирования и постановочных развертываний.

- Политическое соблюдение: устанавливает правила общенациональной организации для конфиденциальности, безопасности, ограничений затрат и соответствия (например, региональные ограничения, выходные фильтры).

- Мониторинг и оповещение: общеобразовательные панели мониторинга, статистика использования и автоматические оповещения о дрейфе, шипах затрат или нарушениях безопасности.

Образцы реализации

- Декларативные конфигурации: рассматривать все определения модели, агента и рабочего процесса как код - управляемый через GIT, CI/CD и трубопроводы развертывания.

- Необываемые версии: не изменяется безмолвное «на месте». Ответы и Rollforwards явные, протестированные и проверенные.

- Управление детальным доступом: назначьте четкие роли, кто может развернуть, обновлять или выходить на пенсию модели и рабочие процессы.

- Автоматизированное тестирование и продвижение: промежуточные среды, автоматизированные эвалы и принятие пользователей до развертывания производства.

Суть

MCP не роскошь - это фонд, который отделяет демонстрационные проекты от производственных систем LLM. Лучшие архитектуры рассматривают контроль, видимость и безопасность как первоклассные функции, а не за последующими. Благодаря эффективному MCP организации разблокируют безопасное масштабирование, быстрое инновации и аудит Ironclad - необходимы в любой регулируемой или критически важной среде.

Реальные проблемы и подводные камни (проблемы и решения)

Никакая система LLM-мощности не переживает контакт с производством без изменений. Реальный мир быстро обнажает слепые пятна даже в лучших архитектурах. Понимание и планирование этих точек отказа и строительства надежных, тестируемых систем-это то, что отделяет надежный ИИ от демонстрационной дороги.

Общие точки отказа в архитектурах LLM

- Галлюцинации: LLM могут генерировать выходы, которые звучат правильно, но фактически неверны, изготовлены или даже опасны.

- Каскады ошибок: ранняя ошибка (например, плохое поиск или быстрое неверное толкование) распространяется через цепные агенты или шаги рабочего процесса, умножая ошибки вниз по течению.

- Потеря состояния: плохое управление разговором, контекстом или состоянием рабочего процесса приводит к отброшенным потокам, сбросам контекста или необъяснимой «амнезии» в приложениях, связанных с пользователем.

- Утечки конфиденциальности: конфиденциальные данные могут быть непреднамеренно включены в подсказки, журналы или выходы - разоблачение PII или бизнес -секретов.

- Стоимость бегла: неэффективные подсказки, неконтролируемое использование токенов и рекурсивные вызовы агентов могут поставить эксплуатационные расходы далеко за пределами первоначальных оценок.

Шаблоны для надежной проверки, тестирования и вывода QA

- Тестирование модуля и интеграции: создайте репрезентативные входные/выходные наборы для каждой подсказки, агента и рабочего процесса. Моделируют случаи краев, неоднозначные запросы и «стресс -тест» стека.

- Непрерывная оценка вывода: используйте автоматические метрики (точность, актуальность, токсичность, полнота) и обзор человека в петле. Отслеживайте дрейф с течением времени по мере развития моделей или подсказок.

- Мониторинг золотых наборов: поддерживайте набор «канонических» запросов с ожидаемыми ответами. Предупреждение об отклонениях.

- Структурированный выход и анализ: где это возможно, заставляйте LLMS для создания машинных выходов (например, JSON, таблиц) для автоматической проверки и нижней обработки.

- A/B -тестирование и поэтапные развертывания: всегда развертывайте новые рабочие процессы или модельные версии, стоящие за флагами функций, с опциями отката и измерением воздействия.

Уроки, извлеченные из неудачных развертываний

- Не доверяйте демонстрациям «счастливого пути»: пользователи производства и данные всегда найдут краевые случаи. Системы, которые выглядят надежными в изолированных тестах, часто разрушаются в реальном разнообразии и масштабе.

- Чрезмерная зависимость от LLM «Интуиция»: когда LLM разрешается угадать или импровизировать вне подтвержденного контекста, риск галлюцинации и нарушения политики.

- Игнорирование дрейфа: LLMS, подсказки и основные источники знаний все развиваются. Недоможденные системы разлагаются, производя устаревшие, нерелевантные или даже опасные результаты.

Лучшие практики безопасности и соответствия

- Запрашивая дезинфекцию: вычистите все входы и контекст для PII или конфиденциальных данных, прежде чем передавать внешние модели или журнал.

- Guardrails and Filters: Используйте явные политики: Блок небезопасных выходов, требуют ответов «я не знаю», когда данные недостаточны.

- Регистрация аудита: захватить каждую подсказку, контекст, версия модели и ответ для соответствия и пост-инцидента.

- Элементы управления доступом: лимит, кто может изменить подсказки, развертывание моделей или доступ к конфиденциальным данным в стеке.

Путь вперед: непрерывная устойчивость

Производственные системы LLM никогда не «выполняются». Они требуют непрерывного мониторинга, регулярной валидации и упреждающего управления рисками. Инвестировать в многоуровневую защиту: надежная оперативная инженерия, дизайн агента, оркестровка и культура эксплуатационного смирения. Компании, которые учатся на своих неудачах и делятся этими уроками, установит планку для безопасной и эффективной доставки искусственного интеллекта.

Практическое руководство и контрольный список: как начать, не испортив

Строительство систем LLM, готовых к производству, обманчиво легко начать и опасно легко сорвать. Разница между рабочим прототипом и масштабируемым, поддерживаемым решением - это процесс, дисциплина и честный взгляд на риск. Вот пьеса для того, чтобы получить его прямо с первого дня.

Шаг 1: Определите свой вариант использования в реальном мире

- Какова бизнес -цель или страна пользователя?

- Является ли LLM лучшим подходом, или есть более простая детерминированная альтернатива?

- Кто такие настоящие пользователи и как для них выглядит «успех»?

Шаг 2: Наметите поток данных и знаний

- Какие данные или документы должны получить систему? Где живут обновленные, авторитетные знания?

- Есть ли границы конфиденциальности или соответствия? Что не может быть подвергнуто LLM?

- Начните с минимальной, проверенной базы знаний для первоначальных экспериментов.

Шаг 3: Постройте свой стек - слой по слою

- Быстрый слой

- Агент слой

- Оркестровский слой

- Плоскость управления модели

Шаг 4: Проверка за пределами «счастливого пути»

- Создайте сложные тестовые примеры и «красную команду» свой собственный стек.

- Моделируйте ошибки пользователей, неоднозначные подсказки и состязательные входы.

- Мониторинг вывода дрейфа как моделей, данных или подсказки об изменении.

Шаг 5: Мониторинг, просмотр и итерация

- Настройка автоматизированных метрик: точность, релевантность, стоимость, частота ошибок, задержка.

- Регулярно просмотрите журналы и отзывы пользователей - ищите как ложные позитивы, так и ложные негативы.

- Планируйте непрерывную уточнение по мере развития масштабов и требований использования.

Анти-паттерны и красные флаги: что не нужно делать

- Монолитная логика подсказки: одна огромная подсказка, без модульности, без контроля версий.

- «Это просто работает»: менталитет: пропуск тестирования, мониторинга или проверки.

- Знание в твердом кодировании: обходные извлечения устаревшие, неполные или несоответствующие результаты.

- Нет отката или аудита: развертывание модели или изменения рабочего процесса без возможности отслеживать, возвращать или объяснять результаты.

- Игнорирование конфиденциальности/соответствия: разоблачение конфиденциальных данных, неспособность документировать, кто может видеть или обновить что.

Краткий контрольный список

- □ Является ли ваш вариант использования чистым, ценным и измеримым?

- □ Есть ли у вас минимальная, безопасная база знаний и карта данных?

- □ Ваши подсказки версии, протестированы и просмотрены?

- □ Модуль вашего агента, с четким разделением обязанностей?

- □ Является ли оркестровка, с состоянием и контекстом, управляемым за пределами LLM?

- □ Является ли каждая часть вашего стека наблюдаемая и проверена?

- □ Есть ли у вас надежная проверка и ограждения от плохих результатов?

- □ Можете ли вы отказаться или проверить какие -либо изменения, запрос или обновление модели?

- □ Являются ли отслеживаемые и просмотренные отзывы пользователей?

- □ Понимаются и применяются ли конфиденциальность и соответствие?

Резюме: Great LLM Системы не создаются случайно. Они спроектированы - слой за слоем, с дисциплиной и смирением. Каждый ярлык, взятый в начале, становится дорогим уроком позже. Используйте этот контрольный список, избегайте общих ловушек и рассматривайте каждый ранний проект как основу для долгосрочного и масштабируемого успеха.

Слепые пятна и стратегические риски

Даже самые опытные технологические лидеры могут пропустить истинный масштаб архитектурного сдвига, управляемого LLM. Причина не является отсутствием интеллекта или амбиций - это то, что модели прошлого больше не применяются. Вот что часто упускается из виду, и как переосмыслить для будущего, построенного на языковом ИИ.

Почему лидеры упускают смену

- Системы LLM выглядят обманчиво простыми. Рабочее доказательство концепции легко; Масштабирование до надежности предпринимательства является совершенно другой дисциплиной.

- «Ящик» сохраняется. Лидеры рассматривают LLMS как дополнения к существующей архитектуре, а не как новый основополагающий слой с уникальными рисками и требованиями.

- Сосредоточьтесь на поверхностных показателях. Ранние пилоты преуспевают в скорости или новизны, в то время как технические долги, дрейф и дыры в соответствии с требованиями тихо накапливаются под поверхностью.

- Чрезмерная уверенность в устаревших практиках. Традиционные шаблоны SDLC, обзор кода или DevOps необходимы, но недостаточные - новые дисциплины, такие как быстрое инженерное инженер, управление поиском и непрерывная проверка, столь же важны.

Новые виды рисков

- Технический

- Бизнес

- Соответствие и конфиденциальность

Мышление: от статических правил до адаптивной, обучающей культуры

- Принимайте непрерывное обучение: «правильная» архитектура сегодня может потребоваться заменить или переработать завтра. Команды должны быть готовы тестировать, потерпеть неудачу и быстро адаптироваться.

- Институционализация любопытства: сделайте безопасным для инженеров спросить: «Что если?» и экспериментировать с новыми компонентами стека без штрафа за быстрой итерации или ранних ошибок.

- Ценность системы на уровне системы: поощряйте команды видеть весь рабочий процесс: от быстрого до поиска, оркестровки, валидации и обратно.

- Межфункциональное повышение: поддержка постоянного обучения в области быстрого инженера, поиска/тряпичной ткани и операционного мониторинга, а не только классических практик программного обеспечения.

Руководство для лидеров

- Обработать архитектуру LLM как основную инфраструктуру, а не эксперимент.

- Требование отслеживаемости, аудитации и надежного мониторинга с первого дня.

- Согласовать стимулы для команд, чтобы найти, сообщать и решать проблемы на ранних стадиях - вознаградить проактивное управление рисками, а не только «героическое» пожаротушение.

- Создайте партнерские отношения с командами по соблюдению, конфиденциальности и рискам - не оставляйте их из проектов LLM, пока не станет слишком поздно.

Резюме: самый большой риск предполагает, что усыновление LLM - «просто еще один проект». В действительности, это долгосрочный, основополагающий сдвиг, который будет вознаграждать организации, способные отучить, переучить и адаптировать свою архитектуру и культуру к новым правилам доставки с AI.

Контрольный список Self & Team: Вы действительно готовы к LLM?

Используйте этот контрольный список в качестве структурированного аудита ваших возможностей LLM. Он охватывает технические навыки, зрелость процесса и культурное выравнивание - так что вы точно знаете, куда инвестировать дальше.

1.

- □ Есть ли у нас члены команды, квалифицированные в быстром дизайне (учебная, несколько выстрелов, цепочка мыслей, модульные подсказки)?

- □ Являются ли подсказки версии, рецензированы и протестированы как код?

- □ Можем ли мы быстро адаптировать или отлаживать подсказки по мере изменения требований или моделей?

2. оркестровка и рабочий процесс

- □ Является ли наш слой рабочего процесса явным и модульным (не скрытым внутри подсказок)?

- □ Управляем ли мы состоянием, контекстом и координацией агента вне LLM?

- □ Можем ли мы проследить, контролировать и откатываться от изменения рабочего процесса?

3. Поигрывательный поколение (Rag)

- □ Есть ли у нас возможности RAG - использование внешних баз знаний, семантический поиск или API?

- □ Наш источник данных курируется, актуально и проверен?

- □ Всегда ли выходы основаны на извлеченном, авторитетном контексте?

4. Безопасность и соответствие

- □ Созданы ли границы конфиденциальности в подсказках, данных и журналах?

- □ Есть ли у нас автоматизированные ограждения, проверка вывода и обеспечение соблюдения политики?

- □ Зарегистрирован ли каждый шаг (приглашение, агент, рабочий процесс) для аудита и соответствия?

5. Управление затратами

- □ Неужели мы отслеживаем и прогнозируем токен/API, расходы на приглашение, агент и уровень рабочего процесса?

- □ автоматически обнаруживаются и ограничены сбежавшие петли или сбежавшие петли?

- □ Можем ли мы сообщить о реальных соотношениях стоимости к значению для каждой функции, управляемой LLM?

6. Выравнивание стоимости и обратная связь

- □ Являются ли бизнес -цели, потребности пользователей и метрики успеха четко определены и отслеживаются для каждого варианта использования LLM?

- □ Регулярно ли мы просматриваем отзывы пользователей, качество вывода и ошибки?

- □ Существует ли механизм, который бы быстро действовал по обратной связи, обновления подсказки и развития рабочих процессов?

7. Upskilling & Culture

- □ Повышены ли инженеры, лидеры продукции и владельцы бизнеса в мышлении LLM, а не только классические практики программного обеспечения?

- □ Разве мы регулярно проводим обзоры и упражнения «красная команда» для риска и качества LLM?

- □ Оценивает ли руководство поставку LLM как стратегическую возможность, а не только технический эксперимент?

Как использовать этот контрольный список

- Любая неконтролируемая коробка является предметом действия или риском.

- Назначьте владельцев и сроки для закрытия каждого разрыва.

- Повторно поощряйте ежеквартально по мере развития вашей архитектуры, данных и бизнес-требований.

Резюме: Усыновление LLM не о проверке одной коробки-это непрерывная, кросс-функциональная готовность. Этот контрольный список делает пробелы видимыми, разъясняет приоритеты и гарантирует, что LLM становятся реальным активом, а не ответственностью в вашей организации.

Вывод: архитектура LLM как реальная основа

Возраст крупных языковых моделей не является мимолетной тенденцией или набором «прохладных демонстраций». Это постоянный сдвиг в том, как мы строим, доставляем и эксплуатируем интеллектуальное программное обеспечение. LLMS, когда архизировано с дисциплиной и предвидением, могут разблокировать скорость, адаптивность и ценность в инструментах устаревших масштабов просто не могут совпадать. Но добраться туда есть выбор, а не несчастный случай.

Что действительно делает этот сдвиг фундаментальным, так это прибытие нового архитектурного измерения: неопределенность. В отличие от предыдущих технологических волн, непредсказуемость теперь является основным дизайнерским ограничением, присутствующим в каждой подсказке, агенте, оркестровке, и особенно в пределах внимания модели. Инжиниринг для LLMS означает инженерию для неоднозначности и дрейфа, а не только для масштаба или производительности. Команды, которые будут успешными, - это те, которые учатся наблюдать, управлять и даже использовать эту неопределенность, рассматривая ее как первоклассный элемент архитектуры, а не проблема, которую нужно устранить.

Что дальше для лидеров и архитекторов

Сделайте архитектуру LLM основной частью вашей технологий и бизнес -карты. Обратитесь к нему как к инфраструктуре, а не к эксперименту. Настаивайте на выводе версий, валидации, мониторинге и непрерывном улучшении.

- Чемпион Новые навыки и роли. Инвестируйте в команды по повышению квалификации в быструю инженерию, тряпку, оркестровку и управление. Межфункциональная экспертиза отделяет победителей от Laggards.

- Начните с малого - но начните правильно. Пилот с реальными деловыми случаями, слоистыми архитектурами и явными ограждениями. Создайте петли обратной связи, наблюдение и аудит с первого дня.

- Обратитесь к каждой неудаче как урок. Отслеживать, что идет не так, а не только то, что работает. Поделитесь изучением открыто для команд и дисциплин - именно так ИИ становится безопасным и эффективным в масштабе.

- Оставаться адаптивным. Темп изменения ИИ не замедляется. Создайте культуру, в которой архитектура и процесс могут развиваться без драмы - потому что то, что является «лучшей практикой» сегодня, снова сдвинутся завтра.

Действия в понедельник утро

- Определите одну область, где вы можете добавить управление версиями, проверкой или мониторинг в свой стек LLM на этой неделе.

- Запланируйте командную сессию, чтобы сопоставить ваши текущие рабочие процессы LLM - выделите риски, неизвестные и скрытые зависимости.

- Назначьте одного владельца для LLM Pretency: кого -то, кто может управлять аудитами, обучения и постоянного улучшения.

Последняя мысль:

Будущее систем, управляемых LLM, не будет выиграно тем, кто имеет больше всего токенов или новейшей модели фонда. Победителями будут те, кто рассматривает архитектуру LLM как к ремеслу, постоянно повышает свои команды и организует каждый слой для надежности, безопасности и скорости. Строительство реальной ценности с ИИ - это командный вид спорта, который вознаграждает тех, кто инвестирует в освоение стека, а не только в погоне за характеристиками моделей. Освоение этого нового архитектурного измерения, где неопределенность является постоянной переменной - будет определять организации, которые терпят, адаптируются и приводят в следующем десятилетии интеллектуального программного обеспечения.

PMO & Delive Head

Vitalii oborskyi -https://www.linkedin.com/in/vitaliioborskyi/

Оригинал