Когда эксперты не согласны, пусть Unipelt решит

13 августа 2025 г.Таблица ссылок

Аннотация и 1. Введение

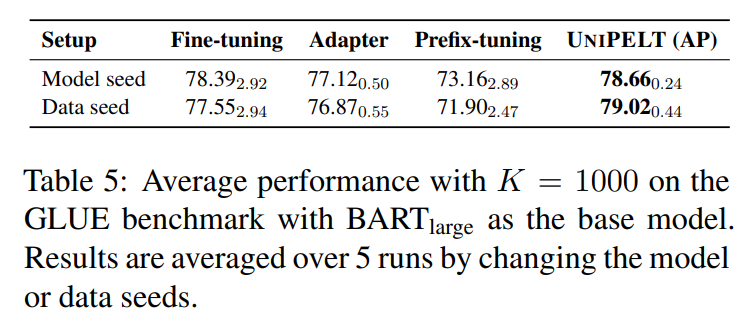

Предварительные

Объединение методов шкура

Эксперименты

4.1 Настройка эксперимента

4.2 Анализ отдельных методов шкура

4.3 Анализ Unipelt

4.4 Эффективность методов шкура

Связанная работа

Заключение, подтверждение и ссылки

5 Связанная работа

Параметр-эффективная настройка ПЛМС.Поскольку все больше невозможно обучать и хранить полные копии больших ПЛМС для различных задач вниз по течению, как эффективно настроить ПЛМС с помощью нескольких обучаемых параметров, становится критическим. Существующие методы PELT могут быть в значительной степени разделены на две категории, основываясь на том, введены ли новые обучаемые параметры. В частности, можно либо обучить подмножество параметров модели, таких как головка прогнозирования (Lee et al., 2019) и термины смещения (Ben Zaken et al., 2021), или ввести специфические для задачи параметры в разные части PLM, такие как многократное внимание. Поскольку число методов шкура продолжает расти, цель Unipelt - лучше понять и использовать различия различных методов вместо того, чтобы предлагать еще один метод.

Смесь экспертов.Unipelt также связан с подходами, которые включают сеть высокой емкости, и активируют (увеличенный) различные части сети с учетом различных входов. Одним из примечательных примеров является смеси экспертов (MOE) (Jacobs et al., 1991; Shazeer et al., 2017), который поддерживает набор экспертов (нейронные сети) и одного или нескольких тренировочных ворот, которые выбирают комбинацию экспертов, специфичных для каждого входа. Несмотря на концептуально сходное, Unipelt отличается от MOE: подмодулы в Unipelt явно комбинируются не суммированием, таким как MOE, но в последовательном порядке и неявно влияют друг на друга. Более того, «эксперты» разнообразны в Unipelt, в то время как обычно однородные или идентичные в методах MOE.

6 Заключение

В этой статье мы представляем всестороннее исследование методов настройки модели (SELT), эффективных для параметров (SELT) и предлагаем единую структуру, которая включает в себя различные методы PELT в качестве подмодулей и учится активировать наиболее подходящие подмодулы для заданной задачи или настройки данных. Наша предлагаемая структура последовательно превосходит обычную точную настройку, а также подмодули, которые она включает в различные настройки, и обычно превосходит верхнюю границу, которая берет наилучшую производительность каждого подмодуля, используемого индивидуально для каждой задачи. Наши результаты показывают, что смесь множества методов шкура, которые включают в себя различные части PLM, может быть благоприятной как в отношении эффективности модели, так и надежности. Для будущей работы мы постараемся лучше понять несоответствие различных методов шкура в разных сценариях. Мы также планируем исследовать многозадачную настройку, где можно активировать несколько подмодулей и сотрудничать на уровне задачи.

Благодарности

Мы благодарим Сян Лизу Ли, Хай Йе, Рабеэ Карими Махабади, Джунсиан Хе, Икин Се, Якинг Ван и Лиюань Лю за полезные обсуждения и отзывы. Мы благодарим анонимных рецензентов за ценные комментарии и предложения.

Ссылки

Элад Бен Закен, Шаули Равфогель и Йоав Голдберг. 2021. BitFit: простой параметры, эффективная тонкая настраиваемая настройка для маскированных языковых моделей на основе трансформаторов. arxiv e-prints, страницы Arxiv-2106.

Том Б. Браун, Бенджамин Манн, Ник Райдер, Мелани Суббия, Джаред Каплан, Прафулла Дхаривал, Арвинд Нилакантан, Пранав Шьям, Гириш Сыпри, Аманда Аскилл и др. 2020. Языковые модели-несколько учащихся. Arxiv Preprint arxiv: 2005.14165.

Джейкоб Девлин, Мин-Вей Чанг, Кентон Ли и Кристина Тутанова. 2019. Берт: предварительное обучение глубоких двунаправленных трансформаторов для понимания языка. В материалах Конференции Северной Америки в Северной Америке Ассоциации вычислительной лингвистики: технологии человеческого языка, том 1 (длинные и короткие документы), стр. 4171–4186, Миннеаполис, Миннесота. Ассоциация вычислительной лингвистики.

Ning Ding и Shengding Hu. 2021. Необходимо прочитать документы на настройке на основе быстрого на основе предварительно обученных языковых моделей. https://github.com/ thunlp/rompterpapers.

Tianyu Gao, Adam Fisch и Danqi Chen. 2021. Создание предварительно обученных языковых моделей лучше учащихся. В материалах 59 -го ежегодного собрания Ассоциации по вычислительной лингвистике и 11 -й Международной совместной конференции по обработке естественного языка (том 1: длинные документы), стр. 3816–3830, онлайн. Ассоциация вычислительной лингвистики.

Yuxian Gu, Xu Han, Zhiyuan Liu и Minlie Huang. 2021. PPT: предварительно обученная оперативная настройка для нескольких выстрелов. Arxiv Preprint arxiv: 2109.04332.

Деми Го, Александр Раш и Юн Ким. 2021. Параметр-эффективное обучение переноса с обрезкой DIFF. В материалах 59 -го ежегодного собрания Ассоциации по вычислительной лингвистике и 11 -й Международной совместной конференции по обработке естественного языка (том 1: Долгок), стр. 4884–4896, онлайн. Ассоциация вычислительной лингвистики.

Руидан Х. Х., Линлин Лю, Хай Йе, Циню Тан, Бошенен Дин, Лиинг Ченг, Цзявей Лоу, Лидонг Бинг и Луо Си. 2021. Об эффективности адаптерной настройки для адаптации на предварительно пребываемой языке. В материалах 59 -го ежегодного собрания Ассоциации вычислительной лингвистики и 11 -й Международной совместной конференции по обработке естественного языка (том 1: длинные документы), стр. 2208–2222, онлайн. Ассоциация вычислительной лингвистики.

Нил Хоулсби, Андрей Джургиу, Станислав Ястзбски, Бруна Моррон, Квентин де Ларуссилхе, Андреа Гесмундо, Мона Аттарияян и Сильвен Гелли. 2019. Параметр-эффективное обучение передачи для NLP. На Международной конференции по машинному обучению, страницы 2790–2799. PMLR.

Эдвард Дж. Ху, Йелонг Шен, Филипп Уоллис, Зейуан Аллен-зху, Юаньжи Ли, Шин Ван и Вайуху Чен. 2021. LORA: Низкая адаптация крупных языковых моделей. Arxiv Preprint arxiv: 2106.09685.

Роберт А. Джейкобс, Майкл I Джордан, Стивен Дж. Новлан и Джеффри Э. Хинтон. 1991. Адаптивные смеси местных экспертов. Нейронные вычисления, 3 (1): 79–87.

Рабех Карими Махабади, Джеймс Хендерсон и Себастьян Рудер. 2021a. Компактер: эффективные слои гиперкомплекса с низким уровнем гиперкомплекса. Arxiv Preprint arxiv: 2106.04647.

Рабеэ Карими Махабади, Себастьян Рудер, Мостафа Дехгани и Джеймс Хендерсон. 2021b. Parametreeffiate Multi-Task FineNuling для трансформаторов через общие гипернеты. В материалах 59 -го ежегодного собрания Ассоциации вычислительной лингвистики и 11 -й Международной совместной конференции по обработке естественного языка (том 1: длинные документы), стр. 565–576, онлайн. Ассоциация вычислительной лингвистики.

Jaejun Lee, Raphael Tang и Jimmy Lin. 2019. Что бы сделала Эльза? Замораживание слоев во время тонкой настройки трансформатора. Arxiv Preprint arxiv: 1911.03090.

Брайан Лестер, Рами аль-Рфу и Ной Константа. 2021. Мощность масштаба для параметров-эффективной настройки приглашения. Arxiv Preprint arxiv: 2104.08691.

Майк Льюис, Иньхан Лю, Наман Гоял, Марджан Газвинийнжад, Абдельрахман Мохамед, Омер Леви, Веселин Стоянов и Люк Зеттлемойер. 2020. Барт: денорирующая последовательность к последовательности предварительно подготовки для генерации естественного языка, перевода и понимания. В материалах 58 -го ежегодного собрания Ассоциации вычислительной лингвистики, страницы 7871–7880, онлайн. Ассоциация вычислительной лингвистики.

Сян Лиза Ли и Перси Лян. 2021. Префикс-настройка: оптимизация непрерывных подсказок для генерации. В материалах 59 -го ежегодного собрания Ассоциации по вычислительной лингвистике и 11 -й Международной совместной конференции по обработке естественного языка (том 1: Долгошны), стр. 4582–4597, онлайн. Ассоциация вычислительной лингвистики.

Jonas Pfeiffer, Aishwarya Kamath, Andreas Rücklé, Kyunghyun Cho и Iryna Gurevych. 2021. Адаптерфузия: неразрушающая задача состав для обучения передачи. В материалах 16 -й конференции Европейской главы Ассоциации вычислительной лингвистики: основной том, страницы 487–503, онлайн. Ассоциация вычислительной лингвистики.

Джонас Пфайффер, Андреас Рюкле, Клифтон Пот, Айшвария Камат, Иван Вулиник, Себастьян Рудер, Кюнхён Чо и Ирина Гуреви. 2020a. Адаптерхуб: структура для адаптации трансформаторов. В материалах конференции 2020 года по эмпирическим методам в обработке естественного языка (EMNLP 2020): Системные демонстрации, страницы 46–54, онлайн. Ассоциация вычислительной лингвистики.

Jonas Pfeiffer, Ivan Vulic, Iryna Gurevych и Se-Bastian Ruder. 2020b. MAD-X: адаптерная структура для многозадачного перекрестного переноса. В материалах конференции 2020 года по эмпирическим методам в обработке естественного языка (EMNLP), стр. 7654–7673, онлайн. Ассоциация вычислительной лингвистики.

Тимо Шик и Хинрих Шютце. 2021. Использование взыскания для классификации текстовых и естественного языка. В материалах 16 -й конференции Европейской главы Ассоциации вычислительной лингвистики: основной том, страницы 255–269, онлайн. Ассоциация вычислительной лингвистики.

Ноам Шейзер, Азалия Мирхосейни, Кзиштоф Мазиарц, Энди Дэвис, Кук Ле, Джеффри Хинтон и Джефф Дин. 2017. Возмутительно крупные нейронные сети: редко управляемый слой смеси экспертов. Arxiv Preprint arxiv: 1701.06538.

Алекс Ван, Аманприт Сингх, Джулиан Майкл, Феликс Хилл, Омер Леви и Сэмюэл Р. Боуман. 2019. Клей: многозадачный эталон и платформа анализа для понимания естественного языка. В Международной конференции по обучению

Томас Вольф, Дебют Лисандр, Виктор Сан, Жюльен Чаумонд, Клемент Деланги, Энтони Мои, Пиррический Cistac, Тим Рулт, Реми Луф, Морган Фантович и др. 2019. Трансформеры Huggingface: современная обработка естественного языка. Arxiv Preprint arxiv: 1910.03771.

Томас Вольф, Дебют Лисандре, Виктор Санх, Джульен Чаумонд, Клемент Деланги, Энтони Мои, Пиррический Систак, Тим Рулт, Реми Луф, Морган Фантович, Джо Дэвисон, Сэм Шлейфер, Патрик Фон Платен, Клара Ма, Ясин Джернит, Джульен Плайен, Кавен Люг, Сивен Люг, Сивен Люг, Сивен Люг, Сивен Люуг, Сивен Люуг, Сивен Люуг, Сивен Ле. Мариама Дрейм, Квентин Лхоэст и Александр М. Раш. 2020. Как сравнить модели трансформаторов. https://huggingface.co/ transformers/benchmarks.html.

Джеффри О Чжан, Александр Сакс, Амир Замир, Леонидас Гибас и Джитендра Малик. 2020. Стоимость боя: базовая линия для адаптации сети через аддитивные боковые сети. В компьютерном видении - ECCV 2020: 16 -я Европейская конференция, Глазго, Великобритания, 23–28 августа 2020 года, Труды, часть III 16, страницы 698–714. Спрингер.

Префикс-настройка против быстрого настройки на основе быстрого настройки

Мы отмечаем, что префикс-настройка (или подключение быстрого подключения) отличается от методов точной настройки на основе быстрого настройки (Schick and Schütze, 2021; Gao et al., 2021) во многих отношениях: (1) Fine-Tuning на основе быстрого настройки не является параметром, поскольку обновляет все параметры модели, в то время как префикс-подключение только обновляет предварительный отфикс Matrix P. (2) Подсказки используются только при входе модели для точной настройки на основе быстрого настройки, но добавляются к каждому слою трансформатора в префиксе-настройке (хранятся как разные векторы). (3) Точная настройка на основе быстрого настройки обычно использует тщательно спроектированные подсказки естественного языка, в то время как префикс-настройка использует непрерывные подсказки (виртуальные токены).

B Детали реализации

Подготовка данных.Мы перетасовываем тренировочный набор с семенами S, принимаем первые k -образцы в качестве нового учебного набора и следующие 1000 образцов в качестве набора разработки. Мы используем S = {111, 222, 333, 444, 555} в качестве семян данных и то же семя (S = 42) для обучения модели. Мы также проводим еще один набор предварительных экспериментов, фиксируя данные и используя 5 различных случайных семян для обучения модели, результаты которых похожи (Таблица 5).

ГиперпараметрыПолем Мы принимаем AdapterHub (Pfeiffer et al., 2020a), библиотеку, основанную на трансформаторах Huggingface (Wolf et al., 2019), как наша кодовая база. Мы в значительной степени следуем рекомендуемым гиперпараметрам, используемым в различных методах для справедливого сравнения. Мы установили длину ввода на 128, а размер учебной партии на 16. Мы устанавливаем количество эпох на 50 и принимаем раннюю остановку с терпением из 10 неразрешенных эпох. Мы устанавливаем скорость обучения тонкой настройки и адаптера на 2E-5 и 1E-4 в соответствии с результатами в предыдущих исследованиях (Pfeiffer et al., 2020a; He et al., 2021). Для префикса настройки и Unipelt, поскольку они ранее не оцениваются по задачам NLU, мы настраиваем их скорости обучения с {1E-4, 2E-4, 5E-4} на набор разработки и устанавливаем 2E-4 и 5E-4 соответственно. Для BitFit и Lora мы выбираем скорости обучения, обычно используемые в их собственных экспериментах (1E-4 и 5E-4 соответственно). Мы устанавливаем α = 2 и r = 8 в Лоре в соответствии с его официальными сценариями

C Результаты Барта

D Подробная производительность

В таблице 6 мы перечисляем подробные результаты как по разработке, так и по тестовым наборам теста клея. Наблюдения и результаты в значительной степени последовательны в двух разрывах оценки.

Авторы:

(1) Юнинг Мао, Университет Иллинойса Урбана-Шампейн и работа была выполнена во время стажировки в Meta AI (yuningm2@illinois.edu);

(2) Ламберт Матиас, Meta AI (mathiasl@fb.com);

(3) Rui Hou, Meta AI (rayhou@fb.com);

(4) Amjad Almahairi, Meta AI (aalmah@fb.com);

(5) Хао Ма, Мета Ай (haom@fb.com);

(6) Цзявей Хан, Университет Иллинойса Урбана-Шампейн (hanj@illinois.edu);

(7) Wen-tau Yih, Meta AI (scottyih@fb.com);

(8) Мадиан Хабса, Meta AI (mkhabsa@fb.com).

Эта статья есть

Оригинал