Что, если ваш уникальный стиль набора набора может стать вашим бесшовным паролем?

14 августа 2025 г.Представьте, что вы войдите в свой ноутбук, и вместо того, чтобы просто проверять свой пароль один раз, система непрерывно проверяет, что это действительно вы, анализируя, как вы печатаете. Нет дополнительного оборудования, нет сканирования лица, нет читателей отпечатков пальцев - только естественный ритм ваших пальцев, танцующих через клавиатуру. Добро пожаловать в Keystroke Dynamics, одно из самых элегантных решений Cybersecurity для непрерывной аутентификации.

Хотите верьте, хотите нет, но каждый раз, когда вы печатаете, вы создаете уникальную цифровую подпись. То, как вы удерживаете ключ «А», пауза миллисекундов между «th», небольшим колебаниям перед тем, как нажимать на пробел-эти микро-паттерны так же отличительны, как ваш почерк, и гораздо сложнее воспроизвести, чем украденные пароли.

Видеть шаблоны клавишных в качестве аутентификации

Традиционная аутентификация является двоичной: вы либо в том, что вы находитесь. Вы вводите свои учетные данные один раз, и система доверяет вам на всю сессию. Но что, если кто-то обрушится на ваш пароль? Что если вы уйдете от разблокированного терминала? Что если злоумышленник получает удаленный доступ к вашему аутентифицированному сеансу?

Непрерывная аутентификация решает это, постоянно спрашивая: «Это все же человек?» Вместо одной контрольно-пропускной пункты безопасности у вас есть десятки микроверикаций, которые происходят невидимо, когда вы работаете.

Понимание динамики нажатия клавиш

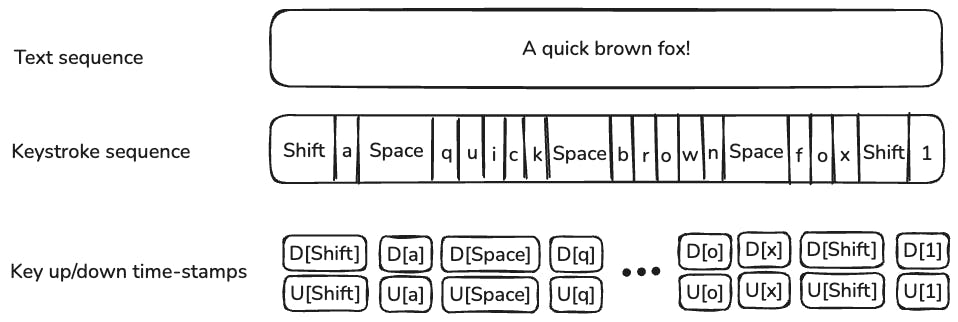

Динамика клавиш отражает уникальные временные закономерности в том, как типа людей типа. Мы записываем не просто какие клавиши, которые вы нажимаете, но когда и как вы их нажимаете. Думайте об этом как о поведенческой биометрии - выявляя людей по тому, что они делают, а не только то, что они знают или что у них есть.

Keystroke Event Sequence Visualization:

========================================

Raw Keystrokes: "hello"

Key: h e l l o

| | | | |

▼ ▼ ▼ ▼ ▼

Press ●----●----●----●----●

| | | | |

Release ●----●----●----●----●

| | | | |

Time: 0 50 120 180 220 280 (ms)

Dwell Times (Press to Release):

h: 45ms e: 38ms l: 42ms l: 35ms o: 48ms

Flight Times (Release to Next Press):

h→e: 25ms e→l: 28ms l→l: 18ms l→o: 12ms

Ключевые измерения включают:

Время задержки: Как долго вы удерживаете каждый ключ. Некоторые люди являются клавишами (быстро нажимайте и выпускают), другие-держатели клавиш (более длительная продолжительность давления).

Время полета: Интервал между выпуском одной клавиши и нажатием следующей. Это показывает ваш естественный ритм типирования и паттерны координации пальцев.

Динамика давления: На чувствительных к давлению клавиатуры, как сильно вы нажимаете клавиши. Нервные типовые могут нажать сильнее, расслабленные типовые, могут иметь более легкое прикосновение.

Скорость набора текста: Не только слова в минуту, но и ускорение и паттерны замедления в рамках слов и предложений.

Individual Typing Pattern Comparison:

====================================

User A (Fast Typer):

Dwell: ■■ (30ms avg) Flight: ■ (15ms avg)

Pattern: ●-●-●-●-●-●-●-● (Quick, consistent rhythm)

User B (Deliberate Typer):

Dwell: ■■■■ (65ms avg) Flight: ■■■ (45ms avg)

Pattern: ●---●---●---●--- (Slower, thoughtful pace)

User C (Variable Typer):

Dwell: ■■■ (50ms avg) Flight: ■■ (varies 10-80ms)

Pattern: ●--●-●----●--●- (Irregular, context-dependent)

Архитектура глубокого обучения

Вот где это становится интересным. Необработанные данные о сиянии клавишных-это грязные, высокие и полные шума. Традиционные подходы машинного обучения часто борются с временными сложностями и индивидуальными вариациями. Введите глубокое обучение.

Data Flow Architecture Overview:

===============================

Raw Keystrokes → Feature Extraction → Model Training → Authentication

↓ ↓ ↓ ↓

[h][e][l][l] [Dwell Times] [CNN/RNN] [User/Imposter]

Time stamps → [Flight Times] → Training → Decision

Press/Release [Velocities] [Patterns] [Confidence]

Full Pipeline Visualization:

===========================

Input Layer: [●●●●●●●●●●] (Keystroke sequence)

↓

Feature Layer: [■■■■] (Temporal features)

↓ ↘

CNN Branch: [▲▲▲] → [▼] (Pattern detection)

↓ ↘

RNN Branch: [◆◆◆] → [♦] (Sequence modeling)

↓

Fusion Layer: [⬢] (Combined features)

↓

Output: [0.87] (Authentication score)

Сверточные нейронные сети (CNN) для распознавания образцов

CNNS Excel при поиске пространственных паттернов, и мы можем использовать это для анализа клавишных, обрабатывая последовательности типирования как 1D -сигналы или преобразовав их в 2D -представления.

CNN Architecture for Keystroke Analysis:

=======================================

Input: Keystroke Sequence (100 timesteps × 4 features)

┌─────────────────────────────────────────────────┐

│ Dwell │■■□■■■□□■■■□■■□□■■■□■■■□□■■■□■■□□■■■□. │

│ Flight│□■■□□■■□■■□□■■□■■□□■■□■■□□■■□■■□□■■□. │

│ Press │■□■■□■□■■□■■□■□■■□■■□■□■■□■■□■□■■□■■. │

│ Velocity│□□■■■□□■■■□□■■■□□■■■□□■■■□□■■■□□■■■. │

└─────────────────────────────────────────────────┘

↓ Conv2D (32 filters, 3×1)

┌─────────────────────────────────────────────────┐

│ Feature Maps │

│ ▲▲▲▲ ▼▼▼▼ ◆◆◆◆ ●●●● ■■■■ □□□□ ★★★★ ☆☆☆☆ │

│ Filter responses detecting local patterns │

└─────────────────────────────────────────────────┘

↓ MaxPool + Conv2D (64 filters)

┌─────────────────────────────────────────────────┐

│ Higher-level Features │

│ ████ ▓▓▓▓ ░░░░ ▒▒▒▒ ■■■■ □□□□ │

│ Complex typing pattern detectors │

└─────────────────────────────────────────────────┘

↓ Global Average Pooling

[Feature Vector]

↓ Dense Layer

[Authentication Score: 0.92]

Pattern Recognition Examples:

============================

Filter 1: ■□■□■□ (Detects alternating dwell patterns)

Filter 2: ■■■□□□ (Detects burst typing followed by pause)

Filter 3: □■■■■□ (Detects acceleration patterns)

Filter 4: ■□□■□□ (Detects hesitation patterns)

Пример архитектуры CNN для извлечения функций клавишного:

import tensorflow as tf

def build_keystroke_cnn(sequence_length, num_features):

model = tf.keras.Sequential([

# Reshape input for 1D convolution

tf.keras.layers.Reshape((sequence_length, num_features, 1)),

# First convolutional block - captures local typing patterns

tf.keras.layers.Conv2D(32, (3, 1), activation='relu', padding='same'),

tf.keras.layers.BatchNormalization(),

tf.keras.layers.MaxPooling2D((2, 1)),

# Second block - captures mid-level temporal patterns

tf.keras.layers.Conv2D(64, (3, 1), activation='relu', padding='same'),

tf.keras.layers.BatchNormalization(),

tf.keras.layers.MaxPooling2D((2, 1)),

# Third block - high-level feature extraction

tf.keras.layers.Conv2D(128, (3, 1), activation='relu', padding='same'),

tf.keras.layers.GlobalAveragePooling2D(),

# Dense layers for classification

tf.keras.layers.Dense(256, activation='relu'),

tf.keras.layers.Dropout(0.3),

tf.keras.layers.Dense(1, activation='sigmoid') # Binary: authentic user or not

])

return model

CNN учится идентифицировать характерные закономерности в вашем типировании «сигнала». Как и то, как он может распознавать края в изображениях, он распознает отличительные сигнатуры времени в последовательностях ваших клавишных.

Рецидивирующие нейронные сети (RNN) для временного моделирования

В то время как CNN отлично подходят для распознавания шаблонов, RNN специально разработаны для последовательных данных. Типирование по своей сути временно - порядок и время нажатия нажатий имеют значительное значение.

RNN/LSTM Architecture for Keystroke Sequences:

==============================================

Keystroke Sequence: [k1] → [k2] → [k3] → [k4] → ... → [kn]

↓ ↓ ↓ ↓ ↓

LSTM Layer 1: [h1] → [h2] → [h3] → [h4] → ... → [hn]

↓ ↓ ↓ ↓ ↓

Memory States: [c1] [c2] [c3] [c4] ... [cn]

LSTM Layer 2: [h1'] → [h2'] → [h3'] → [h4'] → ... → [hn']

↓ ↓ ↓ ↓ ↓

Final Output: [Output]

↓

[Auth Score: 0.85]

LSTM Cell Internal Process:

==========================

Previous: h(t-1), c(t-1) Current Input: x(t)

↓ ↓

┌─────────────────────────────────────┐

│ Forget Gate: f(t) = σ(Wf·[h,x]+bf) │ ← Decides what to forget

│ Input Gate: i(t) = σ(Wi·[h,x]+bi) │ ← Decides what to update

│ Candidate: C̃(t) = tanh(Wc·[h,x]) │ ← New candidate values

│ Output Gate: o(t) = σ(Wo·[h,x]+bo) │ ← Controls output

└─────────────────────────────────────┘

↓

Memory Update: c(t) = f(t)*c(t-1) + i(t)*C̃(t)

Hidden State: h(t) = o(t) * tanh(c(t))

Temporal Pattern Learning:

=========================

Time: t1 t2 t3 t4 t5 t6

Input: [●] [●] [●] [●] [●] [●]

Pattern: Fast→Fast→Slow→Fast→Fast→Slow

Memory: ■ ■■ ■■■ ■■ ■■■ ■■■■

↑ ↑ ↑ ↑ ↑ ↑

Learn Build Slow Reset Repeat Confirm

rhythm context pattern state rhythm pattern

Перевод вышеуказанной архитектуры RNN/LSTM в Python:

def build_keystroke_rnn(sequence_length, num_features):

model = tf.keras.Sequential([

# LSTM layers to capture typing rhythm and dependencies

tf.keras.layers.LSTM(128, return_sequences=True, dropout=0.2),

tf.keras.layers.LSTM(64, return_sequences=True, dropout=0.2),

tf.keras.layers.LSTM(32, dropout=0.2),

# Dense layers for user identification

tf.keras.layers.Dense(128, activation='relu'),

tf.keras.layers.Dropout(0.3),

tf.keras.layers.Dense(64, activation='relu'),

tf.keras.layers.Dense(1, activation='sigmoid')

])

return model

RNN сохраняет внутреннюю память о вашей истории печати, узнавая, что ваш уникальный шаблон может быть быстрым, pause-Quick для определенных комбинаций букв, или что вы постоянно замедляете, прежде чем вводить числа.

Гибридная архитектура CNN-RNN

Наиболее мощный подход объединяет оба: CNNS извлекает локальные паттерны типирования, в то время как RNN моделируют временные зависимости.

def build_hybrid_keystroke_model(sequence_length, num_features):

# Input layer

inputs = tf.keras.layers.Input(shape=(sequence_length, num_features))

# CNN branch for pattern extraction

cnn_branch = tf.keras.layers.Reshape((sequence_length, num_features, 1))(inputs)

cnn_branch = tf.keras.layers.Conv2D(64, (3, 1), activation='relu', padding='same')(cnn_branch)

cnn_branch = tf.keras.layers.MaxPooling2D((2, 1))(cnn_branch)

cnn_branch = tf.keras.layers.Conv2D(32, (3, 1), activation='relu', padding='same')(cnn_branch)

cnn_branch = tf.keras.layers.Reshape((-1, 32))(cnn_branch)

# RNN branch for temporal modeling

rnn_branch = tf.keras.layers.LSTM(64, return_sequences=True)(inputs)

rnn_branch = tf.keras.layers.LSTM(32)(rnn_branch)

# Combine features

combined = tf.keras.layers.Concatenate()([

tf.keras.layers.GlobalAveragePooling1D()(cnn_branch),

rnn_branch

])

# Final classification

outputs = tf.keras.layers.Dense(128, activation='relu')(combined)

outputs = tf.keras.layers.Dropout(0.3)(outputs)

outputs = tf.keras.layers.Dense(1, activation='sigmoid')(outputs)

model = tf.keras.Model(inputs=inputs, outputs=outputs)

return model

Практический тренировочный трубопровод

Предварительная обработка данных

def preprocess_keystroke_data(raw_data):

"""

Convert raw keystroke events into feature vectors

"""

features = []

for session in raw_data:

# Calculate dwell times

dwell_times = [event.release_time - event.press_time for event in session]

# Calculate flight times

flight_times = []

for i in range(len(session) - 1):

flight_time = session[i+1].press_time - session[i].release_time

flight_times.append(flight_time)

# Normalize to handle different typing speeds

dwell_times = normalize_sequence(dwell_times)

flight_times = normalize_sequence(flight_times)

# Create fixed-length sequences

feature_vector = create_fixed_sequence(dwell_times, flight_times)

features.append(feature_vector)

return np.array(features)

Стратегия обучения моделей

Ключевым пониманием является рассматриваемое это как задачу обнаружения аномалий, а не как традиционную классификацию. Вы не пытаетесь распознать каждого возможного пользователя - вы пытаетесь распознать, когда кто -то не является аутентифицированным пользователем.

# Training approach

def train_keystroke_authenticator(user_data, imposter_data):

# Combine CNN and RNN model

model = build_hybrid_keystroke_model(sequence_length=100, num_features=4)

# Use focal loss to handle class imbalance

model.compile(

optimizer='adam',

loss='binary_focal_crossentropy', # Better for imbalanced data

metrics=['accuracy', 'precision', 'recall']

)

# Training with data augmentation

X_train, X_val, y_train, y_val = train_test_split(

features, labels, test_size=0.2, stratify=labels

)

# Use callbacks for adaptive training

callbacks = [

tf.keras.callbacks.EarlyStopping(patience=10),

tf.keras.callbacks.ReduceLROnPlateau(factor=0.5, patience=5),

tf.keras.callbacks.ModelCheckpoint('best_model.h5', save_best_only=True)

]

model.fit(X_train, y_train,

validation_data=(X_val, y_val),

epochs=100,

batch_size=32,

callbacks=callbacks)

return model

Развертывание и мониторинг

Вывод в реальном времени

В производстве система принимает непрерывные решения по аутентификации:

class KeystrokeAuthenticator:

def __init__(self, model_path, window_size=50):

self.model = tf.keras.models.load_model(model_path)

self.window_size = window_size

self.keystroke_buffer = []

self.confidence_threshold = 0.7

def process_keystroke(self, keystroke_event):

# Add to rolling buffer

self.keystroke_buffer.append(keystroke_event)

# Keep only recent keystrokes

if len(self.keystroke_buffer) > self.window_size:

self.keystroke_buffer.pop(0)

# Make prediction if we have enough data

if len(self.keystroke_buffer) >= self.window_size:

features = self.extract_features(self.keystroke_buffer)

confidence = self.model.predict(features.reshape(1, -1))[0][0]

if confidence < self.confidence_threshold:

return "AUTHENTICATION_FAILED"

else:

return "AUTHENTICATED"

return "INSUFFICIENT_DATA"

Адаптивные пороги

Статические пороги не работают хорошо для биометрии поведения. Пользователи изменяются, системы изменяются, а контекст имеет значение. Реализовать динамические пороги, которые адаптируются на основе:

- Недавние показатели успеха аутентификации

- Время дня и дня недели

- Контекст клавиатуры/устройства

- Отзывы пользователя (если доступны)

Запуск эксперимента

Запустите приведенные выше сценарии, следуя побуждениям к обычному типу для законного пользователя и по -разному для самозванца. Слои CNN извлекают пространственные особенности во время обучения, в то время как RNN обрабатывает височные последовательности во время тестирования, моделируя непрерывную аутентификацию. Модель выводит прогноз (подлинный или самозванец) с оценкой доверия.

Примечание: это упрощенный прототип. В производстве вам понадобится более крупный набор данных, надежная предварительная обработка и этические соображения, такие как согласие пользователя.

Реальные проблемы реализации

Сбор данных и конфиденциальность

Динамика клавиш требует непрерывного мониторинга пользовательского ввода, что вызывает значительные проблемы конфиденциальности. Вы, по сути, регистрируете все, что кто -то типа. Решение включает в себя:

- Обработка на грани: Необработанные данные на клавишном никогда не покидают машину пользователя

- Только извлечение функций: Хранить схемы синхронизации, а не фактические нажатия клавиш

- Дифференциальная конфиденциальность: Добавьте контролируемый шум для защиты индивидуальных схем печати

- Согласие пользователя и прозрачность: Четкое общение о том, что контролируется

Вариабельность обработки

Люди не печатают последовательно. Вы печатаете по -разному, когда устали, напрягаете, используете другую клавиатуру или даже сидите в другом положении. Успешные системы должны учитывать:

- Контекстуальная адаптация: Различные модели для разных сценариев (ноутбук против настольной клавиатуры, утренняя вечерняя набор)

- Непрерывное обучение: Модели, которые адаптируются к постепенным изменениям в типировании шаблонов

- Доверие забивание: Иногда лучше сказать «я не уверен», чем принять неправильное решение аутентификации

Требования к производительности

Непрерывная аутентификация должна быть:

- Быстрый: Занятие решений в субсекунде

- Ресурсный: Не может дать батарею или замедлить систему

- Точный: Низкие ложноположительные показатели (не блокируйте законных пользователей) и низкие ложные отрицательные показатели (не пропустите злоумышленников)

Заключение

Картирование клавиш для непрерывной аутентификации предлагает мощный, удобный подход к современной кибербезопасности. Используя уникальные закономерности в поведении на типинг, он обеспечивает бесшовную проверку идентификации в реальном времени, что подтверждается эмпирическими данными, показывающими низкие значения EER в кривых DET и ROC.

Гибридная реализация CNN-RNN демонстрирует, как продвинутое машинное обучение может улучшить эту технологию, при этом CNNS извлекает надежные функции во время обучения и моделирования RNNS для непрерывного тестирования. Благодаря этому упражнению вы получили практическое представление о создании сложной системы аутентификации, позиционируя вас для дальнейшего изучения или разработки инновационных приложений. По мере развития киберугрозов, освоение таких методов ставит вас на передний план цифровой безопасности. Для дальнейших запросов или для того, чтобы поделиться своими экспериментами, взаимодействовать с сообществом или проконсультироваться с дополнительными ресурсами.

Оригинал