Transic: Передача политики с рисованием в реальность путем обучения из онлайн-коррекции: связанная работа

4 июня 2025 г.Таблица ссылок

Аннотация и 1 введение

2 предварительные

3 Transic: передача политики с рисованием в реальность путем обучения на онлайн-коррекции и 3.1 базовые политики обучения в моделировании с RL

3.2 ОБУЧЕНИЯ ОТРИЦИЯ ПОЛИТИКИ ОТНОВЛЕНИЯ НАУКЦИИ

3.3 Интегрированная структура развертывания и 3,4 Подробности реализации

4 эксперименты

4.1 Настройки эксперимента

4.2 Количественное сравнение по четырем задачам сборки

4.3 Эффективность в решении различных разрывов с рисунком (Q4)

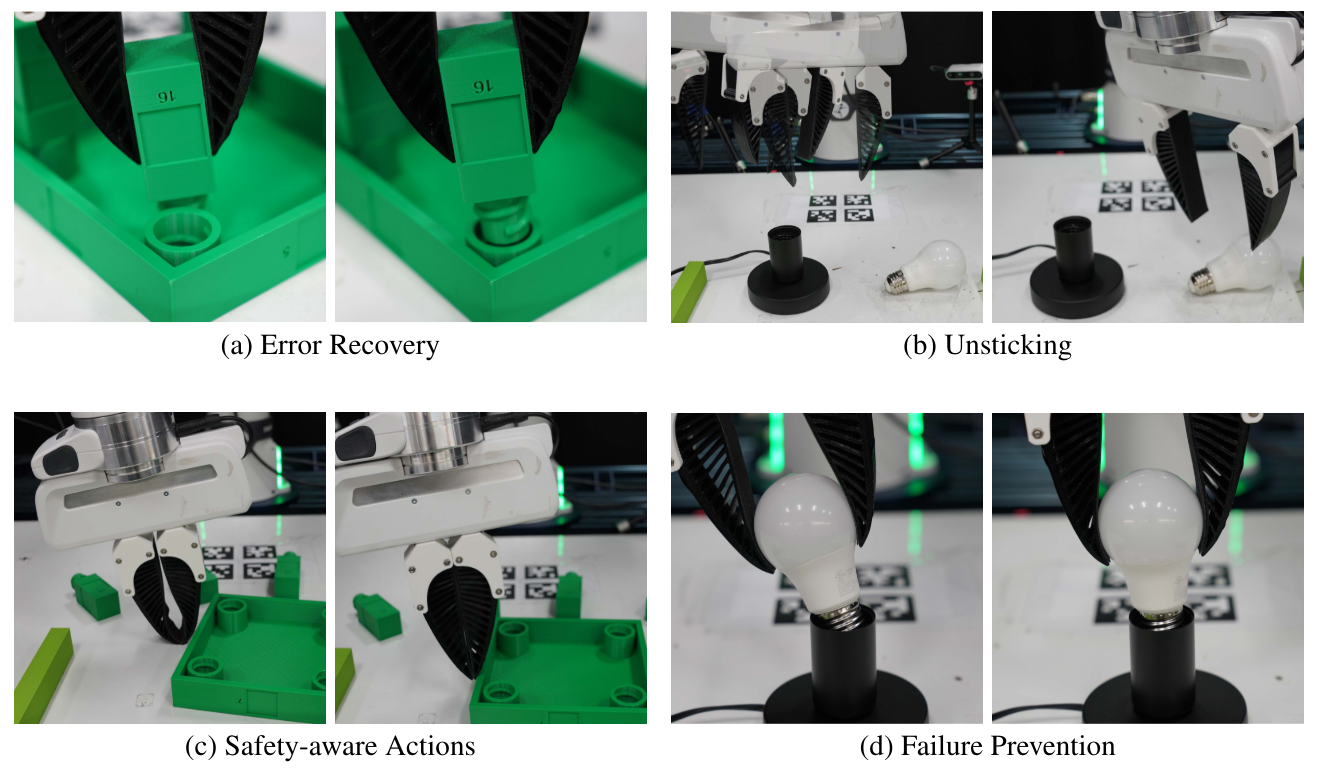

4.4 Масштабируемость с человеческими усилиями (Q5) и 4,5 интригующих свойств и возникающего поведения (Q6)

5 Связанная работа

6 Заключение и ограничения, подтверждения и ссылки

А. Подробная информация об обучении симуляции

Б. Реальные детали обучения в реальном мире

C. Настройки эксперимента и детали оценки

D. Дополнительные результаты эксперимента

5 Связанная работа

Обучение роботом с помощью передачи с рисованиемФизическое моделирование [7–11, 50, 93–95] стало движущей силой [1, 2] для развития роботизированных навыков в манипуляциях с настольным уровнем [96–99], подвижные манипуляции [100–103], жидкость и деформационные объектные манипуляции [104–107], декстера в манипуляции. [83], акробатический полет [29, 30] и т. Д. Однако разрыв домена между симуляторами и реальностью не является незначительным [11]. Успешная передача SIM-в реальность включает в себя локомоцию [19–28], переориентацию в руке для ловких рук, где объекты изначально расположены рядом с роботом [14–18], а неподчисые манипуляции ограничены простыми задачами [31–40]. В этой работе мы решаем более сложную передачу с рисунком для сложных задач манипуляции и успешно демонстрируем, что наш подход может решить сложные задачи манипуляции с богатыми контактами. Что еще более важно, это требует значительно меньше реальных

Данные о роботах по сравнению с распространенным имитационным обучением и офлайн -подходами RL [68, 69, 72]. Это делает решения, основанные на симуляторах и передаче с рисованием, более привлекательными для робототехников.

Пробелы в рисунке в задаче манипуляциисНесмотря на сложные навыки манипуляции, недавно изученные с RL в моделировании [109], непосредственно развертывая научную политику контроля для физических роботов часто терпит неудачу. Промежутки SIM-к реальности [11, 41, 45, 110], которые способствуют этому расхождению производительности, могут быть грубо классифицированы следующим образом: а) разрыв восприятия [19, 42–44], где синтетические сенсорные наблюдения отличаются от тех, которые измеряются в реальном мире; б) несоответствие воплощения [19, 45, 46], где модели роботов, используемые при симуляции, не соответствуют точному оборудованию в реальном мире; c) неточность контроллера [47–49], что означает, что результаты развертывания тех же команд высокого уровня (например, в пространстве конфигурации [111] и пространства задачи [112]) различаются по моделированию и реальному оборудованию; и г) плохой физический реализм [50], где физические взаимодействия, такие как контакт и столкновение, плохо смоделируются [113].

Хотя эти пробелы могут не быть полностью простыми, традиционные методы для их решения включают идентификацию системы [19, 31, 51, 52], рандомизация домена [14, 53–55], адаптация в реальном мире [56] и увеличение симулятора [58–60]. Тем не менее, идентификация системы в основном спроектирована на основе биказы. Рандомизация домена страдает от неспособности идентифицировать и рандомизировать все физические параметры. Методы с реальной адаптацией, как правило, посредством мета-обучения [114], несут потенциальные проблемы безопасности на этапе адаптации. Большинство из этих подходов также полагаются на явные и специфичные для домена знания о задачах и симуляторе априор. Например, для выполнения идентификации системы для закрытия зазора воплощения для четвероногих, Tan et al. [19] Разбирают физического робота и тщательно калибруют параметры, включая размер, массу и инерцию. Kim et al. [33] сообщают, что совместные роботы, такие как обычно используемый робот Франка Эмика, имеют сложное суставное трение, которое трудно идентифицировать и рандомизировать в типичных симуляторах физики. Чтобы сделать симулятор более сродни реальному миру, Chebotar et al. [40] развертывает обученные виртуальные роботы несколько раз для уточнения распределений параметров моделирования. Эта процедура не только вводит значительные усилия по отбору реальной жизни, но также вызывает потенциальные проблемы безопасности из-за развертывания субоптимальной политики. Напротив, наш метод использует данные вмешательства человека, чтобы неявно преодолеть проблему передачи, агрессию, а также приводит к более безопасному развертыванию.

![Figure 8: We demonstrate that individual skills learned with TRANSIC can be effectively chained together to enable long-horizon contact-rich manipulation. a) The robot assembles a lamp (160 seconds in 1× speed). b) The robot assembles a square table from FurnitureBench [90] (550 seconds in 1× speed). Videos are available on transic-robot.github.io.](https://cdn.hackernoon.com/images/fWZa4tUiBGemnqQfBGgCPf9594N2-1z934y4.png)

Обучение роботистам человека в петлеМашинное обучение человека в петле является распространенной основой для введения человеческих знаний в автономные системы [62, 115, 116]. Существуют различные формы обратной связи человека [63], от пассивного суждения, таких как предпочтение [117–126] и оценка [127–132], до активного участия, включая вмешательство [133–135] и коррекцию [136, 137]. Они широко приняты в решениях для последовательных задач принятия решений. Например, интерактивное имитационное обучение [66, 67, 70, 138] использует вмешательство и коррекцию человека, чтобы помочь имитаторам Na¨ıve решать несоответствие данных и ошибку составления. В контексте RL функции вознаграждения могут быть получены для лучшего выравнивания поведения агента с человеческими предпочтениями [120, 123, 124, 127]. Примечательно, что недавняя тенденция фокусируется на постоянном улучшении возможностей роботов путем итеративного обновления и развертывания политики с обратной связью с человеком [70], сочетая активное участие человека с RL [137] и автономно генерировать данные корректирующих вмешательства [139]. Наша работа дополнительно расширяет эту тенденцию, показывая, что промежутки с рисованием могут быть эффективно устранены с использованием вмешательства человека и сигналов коррекции

В общей автономии роботы и люди разделяют управляющий орган для достижения общей цели [64, 65, 140–142]. Эта контрольная парадигма в значительной степени изучалась в вспомогательной робототехнике и сотрудничестве человека-робот [143–145]. В этой работе мы предоставляем новую перспективу, используя ее для передачи политик контроля роботов с риботом и демонстрируя ее важность в достижении эффективной передачи.

6 Заключение и ограничения

В этой работе мы представляем Transic, целостный метод человека в петле для борьбы с передачей политик с рисованием для выполнения задач манипуляции с богатыми контактами. Мы показываем, что при переводе с рисунком хорошую базовую политику, полученную из моделирования, может быть объединена с ограниченными реальными данными для достижения успеха. Тем не менее, эффективно использование данных по коррекции человека для устранения разрыва в рисунке является сложной задачей, особенно когда мы хотим предотвратить катастрофическое забывание об базовой политике. Transic успешно решает эти проблемы, изучая закрытую остаточную политику из данных по коррекции человека. Мы показываем, что Transic эффективен в качестве целостного подхода для решения различных типов пробелов с рисованием в реальность, когда представлен одновременно; Это также эффективно в качестве подхода для решения индивидуальных пробелов очень разных природы. Он отображает привлекательные свойства, такие как масштабирование с человеческими усилиями.

Несмотря на то, что Transic достигает замечательных результатов переноса SIM-к реальности, он по-прежнему имеет несколько ограничений, которые следует учитывать последующими исследованиями. 1) Текущие задачи ограничены сценарием настольного настольного сценария с помощью мягкой параллельной челюсти. Тем не менее, мы замечаем, что с разработкой устройств телеоперации для более сложных роботов, таких как бимануальные руки [146], ловкие руки [147], мобильные манипуляторы [148, 149] и гуманоиды [150] также могут быть потенциально применены к этим условиям. 2) На этапе сбора данных коррекции оператор человека по -прежнему решает, когда вмешиваться. Это усилие может быть уменьшено за счет использования методов автоматического обнаружения разрушения [151, 152]. 3) Транцик требует политики моделирования с разумными выступлениями, в первую очередь, что трудно учиться само по себе. Тем не менее, Transic совместим с и может извлечь выгоду из последних достижений в этом направлении [6, 85, 153].

Благодарности

Мы благодарны Джозии Вонгу, Ченгшу (Эрик) Ли, Вейю Лю, Вэньлон Хуанг, Стивену Тянь, Санджана Шривастава и группы SVL за их полезными отзывами и проницательными дискуссиями. Эта работа частично поддерживается Стэнфордским институтом ИИ (HAI), Onr Muri N00014-22-1-2740, Onr Muri N00014-21-2801 и Schmidt Sciences. Руохан Чжан частично поддерживается стипендией Wu Tsai Alliance Human Performance.

Ссылки

[1] H. Choi, C. Crump, C. Duriez, A. Elmquist, G. Hager, D. Han, F. Hearle, J. Hodgins, A. Jain, F. Leve, C. Li, F. Meier, D. Negrut, L. Righetti, A. Rodriguez, J. Tan и J. Trinkle. При использовании симуляции в робототехнике: возможности, проблемы и предложения для продвижения вперед. Материалы Национальной академии наук, 118 (1): E1907856118, 2021. DOI: 10.1073/pnas.1907856118. URL https://www.pnas.org/doi/abs/10.1073/pnas. 1907856118.

[2] С. К. Лю и Д. Неграт. Роль физических симуляторов в робототехнике. Ежегодный обзор контроля, робототехники и автономных систем, 4 (1): 35–58, 2021. DOI: 10.1146/Annurev-Control-072220-093055. URL https://doi.org/10.1146/ annurev-control-072220-093055.

[3] П. Аббейль и А. Ю. Нг. Ученическое обучение с помощью обучения обратному подкреплению. В материалах Двадцать первой Международной конференции по машинному обучению, ICML ’04, стр. 1, Нью-Йорк, Нью-Йорк, США, 2004. ISBN 1581138385. DOI: 10.1145/1015330.1015430. URL https://doi.org/10.1145/ 1015330.1015430.

[4] H. D. III, J. Langford и D. Marcu. Структурированный прогноз на основе поиска. Arxiv Preprint arxiv: arxiv-0907.0786, 2009.

[5] S. Yang, O. Nachum, Y. Du, J. Wei, P. Abbeel и D. Schuurmans. Фонд модели для принятия решений: проблемы, методы и возможности. Arxiv Preprint arxiv: arxiv2303.04129, 2023.

[6] А. Мандлекар, С. Насириани, Б. Вэнь, И. Акинола, Ю. Наранг, Л. Фан, Ю. Чжу и Д. Фокс. Mimicgen: система генерации данных для масштабируемого обучения роботов с использованием человеческих демонстраций. Arxiv Preprint arxiv: arxiv-2310.17596, 2023.

[7] Э. Тодоров, Т. Эрез и Ю. Тасса. Mujoco: физический двигатель для модельного управления. 2012 IEEE/RSJ Международная конференция по интеллектуальным роботам и системам, страницы 5026–5033, 2012. DOI: 10.1109/iros.2012.6386109.

[8] Э. Куманс и Ю. Бай. Pybullet, модуль Python для физического моделирования для игр, робототехники и машинного обучения. http://pybullet.org, 2016–2021.

[9] Y. Zhu, J. Wong, A. Mandlekar, R. Mart´ın-Mart´ın, A. Joshi, S. Nasiriany и Y. Zhu. Robosuite: модульная структура моделирования и эталон для обучения роботам. Arxiv Preprint arxiv: arxiv-2009.12293, 2020.

[10] В. Маковийчук, Л. Ваврзиньак, Ю. Го, М. Лу, К. Стори, М. Маклин, Д. Холлер, Н. Рудин, А. Алшир, А. Ханда и Г. Штат. ISAAC GYM: высокопроизводительная физика на основе графических процессоров для обучения роботам. Arxiv Preprint arxiv: arxiv-2108.10470, 2021.

[11] C. Li, C. Gokmen, G. Levine, R. Mart´ın-Mart´ın, S. Srivastava, C. Wang, J. Wong, R. Zhang, M. Lingelbach, J. Sun, M. Anvari, M. Hwang, M. Sharma, A. Aydin, D. Bansal, S. Hunter, K.-Y. Ким, А. Лу, С. Р. Мэтьюз, И. Вилла-Рентерия, Дж. Х. Тан, С. Тан, Ф. Ся, С. Саварзе, Х. Гвеон, К. Лю, Дж. Ву и Л. Фей-Фей. Поведение-1K: эталон для воплощенного ИИ с 1000 повседневной деятельностью и реалистичным моделированием. В 6 -й ежегодной конференции по обучению роботам, 2022 год. URL https://openreview.net/forum?id=_8doie8g3t.

[12] A. Brohan, N. Brown, J. Carbajal, Y. Chebotar, J. Dabis, C. Finn, K. Gopalakrishnan, K. Hausman, A. Herzog, J. Hsu, J. Ibarz, B. Ichter, A. Irpan, T. Jackson, S. jesmonth, N. Joshi, R. Julian, D. Kalashnikv, I. Lealgan, I. Lealgov, I. hu. К.-Х. Lee, S. Levine, Y. Lu, U. Malla, D. Manjunath, I. Mordatch, O. Nachum, C. Parada, J. Peralta, E. Perez, K. Pertsch, J. Quiambao, K. Rao, M. Ryoo, G. Salazar, P. Sanketi, K. Sayed, J. Singh, S. Sontakke, A. Stamy, H. Tank, Vanke, Vanke, Ван. Vega, Q. Vuong, F. Xia, T. xiao, P. Xu, S. Xu, T. Yu и B. Zitkovich. RT-1: трансформатор робототехники для реального управления в масштабе. Arxiv Preprint arxiv: arxiv-2212.06817, 2022.

[13] К. Бусмалис, Г. Веццани, Д. Рао, С. Девин, А. Х. Ли, М. Бауза, Т. Дэвчев, Ю. Чжоу, А. Гупта, А. Раджу, А. Лорен, С. Фантакси, В. Далибард, М. Замбелли, М. Мартинс, Р. Певсевичи, М. Блокзи, М. Б., Н., Н., Н. Б., Н. Б., Н. Б., Н., Н. Б. E. Parisotto, K. Zołna, S. Reed, S.G. ˙ Colmenarejo, J. Scholz, A. Abdolmaleki, O. Groth, J.-B. Regli, O. Sushkov, T. Rothorl, J.E. ¨ Chen, Y. Aytar, D. Barker, J. Ortiz, M. Riedmiller, J. T. Springenberg, R. Hadsell, F. Nori и N. Heess. Robocat: самосовершенствовающийся генеральный агент для роботизированных манипуляций. Arxiv Preprint arxiv: arxiv-2306.11706, 2023.

[14] Openai, I. Akkaya, M. Andrychowicz, M. Chociej, M. Litwin, B. McGrew, A. Petron, A. Paino, M. Plappert, G. Powell, R. Ribas, J. Schneider, N. Tezak, J. Tworek, P. Welder, L. Weng, Q. Yuan, W. Zaremba и L. Zhang. Решение куба Рубика с рукой робота. Arxiv Preprint arxiv: arxiv-1910.07113, 2019.

[15] Т. Чен, М. Типпур, С. Ву, В. Кумар, Э. Адельсон и П. Агравал. Визуальная ловкость: переориентация в руке новых и сложных форм объекта. Science Robotics, 8 (84): EADC9244, 2023. DOI: 10.1126/scirobotics.adc9244. URL https://www.science.org/doi/abs/10.1126/ scirobotics.adc9244.

[16] Y. Chen, C. Wang, L. Fei-Fei и C.K. Liu. Последовательная ловкость: политика ловкости цепочки для манипуляции с длинным хоризоном. Arxiv Preprint arxiv: arxiv-2309.00987, 2023.

[17] H. Qi, A. Kumar, R. Calandra, Y. Ma и J. Malik. Вращение объекта с помощью быстрого адаптации моторной адаптации. Arxiv Preprint arxiv: arxiv-2210.04887, 2022.

[18] H. Qi, B. Yi, S. Suresh, M. Lambeta, Y. Ma, R. Calandra и J. Malik. Общее вращение объекта с зрением и прикосновением. Arxiv Preprint arxiv: arxiv-2309.09979, 2023.

[19] Дж. Тан, Т. Чжан, Э. Куманс, А. Искен, Ю. Бай, Д. Хафнер, С. Бохез и В. Ванхокке. SIM-BO-ELEAL: обучение Agile Locomotion для четвероногих роботов. Arxiv Preprint arxiv: arxiv1804.10332, 2018.

[20] А. Кумар, З. Фу, Д. Патхак и Дж. Малик. RMA: быстрая моторная адаптация для легких роботов. В D. A. Shell, M. Toussaint и M. A. Sieh, редакторы, робототехника: наука и системы XVII, виртуальное событие, 12-16 июля, 2021, 2021. Дои: 10.15607/rss.2021.xvii.011. URL https: //doi.org/10.15607/rss.2021.xvii.011.

[21] Z. Zhuang, Z. Fu, J. Wang, C. Atkeson, S. Schwertfeger, C. Finn и H. Zhao. Robot Parkour Learning. Arxiv Preprint arxiv: arxiv-2309.05665, 2023.

[22] Р. Ян, Г. Ян и Х. Ван. Нейронная объемная память для управления зрительным локомоусом. Arxiv Preprint arxiv: arxiv-2304.01201, 2023.

[23] Х. Бенбрагим и Дж. А. Франклин. Двуковочная динамическая ходьба с использованием подкрепления обучения. Робототехника и автономные системы, 22 (3): 283–302, 1997. ISSN 0921-8890. doi: https://doi.org/10.1016/S0921-8890(97)00043-2. URL https: //www.scienceDirect. com/science/article/pii/s0921889097000432. Обучение роботам: новая волна.

[24] Г. А. Кастильо, Б. Венг, В. Чжан и А. Здесь. Подкрепление, основанное на обучении каскадным движением, для надежного трехмерного двуночного локомоции. IEEE Access, 10: 20135–20148, 2022. DOI: 10.1109/Access.2022.3151771.

[25] Л. Кришна, Г. А. Кастильо, У. А. Мишра, А. Хрой и С. Колатхая. Линейная политика достаточно, чтобы реализовать надежную двуночную ходьбу по сложной территории. Arxiv Preprint arxiv: arxiv-2109.12665, 2021.

[26] J. Siekmann, K. Green, J. Warila, A. Fern и J. Hurst. Слепая двуночная лестница пересекается через обучение подкреплению с рисованием. Arxiv Preprint arxiv: arxiv-2105.08328, 2021.

[27] И. Радовавович, Т. Сяо, Б. Чжан, Т. Даррелл, Дж. Малик и К. Срейнатх. Реальное гуманоидное локомоция с обучением подкрепления. Arxiv Preprint arxiv: arxiv-2303.03381, 2023.

[28] Z. Li, X. B. Peng, P. Abbeel, S. Levine, G. Berseth и K. Sreenath. Подкрепление обучения для универсального, динамичного и надежного двухдостого контроля локомоции. Arxiv Preprint arxiv: arxiv2401.16889, 2024.

[29] Э. Кауфманн, Л. Бауэрсфельд, А. Локеерсио, М. Мюллер, В. Колтун и Д. Скарамуза. ¨ Ронковые гонки на уровне чемпиона с использованием глубокого обучения подкреплению. Nature, 2023. DOI: 10.1038/ S41586-023-06419-4. URL https://doi.org/10.1038/S41586-023-06419-4.

[30] Y. Song, A. Romero, M. Muller, V. Koltun и D. Scaramuzza. Достижение предела в Au-Tonomous Racing: оптимальный контроль по сравнению с обучением подкрепления. Science Robotics, 8 (82): EADG1462, 2023. DOI: 10.1126/scirobotics.adg1462. URL https://www.science.org/ doi/abs/10.1126/scirobotics.adg1462.

[31] В. Лим, Х. Хуан, Л. Ю. Чен, Дж. Ван, Дж. Ичновский, Д. Сейта, М. Ласки и К. Голдберг. Планарный робот кастинг с самоуверенным обучением REAL2SIM2REAL. Arxiv Preprint arxiv: arxiv2111.04814, 2021.

[32] В. Чжоу и Д. Холд. Учимся понимать невозмутимую с возникающей внешней ловкостью. В К. Лю, Д. Кулич и Дж. Ичновский, редакторы, Конференция по обучению роботов, Корл 2022, 14-18 декабря 2022 года, Окленд, Новая Зеландия, том 205 Служений исследований машинного обучения, страницы 150–160. PMLR, 2022. URL https://proceedings.mlr.press/v205/ Zhou23a.html.

[33] М. Ким, Дж. Хан, Дж. Ким и Б. Ким. До- и постконтактная политика разложение для нехватливых манипуляций с нулевым выстрелом передачи с рисунком в реальность. Arxiv Preprint arxiv: arxiv2309.02754, 2023.

[34] X. Чжан, С. Джейн, Б. Хуанг, М. Томизука и Д. Ромерс. Изучение обобщаемых навыков поворота. В Международной конференции IEEE по робототехнике и автоматизации, ICRA 2023, Лондон, Великобритания, 29 мая - 2 июня 2023 года, страницы 5865–5871. IEEE, 2023. DOI: 10.1109/ICRA48891.2023. 10161271. URL https://doi.org/10.1109/icra48891.2023.10161271.

[35] С. Козловский, Э. Ньюман и М. Заксенхаус. Подкрепление изучения политики импеданса для задач PEG-в отверстиях: роль асимметричных матриц. IEEE Robotics and Automation Letters, 7 (4): 10898–10905, 2022. doi: 10.1109/lra.2022.3191070.

[36] Д. Сон, Х. Ян и Д. Ли. Сим-реальность передача задач с затяжкой с жесткой устойчивостью. В 2020 году IEEE/RSJ Международная конференция по интеллектуальным роботам и системам (IROS), стр. 9056–9063, 2020. DOI: 10.1109/iros45743.2020.9341644.

[37] Б. Тан, М. А. Лин, И. Акинола, А. Ханда, Г. С. Сухатме, Ф. Рамос, Д. Фокс и Ю. С. Наранг. Промышленность: передача задач об сборе, богатых контактами, от моделирования в реальность. В К. Э. Бекрис, К. Хаузер, С. Л. Герберт и Дж. Ю, редакторы, Робототехника: Наука и Системы XIX, Дейгу, Республика Корея, 10-14 июля, 2023, 2023. DOI: 10.15607/rss.2023.xix.039. URL https://doi.org/10.15607/rss.2023.xix.039.

[38] X. Zhang, C. Wang, L. Sun, Z. Wu, X. Zhu и M. Tomizuka. Эффективная передача навыков манипуляций с богатыми контактами с симуляцией с остаточным обучением онлайн-допуска. На 7 -й ежегодной конференции по обучению роботам, 2023 год. URL https://openreview.net/forum?id= gfxvysxh48k.

[39] X. Чжан, М. Томизука и Х. Ли. Соединение разрыва с рисунком с помощью динамического настройки соответствия для промышленной вставки. Arxiv Preprint arxiv: arxiv-2311.07499, 2023.

[40] Y. Chebotar, A. Handa, V. Makoviychuk, M. Macklin, J. Issac, N. Ratliff и D. Fox. Закрытие петли с рисунком: адаптирование рандомизации симуляции с помощью реального опыта. Arxiv Preprint arxiv: arxiv-1810.05687, 2018.

[41] Н. Якоби, П. Мужья и И. Харви. Шум и разрыв в реальности: использование симуляции в эволюционной робототехнике. В F. Moran, A. Moreno, J. J. Merelo и P. chac ´ On, Editors, «Достижения в области искусственной жизни», стр. 704–720, Берлин, Гейдельберг, 1995. Springer Berlin Heidelberg. ISBN 978-3-540-49286-3.

[42] Э. Ценг, С. Девин, Дж. Хоффман, С. Финн, X. Пенг, С. Левин, К. Саенко и Т. Даррелл. К адаптации глубоких визуальных представлений от моделируемых к реальным средам. Arxiv, abs/1511.07111, 2015. URL https://api.semanticscholar.org/corpusid:1541419.

[43] К. Бусмалис, А. Ирпан, П. Волхарт, Ю. Бай, М. Келси, М. Калакришнан, Л. Даунс, Дж. Ибарц, П. Пастор, К. Конолиге, С. Левин и В. Ванхоуке. Использование моделирования и адаптации доменов для повышения эффективности глубокого роботизированного схватки. Arxiv Preprint arxiv: arxiv-1709.07857, 2017.

[44] Д. Хо, К. Рао, З. Сюй, Э. Джанг, М. Хансари и Ю. Бай. Retinagan: объектный подход к передаче с рисунком в рисунку. Arxiv Preprint arxiv: arxiv-2011.03148, 2020.

[45] S. Koos, J.-B. Море и С. Донси. Скрещивание разрыва в реальности в эволюционной робототехнике путем продвижения передаваемых контроллеров. В материалах 12 -й ежегодной конференции по генетическим и эволюционным вычислениям, Gecco ’10, стр. 119–126, Нью -Йорк, Нью -Йорк, США, 2010. ISBN 9781450300728. DOI: 10.1145/1830483. 1830505. URL https://doi.org/10.1145/1830483.1830505.

[46] Z. Xie, G. Berseth, P. Clary, J. Hurst и M. van de Panne. Контроль обратной связи для Кэсси с глубоким обучением подкрепления. Arxiv Preprint arxiv: arxiv-1803.05580, 2018.

[47] R. Mart´ın-Mart´ın, M.A. Lee, R. Gardner, S. Savarese, J. Bohg и A. Garg. Управление импедансом переменного сопротивления в пространстве конечных эффектов: пространство действий для обучения подкреплению в задачах, богатых контактами. ARXIV PREPRINT ARXIV: ARXIV-1906.08880, 2019. [48] Дж. Вонг, В. Маковийчук, А. Анандкумар и Ю. Чжу. Оскар: управление эксплуатационным пространством, управляемым данными для адаптивных и надежных манипуляций с роботами. Arxiv Preprint arxiv: arxiv-2110.00704, 2021.

[49] Э. Альджалбуут, Ф. Франк, М. Карл и П. Ван дер Смагт. О роли действия в области манипуляции с роботами и переноса с рисованием. Arxiv Preprint arxiv: arxiv-2312.03673, 2023.

[50] Y. S. Narang, K. Story, I. Akinola, M. Macklin, P. Reist, L. Wawrzyniak, Y. Guo, A. Morav 'Anszky, G. State, M. Lu, A. Handa и D. Fox. Фабрика: быстрый контакт для роботизированной сборки. В K. Hauser, D.A. Shell и S. Huang, редакторы, Робототехника: Science and Systems XVIII, Нью -Йорк, Нью -Йорк, США, 27 июня - 1 июля 2022 года. 035. URL https://doi.org/10.15607/rss.2022.xviii.035.

[51] L. Ljung. Идентификация системы, страницы 163–173. Birkhauser Boston, Boston, MA, 1998. ¨ ISBN 978-1-4612-1768-8. doi: 10.1007/978-1-4612-1768-8 11. URL https://doi.org/ 10.1007/978-1-4612-1768-8_11.

[52] П. Чанг и Т. Падир. SIM2Real2sim: преодоление разрыва между симуляцией и реальным миром в гибких манипуляциях с объектами. Arxiv Preprint arxiv: arxiv-2002.02538, 2020.

[53] X. B. Peng, M. Andrychowicz, W. Zaremba и P. Abbeel. Сим-в реальность передача роботизированного управления с рандомизацией динамики. Arxiv Preprint arxiv: arxiv-1710.06537, 2017.

[54] А. Ханда, А. Алшир, В. Маковийчук, А. Петренко, Р. Сингх, Дж. Лю, Д. Маковичук, К. В. Вик, А. Чхуркевич, Б. Сундаралингам и Ю. С. Наранг. Dextreme: передача гибких манипуляций с симуляцией в реальность. В Международной конференции IEEE по робототехнике и автоматизации, ICRA 2023, Лондон, Великобритания, 29 мая - 2 июня 2023 года, стр. URL https://doi.org/10. 1109/ICRA48891.2023.10160216.

[55] Дж. Ванг, Ю. Цинь, К. Куанг, Ю. Коркмаз, А. Гурумурти, Х. Су и Х. Ван. CyberDemo: увеличение моделируемой человеческой демонстрации для реальной ловкой манипуляции. Arxiv Preprint arxiv: arxiv-2402.14795, 2024.

[56] G. Schoettler, A. Nair, J.A. Ojea, S. Levine и E. Solowjow. Мета-прикрепление обучения для задач роботизированной промышленной вставки. Arxiv Preprint arxiv: arxiv-2004.14404, 2020.

[57] Y. Zhang, L. Ke, A. Deshpande, A. Gupta и S. Srinivasa. Вишня с подкреплением обучения. В «Труды робототехники: наука и системы», Дейгу, Республика Корея, июль 2023 г. DOI: 10.15607/rss.2023.xix.021.

[58] Y. Chebotar, A. Handa, V. Makoviychuk, M. Macklin, J. Issac, N. D. Ratliff и D. Fox. Закрытие петли с рисунком: адаптирование рандомизации симуляции с помощью реального опыта. На Международной конференции по робототехнике и автоматизации, ICRA 2019, Монреаль, качества, Канада, 20-24 мая 2019 года, страницы 8973–8979. IEEE, 2019. DOI: 10.1109/ICRA.2019.8793789. URL https://doi.org/10.1109/icra.2019.8793789.

[59] Дж. П. Ханна и П. Стоун. Заземленное действие трансформация для обучения роботов при симуляции. В материалах Тридцать первой конференции AAAI по искусственному интеллекту, AAAI'17, стр. 4931–4932. AAAI Press, 2017.

[60] Э. Хайден, Д. Миллард, Э. Куманс и Г. С. Сухатме. Увеличение дифференцируемых симуляторов нейронными сетями, чтобы закрыть разрыв SIM2Real. Arxiv Preprint arxiv: arxiv-2007.06045, 2020.

[61] С. А. Круз и Т. Игараши. Опрос по интерактивному обучению подкрепления: принципы проектирования и открытые проблемы. Arxiv Preprint arxiv: arxiv-2105.12949, 2021.

[62] Y. Cui, P. Koppol, H. Admoni, S. Niekum, R. Simmons, A. Steinfeld и T. Fitzgerald. Понимание взаимосвязи между взаимодействиями и результатами в машинном обучении человека. В Z.-H. Чжоу, редактор, Труды Тридцатой Международной совместной конференции по искусственному интеллекту, IJCAI-21, стр. 4382–4391. Международные совместные конференции по организации искусственного интеллекта, 8 2021. doi: 10.24963/ijcai.2021/599. URL https://doi.org/10.24963/ijcai.2021/599. Трек Обследования.

[63] Р. Чжан, Ф. Тораби, Л. Гуан, Д. Х. Баллард и П. Стоун. Использование человеческого руководства для задач обучения в глубоком подкреплении. ARXIV PREPRINT ARXIV: ARXIV-1909.09906, 2019.

[64] С. Джавдани, С. С. Сриниваса и Дж. А. Багнелл. Общая автономия через оптимизацию задним числом. Arxiv Preprint arxiv: arxiv-1503.07619, 2015.

[65] С. Редди, А. Д. Драган и С. Левин. Общая автономия с помощью глубокого подкрепления обучения. Arxiv Preprint arxiv: arxiv-1802.01744, 2018.

[66] М. Келли, С. Сидрейн, К. Дриггс-Кампбелл и М. Дж. Кохендерфер. HG-Dagger: интерактивное имитационное обучение с экспертами. Arxiv Preprint arxiv: arxiv-1810.02890, 2018.

[67] А. Мандлекар, Д. Сюй, Р. Март-Март-Мартан, Ю. Чжу, Л. Фей-Феи и С. Саварзе. Обучение имитации человека в Theloop с использованием удаленной телеоперации. Arxiv Preprint arxiv: arxiv-2012.06733, 2020.

[68] А. Мандлекар, Д. Сюй, Дж. Вонг, С. Насирия, С. Ван, Р. Кулкарни, Л. Фей-Фей, С. Саварзе, Ю. Чжу и Р. Март-Март-Март. Что имеет значение для обучения в автономных человеческих демонстрациях для манипуляции с роботами. Arxiv Preprint arxiv: arxiv-2108.03298, 2021.

[69] И. Костроков, А. Наир и С. Левин. Обучение в автономном режиме с неявным Q-обучением. Arxiv Preprint arxiv: arxiv-2110.06169, 2021.

[70] H. Liu, S. Nasiriany, L. Zhang, Z. Bao и Y. Zhu. Обучение роботам на работе: автономия и обучение человека во время развертывания. Arxiv Preprint arxiv: arxiv-2211.08416, 2022.

[71] A. Abdolmaleki, J. T. Springenberg, Y. Tassa, R. Munos, N. Heess и M. Riedmiller. Максимум оптимизация политики задней политики. ARXIV PREPRINT ARXIV: ARXIV-1806.06920, 2018.

[72] Д. А. Померло. Элвинн: автономный наземный автомобиль в нейронной сети. В D. Touretzky, редактор, Достижения в области систем обработки нейронной информации, том 1. Morgan-kaufmann, 1988. URL https://proceedings.neurips.cc/paper_files/paper/1988/file/ 812b4ba287f5e0bc9d43bbf5bbe87f.ppapbb.pdf.

[73] Y. Zhu, Z. Wang, J. Merel, A. Rusu, T. Erez, S. Cabi, S. tunyasuvunakool, J. Kramar, R. Had- `sell, N. de Freitas и N. Heess. Подкрепление и имитационное обучение для различных визуальных навыков. Arxiv Preprint arxiv: arxiv-1802.09564, 2018.

[74] А. Си, Л. Ли, Т. Сяо и С. Финн. Разложение разрыва в обобщении в имитационном обучении для визуальных роботизированных манипуляций. Arxiv Preprint arxiv: arxiv-2307.03659, 2023.

[75] Ю. Цинь, Б. Хуанг, З.-Х. Инь, Х. Су и Х. Ван. DEXPOINT: Обобщаемая точечная облако обучение подкреплению для подкрепления для симуляции для ловких манипуляций с рисунком. Arxiv Preprint arxiv: arxiv2211.09423, 2022.

[76] О. Хатиб. Единый подход к управлению движением и силой манипуляторов роботов: формулировка эксплуатационного пространства. Журнал IEEE по робототехнике и автоматизации, 3 (1): 43–53, 1987. DOI: 10.1109/JRA.1987.1087068.

[77] Дж. Наканиши, Р. Кори, М. Мисти, Дж. Петерс и С. Шаал. Оперативное управление пространством: теоретическое и эмпирическое сравнение. Международный журнал исследований робототехники, 27 (6): 737–757, 2008. DOI: 10.1177/0278364908091463. URL https://doi.org/10.1177/ 0278364908091463.

[78] A. A. Rusu, S.G. Colmenarejo, C. Gulcehre, G. Desjardins, J. Kirkpatrick, R. Pascanu, V. Mnih, K. Kavukcuoglu и R. Hadsell. Политическая дистилляция. Arxiv Preprint arxiv: arxiv1511.06295, 2015.

[79] Т. Чен, М. Типпур, С. Ву, В. Кумар, Э. Адельсон и П. Агравал. Визуальная ловкость: ловкие манипуляции с глубиной. Arxiv Preprint arxiv: arxiv-2211.11744, 2022.

[80] Т. Чен, Дж. Сюй и П. Агравал. Система для общей переориентации объекта. В A. Faust, D. Hsu и G. Neumann, редакторы, Конференция по обучению роботов, 8-11 ноября 2021 года, Лондон, Великобритания, Том 164 Служений исследований машинного обучения, страницы 297–307. PMLR, 2021.

[81] T. Johannink, S. Bahl, A. Nair, J. Luo, A. Kumar, M. Loskyll, J. A. Ojea, E. Solowjow и S. Levine. Остаточное обучение подкрепления для контроля роботов. Arxiv Preprint arxiv: arxiv1812.03201, 2018.

[82] Т. Сильвер, К. Аллен, Дж. Тененбаум и Л. Кэльбблинг. Официальное обучение политики. Arxiv Preprint arxiv: arxiv-1812.06298, 2018.

[83] А. Зенг, С. Сонг, Дж. Ли, А. Родригес и Т. Функхаузер. Tossingbot: научиться бросать произвольные объекты с остаточной физикой. Arxiv Preprint arxiv: arxiv-1903.11239, 2019.

[84] J. Schulman, F. Wolski, P. Dhariwal, A. Radford и O. Klimov. Алгоритмы оптимизации проксимальной политики. ARXIV PREPRINT ARXIV: ARXIV-1707.06347, 2017.

[85] C. Chi, S. Feng, Y. Du, Z. Xu, E. Cousineau, B. Burchfiel и S. Song. Политика диффузии: визуально -политическое обучение посредством распространения действий. В К. Э. Бекрис, К. Хаузер, С. Л. Герберт и Дж. Ю, редакторы, робототехника: наука и системы XIX, Дейгу, Республика Корея, 10-14 июля, 2023, 2023. DOI: 10.15607/rss.2023.xix.026. URL https://doi.org/10.15607/rss. 2023.xix.026.

[86] С. Р. Ци, Х. Су, К. Мо и Л. Дж. Гибас. PointNet: глубокое обучение на наборах точек для 3D -классификации и сегментации. Arxiv Preprint arxiv: arxiv-1612.00593, 2016.

[87] A. Jaegle, F. Gimeno, A. Brock, A. Zisserman, O. Vinyanals и J. Carreira. Восприятие: общее восприятие с итеративным вниманием. Arxiv Preprint arxiv: arxiv-2103.03206, 2021.

[88] Дж. Ли, Ю. Ли, Дж. Ким, А. Р. Косиорек, С. Чой и Ю. В. Тех. SET Transformer: основа для нейронных сетей, основанных на перзаскате, основанных на внимании. Arxiv Preprint arxiv: arxiv1810.00825, 2018.

[89] И. Лошчилов и Ф. Хаттер. SGDR: Стохастический градиент спуск с теплыми перезапусками. ARXIV PREPRINT ARXIV: ARXIV-1608.03983, 2016.

[90] М. Хео, Ю. Ли, Д. Ли и Дж. Дж. Лим. Furniturebench: воспроизводимый реальный эталон для манипуляции с длинными горы. В К. Э. Бекрик, К. Хаузер, С. Л. Герберт и Дж. Ю, редакторы, Робототехника: Наука и Системы XIX, Дейгу, Республика Корея, 10-14 июля, 2023, 2023. DOI: 10.15607/rss.2023.xix.041. URL https://doi.org/10.15607/rss.2023. XIX.041.

[91] А. Фишман, А. Мурали, С. Эппнер, Б. Пил, Б. Сапоги и Д. Фокс. Сети политики движения. В К. Лю, Д. Кулич и Дж. Ичновский, редакторы, Конференция по обучению роботов, Корл 2022, 14-18 декабря 2022 года, Окленд, Новая Зеландия, том 205 «Слушания исследований машинного обучения», страницы 967–977. PMLR, 2022. URL https://proceedings.mlr.press/v205/ Fishman23a.html.

[92] Р. Хоке, А. Балакришна, Э. Новоселлер, А. Уилкокс, Д. С. Браун и К. Голдберг. THRIFTYDAGGER: новизна, с учетом бюджета и риски для интерактивного имитационного обучения. Arxiv Preprint arxiv: arxiv-2109.08273, 2021.

[93] Р. Тедрак и команда разработчиков Дрейка. Drake: модельный дизайн и проверка для робототехники, 2019. URL https://drake.mit.edu.

[94] F. Xiang, Y. Qin, K. Mo, Y. Xia, H. Zhu, F. Liu, M. Liu, H. Jiang, Y. Yuan, H. Wang, L. Yi, A. X. Chang, L. J. Guibas и H. Su. Sapien: моделируемая интерактивная среда на основе деталей. Arxiv Preprint arxiv: arxiv-2003.08515, 2020.

[95] М. Миттал, С. Ю, К. Ю, Дж. Лю, Н. Рудин, Д. Холлер, Дж. Л. Юань, П. П. Тегерани, Р. Сингх, Ю. Го, Х. Мажар, А. Мандлекар, Б. Бабич, Г. Стейт, М. Хаттер и А. Гарг. Орбита: унифицированная структура моделирования для интерактивных среды обучения роботов. Arxiv Preprint arxiv: arxiv-2301.04195, 2023.

[96] A. Zeng, P. Florence, J. Tompson, S. Welker, J. Chien, M. Attarin, T. Armstrong, I. Krasin, D. Duong, A. Wahid, V. Sindhwani и J. Lee. Сети Transporter: перестройка визуального мира для роботизированных манипуляций. Arxiv Preprint arxiv: arxiv-2010.14406, 2020.

[97] М. Шридхар, Л. Мануэлли и Д. Фокс. Cliport: Что и где пути к роботизированным манипуляциям. Arxiv Preprint arxiv: arxiv-2109.12098, 2021.

[98] Y. Jiang, A. Gupta, Z. Zhang, G. Wang, Y. Dou, Y. Chen, L. Fei-Fei, A. Anandkumar, Y. Zhu и L. Fan. VIMA: общие манипуляции с роботом с помощью мультимодальных подсказок. Arxiv Preprint arxiv: arxiv-2210.03094, 2022.

[99] М. Шридхар, Л. Мануэлли и Д. Фокс. Восприятие-актер: многозадачный трансформатор для роботизированных манипуляций. Arxiv Preprint arxiv: arxiv-2209.05451, 2022.

[100] D. Batra, A. X. Chang, S. Chernova, A.J. Davison, J. Deng, V. Koltun, S. Levine, J. Malik, I. Mordatch, R. Mottaghi, M. Savva и H. Su. Перестановление: вызов воплощенного ИИ. Arxiv Preprint arxiv: arxiv-2011.01975, 2020.

[101] J. Gu, D. S. Chaplot, H. Su и J. Malik. Мобильные манипуляции с несколькими навыками для перестройки объекта. Arxiv Preprint arxiv: arxiv-2209.02778, 2022.

[102] С. Йенамандра, А. Рамачандран, К. Ядав, А. Ван, М. Ханна, Т. Гервер, Т.-Е. Ян, В. Джейн, А. У. Клегг, Дж. Тернер, З. Кира, М. Савва, А. Чанг, Д. С. Чапри, Д. Батра, Р. Моттаги, Ю. Биск и С. Пакстон. HOMEROBOT: Мобильные манипуляции с открытым вокабуляцией. Arxiv Preprint arxiv: arxiv-2306.11565, 2023.

[103] К. Эхсани, Т. Гупта, Р. Хендрикс, Дж. Сальвадор, Л. Вейхс, К.-Х. Зенг, К. П. Сингх, Ю. Ким, В. Хан, А. Эррасти, Р. Кришна, Д. Швенк, Э. Вандербильт и А. Кембхави. Имитация самых коротких путей в моделировании позволяет эффективно навигации и манипуляции в реальном мире. Arxiv Preprint arxiv: arxiv-2312.02976, 2023.

[104] Y. Wu, W. Yan, T. Kurutach, L. Pinto и P. Abbeel. Учиться манипулировать деформируемыми объектами без демонстраций. Arxiv Preprint arxiv: arxiv-1910.13439, 2019.

[105] Х. Ха и С. Сонг. Flingbot: необоснованная эффективность динамических манипуляций для разворачивания ткани. Arxiv Preprint arxiv: arxiv-2105.03655, 2021.

[106] D. Seita, Y. Wang, S.J. Shetty, E. Y. Li, Z. Erickson и D. Hold. Toolflownet: роботизированные манипуляции с инструментами посредством прогнозирования потока инструментов из точечных облаков. Arxiv Preprint arxiv: arxiv-2211.09006, 2022.

[107] X. Lin, Z. Huang, Y. Li, J. B. Tenenbaum, D. Held и C. Gan. Diffskill: абстракция навыков от дифференцируемой физики для деформируемых манипуляций с объектами с помощью инструментов. Arxiv Preprint arxiv: arxiv-2203.17275, 2022.

[108] Y. Ji, Z. Li, Y. Sun, X. B. Peng, S. Levine, G. Berseth и K. Sreenath. Иерархическое обучение подкреплению для точных навыков стрельбы в футболе с использованием четвероночного робота. Arxiv Preprint arxiv: arxiv-2208.01160, 2022.

[109] Y. J. Ma, W. Liang, G. Wang, D.-A. Huang, O. Bastani, D. Jayaraman, Y. Zhu, L. Fan и A. Anandkumar. Eureka: дизайн вознаграждения на уровне человека через кодируя большие языковые модели. Arxiv Preprint arxiv: arxiv-2310.12931, 2023.

[110] А. Боинг и Т. Браунл. Использование нескольких симуляторов для пересечения разрыва в реальности. В ¨ 2012 12 -я Международная конференция по управлению Automation Robotics & Vision (ICARCV), стр. 1113–1119, 2012. DOI: 10.1109/icarcv.2012.6485313.

[111] J. Hwangbo, J. Lee, A. Dosovitskiy, D. Bellicoso, V. Tsounis, V. Koltun и M. Hutter. Изучение гибких и динамических моторных навыков для ногайных роботов. Science Robotics, 4 (26): EAAU5872, 2019. DOI: 10.1126/scirobotics.aau5872. URL https://www.science.org/doi/abs/10. 1126/scirobotics.aau5872.

[112] J. Luo, E. Solowjow, C. Wen, J.A. Ojea, A.M. Agogino, A. Tamar и P. Abbeel. Подкрепление обучения на контроллере с переменным импедансом для высокой роботизированной сборки. На Международной конференции по робототехнике и автоматизации, ICRA 2019, Монреаль, качества, Канада, 20-24 мая 2019 года, страницы 3080–3087. IEEE, 2019. DOI: 10.1109/ICRA.2019.8793506. URL https://doi.org/10.1109/icra.2019.8793506.

[113] П. С. Хорак и Дж. С. Тринкл. О сходстве и различиях между контактными моделями в моделировании роботов. IEEE Robotics and Automation Letters, 4 (2): 493–499, 2019. DOI: 10.1109/ LRA.2019.2891085.

[114] C. Finn, P. Abbeel и S. Levine. Модель-агрессивный мета-обучение для быстрой адаптации глубоких сетей. ARXIV PREPRINT ARXIV: ARXIV-1703.03400, 2017.

[115] Дж. А. Неисправность и Д. Р. Олсен. Интерактивное машинное обучение. В материалах 8 -й Международной конференции по интеллектуальным пользовательским интерфейсам, IUI ’03, стр. 39–45, Нью -Йорк, Нью -Йорк, США, 2003. Ассоциация по вычислительной технике. ISBN 1581135866. DOI: 10.1145/604045. 604056. URL https://doi.org/10.1145/604045.604056.

[116] S. Amershi, M. Cakmak, W. B. Knox и T. Kulesza. Сила для людей: роль людей в интерактивном машинном обучении. Журнал AI, 35 (4): 105–120, декабрь 2014 г. DOI: 10.1609/aimag.v35i4.2513. URL https://ojs.aaai.org/aimagazine/index.php/ aimagazine/article/view/2513.

[117] Y. Yue, J. Broder, R. Kleinberg и T. Joachims. K-Armed Dueling Bandits Проблема. Журнал компьютерных и системных наук, 78 (5): 1538–1556, 2012. ISSN 0022-0000. doi: https: //doi.org/10.1016/j.jcss.2011.12.028. URL https://www.sciendirect.com/ science/article/pii/s0022000012000281. Специальный выпуск JCSS: Cloud Computing 2011.

[118] А. Джайн, Б. Войчик, Т. Йоахимс и А. Саксена. Учебные предпочтения для манипуляторов посредством итеративного улучшения. Arxiv Preprint arxiv: arxiv-1306.6294, 2013.

[119] P. Christiano, J. Leike, T. B. Brown, M. Martic, S. Legg и D. Amodei. Глубокое подкрепление обучения от человеческих предпочтений. Arxiv Preprint arxiv: arxiv-1706.03741, 2017.

[120] Э. Бийкик, Д. П. Лоси, М. Палан, Н. С. Ландольфи, Г. Шевчук и Д. Садиг. Вознаграждение за обучение функционирует из разнообразных источников обратной связи человека: оптимальная интеграция демонстраций и предпочтений. Arxiv Preprint arxiv: arxiv-2006.14091, 2020.

[121] К. Ли, Л. Смит и П. Аббейл. Pebble: Эффективное интерактивное обучение подкрепления с обратной связью посредством опыта в отношении перераспределения и неконтролируемого предварительного обучения. Arxiv Preprint arxiv: arxiv2106.05091, 2021.

[122] X. Wang, K. Lee, K. Hakhamaneshi, P. Abbeel и M. Laskin. Настройки навыков: научиться извлекать и выполнять роботизированные навыки из отзывов человека. Arxiv Preprint arxiv: arxiv2108.05382, 2021.

[123] L. Ouyang, J. Wu, X. Jiang, D. Almeida, C.L. Wainwright, P. Mishkin, C. Zhang, S. Agarwal, K. Slama, A. Ray, J. Schulman, J. Hilton, F. Kelton, L. Miller, M. Simens, A. Askell, P. leleder, P. Christiano, J. Leike и R. Lowe. Обучающие языковые модели, чтобы следовать инструкциям с отзывом человека. Arxiv Preprint arxiv: arxiv-2203.02155, 2022.

[124] В. Майерс, Э. Бийык и Д. Садиг. Активное вознаграждение от онлайн -предпочтений. Arxiv Preprint arxiv: arxiv-2302.13507, 2023.

[125] R. Rafailov, A. Sharma, E. Mitchell, S. Ermon, C. D. Manning, and C. Finn. Direct preference optimization: Your language model is secretly a reward model. arXiv preprint arXiv: Arxiv2305.18290, 2023.

[126] J. Hejna, R. Rafailov, H. Sikchi, C. Finn, S. Niekum, W. B. Knox и D. Sadigh. Контрастные предпочтения Обучение: учиться на отзывах человека без RL. Arxiv Preprint arxiv: arxiv2310.13639, 2023.

[127] В. Б. Нокс и П. Стоун. Подкрепление обучения на вознаграждении человека: дисконтирование в эпизодических задачах. В 2012 году IEEE RO-MAN: 21-й Международный симпозиум IEEE по интерактивному общению робота и человека, страницы 878–885, 2012. DOI: 10.1109/Roman.2012. 6343862.

[128] Б. Д. Аргалл, Э. Л. Саузер и А. Г. Биллард. Тактильное руководство для уточнения и повторного использования политики. В 2010 году 9 -я Международная конференция по развитию и обучению IEEE, страницы 7–12, 2010. DOI: 10.1109/devlrn.2010.5578872.

[129] Т. Фицджеральд, Э. Шорт, А. Гоэль и А. Томаз. Адаптация траектории под руководством человека для передачи инструментов. В материалах 18 -й Международной конференции по автономным агентам и многоагентным системам, Aamas ’19, стр. 1350–1358, Ричленд, Южная Каролина, 2019. Международный фонд автономных агентов и многоагентных систем. ISBN 9781450363099.

[130] А. В. Баджси, Д. П. Лоси, М. К. О'Мэлли и А. Д. Драган. Изучение целей робота от физического человеческого взаимодействия. В конференции по обучению роботам, 2017. URL https: //api.semanticscholar.org/corpusid:28406224.

[131] A. Najar, O. Sigaud, and M. Chetouani. Interactively shaping robot behaviour with unlabeled human instructions. arXiv preprint arXiv: Arxiv-1902.01670, 2019.

[132] Н. Уайльд, Э. Бийык, Д. Садиг и С. Л. Смит. Учебное пособие функционирует от обратной связи по масштабе. Arxiv Preprint arxiv: arxiv-2110.00284, 2021.

[133] Дж. Чжан и К. Чо. Запрос эффективного имитационного обучения для сквозного автономного вождения. Arxiv Preprint arxiv: arxiv-1605.06450, 2016.

[134] У. Сондерс, Г. Састри, А. Стулмуллер и О. Эванс. Пробная версия без ошибки: к безопасному обучению подкрепления посредством вмешательства человека. Arxiv Preprint arxiv: arxiv-1707.05173, 2017.

[135] Z. Wang, X. Xiao, B. Liu, G. Warnell и P. Stone. Appli: адаптивное планирование, обучение параметрам от вмешательств. Arxiv Preprint arxiv: arxiv-2011.00400, 2020.

[136] C. Celemin и J. R. Del Solar. Интерактивная структура для обучения политике непрерывных действий на основе корректирующей обратной связи. Журнал интеллектуальных и роботизированных систем, 95: 77–97, 2018. DOI: 10.1007/S10846-018-0839-Z. URL http://link.springer.com/article/ 10.1007/s10846-018-0839-z/fulltext.html.

[137] Z. Peng, W. Mo, C. Duan, Q. Li и B. Zhou. Обучение у активного участия человека посредством распространения ценности прокси. В Тридцать седьмой конференции по системам обработки нейронной информации, 2023. URL https://openreview.net/forum?id=q8sukwaeby.

[138] C. Celemin, R. Perez-Dattari, E. Chisari, G. Franzese, L. de Souza Rosa, R. Prakash, 'Z. Ajanovic, M. Ferraz, A. Valada и J. Kober. Интерактивное имитационное обучение в робототехнике: опрос. Arxiv Preprint arxiv: arxiv-2211.00600, 2022.

[139] Р. Хоке, А. Мандлекар, К. Р. Гаррет, К. Голдберг и Д. Фокс. Интервенционное генерация данных для надежного и эффективного обучения роботов. В первом семинаре по обобщению за пределами робототехники в Corl 2023, 2023. URL https: // openReview. net/forum? id = ckfrooaa3n.

[140] Дж. Крэндалл и М. Гудрич. Характеристика эффективности взаимодействия роботов человека: тематическое исследование телеоперации общего контроля. В Международной конференции IEEE/RSJ по интеллектуальным роботам и системам, том 2, страницы 1290–1295 т.2, 2002. doi: 10.1109/irds.2002. 1043932.

[141] А. Д. Драган и С. С. Сриниваса. Формализм, смешанный политикой для общего контроля. Международный журнал Robotics Research, 32 (7): 790–805, 2013. DOI: 10.1177/0278364913490324. URL https://doi.org/10.1177/0278364913490324.

[142] Д. Гопинат, С. Джайн и Б. Д. Аргалл. Оптимизация общей автономии человека в вспомогательной робототехнике. IEEE Robotics and Automation Letters, 2 (1): 247–254, 2017. DOI: 10. 1109/LRA.2016.2593928.

[143] А. Д. Драган и С. С. Сриниваса. Формализация вспомогательной телеоперации, том 376. MIT Press, июль 2012 года.

[144] H. J. Jeon, D.P. Losey и D. Sadigh. Общая автономия с учеными скрытыми действиями. Arxiv Preprint arxiv: arxiv-2005.03210, 2020.

[145] Y. Cui, S. Karamcheti, R. Palleti, N. Shivakumar, P. Liang и D. Sadigh. «Нет, справа» - онлайн -исправление языков для манипуляции с роботизированными манипуляциями с помощью общей автономии. Arxiv Preprint arxiv: arxiv-2301.02555, 2023.

[146] P. Wu, Y. Shentu, Z. Yi, X. Lin и P. Abbeel. Гелло: общая, недорогая и интуитивная структура телеоперации для манипуляторов роботов. Arxiv Preprint arxiv: arxiv-2309.13037, 2023.

[147] C. Wang, H. Shi, W. Wang, R. Zhang, L. Fei-Fei и C.K. Liu. DEXCAP: масштабируемая и портативная система сбора данных MOCAP для ловких манипуляций. Arxiv Preprint arxiv: arxiv-2403.07788, 2024.

[148] З. Фу, Т. З. Чжао и С. Финн. Mobile Aloha: изучение бимануальных мобильных манипуляций с недорогим телеодером всего тела. Arxiv Preprint arxiv: arxiv-2401.02117, 2024.

[149] S. Dass, W. Ai, Y. Jiang, S. Singh, J. Hu, R. Zhang, P. Stone, B. Abbatematteo и R. Mart´ınmart´ın. Телемома: модульная и универсальная система телеоперации для мобильных манипуляций. Arxiv Preprint arxiv: arxiv-2403.07869, 2024.

[150] T. He, Z. Luo, W. Xiao, C. Zhang, K. Kitani, C. Liu и G. Shi. Изучение человеческой топюманоидной телеоперации в реальном времени. Arxiv Preprint arxiv: arxiv-2403.04436, 2024.

[151] H. Liu, S. Dass, R. Mart´ın-Mart´ın и Y. Zhu. Модель мониторинга выполнения с интерактивным имитационным обучением. Arxiv Preprint arxiv: arxiv-2310.17552, 2023.

[152] З. Лю, А. Бахети и С. Сонг. Отражается: суммирование опыта робота для объяснения неудачи и коррекции. Arxiv Preprint arxiv: arxiv-2306.15724, 2023.

[153] L. Ankile, A. Simeonov, I. Shenfeld и P. Agrawal. Соковыжималка: эффективное имитационное обучение имитации для роботизированной сборки. Arxiv Preprint arxiv: arxiv-2404.03729, 2024.

[154] М. Н. Мистри и Л. Ригетти. Оперативное пространство управление ограниченными и неразрешимыми системами. В робототехнике: Science and Systems, 2011. URL https: //api.semanticscholar. org/corpusid: 10392712.

[155] Л. Фан, Г. Ван, Ю. Цзян, А. Мандлекар, Ю. Ян, Х. Чжу, А. Тан, Д.-А. Хуан, Ю. Чжу и А. Анандкумар. Minedojo: строительство открытых воплощенных агентов с знаниями в интернет-масштабе. Arxiv Preprint arxiv: arxiv-2206.08853, 2022.

[156] Д.-А. Кливерт, Т. Унтертинер и С. Хохрейтер. Быстрое и точное глубокое обучение сети с помощью экспоненциальных линейных единиц (Elus). Arxiv Preprint arxiv: arxiv-1511.07289, 2015.

[157] Д. Маковичук и В. Маковийчук. RL-игра: высокопроизводительная структура для обучения подкреплению. https://github.com/denys88/rl_games, май 2021.

[158] J. Schulman, P. Moritz, S. Levine, M. Jordan и P. Abbeel. Высокомерный непрерывный контроль с использованием общей оценки преимуществ. Arxiv Preprint arxiv: arxiv-1506.02438, 2015.

[159] Д. П. Кингма и Дж. Ба. Адам: метод стохастической оптимизации. Arxiv Preprint arxiv: arxiv-1412.6980, 2014.

Авторы:

(1) Юнфан Цзян, факультет информатики;

(2) Чен Ван, кафедра компьютерных наук;

(3) Руохан Чжан, Департамент информатики и Институт ИИ, ориентированного на человека (HAI);

(4) Цзяджун Ву, Департамент информатики и Институт ИИ, ориентированного на человека (HAI);

(5) Ли Фей-Фей, Департамент информатики и Институт ИИ, ориентированного на человека (HAI).

Эта статья есть

Оригинал