Транзичный рецепт: моделирование смешивания, добавить человеческое прикосновение, успешно развернуть

4 июня 2025 г.Таблица ссылок

Аннотация и 1 введение

2 предварительные

3 Transic: передача политики с рисованием в реальность путем обучения на онлайн-коррекции и 3.1 базовые политики обучения в моделировании с RL

3.2 ОБУЧЕНИЯ ОТРИЦИЯ ПОЛИТИКИ ОТНОВЛЕНИЯ НАУКЦИИ

3.3 Интегрированная структура развертывания и 3,4 Подробности реализации

4 эксперименты

4.1 Настройки эксперимента

4.2 Количественное сравнение по четырем задачам сборки

4.3 Эффективность в решении различных разрывов с рисунком (Q4)

4.4 Масштабируемость с человеческими усилиями (Q5) и 4,5 интригующих свойств и возникающего поведения (Q6)

5 Связанная работа

6 Заключение и ограничения, подтверждения и ссылки

А. Подробная информация об обучении симуляции

Б. Реальные детали обучения в реальном мире

C. Настройки эксперимента и детали оценки

D. Дополнительные результаты эксперимента

2 предварительные

2.1 Составление проблемы

2.2 Обучение политике на основе вмешательства

3 Transic: Передача политики с рисованием в реальность путем обучения у онлайн-коррекции

Обзор Transic показан на рис. 2. На высоком уровне после обучения базовой политики по моделированию мы развертываем его на реальном роботе, находясь под контролем человеческого оператора. Человек прерывает автономное исполнение при необходимости и обеспечивает онлайн -коррекцию посредством телеоптация. Такое вмешательство и онлайн-коррекция собираются для обучения остаточной политики, после чего используются как базовые, так и остаточные политики для выполнения задач манипуляции, богатых контактами. В этом разделе мы сначала подробно рассмотрим этап обучения симуляции с несколькими важными вариантами дизайна, которые уменьшают разрывы с рисунком до переноса. Затем мы вводим остаточную политику, извлеченную из вмешательства человека и онлайн -коррекции. Впоследствии мы представляем интегрированную структуру для развертывания базовой политики наряду с научной остаточной политикой во время тестирования. Наконец, мы предоставляем детали реализации.

3.1 Политика базовой обучения в моделировании с RL

3.2 ОБУЧЕНИЕ ОСТАНОВИЧЕСКИЙ ПОЛИТИКИ из онлайн -коррекции

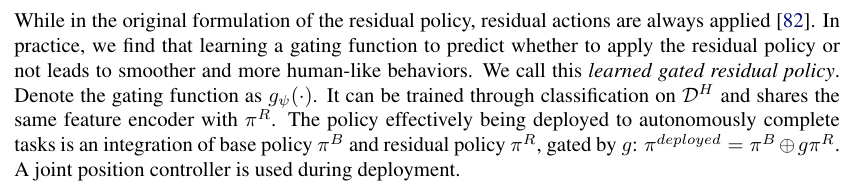

3.3 Интегрированная структура развертывания

3.4 Детали реализации

Мы используем тренажерный зал Исаака [10] в качестве бэкэнда моделирования. Проксимальная оптимизация политики (PPO [84]) используется для обучения политики учителей с нуля. Мы разрабатываем конкретные функции вознаграждения и учебные планы, когда это необходимо, чтобы облегчить обучение RL. Мы применяем исчерпывающую доменную рандомизацию во время обучения политике учителей и надлежащего увеличения данных во время дистилляции политики учащихся. Политика студентов параметризована в виде моделей гауссовой смеси (GMMS [68]). Мы также экспериментировали с другими современными моделями политики, такими как политика диффузии [85], но не наблюдали более качественных результатов. Смотрите приложение гл. A Для получения более подробной информации о этапе обучения моделирования и дополнительных сравнения. На этапе сбора данных человека в петле мы используем пространство 3DConnexion в качестве интерфейса телеоперации. Остаточные политики используют современные облачные кодеры точек, такие как PointNet [86] и восприятие [87, 88] и GMM в качестве головки действия. Мы следуем передовым методам обучения остаточной политики, включая использование скорости обучения и отжига косинуса [89]. В Приложении Sec представлена дополнительная тренировка. Б.4

Авторы:

(1) Юнфан Цзян, факультет информатики;

(2) Чен Ван, кафедра компьютерных наук;

(3) Руохан Чжан, Департамент информатики и Институт ИИ, ориентированного на человека (HAI);

(4) Цзяджун Ву, Департамент информатики и Институт ИИ, ориентированного на человека (HAI);

(5) Ли Фей-Фей, Департамент информатики и Институт ИИ, ориентированного на человека (HAI).

Эта статья есть

Оригинал