Связь между частотой концепции и производительностью искусственного интеллекта, наблюдаемая через изображения и слова

10 июля 2025 г.Таблица ссылок

Аннотация и 1. Введение

2 концепции в предварительных данных и количественная частота

3 Сравнение производительности предварительного подготовки и «нулевого выстрела» и 3.1 Экспериментальная установка

3.2

4 Тестирование стресса Концепция тенденции масштабирования частоты и 4.1.

4.2 Тестирование обобщения на чисто синтетическую концепцию и распределения данных

5 Дополнительные идеи от частот концепции предварительного подготовки

6 Проверка хвоста: пусть он виляет!

7 Связанная работа

8 Выводы и открытые проблемы, подтверждения и ссылки

Часть я

Приложение

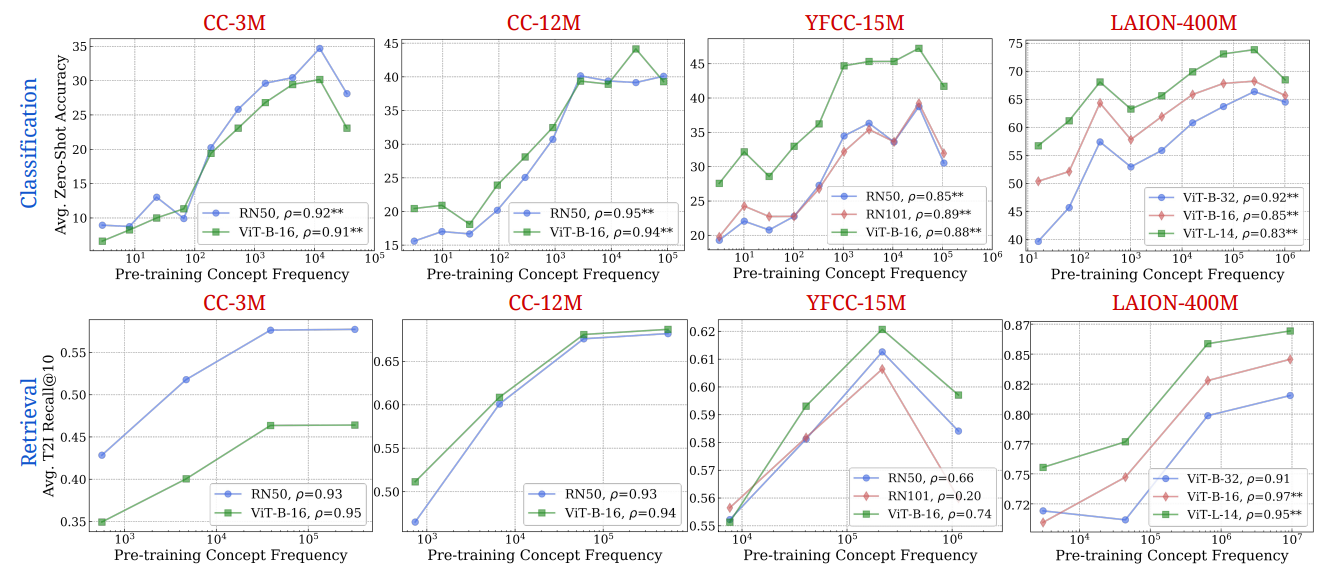

A. Частота концепции является прогнозирующей производительности в разных стратегиях

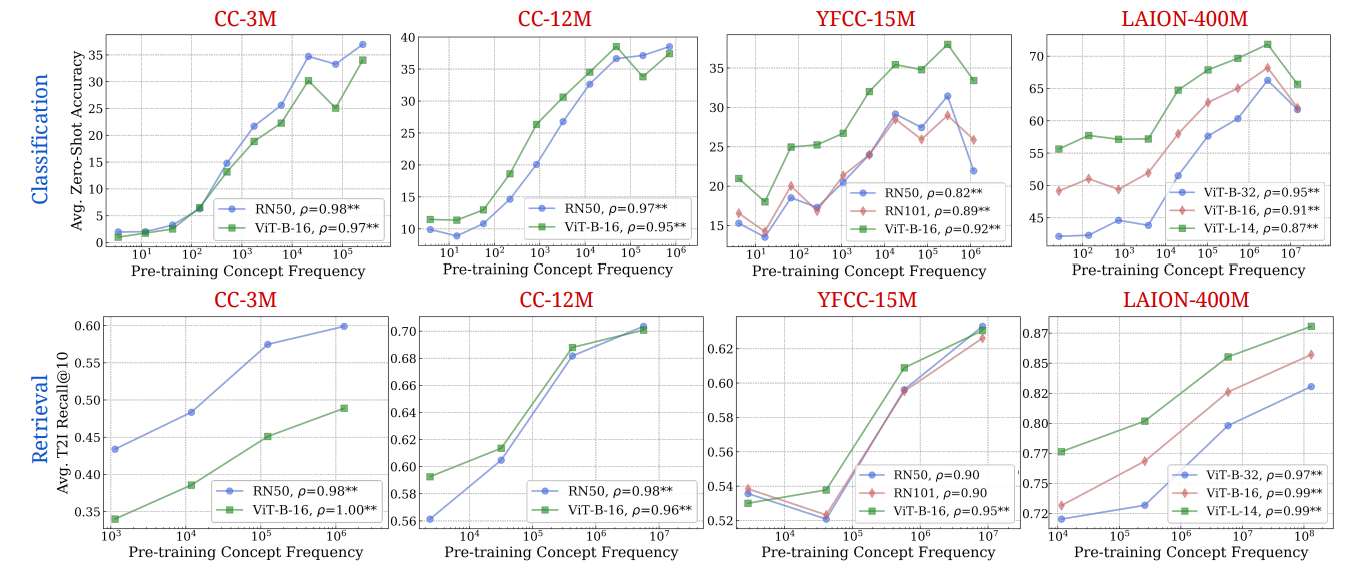

B. Частота концепции является прогнозирующей производительности в результате получения метриков извлечения

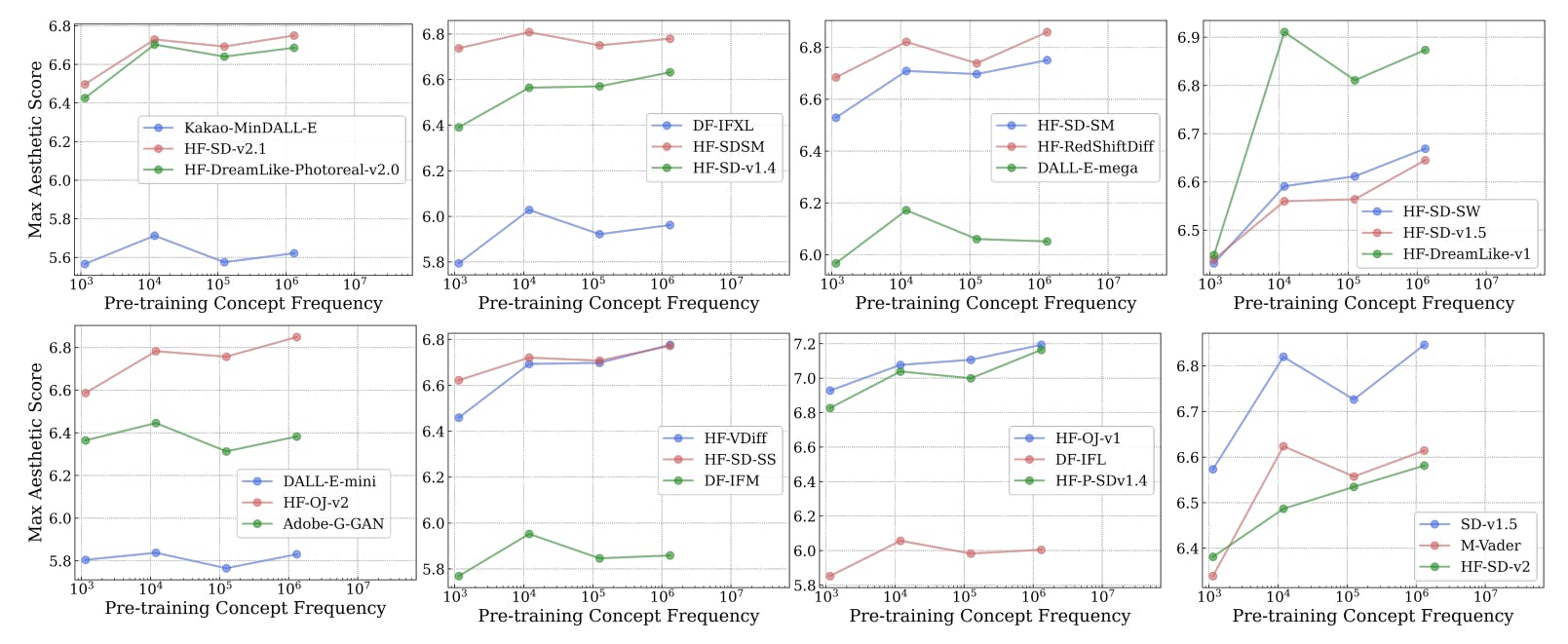

C. Частота концепции является прогнозирующей производительности для моделей T2I

D. Концепция частота является прогнозирующей производительности в разных концепциях только из изображений и текстовых областей

E. Экспериментальные детали

F. Почему и как мы используем Ram ++?

G. Подробная информация о результатах степени смещения

H. T2I Модели: оценка

I. Результаты классификации: пусть это виляет!

D Концепция частота является прогнозирующей производительности в разных концепциях только из изображений и текстовых областей

На всех основных графиках, которые мы представляли до сих пор, частоты концепции были оценены с использованием пересечения частоты изображений и текстовых частот. Здесь мы демонстрируем результаты с использованием их независимо на рис. 17 и 18 соответственно. Мы отмечаем, что оба независимых методов поиска демонстрируют логарифмические тенденции, как и прежде, подтверждая наш основной результат. Мы наблюдаем этоСильная логарифмическая тенденция между частотой концепции и с нулевым выстрелом, надежно удерживается в разных концепциях, полученных из изображений и текстовых доменов независимо.

E Экспериментальные детали

E.1 Установка Mayilvahanan et al. [79]

Laion-200M-это набор данных, полученный путем дедуплирования Laion-400M путем обрезки точных дубликатов, около дубликатов и семантически сходных образцов в Laion-400M [10]. Контрольный набор предварительного подготовки создается путем обрезки 50 миллионов очень похожих образцов из Laion в порядке уменьшения сходства восприятия с данными в наборе ImageNet-Val. Мы используем 150 -метровый набор предварительной подготовки для получения распределения концепции. Мы оцениваем производительность модели клипа Vit-B/32, обученной этому набору данных для наших нижестоящих задач, и представляем наш анализ по этим задачам.

E.2Пусть это виляет!: Курация набора тестов

Чтобы наши наборы данных были тщательно очищены и разнообразны, мы следуем тщательному процессу:

Разнообразный источник:Мы собираем изображения из трех различных онлайн-источников-Flickr, Duckduckgo и Bing Search-для максимизации разнообразия нашего набора данных, сохраняя при этом очень простые в классе изображения [2].

Временная фильтрация:Мы применили фильтр только для получения изображений только после января 2023 года, чтобы минимизировать перекрытие с изображениями, используемыми при предварительном обучении моделей на языке зрения (VLMS). Обратите внимание, что это помогает смягчить, но не гарантирует, что проблема перекрытия решена.

Удаление выбросов:Мы используем предварительно обученный stectionNet [111] для удаления выбросов из всего пула изображений. Мы делаем это, принимая все парные косинусные значения между всеми изображениями в пуле и удаляя изображения, которые находятся в нижних 5% от значений сходства [3].

Первоначальная двойка с началом сети:Мы используем предварительно обученную модель InceptionNet [111] для выявления и удаления дубликатов. Этот шаг включает в себя установку высоких пороговых значений для мягкого двойника (0,9 для общих классов и 0,95 для мелкозернистых классов), чтобы обеспечить лишь незначительные, точные исключения. Порог 0,9/0,95 означает, что мы считаем, что изображения дубликаты, если косинусное сходство встраивания этого изображения (из начала) с любым другим изображением в пуле изображений больше, чем 0,9/0,95.

Ручная проверка:После автоматической очистки мы вручную проверяем и проверяем точность оставшихся изображений для каждого класса, чтобы убедиться, что они соответствуют стандартам качества.

Деупликация второго уровня с хешированием восприятия:После проверки мы используем хеширование восприятия [37] с порогом из 10 бит для идентификации и удаления дублирующих изображений в каждом классе, обеспечивая уникальность в нашем наборе данных [4].

Балансировка класса:Наконец, мы уравновешиваем набор данных, чтобы обеспечить равное представление классов. Этот процесс был следовал за повышение качества и надежности нашего набора данных для задач распознавания изображений.

Авторы:

(1) Вишаал Удандарао, Центр ИИ Тубингена, Университет Табингингена, Кембриджский университет и равный вклад;

(2) Ameya Prabhu, Центр AI Tubingen, Университет Табингинга, Оксфордский университет и равный вклад;

(3) Адхирадж Гош, Центр ИИ Тубинген, Университет Тубингена;

(4) Яш Шарма, Центр ИИ Тубинген, Университет Тубингена;

(5) Филипп Х.С. Торр, Оксфордский университет;

(6) Адель Биби, Оксфордский университет;

(7) Сэмюэль Албани, Кембриджский университет и равные консультирование, приказ, определенный с помощью монеты;

(8) Матиас Бетге, Центр ИИ Тубинген, Университет Тубингена и равные консультирование, Орден определяется с помощью переворачивания монеты.

Эта статья есть

Оригинал

Recent Post

-

Когда ИИ становится посредником в семейных спорах о наследстве

20 августа 2025 г. -

Конец общей аннотации в здравоохранении: визуализация сердца показывает, почему

20 августа 2025 г. -

5 Рабочие процессы агента AI для повторяемого успеха (включен код)

20 августа 2025 г. -

Почему OCR борется со страницами с несколькими колоннами

20 августа 2025 г. -

Все, что я узнал (трудный путь) как начинающий основатель AI SaaS

20 августа 2025 г.

Categories

- Python

- blockchain

- web

- hackernoon

- вычисления

- вычислительные компоненты

- цифровой дом

- игры

- аудио

- домашний кинотеатр

- Интернет

- Мобильные вычисления

- сеть

- фотосъемка видео

- портативные устройства

- программного обеспечения

- телефон и связь

- телевидение

- видео

- мир технологий

- умные гиды

- облако

- искусственный интеллект

- се

- Samsung

- умные города

- digitaltrends

- отели

- Startups

- Venture

- Crypto

- Apps

- безопасность

- техника и работа

- cxo

- мобильность

- разработчик

- 5г

- майкрософт

- инновации

- Права и свободы

- Законодательство и право

- Политика и общество

- Космическая промышленность

- Информационные технологии

- Технологии

- Образование

- Научные исследования

- Автомобильная промышленность

- Программная инженерия

- IT и технологии

- Веб-разработка

- Программирование

- Автоматизация

- Карьерный рост

- Программирование и анализ данных

- Трудоустройство

- Политика

- Искусственный интеллект

- ИТ-технологии

- Программное обеспечение

- Экологическая политика

- Образование и рынок труда

- Политика и право

- Microsoft Teams и SharePoint

- Информационная безопасность

- Кибербезопасность

- Налоги

- Образование и карьера

- Интернет и технологии

- Технологии, Государственные услуги

- Политика и технологии

- Разработка программного обеспечения

- Разработка ПО

- Машинное обучение

- Налогообложение, технологии, открытый исходный код

- Финансы и налоги

- Технологии, Интернет, Экология

- Интернет, безопасность

- Технологии и политика

- Операционные системы

- Профессиональная разработка

- Технологии, Безопасность

- Интернет и общество

- Финансовая индустрия

- Налоговый учёт

- Общественное здравоохранение

- Технологическая отрасль

- Юриспруденция

- Технологии и государство

- Здоровье и фитнес

- IT-инфраструктура

- Технологии и ИИ

- Здравоохранение

- IT

- Технологии, Экономика

- Музыка и технологии

- Здоровье и питание

- IT и безопасность

- Бизнес и предпринимательство

- Технологии, Программное обеспечение

- Технологии и инновации

- Технологии, данные, этика

- Технологии и Интернет

- Технологии и SaaS

- Медицина и здравоохранение

- Онлайн-видеосервисы

- Финансы и технологии

- Чтение и саморазвитие

- Экономика и бизнес

- Безопасность данных

- Удаленная работа

- Авиация и технологии

- Технологии, Игры

- Энергетика

- Социальные сети, безопасность, технологии

- Саморазвитие

- Безопасность информации

- Бизнес и карьера

- Технологии и отношения

- Игровая индустрия

- Компьютерная индустрия

- Математика, Искусственный интеллект

- Наука и технологии

- Технологии и безопасность

- Технологии, Удаленная работа, Бизнес

- Видеоигры

- Технологии, Искусственный интеллект, Этика

- Технологии, социальные сети, 6G

- Технологии, Программирование, AI, Разработка ПО

- Программирование, Разработка ПО, Технологии

- Животные

- Технологии, Искусственный интеллект

- Программирование, карьера, технологии, обучение

- Бизнес и технологии

- Технологии, Безопасность данных

- Астрономия и физика

- Продуктивность, личное развитие

- Медиа и Технологии

- Программирование и Искусственный Интеллект

- Социальные сети

- Политика и экономика

- Технологии, Медицина, Искусственный интеллект

- Технологии и управление

- Космос и астрономия

- Общество и политика

- Космические исследования

- Веб-дизайн

- Искусственный интеллект и безопасность данных

- Технологии, Безопасность, Конфиденциальность

- Экологическая проблема

- Технологии, Погода

- Авиация

- Транспортная сфера

- Технологии и бизнес

- Игровая промышленность

- Телевидение и реклама

- Аналитика данных

- Технологии и кибербезопасность

- Маркетинг

- Технологии и гаджеты

- Технологии, Авиация, Инновации

- Финансы и инвестиции

- Технологии и общество

- Рыночный анализ

- Космология

- Данные и бизнес

- IT и программирование

- Технологии и право

- Программирование и разработка

- Астрофизика

- Медицинские технологии

- Авиационная промышленность

- Технологии и искусственный интеллект

- Генетическая инженерия

- Бизнес и инвестиции

- Компьютерная промышленность

- Психология и социология

- Образование и технологии

- Рынок труда

- Технологии, Стартапы

- Технологии, Приватность, Чтение

- Маркетинг и продажи

- Виртуальная реальность

- Технологии, Смартфоны, Маркетинг

- Технологии, Бизнес, Личностный рост

- Экологические проблемы

- Экономика и технологии

- IT и карьера

- Интернет и безопасность

- Разработка и технологии

- Биотехнологии

- Интернет-магазины, кибербезопасность

- Финансы

- Безопасность и технологии

- Экономика

- Защита данных

- Data Science

- Карьера и работа

- Финансовый успех, мошенничество, маркетинг

- Безопасность

- Экология

- Космическая индустрия

- Программирование, Python, Обучение

- Технологии искусственного интеллекта

- Технологии, Дизайн, iOS

- Программирование, DevOps, Kubernetes

- Социальные сети и пропаганда

- Корпоративная этика

- Управление IT-инфраструктурой

- Здоровье и медицина

- Медицина

- Медицинская промышленность

- Разработка и дизайн

- Искусственный интеллект, Диагностика систем

- Образование и психология

- Технологии, Автомобильная промышленность

- Автомобили и путешествия

- Астрономия и космология

- Программирование и технологии

- IT, работа в офисе, эмоциональный интеллект

- Компьютерная техника

- Здоровье и благополучие

- Управление персоналом

- Политика и управление

- Бизнес и экономика

- Социальные сети, Пропаганда, Информационная безопасность

- Технологии и автоматизация

- Геймдизайн

- Экология и технологии

- CRM-системы, IT-инфраструктура

- Права человека

- Цифровая цензура, свобода слова, технологии

- Технологии, Искусственный интеллект, Работа

- Наука о данных

- Астрономия, Наука

- Интернет и цифровые технологии

- Технологии, управление

- Интернет и связь

- Технологии и конфиденциальность

- Интернет и свобода слова

- Психология и социальные науки

- Книги и литература

- Работа и карьера

- Финансовые технологии

- Психология и саморазвитие

- IT, программирование, сети

- Технологии, Видеоигры

- Экология и энергетика

- Космонавтика

- Медицина и технологии

- Игры и развлечения

- Музыкальная индустрия

- Логистика и складирование

- Бизнес и финансы

- Экология и окружающая среда

- Правозащита

- Социальные сети и дезинформация

- Технологии и рынок труда

- Технологии, Искусственный интеллект, Рынок труда

- Технологии и будущее

- Медицина и здоровье

- Социальные медиа

- Экология, политика, общество

- Экономика и Финансы

- Разработка игр

- Пропаганда и дезинформация

- Медицинские исследования

- Онлайн-знакомства

- Политика и СМИ

- Энергетика и электромобили

- Климатические изменения

- Технологии, Рынок труда

- IT и управление данными

- Безопасность и кибербезопасность

- Интернет-технологии

- Психология и личностное развитие

- Технологии, Мессенджеры

- Цифровые технологии

- Здоровье и самосовершенствование

- Технологии и AI

- Технологии и спорт

- IT, Разработка программного обеспечения

- Экология и климат

- Космос и технологии

- Юридическая сфера

- Безопасность в интернете

- Программирование, Искусственный Интеллект, Качество ПО

- Технологии и мессенджеры

- Социальная справедливость

- Технологическая индустрия

- Личностное развитие, Time-менеджмент, Психология

- Бизнес и менеджмент

- Технологии, Микросхемы, Автономные системы

- Фриланс и предпринимательство

- Социальные сети и искусственный интеллект

- Криминальные дела

- Социальные сети, Маркетинг

- Энергетика и экология

- Технологии, Искусственный Интеллект, Полиция

- Программирование, Искусственный интеллект, Рынок труда

- Социальные сети, дезинформация, анализ данных

- Потребительские права

- Образование и наука

- Технологии и правосудие

- Технологии, Безопасность, Автомобили

- Энергетика и окружающая среда

- Личностное развитие

- Технологии и экономика

- Медиа и коммуникации

- Миграция и иммиграция

- Личностный рост

- Налоговая система

- Медиа и телевидение

- Интернет и телекоммуникации

- Технологии, Кибербезопасность

- Здоровье

- Социальные сети и карьера

- Политика и инфраструктура

- Предпринимательство

- Промышленность программного обеспечения

- СМИ и коммуникации

- Медиа и Общество

- Медицина и генетика

- Веб-разработка и дизайн

- Технологии, процессоры

- IT-индустрия

- Кинопроизводство и технологии

- Транспорт

- Текстовый анализ

- Технологии, дизайн интерфейсов

- Офисные приложения

- Технологии, Онлайн-сервисы

- Медицина и биотехнологии

- Общество и технологии

- Экономика и рынок труда

- Искусственный интеллект, программирование, аналитика

- Технологии, следствие

- Сетевые технологии

- Технологии и веб-разработка

- Программирование, Обучение, Практика

- Коммуникации и ИТ

- Технологии, Карьера, Экономика

- Технологии и транспорт

- Здравоохранение и медицина

- Технологии, Государственное управление

- IT-безопасность

- IT и разработка

- Финансы и экономика

- Социальные сети, Общество, Сообщества

- IT-разработка

- СМИ и политика

- Конфиденциальность и безопасность

- Экономика и политика

- Технологии и общественная жизнь

- Бизнес и этика

- Безопасность и защита информации

- Технологии, бизнес

- Интернет и цензура

- Государственное регулирование

- Игры, Технологии

- Технологии и оптимизация

- Технологии ИИ и машинного обучения

- Технологии, IT, карьера

- IT и программное обеспечение

- Право и преступность

- Криминал и Правоохранительные Органы

- Технологии и энергетика

- Нефтяная промышленность

- Социальные конфликты

- Преступность и безопасность

- Таможенная очистка

- Медиа и журналистика

- Технологии и разработка приложений

- Телекоммуникации

- Консалтинг и управление

- Управление человеческими ресурсами

- Онлайн-контент

- Психология и психотерапия

- Морская отрасль

- Психология и технологии

- Социальные проблемы

- Маркетинг и реклама

- Политика и власть

- Экономика и торговля

- Карьера и развитие

- Продуктивность и Управление Временем

- Технологии, Искусственный интеллект, Реклама

- Окружающая среда

- Здоровье и технологии

- Бытовая химия

- Правовая информация

- Юстиция

- Технологии и экология

- Социальные сети и безопасность

- Базы данных

- Политика и государственное управление

- Интернет и социальные сети

- Индустрия IT

- Технологии и программное обеспечение

- История и искусственный интеллект

- Рестораны и обслуживание

- Технологии и программирование

- Социология

- Телевидение и СМИ

- Психология

- Политика и бизнес

- Мобильные устройства

- Технологии и развлечения

- Экология и охрана окружающей среды

- Маркетинг и брендинг

- Медицинская индустрия

- Кибербезопасность и технологии

- Социальные сети и политика

- Развлечения

- ИТ и автоматизация

- Криптовалюты и блокчейн

- История и идеология

- Медицина и политика

- Личная жизнь миллиардеров

- Образование и Политика

- Туризм и отдых

- Психология и искусственный интеллект

- Удаленная работа и производительность

- Выживание

- Управление командами

- Разработка

- Международная торговля

- Корпоративная ответственность

- Социальные сети и общество

- Управление серверами

- Индустрия компьютерных игр

- Политика и климат

- Онлайн-игры

- Медицинская отрасль

- Искусственный интеллект и технологии

- Религия и мораль

- Путешествия

- Социальные сети и информация

- Технологии и медиа

- Технологии и свобода

- Электронная коммерция

- Бизнес и управление

- Психическое здоровье и технологии

- Технологии и устойчивое развитие

- Технологии и социальные сети

- Профессии

- Экономика и промышленность

- Технологии и трудоустройство

- Иммиграционная политика

- Продуктивность и фокус

- Технологии и робототехника

- Свобода слова

- Психология и власть

- Социальные сети и онлайн-платформы

- Технологии и Права Человека

- СМИ и журналистика

- Окружающая среда и здоровье

- Технологии и сервисы

- Индустрия игр

- Программирование и ИИ

- Медиа и пропаганда

- Социальная сфера

- Социальные сети и общественное мнение

- Поп-культура

- Сервисы потокового вещания

- Рынок развлечений

- Социальные медиа и политика

- Технологии и информация

- Медиа и развлечения

- Квантовая криптография

- Искусственный интеллект в индустрии развлечений

- Технологии и коммуникация

- Индустрия программирования

- Финансовая безопасность

- Международные отношения

- Бизнес и лидерство

- Технологические новости и аналитика

- Программное обеспечение и технологии

- Предпринимательство и малый бизнес

- Политика и общественный контроль

- Здравоохранение и политика

- Управление персоналом и эффективность разработки

- Технологии и ИТ‑управление

- Свобода слова и дезинформация

- Веб-дизайн и разработка

- Веб‑разработка и карьера