Экспериментальный интерфейс Numpy's Tensorflow приводит к глубокому обучению

22 июля 2025 г.Обзор контента

- Обзор

- Настраивать

- Включение поведения Numpy

- Tensorflow numpy nd массив

- Тип продвижения

- Вещание

- Индексация

- Пример модель

- Tensorflow numpy и numpy

- Numpy Feetworkabity

- Буферные копии

- Приоритет оператора

Обзор

TensorFlow реализует подмножествоNumpy API, доступно какtf.experimental.numpyПолем Это позволяет запустить код Numpy, ускоряемый TensorFlow, а также позволяет доступа ко всем API -интерфейсам TensorFlow.

Настраивать

import matplotlib.pyplot as plt

import numpy as np

import tensorflow as tf

import tensorflow.experimental.numpy as tnp

import timeit

print("Using TensorFlow version %s" % tf.__version__)

2024-08-15 01:31:55.452313: E external/local_xla/xla/stream_executor/cuda/cuda_fft.cc:485] Unable to register cuFFT factory: Attempting to register factory for plugin cuFFT when one has already been registered

2024-08-15 01:31:55.473711: E external/local_xla/xla/stream_executor/cuda/cuda_dnn.cc:8454] Unable to register cuDNN factory: Attempting to register factory for plugin cuDNN when one has already been registered

2024-08-15 01:31:55.480014: E external/local_xla/xla/stream_executor/cuda/cuda_blas.cc:1452] Unable to register cuBLAS factory: Attempting to register factory for plugin cuBLAS when one has already been registered

Using TensorFlow version 2.17.0

Включение поведения Numpy

Для использованияtnpКак Numpy, включите поведение Numpy для TensorFlow:

tnp.experimental_enable_numpy_behavior()

Этот вызов обеспечивает продвижение типа в TensorFlow, а также изменяет вывод типа при преобразовании литералов в тензоры, чтобы более строго следовать стандарту Numpy.

Примечание:Этот вызов изменит поведение всего TensorFlow, а не толькоtf.experimental.numpyмодуль.

Tensorflow numpy nd массив

Экземплярtf.experimental.numpy.ndarray, называетсяИ массив, представляет собой многомерный плотный массив данногоdtypeразмещен на определенном устройстве. Это псевдонимаtf.TensorПолем Ознакомьтесь с классом ND массива для полезных методов, таких какndarray.TВndarray.reshapeВndarray.ravelи другие.

Сначала создайте объект ND массива, а затем вызовите разные методы.

# Create an ND array and check out different attributes.

ones = tnp.ones([5, 3], dtype=tnp.float32)

print("Created ND array with shape = %s, rank = %s, "

"dtype = %s on device = %s\n" % (

ones.shape, ones.ndim, ones.dtype, ones.device))

# `ndarray` is just an alias to `tf.Tensor`.

print("Is `ones` an instance of tf.Tensor: %s\n" % isinstance(ones, tf.Tensor))

# Try commonly used member functions.

print("ndarray.T has shape %s" % str(ones.T.shape))

print("narray.reshape(-1) has shape %s" % ones.reshape(-1).shape)

Created ND array with shape = (5, 3), rank = 2, dtype = <dtype: 'float32'> on device = /job:localhost/replica:0/task:0/device:GPU:0

Is `ones` an instance of tf.Tensor: True

ndarray.T has shape (3, 5)

narray.reshape(-1) has shape (15,)

WARNING: All log messages before absl::InitializeLog() is called are written to STDERR

I0000 00:00:1723685517.895102 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685517.898954 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685517.902591 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685517.906282 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685517.918004 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685517.921334 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685517.924792 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685517.928195 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685517.931648 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685517.935182 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685517.938672 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685517.942206 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685519.174780 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685519.176882 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685519.178882 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685519.180984 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685519.183497 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685519.185413 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685519.187391 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685519.189496 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685519.191405 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685519.193373 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685519.195387 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685519.197409 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685519.235845 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685519.237893 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685519.239848 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685519.241962 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685519.243923 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685519.245869 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685519.247783 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685519.249797 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685519.251701 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685519.254112 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685519.256530 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

I0000 00:00:1723685519.258985 23752 cuda_executor.cc:1015] successful NUMA node read from SysFS had negative value (-1), but there must be at least one NUMA node, so returning NUMA node zero. See more at https://github.com/torvalds/linux/blob/v6.0/Documentation/ABI/testing/sysfs-bus-pci#L344-L355

Тип продвижения

В TensorFlow есть 4 варианта продвижения типа.

- По умолчанию TensorFlow повышает ошибки вместо того, чтобы продвигать типы для операций смешанного типа.

- Бег

tf.numpy.experimental_enable_numpy_behavior()переключает TensorFlow для использованияNumPyТип Правила продвижения (описано ниже). - После TensorFlow 2.15 есть два новых варианта (см.TF Numpy PromotionДля получения подробной информации):

tf.numpy.experimental_enable_numpy_behavior(dtype_conversion_mode="all")использует правила продвижения JAX Type.tf.numpy.experimental_enable_numpy_behavior(dtype_conversion_mode="safe")Использует правила продвижения JAX Type, но не позволяет определенным небезопасным акциям.

Numpy Type Promotion

API-интерфейсы Tensorflow Numpy имеют четкую семантику для преобразования литералов в массив ND, а также для выполнения продвижения типа на ND-входах. Пожалуйста, посмотритеnp.result_typeДля получения более подробной информации.

Tensorflow APIS уходитtf.TensorВходы без изменений и не выполняют акцию типа, в то время как API -интерфейсы Tensorflow Numpy продвигают все входные данные в соответствии с правилами продвижения типа Numpy. В следующем примере вы будете выполнять продвижение типа. Во -первых, запустите дополнение на ND -входах различных типов и обратите внимание на типы выводов. Ни одно из этих акций типа не будет разрешено API -интерфейсом Tensorflow.

print("Type promotion for operations")

values = [tnp.asarray(1, dtype=d) for d in

(tnp.int32, tnp.int64, tnp.float32, tnp.float64)]

for i, v1 in enumerate(values):

for v2 in values[i + 1:]:

print("%s + %s => %s" %

(v1.dtype.name, v2.dtype.name, (v1 + v2).dtype.name))

Type promotion for operations

int32 + int64 => int64

int32 + float32 => float64

int32 + float64 => float64

int64 + float32 => float64

int64 + float64 => float64

float32 + float64 => float64

Наконец, преобразуйте литералы в nd массив, используяndarray.asarrayи обратите внимание на полученный тип.

print("Type inference during array creation")

print("tnp.asarray(1).dtype == tnp.%s" % tnp.asarray(1).dtype.name)

print("tnp.asarray(1.).dtype == tnp.%s\n" % tnp.asarray(1.).dtype.name)

Type inference during array creation

tnp.asarray(1).dtype == tnp.int64

tnp.asarray(1.).dtype == tnp.float64

При преобразовании литералов в массив ND Numpy предпочитает широкие типы, такие какtnp.int64иtnp.float64Полем В отличие,tf.convert_to_tensorпредпочитаетtf.int32иtf.float32Типы для преобразования констант вtf.TensorПолем Tensorflow Numpy APIS придерживается поведения Numpy для целых чисел. Что касается поплавков,prefer_float32аргументexperimental_enable_numpy_behaviorПозволяет вам контролироватьtf.float32надtf.float64(по умолчаниюFalse) Например:

tnp.experimental_enable_numpy_behavior(prefer_float32=True)

print("When prefer_float32 is True:")

print("tnp.asarray(1.).dtype == tnp.%s" % tnp.asarray(1.).dtype.name)

print("tnp.add(1., 2.).dtype == tnp.%s" % tnp.add(1., 2.).dtype.name)

tnp.experimental_enable_numpy_behavior(prefer_float32=False)

print("When prefer_float32 is False:")

print("tnp.asarray(1.).dtype == tnp.%s" % tnp.asarray(1.).dtype.name)

print("tnp.add(1., 2.).dtype == tnp.%s" % tnp.add(1., 2.).dtype.name)

When prefer_float32 is True:

tnp.asarray(1.).dtype == tnp.float32

tnp.add(1., 2.).dtype == tnp.float32

When prefer_float32 is False:

tnp.asarray(1.).dtype == tnp.float64

tnp.add(1., 2.).dtype == tnp.float64

Вещание

Подобно Tensorflow, Numpy определяет богатую семантику для «вещания» ценностей. Вы можете проверитьNumpy Trowdcasting GuideДля получения дополнительной информации и сравните это сСемантика вещания TensorflowПолем

x = tnp.ones([2, 3])

y = tnp.ones([3])

z = tnp.ones([1, 2, 1])

print("Broadcasting shapes %s, %s and %s gives shape %s" % (

x.shape, y.shape, z.shape, (x + y + z).shape))

Broadcasting shapes (2, 3), (3,) and (1, 2, 1) gives shape (1, 2, 3)

Индексация

Numpy определяет очень сложные правила индексации. УвидетьNumpy Indexing GuideПолем Обратите внимание на использование массивов ND в качестве индексов ниже.

x = tnp.arange(24).reshape(2, 3, 4)

print("Basic indexing")

print(x[1, tnp.newaxis, 1:3, ...], "\n")

print("Boolean indexing")

print(x[:, (True, False, True)], "\n")

print("Advanced indexing")

print(x[1, (0, 0, 1), tnp.asarray([0, 1, 1])])

Basic indexing

tf.Tensor(

[[[16 17 18 19]

[20 21 22 23]]], shape=(1, 2, 4), dtype=int64)

Boolean indexing

tf.Tensor(

[[[ 0 1 2 3]

[ 8 9 10 11]]

[[12 13 14 15]

[20 21 22 23]]], shape=(2, 2, 4), dtype=int64)

Advanced indexing

tf.Tensor([12 13 17], shape=(3,), dtype=int64)

# Mutation is currently not supported

try:

tnp.arange(6)[1] = -1

except TypeError:

print("Currently, TensorFlow NumPy does not support mutation.")

Currently, TensorFlow NumPy does not support mutation.

Пример модель

Далее вы можете увидеть, как создать модель и выполнить вывод на нее. Эта простая модель применяет Relu -слой, за которым следует линейная проекция. Более поздние разделы покажут, как вычислить градиенты для этой модели, используя Tensorflow'sGradientTapeПолем

class Model(object):

"""Model with a dense and a linear layer."""

def __init__(self):

self.weights = None

def predict(self, inputs):

if self.weights is None:

size = inputs.shape[1]

# Note that type `tnp.float32` is used for performance.

stddev = tnp.sqrt(size).astype(tnp.float32)

w1 = tnp.random.randn(size, 64).astype(tnp.float32) / stddev

bias = tnp.random.randn(64).astype(tnp.float32)

w2 = tnp.random.randn(64, 2).astype(tnp.float32) / 8

self.weights = (w1, bias, w2)

else:

w1, bias, w2 = self.weights

y = tnp.matmul(inputs, w1) + bias

y = tnp.maximum(y, 0) # Relu

return tnp.matmul(y, w2) # Linear projection

model = Model()

# Create input data and compute predictions.

print(model.predict(tnp.ones([2, 32], dtype=tnp.float32)))

tf.Tensor(

[[-0.8292594 0.75780904]

[-0.8292594 0.75780904]], shape=(2, 2), dtype=float32)

Tensorflow numpy и numpy

Tensorflow Numpy реализует подмножество полной Numpy Spec. Хотя с течением времени будет добавлено больше символов, существуют систематические функции, которые не будут поддерживаться в ближайшем будущем. К ним относятся поддержка Numpy C API, интеграция SWIG, заказ на хранение Fortran, просмотры иstride_tricksи некоторыеdtypeS (какnp.recarrayиnp.object) Для получения более подробной информации см.Tensorflow Numpy API документацияПолем

Numpy Feetworkabity

Массивы Tensorflow ND могут взаимодействовать с функциями Numpy. Эти объекты реализуют__array__интерфейс. Numpy использует этот интерфейс для преобразования аргументов функций вnp.ndarrayценности перед их обработкой.

Точно так же функции Tensorflow Numpy могут принимать входные данные различных типов, включаяnp.ndarrayПолем Эти входы преобразуются в массив ND, вызываяndarray.asarrayна них.

Преобразование массива ND в и обратноnp.ndarrayможет вызвать фактические копии данных. Пожалуйста, смотрите раздел обуферные копииДля получения более подробной информации.

# ND array passed into NumPy function.

np_sum = np.sum(tnp.ones([2, 3]))

print("sum = %s. Class: %s" % (float(np_sum), np_sum.__class__))

# `np.ndarray` passed into TensorFlow NumPy function.

tnp_sum = tnp.sum(np.ones([2, 3]))

print("sum = %s. Class: %s" % (float(tnp_sum), tnp_sum.__class__))

sum = 6.0. Class: <class 'numpy.float64'>

sum = 6.0. Class: <class 'tensorflow.python.framework.ops.EagerTensor'>

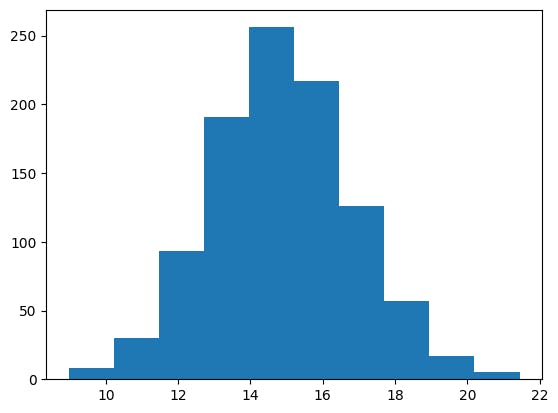

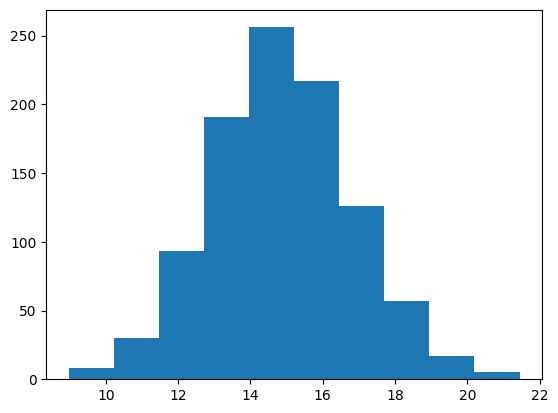

# It is easy to plot ND arrays, given the __array__ interface.

labels = 15 + 2 * tnp.random.randn(1, 1000)

_ = plt.hist(labels)

Буферные копии

Смешание Tensorflow Numpy с кодом Numpy может запускать копии данных. Это связано с тем, что Tensorflow Numpy имеет более строгие требования к выравниванию памяти, чем у Numpy.

Когда аnp.ndarrayпередается в Tensorflow Numpy, он проверит требования выравнивания и при необходимости запустит копию. При передаче буфера процессора ND массива в Numpy, как правило, буфер будет удовлетворять требованиям выравнивания, а Numpy не нужно будет создавать копию.

Массивы ND могут ссылаться на буферы, размещенные на устройствах, отличных от локальной памяти процессора. В таких случаях вызывание функции Numpy вызовет копии по всей сети или устройству по мере необходимости.

Учитывая это, смешивание с вызовами Numpy API, как правило, следует делать с осторожностью, и пользователь должен следить за накладными расходами на копирование данных. Червейные вызовы Numpy Tensorflow с вызовами TensorFlow, как правило, безопасны и избегают копирования данных. См. Раздел оTensorflow FeelsectionbilityДля получения более подробной информации.

Приоритет оператора

Tensorflow Numpy определяет__array_priority__выше, чем у Нампи. Это означает, что для операторов, включающих как nd массив, так иnp.ndarrayПервый будет иметь приоритет, то есть,np.ndarrayВход будет преобразован в ND -массив, и реализация Tensorflow Numpy будет вызвана.

x = tnp.ones([2]) + np.ones([2])

print("x = %s\nclass = %s" % (x, x.__class__))

x = tf.Tensor([2. 2.], shape=(2,), dtype=float64)

class = <class 'tensorflow.python.framework.ops.EagerTensor'>

Первоначально опубликовано на

Оригинал