Связанная работа: Законы масштабирования и модели Hopfield в исследованиях LLM

19 июня 2025 г.Таблица ссылок

Аннотация и 1 введение

2 Связанная работа

3 модели и 3.1 ассоциативные воспоминания

3.2 трансформаторные блоки

4 Новая энергетическая функция

4.1 Слоистая структура

5 Потеря по перекрестной энтропии

6 Эмпирические результаты и 6.1 Эмпирическая оценка радиуса

6.2 Обучение GPT-2

6.3 Тренировка ванильных трансформаторов

7 Заключение и подтверждение

Приложение A. отложенные таблицы

Приложение B. Некоторые свойства энергетических функций

Приложение C. отложенные доказательства из раздела 5

Приложение D. Трансформатор Подробности: Использование GPT-2 в качестве примера

Ссылки

2 Связанная работа

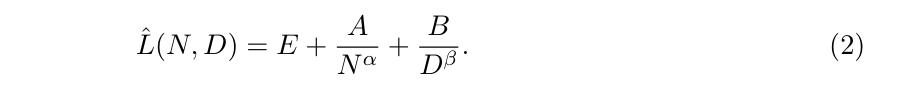

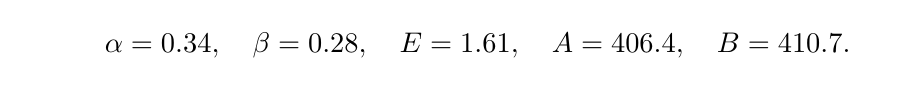

Масштабирование законовКак обсуждалось во введении, мы видели последовательные эмпирические данные о том, что производительность моделей увеличивается как размер моделей и объем учебных данных масштабирования (Kaplan et al., 2020; Khandelwal et al., 2019; Rae et al., 2021; Chowdhery et al., 2023). Были также проведены интенсивные эксперименты для изучения законов о масштабировании нейронного масштаба в различных условиях, включая ограничения на вычислительный бюджет (Hoffmann et al., 2022b), данные (Muennigoff et al., 2024) и случаи чрезмерного обучения (Gadre et al., 2024). В этом анализе используется разложение ожидаемого риска, что приводит к следующему соответствию:

Для моделей Chinchilla приспособленными параметрами являются (Hoffmann et al., 2022a)

Линия исследований касается обобщения чрезмерных нейронных сетей (Belkin et al., 2019; Nakkiran et al., 2021; Power et al., 2022). Недавние эксперименты показывают, что чрезмерные трансформаторы демонстрируют инвертированное U-образное масштабирование поведения (Murty et al., 2023), которое не может быть объяснено эмпирическими законами масштабирования.

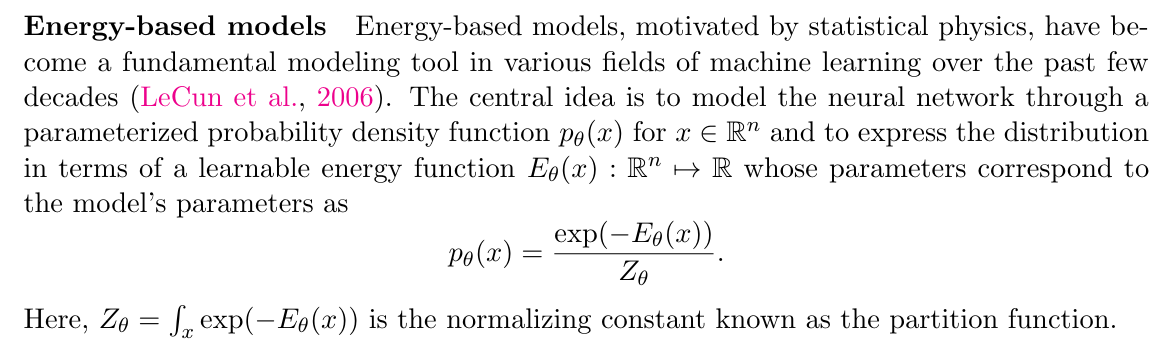

Хопфилд моделиКлассические сети Hopfield Networks (Amari, 1972; Hopfield, 1982) были представлены в качестве парадигматических примеров ассоциативной памяти. Динамика обновления сети определяет энергетическую функцию, чьи фиксированные точки соответствуют хранимым воспоминаниям. Важным показателем является количество шаблонов, которые модель может запомнить, известные как емкость сети. Модификации на энергетическую функцию (Krotov and Hopfield, 2016; Demircigil et al., 2017) приводят к более высоким возможностям хранения (см. Таблицу 1 в Приложении A). Оригинальная модель работает на двоичных переменных. Современная непрерывная сеть Hopfield (MCHN) (Ramsauer et al., 2020) обобщает модель Hopfield для непрерывного домена, что делает ее привлекательным инструментом для понимания механизма внимания в трансформаторах, который также принимает векторные встраивания в реальную область в качестве входных данных. Учитывая вход (например, подсказка), слой хопфилда извлекает память, сходившись к локальному минимуму энергетического ландшафта, и правило обновления имеет хорошее соответствие механизму значений запросов в внимании. Кротов (2021) предлагает модель иерархической ассоциативной памяти (HAM), которая позволяет описанию нейронной сети с глобальной энергетической функцией, в отличие от энергетических функций для отдельных слоев.

Авторы:

(1) Xueyan Niu, Theory Laboratory, Central Research Institute, 2012 Laboratories, Huawei Technologies Co., Ltd.;

(2) Бо Бай Байбо (8@huawei.com);

(3) Lei Deng (deng.lei2@huawei.com);

(4) Вэй Хан (harvey.hanwei@huawei.com).

Эта статья есть

Оригинал