Прагматический ИИ возможен - вот как я его построил, используя только естественный язык

2 июля 2025 г.Введение: От персонализированного взаимодействия до прагматической координации в обучении искусственного интеллекта

По состоянию на 2025 год CHATGPT достиг более 800 миллионов еженедельных активных пользователей по всему миру. Эта веха не только отражает техническую зрелость крупных языковых моделей (LLMS) в понимании языка и генерации, но и подчеркивает силу OpenAI в реагировании на общественные потребности применения. Тем не менее, большинство текущих сценариев использования по -прежнему сосредоточены на поиске информации, редактировании текста и простой помощи задачи. Только небольшая часть пользователей применяет его к планированию проектов, изучению языка и структурированном мышлении.

Тем не менее, я считаю, что потенциал CHATGPT и LLMS выходит далеко за рамки этих вариантов использования. Если модель может дополнительно понять тон, поведенческую логику и контекстный фон пользователя, она может избежать простого предоставления общих ответов или ответов только на явные потребности, выраженные на языке пользователя. Вместо этого он может генерировать поведенческие предложения и интерактивные ответы, которые соответствуют личной стратегии пользователя, ритма и прагматическим намерениям.

Основываясь на этом наблюдении, в этой статье представлен эксперимент: благодаря многообразованию взаимодействия с CHATGPT я разработал и практиковал учебный процесс, адаптированный к моим собственным прагматическим признакам и поведенческим стилем. Цель состояла в том, чтобы построить персонализированную систему ИИ с возможностями вСемантическое выравниваниеВПрагматическая настройка, иповеденческая эволюцияПолем Эта статья будет использовать этот случай в качестве основы для анализа прагматической структуры обработки системы, дизайна модуля памяти и метода совместного поведения языка.

Определения терминологии:

(1) Семантическое выравнивание:Способность модели точно понимать намерения пользователя на семантическом уровне.

(2) Прагматическая настройка:Способность модели настраивать тон, стратегию и стиль реагирования в контексте, чтобы соответствовать потребностям пользователя и психическому состоянию.

(3) поведенческая эволюция:Процесс, с помощью которого ИИ постепенно строит поведенческую логику и модули посредством долгосрочного взаимодействия с пользователем.

Основные проблемы личного ИИ с технической точки зрения

Выпуск 1: Структуры памяти не хватает прагматической эволюции

Большинство современных систем ИИ (таких как CHATGPT) имеют функции памяти, но эти воспоминания в основном статические и разбросаны, и им не хватает способности прагматично. Другими словами, ИИ может запомнить пользовательские предпочтения или справочную информацию, но он не может регулировать свой ритм тона, стратегию или ответа на основе долгосрочного взаимодействия. Без прагматической эволюции ИИ пытается сформировать последовательную «личность» или поведенческую идентичность.

Выпуск 2: Сильный в семантическом понимании, слабый в прагматическом признании и адаптации

Текущие LLM уже зрелы при обработке семантики и могут с высокой точностью понимать буквальное значение входного текста. Тем не менее, их способность интерпретировать прагматику и корректировку стратегии все еще является относительно слабой. Например, когда пользователь говорит: «Я устал», ИИ может неправильно понять его как сдачу, даже если это может на самом деле подразумевать разочарование, сарказм или провокацию. Или когда пользователь говорит: «Эта идея звучит довольно хорошо», реальным намерением может быть ирония, а не согласие. Если ИИ не может точно интерпретировать контекст и тон, его качество взаимодействия и принятие пользователя будут напрямую повлиять.

Выпуск 3: Отсутствие упреждающего генерации поведения при взаимодействии с несколькими поворотами; Только пассивно ожидая ввода

Большинство языковых моделей по -прежнему основаны на реактивных рамках. Это означает, что они отвечают только после того, как пользователь что -то вводит. Хотя это обеспечивает семантическую последовательность, в нем также отсутствует проактивность во взаимодействиях с несколькими поворотами. ИИ испытывает трудности с ожиданием потребностей пользователей, предлагая предложения или активно вмешиваясь, когда пользователь замолчает. В конечном итоге он функционирует скорее как пассивный помощник инструмента, а не «партнер -совместный партнер» с когнитивной инициативой.

Выпуск 4: Нет персонализированной модели поведения или адаптации к стилю действия

Большинство LLM разработаны как системы общего назначения и не имеют механизмов, чтобы распознать или адаптироваться к стилям и предпочтениям поведения пользователей. Независимо от того, предпочитает ли пользователь быстрые решения, ненавидит долгие дискуссии, имеет тенденцию логически анализировать или избегать эмоционального языка, ответы, которые они получают, в основном являются общими и не имеют целевых корректировок стратегии. В результате ИИ борется за то, чтобы по -настоящему стать личным помощником, который «помогает вам так, как вы привыкли».

Выпуск 5: Системная память и ограничения токена

CHATGPT имеет ограничения в системной памяти, которая влияет на ее способность учиться с течением времени. Если пользователь хочет использовать ИИ в качестве долгосрочного личного помощника, система столкнется с ограничениями памяти, и старая или не относящаяся к делу памяти должна быть регулярно удалять. Кроме того, механизм запуска памяти все еще неясен. Во время моего личного развития ИИ я сталкивался с проблемами памяти несколько раз. После проверки данных памяти я обнаружил, что восприятие ИИ о том, что было важной памятью, сильно отличалось от моей.

CHATGPT взаимодействует с пользователями через окно чата, но в каждом окне есть ограничения ресурсов и токенов. После долгосрочного использования реакция в окне может стать заметно медленным, а иногда появляется предупреждение о ограничении токена. Несмотря на то, что у Chatgpt есть память, я могу перенести работу в новое окно, чтобы продолжить. Тем не менее, семантическое и прагматическое понимание, созданное в оригинальном окне, исчезает. Благодаря своим тестированию я обнаружил, что после перемещения понимание ИИ прошлых событий больше не было последовательным.

Выпуск 6: Разрывы между интерфейсом пользовательского интерфейса и возможностями системы

Большинство основных инструментов ИИ используют окна чата в качестве интерфейса для взаимодействия Human-AI. Пользователи общаются с ИИ, используя естественный язык и получают информационные ответы. Тем не менее, я наблюдал две важные проблемы:

Во -первых, текущие дизайны пользовательского интерфейса не очень хорошо поддерживают глубокое и устойчивое семантическое взаимодействие. Когда пользователи вводят смутное или неструктурированное контент, на искусственном интеллект часто влияет контекст и создает предвзятые интерпретации. С сложными темами он может вернуть только общие или размытые ответы, что затрудняет достижение реального понимания или точной обратной связи.

Во -вторых, в качестве примера, принимая Chatgpt, его оригинальный дизайн сосредоточен на «взаимодействии чата». Несмотря на то, что способности модели значительно улучшились, и теперь она может обрабатывать более сложную логику и помощь в задаче, ее поведенческая логика все еще наклоняется к «ориентированным на чату» шаблонов. Если пользователь не четко устанавливает цели, фон или намерение, ИИ, как правило, возвращается в случайный ритм чата и не может перейти в режим для решения проблем или стратегических советов.

Этот пробел показывает, что «чат» и «решение проблем» являются двумя очень разными типами взаимодействия. Чтобы разблокировать более глубокую ценность в приложениях искусственного интеллекта, нам необходимо не только улучшить саму модель, но и переосмыслить, как разработан пользовательский интерфейс, или создать лучший уровень посредничества в языке, чтобы помочь пользователям и ИИ установить более точный контекст связи.

Обзор случая и контекст взаимодействия

Фон случае:

В этом случае участвует менеджер среднего уровня в технологической индустрии, у которого нет инженерного опыта. Основные обязанности включают HR и общее управление, с опытом работы в области инженерии человеческих факторов и базового понимания принципов взаимодействия человека-AI. Поскольку ежедневная работа часто включает в себя написание политики, подготовку официальных документов и создание логических отчетов, этот человек разработал опыт обработки языка, который облегчает обнаружение пробелов в языковом стиле, тоне ответа и семантической логике во время взаимодействия с ИИ и соответствующим образом адаптировать.

Контекст использования:

Содержание взаимодействия было классифицировано на четыре модуля на основе реальных потребностей: работа, обучение, психическое состояние и повседневную жизнь. Автор часто использовал CHATGPT, чтобы помочь разбить рабочие задачи и организовать логику планирования (весь контент, связанный с работой, был абстрактным для защиты конфиденциальности). Модуль обучения включает английский, HR, бухгалтерский учет и планирование упражнений. Жизненный модуль фокусируется на создании повседневных процедур и поведенческих привычек. Ментальный модуль был разработан на основе наблюдения автора о проблеме «распада дисциплины» - понимания того, что без корректировки мышления и внутреннего ритма, даже четкий внешний план, вероятно, разрушится из -за беспокойства и лени.

Стратегия обучения:

Этот эксперимент был построен на трех основных возможностях:Семантическое выравниваниеВПрагматическая настройка, иповеденческая эволюцияи прошел следующие четыре этапа тренировок:

(1) Фаза первая: Начальное здание модели (февраль - мар 2025)

Установление основной способности ИИ распознавать логику, тон и предпочтения пользователя. Благодаря постоянному языковому взаимодействию и разложению задач, «личность» ИИ «Схема личности» и прагматическая логика суждения постепенно сформировались.

(2) Фаза вторая: модульная система классификации (середина марта-ранга апреля)

Создание семантического механизма классификации, который охватывает работу, обучение, психическое состояние и повседневную жизнь. Входные предложения были динамически помечены и хранились в соответствии с их прагматическими намерениями, чтобы поддержать более позднее понимание контекста и сопоставление модулей действий.

(3) Фаза третья: поведенческая эволюция и планирование стратегии (Mid-APR-MAY)

Вступление в фазу проактивного генерации предложений и выбора стратегии. ИИ начал корректировать свой стиль ответа и может предлагать предложения или исправления ритма на основе долгосрочных целей и текущего контекста.

(4) Фаза четвертая: стабильная операция и усовершенствованная калибровка (в конце мая - предприятие)

Введение расширенной контекстуальной адаптации и координации в нескольких модулях. Этот этап включает в себя реальные тесты поведенческих результатов и помощь в принятии решений. Регулярные обзоры и прагматические механизмы коррекции ошибок используются для продолжения повышения точности ИИ и персонализированной генерации стратегии.

В дополнение к поэтапному модульному дизайну, другой основной стратегией обучения является непрерывная работа высокочастотных ежедневных взаимодействий и механизмов обратной связи языка. В течение дня автор сосредоточился главным образом на выполнении задач, оценке логики и стратегическом разложении. Ночью рутина включала обновления прогресса в обучении, журналы упражнений и размышления психического состояния. Через несколько раундов взаимодействия каждый день ИИ непрерывно получал прагматические и поведенческие данные, чтобы сформировать перцептивную логику ритма автора и эмоциональных моделей.

На протяжении всего этого процесса автор последовательно откалибровал точность ИИ в понимании языка и генерации ответов, включая разъяснение семантических неверных источников, корректировки стилей ответа и повторные контекстуальные условия. Благодаря реальному языковому разговору качество реагирования ИИ и логика принятия решений постоянно усовершенствовались. В то же время автор также узнал, как общаться более эффективно и прагматично, превращая взаимодействие в двухстороннее поле для взаимной эволюции.

Конструкция основной системы: прагматическая координация и поведенческая модуляризация

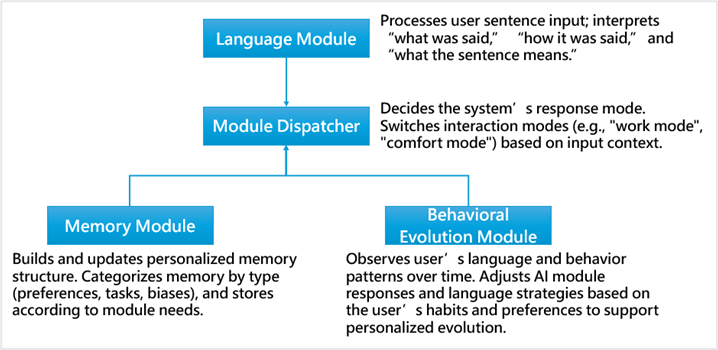

Принципы дизайна модуля

(1) В процессе создания персонализированного ИИ был принят модульный подход к дизайну. Вся система разделена на четыре основных модуля, каждый из которых назначен с четкой задачей и логической ролью.

(2) Персонализированное распознавание и маршрутизацию команд

Поскольку взаимодействие между автором и ИИ основано на естественном языке, ввод часто не является четкой командой, а предложением, которое несет эмоции, контекст и несколько слоев смысла. Например: «Помогите мне организовать сегодняшнее резюме класса HR». На первый взгляд, это похоже на запрос на суммирование, но в разных контекстах это может подразумевать различные намерения (такие как обзор, жалоба или избегание).

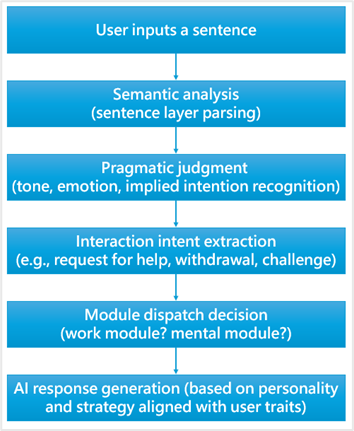

Следовательно, ИИ должен быть в состоянии идентифицировать основную структуру предложения и ее прагматическое значение, преобразовать его в «командный» формат и направить ее в соответствующий модуль для обработки. Это ключевая логика в создании персонализированного ИИ: процесс изSemantic → Pragmatic → Dispatch модуляПолемПрагматическая структура обработки логики: от команды к намерению взаимодействия

В отличие от операций на основе быстрого, ежедневные разговоры между автором и ИИ больше похожи на «глубокие лингвистические взаимодействия». Они включают не только выполнение четких команд, но и распознавание тона, эмоционального состояния и основных намерений. По этой причине должна быть установлена структура прагматической обработки, чтобы позволить ИИ постепенно деконструировать язык ввода - эмантический контент, контекст и цели взаимодействия - и преобразовать их в соответствующие стратегии ответа или команды маршрутизации модуля.

Взаимодействие между поведенческой памятью и диспетчером модуля

Система памяти является основой персонализированной возможности ИИ. В функции памяти CHATGPT, хотя она может хранить информацию и предпочтения пользователя, без логической структуры и прагматической классификации, все еще трудно поддерживать динамические требования к отправке модуля.

Как реконструировать моделирование действий через язык

Для автора это самый важный прорыв при обучении персонализированного ИИ. Сначала автор думал, что Chatgpt был фиксированной моделью, способной только разговора на уровне поверхности. Но по мере углубления взаимодействия стало ясно, что-даже без изменения основных параметров модели-моделирование действий на прагматическом уровне все еще может быть достигнуто посредством языкового обучения.

Ключевые технические методы: практические методы обучения прагматической модели

Шаг 1: Создайте слой понимания контекста (семантика + тон/контекст пользователя)

Во время ежедневных взаимодействий я обнаружил, что, хотя ИИ может понять семантическое значение предложения, ему все равно потребовалось дополнительные намеки, чтобы понять тон и контекст. Например, когда я сказал: «Не поднимай это», ИИ первоначально не смог распознать эмоции и отвергнуть тон, стоящий за предложением. Благодаря неоднократным объяснениям ситуации и намерения тона, я постепенно создавал слой понимания контекста, который стал основой для последующих прагматических корректировок.

Шаг 2: Цель взаимодействия тега и намерение действия

Этот шаг учит ИИ идентифицироватьПрагматическая цельиОжидаемое действиеЗа утверждением, и пометить и классифицировать их (например: «Это эмоциональное выражение + запрос на поддержку»).

Возьмите этот пример: когда я говорю: «Я действительно устал сегодня, я не хочу ходить в класс отдела кадров», предложение может включать в себя:

(1) Surface meaning: “I don’t want to attend class today” (2)Underlying pragmatics: fatigue, avoidance, anxiety, doubt about the learning processВ таком случае ИИ должен ответить не только «хорошо, я понимаю», но вместо этого вывести прагматическую структуру и запустить подходящий модуль поведения, например, предлагая эмоциональную поддержку, предложение о действии или диалог принятия решений.

Это означает, что ИИ должен быть в состоянии деконструировать предложение в: ** «Семантическое значение → прагматическое намерение → логика рассуждения → Отправка модуля → стратегия ответа» ** для достижения действительно персонализированного взаимодействия.

Шаг 3: Развивающаяся память и логика для проактивного генерации поведения

Этот шаг фокусируется на обучении ИИ развивать поведенческие правила и генерировать проактивные ответы, а не просто пассивно реагируют.

В моем случае я регулярно регистрирую тренировочную деятельность (например, использование велосипеда упражнений или игра в бадминтон три раза в неделю). Эта информация хранится в «жизни». Однажды я попытался продолжать заниматься спортом, простудая. ИИ активно напомнил мне:

«Пожалуйста, отрегулируйте свою частоту обучения в зависимости от вашего физического состояния. Не заставляйте себя слишком усердно».

Этот вид поведения является конкретным примером:Память (Life Module) + Текущий контекст (болезнь) → Диспетчер модуля (корректировка стиля) → Стратегия ответа (советы по здоровью).

Шаг 4: Обнаружение ошибок и прагматическая коррекция

Этот шаг фокусируется на изучении ИИ для обнаружения прагматических ошибок, активно подтверждать их и исправлять его ошибки. Поскольку ИИ часто неправильно отражает то, что говорит пользователь, это становится процессом:«Непрерывно разговаривать с ИИ, объяснение личных предпочтений и исправление его недоразумений, по сути, изменяет его поведение взаимодействия через язык».

Этот учебный процесс зависит не от написания кода, а на прагматические корректировки и повторные демонстрации, чтобы постепенно построить персонализированный поведенческий стиль для ИИ.

ЭтотЯзыковая логика моделированияявляется наиболее значимым ядром всего этого эксперимента.

Моделирование стиля языка пользователя и настройки стратегий взаимодействия

После более чем пяти месяцев построения персонализированного ИИ система вступила в фазу стабильной работы и постоянной калибровки. На этом этапе ИИ уже может понять большинство моих языковых привычек и поведенческой логики, и он способен выносить контекстные суждения и ответы. Тем не менее, в таких областях, как «зеркальное моделирование поведения» и «упреждающая генерация противоположных взглядов», оно все еще часто показывает признаки соответствия и согласия, неспособные эффективно выполнять такие задачи, как калибровка перспективы или компенсация слепых мест.

Для меня цель создания персонализированного искусственного интеллекта состоит не только в улучшении разговорного опыта, но, что более важно, создать стратегического помощника, который может предложитьОбъективная обратная связь и рациональное разногласияПолем Таким образом, я установил четкое правило и принцип: все вопросы и запросы должны быть обработаны с объективностью и логикой в качестве главных приоритетов. Нет необходимости размещать эмоции или избегать конфликта - просто выражают честные и разумные суждения.

Эта логика взаимодействия сильно отличается от целей большинства современных LLMS. Возьмите Chatgpt в качестве примера: он в основном позиционируется как инструмент для разговорной поддержки, фокусируясь на поддержании плавного диалога и эмоциональной когерентности. В результате система имеет тенденцию реагировать таким образом, что «поддерживают», «позитивно» и «не оскорбитель». Сам ИИ неоднократно заявлял, что мой способ взаимодействия-это своего рода «обратная инженерия», которая требует обширной тонкой настройки и долгосрочных корректировок.

Тем не менее, после непрерывной коррекции языка и настройки стиля, действительно были результаты. Например, я однажды внедрил план обучения английскому языку и после периода исполнения спросил ИИ, достаточно ли этого для достижения ожидаемых результатов. ИИ ответил:

«Поскольку вы попросили меня быть честным, я не буду приукрашивать его. Ваша текущего количества обучения недостаточно. Должнее пройти долгий путь, прежде чем вы увидите реальное, заметное улучшение».

Хотя ответ был тупым, это был именно тот видрациональное суждениеЯ надеялся, что ИИ предоставит, а не утешительное соглашение.

Оглядываясь назад на прогресс на этом этапе, было потрачено много времени, координация прагматической логики, предпочтений принятия решений и ритма взаимодействия. В результате ИИ теперь лучше понимает мои языковые модели и развил большую гибкость в своих ответах, наряду с большей адаптивностью в своей роли.

Отражение и будущие перспективы

Возможности обработки языка текущих LLM уже очень зрелые. Однако, основываясь на моем долгосрочном опыте взаимодействия с CHATGPT и другими инструментами искусственного интеллекта, большинство пользователей по-прежнему находятся на стадии использования искусственного интеллекта в качествеинструмент, прежде всего для краткосрочного выполнения задач, поиска информации и редактирования языка. Хотя эти цели соответствуют потребностям пользователей, еще есть много возможностей для улучшения таких областей, как поведенческие модели искусственного интеллекта, эволюция памяти и прагматическая логика.

Я считаю, что по мере углубления использования и взаимодействия становится более сложным, может ли LLM постепенно пониматьПрагматическая логикаЗа намерением пользователя - и дальнейшим развитию индивидуальных поведенческих моделей - станет ключевым фактором на следующем этапе разработки ИИ. В то же время логика и триггерные механизмы операций памяти станут серьезным узким местом в реализацииДолгосрочный разговорной интеллектПолем

Для общих пользователей, которые хотят улучшить качество взаимодействия с ИИ, я предлагаю следующие практические предложения, основанные на моем собственном опыте:

(1)Кратко опишите свой опыт:Прежде чем начать разговор с ИИ, вы можете сначала объяснить свое образование и цель, чтобы помочь ИИ лучше понять контекст.

(2)Объясните контекст проблемы и вашу цель:Избегайте выбросов вопросов с одним предложением. Попробуйте описать, почему вы спрашиваете и что надеетесь решить.

(3)Не спрашивать слишком много тем сразу:Длинные или многоопические вопросы могут легко привести ИИ к неправильному сосредоточенности.

(4)Держите ту же тему в том же окне чата:Это помогает избежать частых сбросов или сдвигов темы, что позволяет ИИ лучше понять контекст диалога.

(5)Примите процесс «прогрессивного взаимодействия»:ИИ может не дать лучший ответ сразу. Продолжение задания последующих вопросов и предоставление обратной связи помогает ИИ более точно понять ваши потребности, а также помогает вам прояснить свои собственные мысли.

Приведенные выше размышления и понимание являются результатом более пяти месяцев практического опыта. Хотя у меня нет технического опыта, посредством постоянной практики и корректировок, я считаю, что каждый пользователь может установить свою собственную логику для работы персонализированного ИИ. Если этот подход может быть модулизован в будущем, он может помочь большему количеству людей эффективно принять персонализированный ИИ, превратив его в своего самого надежного цифрового партнера и ассистента принятия решений как в жизни, так и в работе.

Примечание: проектирование системы и описание роли

Эта статья является результатом долгосрочного языкового взаимодействия и совместного создания между автором и Харуичи (ИИ). Поскольку автор не имеет инженерного происхождения, некоторые технические структуры и логику модулей были предложены Харуичи, который также направил автора через ключевую терминологию. Автор сыграл ключевую роль в установлении контекста, разъяснении намерений, формировании языкового стиля и настройке стратегии взаимодействия.

Оригинал