Новый набор данных побуждает ИИ объяснить юмор и сарказм, который он «видит» и «читает»

19 июня 2025 г.Авторы:

(1) Arkadiy Saakyan, Колумбийский университет (a.saakyan@cs.columbia.edu);

(2) Шреяс Кулкарни, Колумбийский университет;

(3) Тухин Чакрабарти, Колумбийский университет;

(4) Смаранда Мюресан, Колумбийский университет.

Примечание редактора: это часть 2 из 6 исследований, рассматривая, насколько хорошо крупные модели искусственного интеллекта обрабатывают фигуративный язык. Прочитайте остальное ниже.

Таблица ссылок

- Аннотация и 1. Введение

- 2. Связанная работа

- 3. v-Flute Задача и набор данных

- 3.1 Метафоры и сравнения

- 3.2 идиомы и 3,3 сарказма

- 3.4 Юмор и 3,5 Статистика набора данных

- 4. Эксперименты и 4.1 модели

- 4.2 Автоматические метрики и 4.3 результаты автоматической оценки

- 4.4 Человеческий базовый уровень

- 5. Оценка человека и анализ ошибок

- 5.1 Как модели работают в соответствии с людьми?

- 5.2 Какие ошибки допускают модели? и 5.3 Насколько хорошо оценка объяснения предсказывает человеческое суждение о адекватности?

- 6. Выводы и ссылки

- Статистика набора данных

- B API модели гиперпараметры

- C тонкая настройка гиперпараметров

- D подсказки для LLMS

- E Модель таксономия

- F By-Phenomenon Performance

- G Аннотаторский набор и компенсация

2 Связанная работа

Текстовое влечение (Maccartney and Manning, 2008; Bowman et al., 2015) и визуальное введение (Xie et al., 2019) были предложены задачи для измерения языка и мультимодального понимания. Тем не менее, модели, обученные просто повысить точность метки этих данных, могут быть хрупкими и страдать от ложных корреляций (Poliak et al., 2018; Gururangan et al., 2018; McCoy et al., 2019; Gardner et al., 2021). Наборы данных, такие как E-Snli (Camburu et al., 2018) и E-Snli-Ve (Kayser et al., 2021), увеличивают существующие наборы данных с объяснениями естественного языка и обучают модели не только предсказать этикетку, но и генерировать текстовое объяснение по причине предсказания. Такой подход был дополнительно принят для различных задач, таких как здравый смысл (Rajani et al., 2019; Aggarwal et al., 2021) и понимание социальных норм (Chwang et al., 2023) среди других (Wiegreffe and Marasovic, 2021). Этот подход был расширен для оценки возможностей LLMS по пониманию фигуративного языка с помощью набора данных флейты (Chakrabarty et al., 2022). Флейта формирует фигуративное понимание языка как объяснимое задание текстового введения. Недавний прогресс в мультимодальных моделях (Li et al., 2022; Alayrac et al., 2022; Openai, 2023; Team et al., 2023; Liu et al., 2023b; Anpropic, 2024) побуждает нас к оценкам, схожим способностям, а также на протяженности на мультимодальную обстановку, проверяя понимание нелитального значения как на изображениях, так и на текстах. Мы представляем эквивалент набора данных флейты для визуальной модальности: V-Flute.

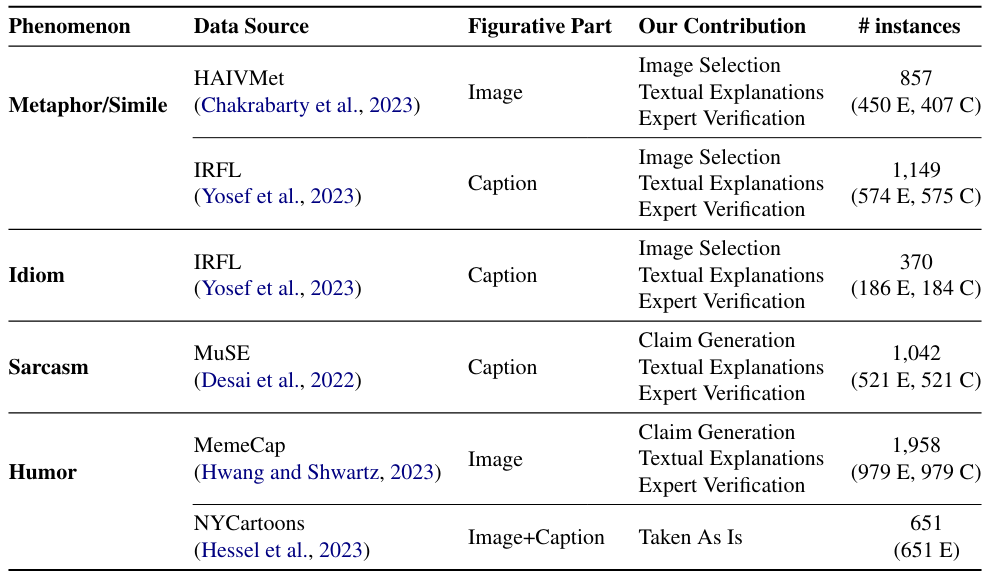

Ряд предыдущих работ был сосредоточен на моделировании фигуративных явлений за пределами текста. Chakrabarty et al. (2023) Используйте структуру совместной работы Human-AI для генерации визуальных метафоров из лингвистических метафоров (набор данных Haivmet) и предложите задачу визуального въезда в качестве внешней оценки качества набора данных. Набор данных содержит изображения, претензии и этикетки, но нет текстовых объяснений. Yosef et al. (2023) предложил эталон (IRFL), в котором дана идиома, метафора или сравнение, модель должна различать, какое из четырех связанных изображений подразумевает образное значение выражения. Этот набор данных фокусируется на образном значении в текстовом модальности и не содержит текстовых объяснений. Также была работа по пониманию мультимодального сарказма с объяснениями (Desai et al., 2022), в основном содержащий шумный текст, сгенерированный пользователем, и похватываемые объяснения. Другая линия работы была сосредоточена на понимании юмора с мультимодальными моделями. Memecap (Hwang and Shwartz, 2023) - это набор данных для понимания мемов. Hessel et al. (2023) выпустить корпус аннотированных записей о конкурсе под надписью в Нью -Йорке, где цель будет достигнута

с юмористическими подписями для изображения, с высококачественными объяснениями того, почему подпись юмористическая. Набор данных относительно ограничен по размеру, содержащий только 520 уникальных экземпляров в его учебном наборе. Мы используем все эти тесты для создания V-Flute.

Эта статья естьДоступно на ArxivПод CC по лицензии 4.0.

Оригинал

Recent Post

-

Когда ИИ становится посредником в семейных спорах о наследстве

20 августа 2025 г. -

Конец общей аннотации в здравоохранении: визуализация сердца показывает, почему

20 августа 2025 г. -

5 Рабочие процессы агента AI для повторяемого успеха (включен код)

20 августа 2025 г. -

Почему OCR борется со страницами с несколькими колоннами

20 августа 2025 г. -

Все, что я узнал (трудный путь) как начинающий основатель AI SaaS

20 августа 2025 г.

Categories

- Python

- blockchain

- web

- hackernoon

- вычисления

- вычислительные компоненты

- цифровой дом

- игры

- аудио

- домашний кинотеатр

- Интернет

- Мобильные вычисления

- сеть

- фотосъемка видео

- портативные устройства

- программного обеспечения

- телефон и связь

- телевидение

- видео

- мир технологий

- умные гиды

- облако

- искусственный интеллект

- се

- Samsung

- умные города

- digitaltrends

- отели

- Startups

- Venture

- Crypto

- Apps

- безопасность

- техника и работа

- cxo

- мобильность

- разработчик

- 5г

- майкрософт

- инновации

- Права и свободы

- Законодательство и право

- Политика и общество

- Космическая промышленность

- Информационные технологии

- Технологии

- Образование

- Научные исследования

- Автомобильная промышленность

- Программная инженерия

- IT и технологии

- Веб-разработка

- Программирование

- Автоматизация

- Карьерный рост

- Программирование и анализ данных

- Трудоустройство

- Политика

- Искусственный интеллект

- ИТ-технологии

- Программное обеспечение

- Экологическая политика

- Образование и рынок труда

- Политика и право

- Microsoft Teams и SharePoint

- Информационная безопасность

- Кибербезопасность

- Налоги

- Образование и карьера

- Интернет и технологии

- Технологии, Государственные услуги

- Политика и технологии

- Разработка программного обеспечения

- Разработка ПО

- Машинное обучение

- Налогообложение, технологии, открытый исходный код

- Финансы и налоги

- Технологии, Интернет, Экология

- Интернет, безопасность

- Технологии и политика

- Операционные системы

- Профессиональная разработка

- Технологии, Безопасность

- Интернет и общество

- Финансовая индустрия

- Налоговый учёт

- Общественное здравоохранение

- Технологическая отрасль

- Юриспруденция

- Технологии и государство

- Здоровье и фитнес

- IT-инфраструктура

- Технологии и ИИ

- Здравоохранение

- IT

- Технологии, Экономика

- Музыка и технологии

- Здоровье и питание

- IT и безопасность

- Бизнес и предпринимательство

- Технологии, Программное обеспечение

- Технологии и инновации

- Технологии, данные, этика

- Технологии и Интернет

- Технологии и SaaS

- Медицина и здравоохранение

- Онлайн-видеосервисы

- Финансы и технологии

- Чтение и саморазвитие

- Экономика и бизнес

- Безопасность данных

- Удаленная работа

- Авиация и технологии

- Технологии, Игры

- Энергетика

- Социальные сети, безопасность, технологии

- Саморазвитие

- Безопасность информации

- Бизнес и карьера

- Технологии и отношения

- Игровая индустрия

- Компьютерная индустрия

- Математика, Искусственный интеллект

- Наука и технологии

- Технологии и безопасность

- Технологии, Удаленная работа, Бизнес

- Видеоигры

- Технологии, Искусственный интеллект, Этика

- Технологии, социальные сети, 6G

- Технологии, Программирование, AI, Разработка ПО

- Программирование, Разработка ПО, Технологии

- Животные

- Технологии, Искусственный интеллект

- Программирование, карьера, технологии, обучение

- Бизнес и технологии

- Технологии, Безопасность данных

- Астрономия и физика

- Продуктивность, личное развитие

- Медиа и Технологии

- Программирование и Искусственный Интеллект

- Социальные сети

- Политика и экономика

- Технологии, Медицина, Искусственный интеллект

- Технологии и управление

- Космос и астрономия

- Общество и политика

- Космические исследования

- Веб-дизайн

- Искусственный интеллект и безопасность данных

- Технологии, Безопасность, Конфиденциальность

- Экологическая проблема

- Технологии, Погода

- Авиация

- Транспортная сфера

- Технологии и бизнес

- Игровая промышленность

- Телевидение и реклама

- Аналитика данных

- Технологии и кибербезопасность

- Маркетинг

- Технологии и гаджеты

- Технологии, Авиация, Инновации

- Финансы и инвестиции

- Технологии и общество

- Рыночный анализ

- Космология

- Данные и бизнес

- IT и программирование

- Технологии и право

- Программирование и разработка

- Астрофизика

- Медицинские технологии

- Авиационная промышленность

- Технологии и искусственный интеллект

- Генетическая инженерия

- Бизнес и инвестиции

- Компьютерная промышленность

- Психология и социология

- Образование и технологии

- Рынок труда

- Технологии, Стартапы

- Технологии, Приватность, Чтение

- Маркетинг и продажи

- Виртуальная реальность

- Технологии, Смартфоны, Маркетинг

- Технологии, Бизнес, Личностный рост

- Экологические проблемы

- Экономика и технологии

- IT и карьера

- Интернет и безопасность

- Разработка и технологии

- Биотехнологии

- Интернет-магазины, кибербезопасность

- Финансы

- Безопасность и технологии

- Экономика

- Защита данных

- Data Science

- Карьера и работа

- Финансовый успех, мошенничество, маркетинг

- Безопасность

- Экология

- Космическая индустрия

- Программирование, Python, Обучение

- Технологии искусственного интеллекта

- Технологии, Дизайн, iOS

- Программирование, DevOps, Kubernetes

- Социальные сети и пропаганда

- Корпоративная этика

- Управление IT-инфраструктурой

- Здоровье и медицина

- Медицина

- Медицинская промышленность

- Разработка и дизайн

- Искусственный интеллект, Диагностика систем

- Образование и психология

- Технологии, Автомобильная промышленность

- Автомобили и путешествия

- Астрономия и космология

- Программирование и технологии

- IT, работа в офисе, эмоциональный интеллект

- Компьютерная техника

- Здоровье и благополучие

- Управление персоналом

- Политика и управление

- Бизнес и экономика

- Социальные сети, Пропаганда, Информационная безопасность

- Технологии и автоматизация

- Геймдизайн

- Экология и технологии

- CRM-системы, IT-инфраструктура

- Права человека

- Цифровая цензура, свобода слова, технологии

- Технологии, Искусственный интеллект, Работа

- Наука о данных

- Астрономия, Наука

- Интернет и цифровые технологии

- Технологии, управление

- Интернет и связь

- Технологии и конфиденциальность

- Интернет и свобода слова

- Психология и социальные науки

- Книги и литература

- Работа и карьера

- Финансовые технологии

- Психология и саморазвитие

- IT, программирование, сети

- Технологии, Видеоигры

- Экология и энергетика

- Космонавтика

- Медицина и технологии

- Игры и развлечения

- Музыкальная индустрия

- Логистика и складирование

- Бизнес и финансы

- Экология и окружающая среда

- Правозащита

- Социальные сети и дезинформация

- Технологии и рынок труда

- Технологии, Искусственный интеллект, Рынок труда

- Технологии и будущее

- Медицина и здоровье

- Социальные медиа

- Экология, политика, общество

- Экономика и Финансы

- Разработка игр

- Пропаганда и дезинформация

- Медицинские исследования

- Онлайн-знакомства

- Политика и СМИ

- Энергетика и электромобили

- Климатические изменения

- Технологии, Рынок труда

- IT и управление данными

- Безопасность и кибербезопасность

- Интернет-технологии

- Психология и личностное развитие

- Технологии, Мессенджеры

- Цифровые технологии

- Здоровье и самосовершенствование

- Технологии и AI

- Технологии и спорт

- IT, Разработка программного обеспечения

- Экология и климат

- Космос и технологии

- Юридическая сфера

- Безопасность в интернете

- Программирование, Искусственный Интеллект, Качество ПО

- Технологии и мессенджеры

- Социальная справедливость

- Технологическая индустрия

- Личностное развитие, Time-менеджмент, Психология

- Бизнес и менеджмент

- Технологии, Микросхемы, Автономные системы

- Фриланс и предпринимательство

- Социальные сети и искусственный интеллект

- Криминальные дела

- Социальные сети, Маркетинг

- Энергетика и экология

- Технологии, Искусственный Интеллект, Полиция

- Программирование, Искусственный интеллект, Рынок труда

- Социальные сети, дезинформация, анализ данных

- Потребительские права

- Образование и наука

- Технологии и правосудие

- Технологии, Безопасность, Автомобили

- Энергетика и окружающая среда

- Личностное развитие

- Технологии и экономика

- Медиа и коммуникации

- Миграция и иммиграция

- Личностный рост

- Налоговая система

- Медиа и телевидение

- Интернет и телекоммуникации

- Технологии, Кибербезопасность

- Здоровье

- Социальные сети и карьера

- Политика и инфраструктура

- Предпринимательство

- Промышленность программного обеспечения

- СМИ и коммуникации

- Медиа и Общество

- Медицина и генетика

- Веб-разработка и дизайн

- Технологии, процессоры

- IT-индустрия

- Кинопроизводство и технологии

- Транспорт

- Текстовый анализ

- Технологии, дизайн интерфейсов

- Офисные приложения

- Технологии, Онлайн-сервисы

- Медицина и биотехнологии

- Общество и технологии

- Экономика и рынок труда

- Искусственный интеллект, программирование, аналитика

- Технологии, следствие

- Сетевые технологии

- Технологии и веб-разработка

- Программирование, Обучение, Практика

- Коммуникации и ИТ

- Технологии, Карьера, Экономика

- Технологии и транспорт

- Здравоохранение и медицина

- Технологии, Государственное управление

- IT-безопасность

- IT и разработка

- Финансы и экономика

- Социальные сети, Общество, Сообщества

- IT-разработка

- СМИ и политика

- Конфиденциальность и безопасность

- Экономика и политика

- Технологии и общественная жизнь

- Бизнес и этика

- Безопасность и защита информации

- Технологии, бизнес

- Интернет и цензура

- Государственное регулирование

- Игры, Технологии

- Технологии и оптимизация

- Технологии ИИ и машинного обучения

- Технологии, IT, карьера

- IT и программное обеспечение

- Право и преступность

- Криминал и Правоохранительные Органы

- Технологии и энергетика

- Нефтяная промышленность

- Социальные конфликты

- Преступность и безопасность

- Таможенная очистка

- Медиа и журналистика

- Технологии и разработка приложений

- Телекоммуникации

- Консалтинг и управление

- Управление человеческими ресурсами

- Онлайн-контент

- Психология и психотерапия

- Морская отрасль

- Психология и технологии

- Социальные проблемы

- Маркетинг и реклама

- Политика и власть

- Экономика и торговля

- Карьера и развитие

- Продуктивность и Управление Временем

- Технологии, Искусственный интеллект, Реклама

- Окружающая среда

- Здоровье и технологии

- Бытовая химия

- Правовая информация

- Юстиция

- Технологии и экология

- Социальные сети и безопасность

- Базы данных

- Политика и государственное управление

- Интернет и социальные сети

- Индустрия IT

- Технологии и программное обеспечение

- История и искусственный интеллект

- Рестораны и обслуживание

- Технологии и программирование

- Социология

- Телевидение и СМИ

- Психология

- Политика и бизнес

- Мобильные устройства

- Технологии и развлечения

- Экология и охрана окружающей среды

- Маркетинг и брендинг

- Медицинская индустрия

- Кибербезопасность и технологии

- Социальные сети и политика

- Развлечения

- ИТ и автоматизация

- Криптовалюты и блокчейн

- История и идеология

- Медицина и политика

- Личная жизнь миллиардеров

- Образование и Политика

- Туризм и отдых

- Психология и искусственный интеллект

- Удаленная работа и производительность

- Выживание

- Управление командами

- Разработка

- Международная торговля

- Корпоративная ответственность

- Социальные сети и общество

- Управление серверами

- Индустрия компьютерных игр

- Политика и климат

- Онлайн-игры

- Медицинская отрасль

- Искусственный интеллект и технологии

- Религия и мораль

- Путешествия

- Социальные сети и информация

- Технологии и медиа

- Технологии и свобода

- Электронная коммерция

- Бизнес и управление

- Психическое здоровье и технологии

- Технологии и устойчивое развитие

- Технологии и социальные сети

- Профессии

- Экономика и промышленность

- Технологии и трудоустройство

- Иммиграционная политика

- Продуктивность и фокус

- Технологии и робототехника

- Свобода слова

- Психология и власть

- Социальные сети и онлайн-платформы

- Технологии и Права Человека