Предсказание с несколькими точками: устойчивый прибыль с множественными эпохами и созданием.

7 июня 2025 г.Таблица ссылок

Аннотация и 1. Введение

2. Метод

3. Эксперименты по реальным данным

3.1. Шкала преимуществ с размером модели и 3,2. Более быстрый вывод

3.3. Изучение глобальных моделей с помощью мульти-байтового прогноза и 3.4. Поиск оптимальногоне

3.5. Обучение для нескольких эпох и 3.6. Создание нескольких предикторов

3.7 Многократный прогноз на естественном языке

4. Абляции на синтетических данных и 4.1. Индукционная способность

4.2. Алгоритмические рассуждения

5. Почему это работает? Некоторые спекуляции и 5.1. Lookahead Укрепляет очки выбора

5.2. Информация теоретичный аргумент

6. Связанная работа

7. Заключение, Заявление о воздействии, воздействие на окружающую среду, подтверждения и ссылки

A. Дополнительные результаты по самопрокативному декодированию

Б. Альтернативные архитектуры

C. Скорость тренировок

D. МАГАЗИН

E. Дополнительные результаты по поведению масштабирования модели

F. Подробности о CodeContests Manetuning

G. Дополнительные результаты по сравнению с естественным языком

H. Дополнительные результаты по абстрактному текстовому суммированию

I. Дополнительные результаты по математическим рассуждениям на естественном языке

J. Дополнительные результаты по индукционному обучению

K. Дополнительные результаты по алгоритмическим рассуждениям

L. Дополнительные интуиции по многоцелевым прогнозам

М. Обучение гиперпараметры

3.5. Обучение для нескольких эпох

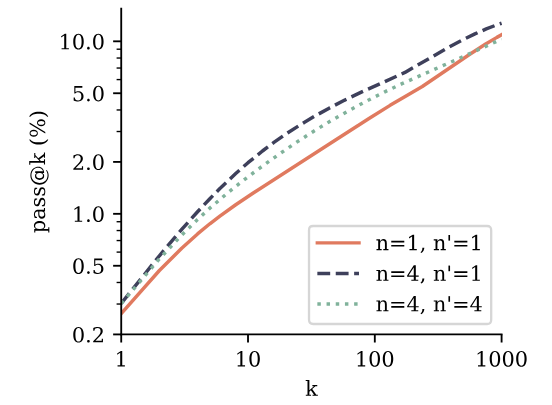

Обучение с несколькими точками по-прежнему сохраняет преимущество над предсказанием следующего ток, когда обучается на нескольких эпохах одних и тех же данных. Улучшения уменьшаются, но у нас все еще есть увеличение на +2,4% при проходе@1 на MBPP и +3,2% увеличения на проходе@100 на Humaneval, в то же время имея аналогичные характеристики для остальных. Что касается приложений/вступления, размер окна 4 уже не был оптимальным с токенами 200b тренировок.

3.6 Создание нескольких предикторов

Предварительные модели с потерей прогнозирования с несколькими ток-точками также превосходят модели следующего ток для использования в Manetunings. Мы оцениваем это путем Manetuning 7B -моделей параметров из Раздела 3.3 в наборе данных CodeContests (Li et al., 2022). Мы сравниваем модель прогнозирования с 4-х позором с базовой линейкой прогнозирования следующего ток и включаем настройку, в которой модель прогнозирования с 4 ток-мышкой снимается с его дополнительных головок прогнозирования и создана с использованием классической цели прогнозирования следующего ток. Согласно результатам на рисунке 4, оба способа создания модели прогнозирования 4-ток превзошли следующую модель прогнозирования следующего ток на Pass@K через k. Это означает, что модели лучше понимают и решают задачу и генерируют разнообразные ответы. Обратите внимание, что CodeContests является наиболее сложным эталоном кодирования, который мы оцениваем в этом исследовании. Следующее предсказание прогнозирования на вершине 4-х дарового прогнозирования предварительно представляется лучшим методом в целом, в соответствии с классической парадигмой предварительной подготовки со вспомогательными задачами, за которыми следуют характеристика, специфичная для задачи. Пожалуйста, обратитесь к Приложению F для получения подробной информации.

Эта статья естьДоступно на ArxivПод CC по лицензии 4.0.

Авторы:

(1) Фабиан Глокл, ярмарка в Meta, Cermics Ecole des Ponts Paristech и внес свой вклад;

(2) Badr Youbi Idrissifair в Meta, Lisn Université Paris-Saclay и внес свой вклад;

(3) Baptiste Rozière, ярмарка в Meta;

(4) Дэвид Лопес-Паз, ярмарка в Мете и его последний автор;

(5) Габриэль Синнев, ярмарка в Мете и его последний автор.

Оригинал

Recent Post

-

Bitpanda запускает Defi Wallet для Power Europe в будущее Onchain

20 августа 2025 г. -

Как Toyota Blockchain Lab хочет сделать автомобили готовыми к финансированию: Внутри предложения Toyota's Mon предложение

20 августа 2025 г. -

Получение звонков клиентов по бюджету в размере 0 долларов США: уроки от стартапа репетиторства

20 августа 2025 г. -

Как я сокращаю задержку рабочего процесса агента в 3-5 раз без увеличения затрат на модель

19 августа 2025 г. -

За кулисами эксперимента парного программирования

19 августа 2025 г.

Categories

- Python

- blockchain

- web

- hackernoon

- вычисления

- вычислительные компоненты

- цифровой дом

- игры

- аудио

- домашний кинотеатр

- Интернет

- Мобильные вычисления

- сеть

- фотосъемка видео

- портативные устройства

- программного обеспечения

- телефон и связь

- телевидение

- видео

- мир технологий

- умные гиды

- облако

- искусственный интеллект

- се

- Samsung

- умные города

- digitaltrends

- отели

- Startups

- Venture

- Crypto

- Apps

- безопасность

- техника и работа

- cxo

- мобильность

- разработчик

- 5г

- майкрософт

- инновации

- Права и свободы

- Законодательство и право

- Политика и общество

- Космическая промышленность

- Информационные технологии

- Технологии

- Образование

- Научные исследования

- Автомобильная промышленность

- Программная инженерия

- IT и технологии

- Веб-разработка

- Программирование

- Автоматизация

- Карьерный рост

- Программирование и анализ данных

- Трудоустройство

- Политика

- Искусственный интеллект

- ИТ-технологии

- Программное обеспечение

- Экологическая политика

- Образование и рынок труда

- Политика и право

- Microsoft Teams и SharePoint

- Информационная безопасность

- Кибербезопасность

- Налоги

- Образование и карьера

- Интернет и технологии

- Технологии, Государственные услуги

- Политика и технологии

- Разработка программного обеспечения

- Разработка ПО

- Машинное обучение

- Налогообложение, технологии, открытый исходный код

- Финансы и налоги

- Технологии, Интернет, Экология

- Интернет, безопасность

- Технологии и политика

- Операционные системы

- Профессиональная разработка

- Технологии, Безопасность

- Интернет и общество

- Финансовая индустрия

- Налоговый учёт

- Общественное здравоохранение

- Технологическая отрасль

- Юриспруденция

- Технологии и государство

- Здоровье и фитнес

- IT-инфраструктура

- Технологии и ИИ

- Здравоохранение

- IT

- Технологии, Экономика

- Музыка и технологии

- Здоровье и питание

- IT и безопасность

- Бизнес и предпринимательство

- Технологии, Программное обеспечение

- Технологии и инновации

- Технологии, данные, этика

- Технологии и Интернет

- Технологии и SaaS

- Медицина и здравоохранение

- Онлайн-видеосервисы

- Финансы и технологии

- Чтение и саморазвитие

- Экономика и бизнес

- Безопасность данных

- Удаленная работа

- Авиация и технологии

- Технологии, Игры

- Энергетика

- Социальные сети, безопасность, технологии

- Саморазвитие

- Безопасность информации

- Бизнес и карьера

- Технологии и отношения

- Игровая индустрия

- Компьютерная индустрия

- Математика, Искусственный интеллект

- Наука и технологии

- Технологии и безопасность

- Технологии, Удаленная работа, Бизнес

- Видеоигры

- Технологии, Искусственный интеллект, Этика

- Технологии, социальные сети, 6G

- Технологии, Программирование, AI, Разработка ПО

- Программирование, Разработка ПО, Технологии

- Животные

- Технологии, Искусственный интеллект

- Программирование, карьера, технологии, обучение

- Бизнес и технологии

- Технологии, Безопасность данных

- Астрономия и физика

- Продуктивность, личное развитие

- Медиа и Технологии

- Программирование и Искусственный Интеллект

- Социальные сети

- Политика и экономика

- Технологии, Медицина, Искусственный интеллект

- Технологии и управление

- Космос и астрономия

- Общество и политика

- Космические исследования

- Веб-дизайн

- Искусственный интеллект и безопасность данных

- Технологии, Безопасность, Конфиденциальность

- Экологическая проблема

- Технологии, Погода

- Авиация

- Транспортная сфера

- Технологии и бизнес

- Игровая промышленность

- Телевидение и реклама

- Аналитика данных

- Технологии и кибербезопасность

- Маркетинг

- Технологии и гаджеты

- Технологии, Авиация, Инновации

- Финансы и инвестиции

- Технологии и общество

- Рыночный анализ

- Космология

- Данные и бизнес

- IT и программирование

- Технологии и право

- Программирование и разработка

- Медицинские технологии

- Авиационная промышленность

- Технологии и искусственный интеллект

- Генетическая инженерия

- Бизнес и инвестиции

- Компьютерная промышленность

- Психология и социология

- Образование и технологии

- Рынок труда

- Технологии, Стартапы

- Технологии, Приватность, Чтение

- Маркетинг и продажи

- Виртуальная реальность

- Технологии, Смартфоны, Маркетинг

- Технологии, Бизнес, Личностный рост

- Экологические проблемы

- Экономика и технологии

- IT и карьера

- Интернет и безопасность

- Разработка и технологии

- Биотехнологии

- Интернет-магазины, кибербезопасность

- Финансы

- Безопасность и технологии

- Экономика

- Защита данных

- Data Science

- Карьера и работа

- Финансовый успех, мошенничество, маркетинг

- Безопасность

- Экология

- Космическая индустрия

- Программирование, Python, Обучение

- Технологии искусственного интеллекта

- Технологии, Дизайн, iOS

- Программирование, DevOps, Kubernetes

- Социальные сети и пропаганда

- Корпоративная этика

- Управление IT-инфраструктурой

- Здоровье и медицина

- Медицина

- Медицинская промышленность

- Разработка и дизайн

- Искусственный интеллект, Диагностика систем

- Образование и психология

- Технологии, Автомобильная промышленность

- Автомобили и путешествия

- Астрономия и космология

- Программирование и технологии

- IT, работа в офисе, эмоциональный интеллект

- Компьютерная техника

- Здоровье и благополучие

- Управление персоналом

- Политика и управление

- Бизнес и экономика

- Социальные сети, Пропаганда, Информационная безопасность

- Технологии и автоматизация

- Геймдизайн

- Экология и технологии

- CRM-системы, IT-инфраструктура

- Права человека

- Цифровая цензура, свобода слова, технологии

- Технологии, Искусственный интеллект, Работа

- Наука о данных

- Астрономия, Наука

- Интернет и цифровые технологии

- Технологии, управление

- Интернет и связь

- Технологии и конфиденциальность

- Интернет и свобода слова

- Психология и социальные науки

- Книги и литература

- Работа и карьера

- Финансовые технологии

- Психология и саморазвитие

- IT, программирование, сети

- Технологии, Видеоигры

- Экология и энергетика

- Космонавтика

- Медицина и технологии

- Игры и развлечения

- Музыкальная индустрия

- Логистика и складирование

- Бизнес и финансы

- Экология и окружающая среда

- Правозащита

- Социальные сети и дезинформация

- Технологии и рынок труда

- Технологии, Искусственный интеллект, Рынок труда

- Технологии и будущее

- Медицина и здоровье

- Социальные медиа

- Экология, политика, общество

- Экономика и Финансы

- Разработка игр

- Пропаганда и дезинформация

- Медицинские исследования

- Онлайн-знакомства

- Политика и СМИ

- Энергетика и электромобили

- Климатические изменения

- Технологии, Рынок труда

- IT и управление данными

- Безопасность и кибербезопасность

- Интернет-технологии

- Психология и личностное развитие

- Технологии, Мессенджеры

- Цифровые технологии

- Здоровье и самосовершенствование

- Технологии и AI

- Технологии и спорт

- IT, Разработка программного обеспечения

- Экология и климат

- Космос и технологии

- Юридическая сфера

- Безопасность в интернете

- Программирование, Искусственный Интеллект, Качество ПО

- Технологии и мессенджеры

- Социальная справедливость

- Технологическая индустрия

- Личностное развитие, Time-менеджмент, Психология

- Бизнес и менеджмент

- Технологии, Микросхемы, Автономные системы

- Фриланс и предпринимательство

- Социальные сети и искусственный интеллект

- Криминальные дела

- Социальные сети, Маркетинг

- Энергетика и экология

- Технологии, Искусственный Интеллект, Полиция

- Программирование, Искусственный интеллект, Рынок труда

- Социальные сети, дезинформация, анализ данных

- Потребительские права

- Образование и наука

- Технологии и правосудие

- Технологии, Безопасность, Автомобили

- Энергетика и окружающая среда

- Личностное развитие

- Технологии и экономика

- Медиа и коммуникации

- Миграция и иммиграция

- Личностный рост

- Налоговая система

- Медиа и телевидение

- Интернет и телекоммуникации

- Технологии, Кибербезопасность

- Здоровье

- Социальные сети и карьера

- Политика и инфраструктура

- Предпринимательство

- Промышленность программного обеспечения

- СМИ и коммуникации

- Медиа и Общество

- Медицина и генетика

- Веб-разработка и дизайн

- Технологии, процессоры

- IT-индустрия

- Кинопроизводство и технологии

- Транспорт

- Текстовый анализ

- Технологии, дизайн интерфейсов

- Офисные приложения

- Технологии, Онлайн-сервисы

- Медицина и биотехнологии

- Общество и технологии

- Экономика и рынок труда

- Искусственный интеллект, программирование, аналитика

- Технологии, следствие

- Сетевые технологии

- Технологии и веб-разработка

- Программирование, Обучение, Практика

- Коммуникации и ИТ

- Технологии, Карьера, Экономика

- Технологии и транспорт

- Здравоохранение и медицина

- Технологии, Государственное управление

- IT-безопасность

- IT и разработка

- Финансы и экономика

- Социальные сети, Общество, Сообщества

- IT-разработка

- СМИ и политика

- Конфиденциальность и безопасность

- Экономика и политика

- Технологии и общественная жизнь

- Бизнес и этика

- Безопасность и защита информации

- Технологии, бизнес

- Интернет и цензура

- Государственное регулирование

- Игры, Технологии

- Технологии и оптимизация

- Технологии ИИ и машинного обучения

- Технологии, IT, карьера

- IT и программное обеспечение

- Право и преступность

- Криминал и Правоохранительные Органы

- Технологии и энергетика

- Нефтяная промышленность

- Социальные конфликты

- Преступность и безопасность

- Таможенная очистка

- Медиа и журналистика

- Технологии и разработка приложений

- Телекоммуникации

- Консалтинг и управление

- Управление человеческими ресурсами

- Онлайн-контент

- Психология и психотерапия

- Морская отрасль

- Психология и технологии

- Социальные проблемы

- Маркетинг и реклама

- Политика и власть

- Экономика и торговля

- Карьера и развитие

- Продуктивность и Управление Временем

- Технологии, Искусственный интеллект, Реклама

- Окружающая среда

- Здоровье и технологии

- Бытовая химия

- Правовая информация

- Юстиция

- Технологии и экология

- Социальные сети и безопасность

- Базы данных

- Политика и государственное управление

- Интернет и социальные сети

- Индустрия IT

- Технологии и программное обеспечение

- История и искусственный интеллект

- Рестораны и обслуживание

- Технологии и программирование

- Социология

- Телевидение и СМИ

- Психология

- Политика и бизнес

- Мобильные устройства

- Технологии и развлечения

- Экология и охрана окружающей среды

- Маркетинг и брендинг

- Медицинская индустрия

- Кибербезопасность и технологии

- Социальные сети и политика

- Развлечения

- ИТ и автоматизация

- Криптовалюты и блокчейн

- История и идеология

- Медицина и политика

- Личная жизнь миллиардеров

- Образование и Политика

- Туризм и отдых

- Психология и искусственный интеллект

- Удаленная работа и производительность

- Выживание

- Управление командами

- Разработка

- Международная торговля

- Корпоративная ответственность

- Социальные сети и общество

- Управление серверами

- Индустрия компьютерных игр

- Политика и климат

- Онлайн-игры

- Медицинская отрасль

- Искусственный интеллект и технологии

- Религия и мораль

- Путешествия

- Социальные сети и информация

- Технологии и медиа

- Технологии и свобода

- Электронная коммерция

- Бизнес и управление

- Психическое здоровье и технологии

- Технологии и устойчивое развитие

- Технологии и социальные сети

- Профессии

- Экономика и промышленность

- Технологии и трудоустройство

- Иммиграционная политика

- Продуктивность и фокус

- Технологии и робототехника

- Свобода слова