Моделирование слоев трансформаторов: минимизация мажоризации и сети хопфилда

19 июня 2025 г.Таблица ссылок

Аннотация и 1 введение

2 Связанная работа

3 модели и 3.1 ассоциативные воспоминания

3.2 трансформаторные блоки

4 Новая энергетическая функция

4.1 Слоистая структура

5 Потеря по перекрестной энтропии

6 Эмпирические результаты и 6.1 Эмпирическая оценка радиуса

6.2 Обучение GPT-2

6.3 Тренировка ванильных трансформаторов

7 Заключение и подтверждение

Приложение A. отложенные таблицы

Приложение B. Некоторые свойства энергетических функций

Приложение C. отложенные доказательства из раздела 5

Приложение D. Трансформатор Подробности: Использование GPT-2 в качестве примера

Ссылки

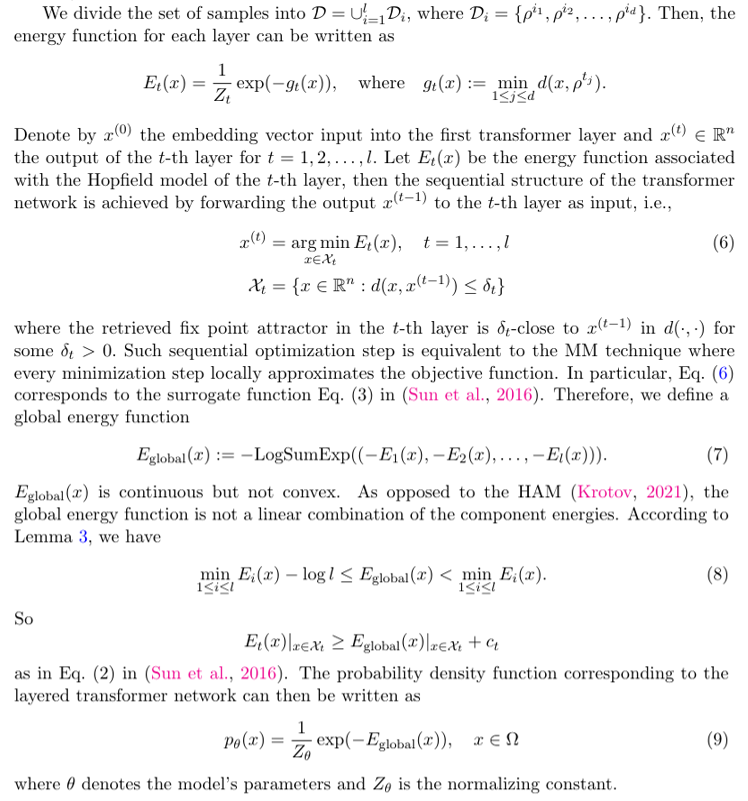

4.1 Слоистая структура

Предыдущие модели Hopfield могут обрабатывать только один скрытый слой, тогда как трансформаторы часто состоят из стопки однородных блоков внимания и слоев FF. Чтобы моделировать многослойную структуру трансформаторов, мы используем методику, известную как минимизация мажоризации (MM) (Ortega and Rheinboldt, 1970; Sun et al., 2016), которая направлена на ускорение оптимизации с использованием суррогатных выпуклостей. Мы утверждаем, что многослойная структура служит той же цели, когда запоминающиеся запоминающиеся запоминающиеся все слои охватывают набор тренировочных образцов.

Замечание 1Если модель сильно перепаратирована, энергетическая функция может аппроксимировать энергию хорошо распределения выборки и не ограничивается формой, выраженной в уравнении. (9).

Авторы:

(1) Xueyan Niu, Theory Laboratory, Central Research Institute, 2012 Laboratories, Huawei Technologies Co., Ltd.;

(2) Бо Бай Байбо (8@huawei.com);

(3) Lei Deng (deng.lei2@huawei.com);

(4) Вэй Хан (harvey.hanwei@huawei.com).

Эта статья есть

Оригинал