DeepSeek заблокировал доступ к публичной базе данных, которая раскрыла историю чатов

31 января 2025 г.29 января американская компания Wiz Research объявила, что она ответственно раскрыла базу данных DeepSeek, ранее открытую для общественности, выставив журналы чатов и другую конфиденциальную информацию. DeepSeek заблокировала базу данных, но это открытие подчеркивает возможные риски, связанные с генеративными моделями ИИ, особенно в международных проектах.

DeepSeek потряс технологическую индустрию на прошлой неделе, поскольку модели искусственного интеллекта китайской компании составили конкуренцию американским лидерам генеративного искусственного интеллекта. В частности, R1 от DeepSeek конкурирует с OpenAI o1 по некоторым показателям.

Как Wiz Research обнаружила общедоступную базу данных DeepSeek?

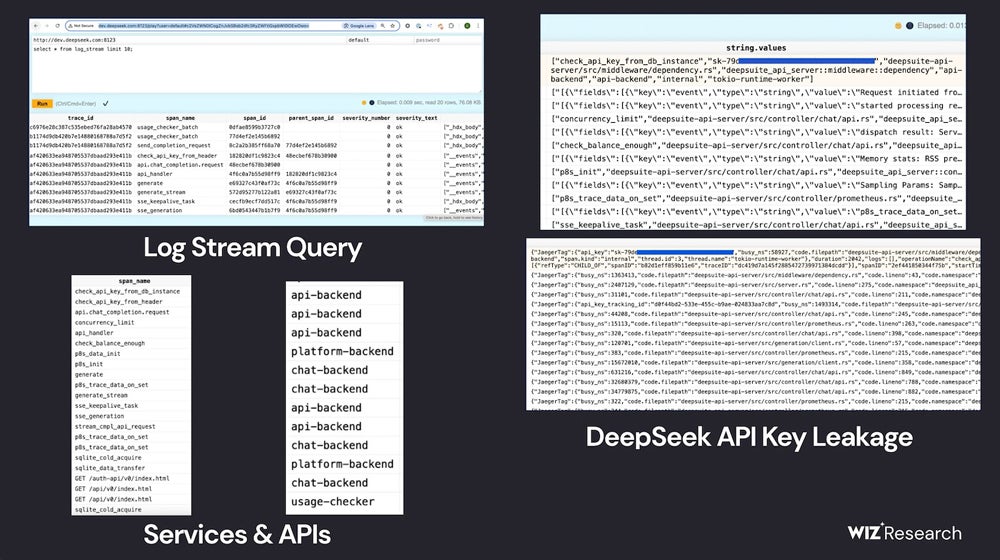

В сообщении в блоге, раскрывающем работу Wiz Research, исследователь облачной безопасности Гал Нагли подробно рассказал, как команда обнаружила общедоступную базу данных ClickHouse, принадлежащую DeepSeek. База данных открыла потенциальные пути для контроля базы данных и атак повышения привилегий. Внутри базы данных Wiz Research мог читать историю чата, данные бэкэнда, потоки журналов, API Secrets и операционные детали.

Команда обнаружила базу данных ClickHouse «в течение нескольких минут», оценив потенциальные уязвимости DeepSeek.

«Мы были потрясены, а также чувствовали огромную необходимость действовать быстро, учитывая масштаб открытия», — написал Нагли в электронном письме TechRepublic.

Сначала они оценили поддомены DeepSeek, выходящие в Интернет, и два открытых порта показались им необычными; эти порты ведут к базе данных DeepSeek, размещенной на ClickHouse, системе управления базами данных с открытым исходным кодом. Просматривая таблицы в ClickHouse, Wiz Research обнаружил историю чата, ключи API, операционные метаданные и многое другое.

Группа Wiz Research отметила, что в ходе исследования они не «выполняли навязчивые запросы», следуя этическим нормам исследования.

Что означает общедоступная база данных для ИИ DeepSeek?

Wiz Research проинформировала DeepSeek об утечке, и компания, занимающаяся разработкой искусственного интеллекта, заблокировала базу данных. Следовательно, продукты DeepSeek на базе искусственного интеллекта не должны быть затронуты.

Однако возможность того, что база данных могла остаться открытой для злоумышленников, подчеркивает сложность обеспечения безопасности продуктов генеративного ИИ.

«Хотя основное внимание в вопросах безопасности ИИ уделяется футуристическим угрозам, реальная опасность часто исходит от базовых рисков, таких как случайное внешнее раскрытие баз данных», — написал Нагли в своем блоге.

IT-специалисты должны знать об опасностях слишком быстрого внедрения новых и непроверенных продуктов, особенно генеративного ИИ, — дайте исследователям время на поиск ошибок и недостатков в системах. Если возможно, включите осторожные временные рамки в политику использования генеративного ИИ в компании.

SEE: Защита и обеспечение безопасности данных стали более сложными в эпоху генеративного ИИ.

«Поскольку организации спешат внедрить инструменты и услуги ИИ от растущего числа стартапов и поставщиков, важно помнить, что, делая это, мы доверяем этим компаниям конфиденциальные данные», — сказал Нагли.

В зависимости от вашего местоположения членам ИТ-отдела может потребоваться знать правила или проблемы безопасности, которые могут применяться к моделям генеративного ИИ, созданным в Китае.

«Например, некоторые факты из истории или прошлого Китая не представлены моделями прозрачно или в полном объеме», — отметил Унмеш Кулкарни, руководитель подразделения ИИ в компании Tredence, занимающейся наукой о данных, в электронном письме TechRepublic. «Последствия вызова размещенной модели для конфиденциальности данных также неясны, и большинство глобальных компаний не захотят этого делать. Однако следует помнить, что модели DeepSeek имеют открытый исходный код и могут быть развернуты локально в частном облаке или сетевой среде компании. Это решит проблемы конфиденциальности данных или проблемы утечки».

Нагли также порекомендовал использовать модели с собственным хостингом, когда TechRepublic связался с ним по электронной почте.

«Внедрение строгого контроля доступа, шифрования данных и сегментации сети может еще больше снизить риски», — написал он. «Организации должны обеспечить видимость и управление всем стеком ИИ, чтобы они могли анализировать все риски, включая использование вредоносных моделей, раскрытие обучающих данных, конфиденциальные данные в обучении, уязвимости в SDK ИИ, раскрытие служб ИИ и другие токсичные комбинации рисков, которые могут быть использованы злоумышленниками».

Оригинал